Da der technologische Fortschritt die sozialen Medien und Massenmedien weiterhin prägt, werden Deepfakes zu einem großen Problem, da die Zahl der Deepfake-Betrügereien weiter zunimmt.

Deepfakes können für schlechte Zwecke verwendet werden

Nach Untersuchungen in Darknet-Foren, in denen Cyberkriminelle häufig aktiv sind, stellte Kaspersky fest, dass viele Kriminelle Deepfakes für Betrugszwecke verwenden, und zwar in einem Ausmaß, dass die Nachfrage das Angebot an Deepfake-Software auf dem Markt bei weitem übersteigt.

Da die Nachfrage das Angebot übersteigt, prognostizieren die Experten von Kaspersky, dass Deepfake-Betrug in Zukunft vielfältiger und raffinierter werden wird. Die Bandbreite reicht vom Angebot eines hochwertigen Identitätsvideo mit kompletter Produktion bis hin zur Verwendung von Prominentenbildern in gefälschten Social-Media-Livestreams und dem Versprechen, den Betrag, den das Opfer ihnen schickt, zu verdoppeln.

„Deepfakes sind zu einem Albtraum für Frauen und die Gesellschaft geworden. Cyberkriminelle nutzen mittlerweile künstliche Intelligenz (KI), um die Gesichter ihrer Opfer in pornografische Fotos und Videos sowie in Propagandakampagnen einzufügen. Ziel dieser Methoden ist es, die öffentliche Meinung durch die Verbreitung falscher Informationen zu manipulieren oder sogar den Ruf von Organisationen oder Einzelpersonen zu schädigen. Wir rufen die Öffentlichkeit dazu auf, gegenüber dieser Bedrohung wachsamer zu sein“, sagte Vo Duong Tu Diem, Landesdirektorin von Kaspersky Vietnam.

Laut Regula, einem Informationsreferenzsystem, sind bis zu 37 % der Unternehmen weltweit Opfer von Voice-Deepfake-Betrug und 29 % von Deepfake-Videos geworden. Deepfakes sind in Vietnam zu einer Bedrohung für die Cybersicherheit geworden, wo Cyberkriminelle häufig Deepfake-Videoanrufe nutzen, um sich als eine andere Person auszugeben und sich von deren Verwandten und Freunden hohe Geldsummen für dringende Fälle zu leihen. Zudem kann ein Deepfake-Videoanruf innerhalb von nur einer Minute getätigt werden, sodass es für Opfer schwierig ist, zwischen echten und gefälschten Anrufen zu unterscheiden.

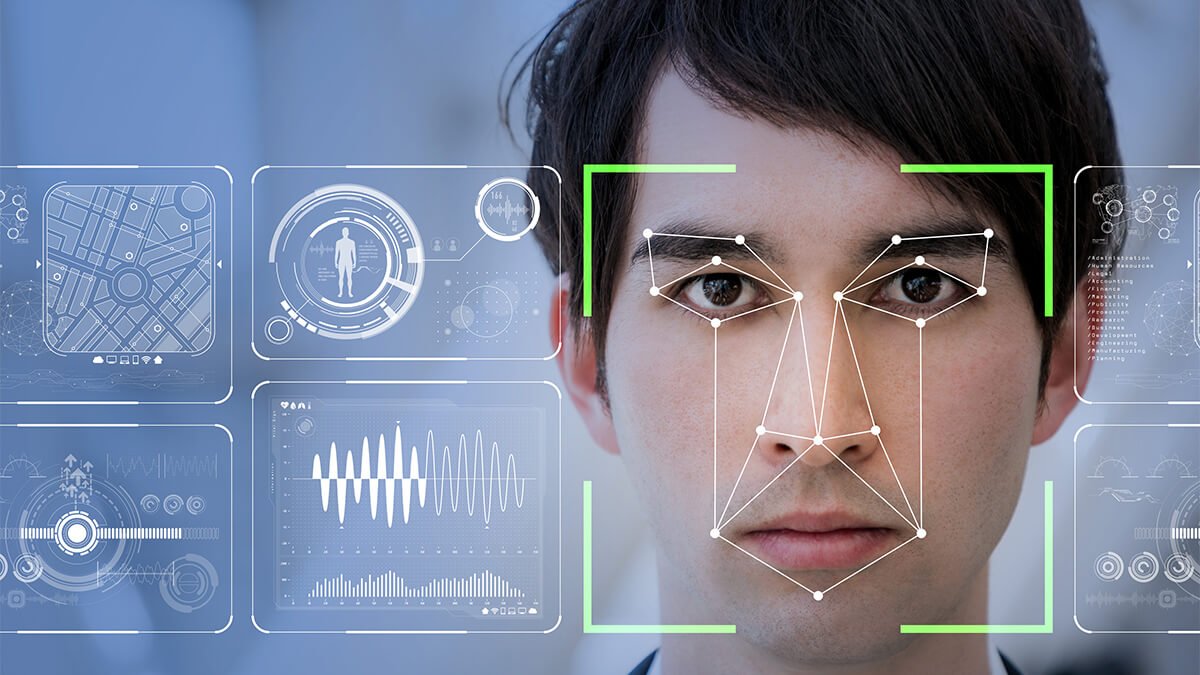

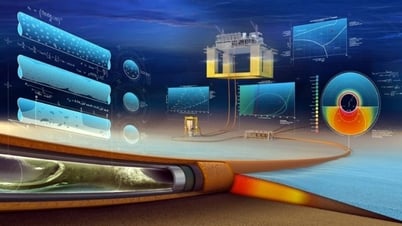

Während KI von Kriminellen für böswillige Zwecke missbraucht wird, können Einzelpersonen und Unternehmen KI dennoch nutzen, um Deepfakes zu erkennen und so die Erfolgswahrscheinlichkeit von Betrugsversuchen zu verringern.

Kaspersky stellt Lösungen vor, mit denen Benutzer sich vor Deepfake-Betrug schützen können:

Tools zur KI-Inhaltserkennung : KI-generierte Software zur Inhaltserkennung nutzt fortschrittliche KI-Algorithmen, um Bild-, Video- und Audiodateien zu analysieren und deren Manipulationsgrad zu bestimmen. Bei Deepfake-Videos helfen einige Tools, nicht übereinstimmende Mundbewegungen und Sprache zu identifizieren. Einige Tools erkennen abnormalen Blutfluss unter der Haut, indem sie die Videoauflösung analysieren, da sich die Farbe der menschlichen Venen ändert, wenn das Herz Blut pumpt.

Wasserzeichen in KI-Inhalten : Wasserzeichen dienen als Erkennungszeichen in Bildern, Videos usw. und helfen Autoren, das Urheberrecht an KI-Werken zu schützen. Dieses Tool kann jedoch auch zu einer Waffe gegen Deepfakes werden, da es hilft, den Ursprung der Plattform, die die KI erstellt hat, zurückzuverfolgen.

Herkunft der Inhalte : Da KI große Datenmengen aus verschiedenen Quellen sammelt, um neue Inhalte zu erstellen, zielt dieser Ansatz darauf ab, den Ursprung dieser Inhalte zu ermitteln.

Videoauthentifizierung : Hierbei wird überprüft, ob der Videoinhalt seit seiner Erstellung verändert wurde. Dieser Prozess ist für Videoproduzenten von größter Bedeutung. Einige neue Technologien verwenden kryptografische Algorithmen, um in festgelegten Abständen Hashwerte in das Video einzufügen. Wurde das Video bearbeitet, wird der Hashwert geändert.

[Anzeige_2]

Quellenlink

Kommentar (0)