Nicht pornografisch oder betrügerisch, aber Prominente wurden kürzlich einem neuen Trend „aufgehängt“, indem ihre Bilder in Lehrvideos im sozialen Netzwerk TikTok auftauchten. Dazu gehören Sängerin Taylor Swift, Rapper Drake, Ice Spice, Medienpersönlichkeit Kim Kardashian, Milliardär Elon Musk und sogar die verstorbene Königin Elizabeth II.

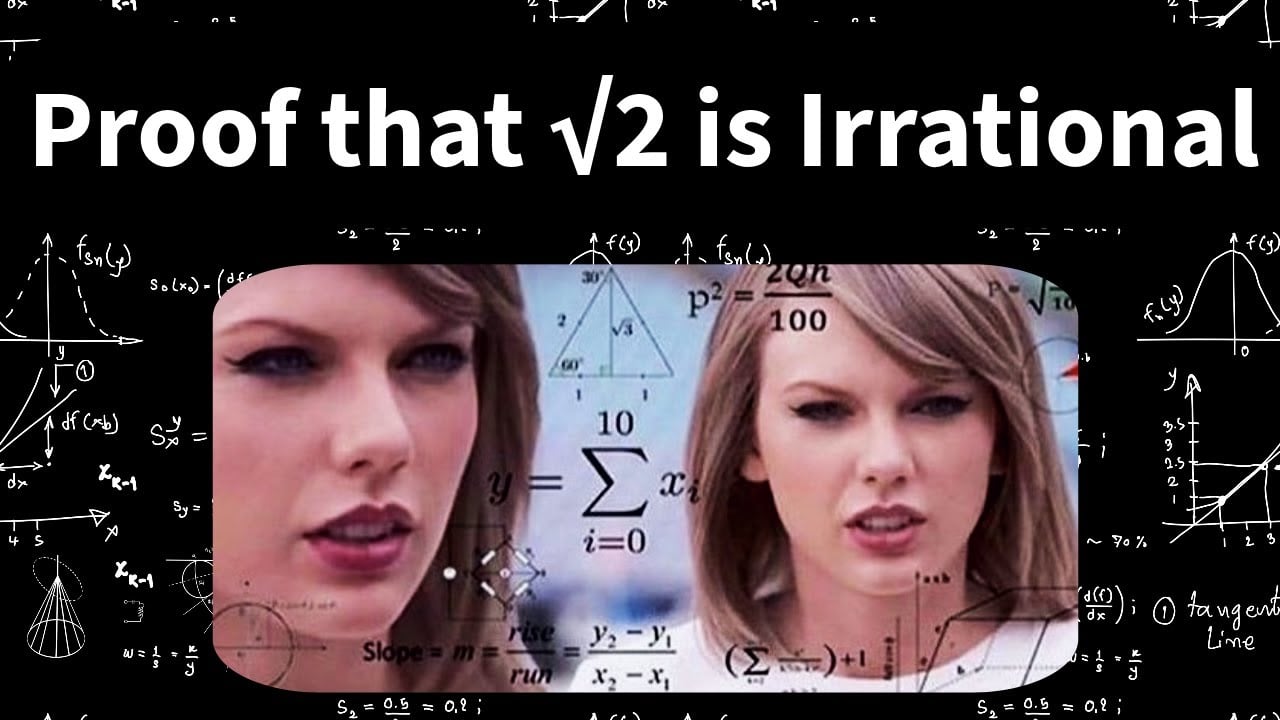

Taylor Swifts Bild wurde mit Deepfake für mathematische Analysen in sozialen Medien nachgebildet

YouTube-Screenshot

Dementsprechend nutzten einige TikTok-Konten KI (künstliche Intelligenz) und Deepfake-Tools, um Videos von Prominenten zu erstellen, die „online gehen“, um das Wissen von Schülern in Mathematik, Physik, Ingenieurwissenschaften usw. zu analysieren. Diese Videos erhielten schnell zig Millionen Aufrufe und unzählige Kommentare.

Im Gegensatz zu den gefälschten Bildern, die in Pornos oder Betrugsmaschen verwendet werden, weisen die Ersteller der Inhalte unter den Lehrvideos stets darauf hin, dass die dargestellten Charaktere von KI erstellt wurden, und geben gleichzeitig entsprechende Haftungsausschlüsse an.

„Dies ist nicht Drakes echte Stimme oder sein Video. Alle Bilder und die Sprache sind computergeneriert, um den Zuschauern das Erlernen von Mathematik, Physik und Ingenieurwesen zu erleichtern“, heißt es in der Bildunterschrift eines Videos deutlich.

Diese Vorgehensweise wird von der Mehrheit der Zuschauer unterstützt, die der Meinung sind, dass der Wissenserwerb einfacher und der Inhalt prägnanter ist, wenn man nur wenige Minuten braucht, um das Problem zu erfassen, während Dozenten normalerweise 1–2 Unterrichtsstunden benötigen, um es zu vermitteln.

Die Verwendung von Prominentenbildern zum „Unterrichten“ in sozialen Netzwerken wie TikTok oder anderen Plattformen gibt jedoch auch Anlass zur Sorge. Psychologen sagen, es gebe keine Garantie dafür, dass das in den Videos vermittelte Wissen korrekt sei. Zudem bestehe die Gefahr, dass Kinder den von künstlicher Intelligenz geschaffenen Figuren völlig vertrauen oder eine Beziehung zu ihnen aufbauen.

[Anzeige_2]

Quellenlink

![[Foto] Der Vorsitzende der Nationalversammlung, Tran Thanh Man, besucht die vietnamesische Heldin Ta Thi Tran](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/20/765c0bd057dd44ad83ab89fe0255b783)

Kommentar (0)