Im Mai 2024 brachten weltbekannte Technologiegiganten nacheinander neue Versionen künstlicher Intelligenz (KI) auf den Markt, darunter OpenAI mit GPT-4o, Google mit Gemini 1.5 Pro … mit vielen „superintelligenten“ Funktionen zur Optimierung des Benutzererlebnisses. Es ist jedoch unbestreitbar, dass diese Technologie von Cyberkriminellen in zahlreichen Online-Betrugsszenarien eingesetzt wird.

Steigendes Risiko

Bei einem kürzlich abgehaltenen Workshop wies der stellvertretende Minister für Information und Kommunikation , Pham Duc Long, darauf hin, dass Cyberangriffe ständig zunehmen und immer raffinierter und komplexer werden. Insbesondere durch die Unterstützung von KI steigen die Risiken für Nutzer exponentiell. „KI-Technologie wird von Cyberkriminellen genutzt, um mühelos neue Schadsoftware und neue, ausgeklügelte Phishing-Angriffe zu entwickeln …“, warnte Vizeminister Pham Duc Long.

Laut einem Bericht der Abteilung für Informationssicherheit des Ministeriums für Information und Kommunikation haben KI-bezogene Cybersicherheitsrisiken weltweit Schäden in Höhe von über einer Billiarde US-Dollar verursacht, davon 8.000 bis 10.000 Milliarden VND allein in Vietnam. Die häufigste Anwendung ist heute die Verwendung von KI zur Fälschung von Stimmen und Gesichtern zu Betrugszwecken. Prognosen zufolge wird es bis 2025 etwa 3.000 Angriffe pro Sekunde, 12 Malware-Angriffe pro Sekunde und 70 neue Schwachstellen pro Tag geben.

Laut Nguyen Huu Giap, Direktor von BShield – spezialisiert auf Anwendungssicherheit – ist die Erstellung gefälschter Bilder und Stimmen dank der Weiterentwicklung der KI kein Problem mehr. Betrüger können problemlos Nutzerdaten aus öffentlichen Informationen sammeln, die sie in sozialen Netzwerken veröffentlichen, oder durch Tricks wie Online-Bewerbungsgespräche und Telefonanrufe unter dem Namen „Behörden“. In einer von BShield durchgeführten Simulation können Betrüger anhand des über einen Videoanruf verfügbaren Gesichts diese auf das CCCD übertragen und auf den Körper einer sich bewegenden Person übertragen, um das eKYC-Tool zu täuschen und vom System als reale Person erkannt zu werden.

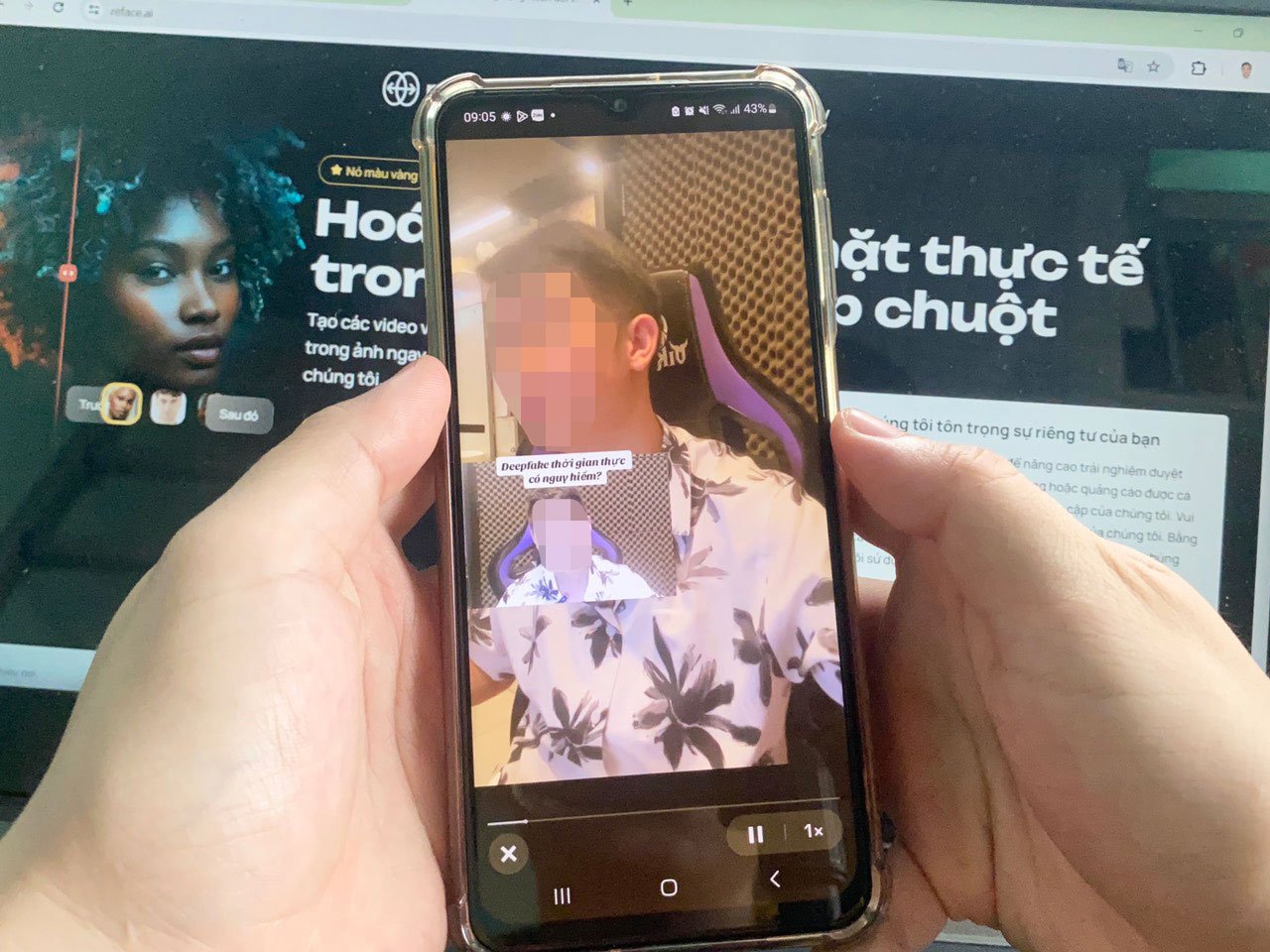

Betrügerische Methoden mit Deepfake-Technologie nehmen zu und werden immer raffinierter. Foto: LE TINH

Aus Nutzersicht befürchtet Herr Nguyen Thanh Trung, ein IT-Spezialist aus Ho-Chi-Minh-Stadt, dass Kriminelle chatGPT ausnutzen könnten, um betrügerische E-Mails zu erstellen, deren Inhalt und Schreibstil echten E-Mails von Banken oder seriösen Organisationen ähneln. Diese E-Mails enthalten häufig Schadsoftware. Klicken Nutzer darauf, werden ihre Daten und ihr Vermögen gestohlen. „KI-Software wird immer besser und kann gefälschte Videos erstellen, deren Gesichter und Stimmen zu 95 % denen echter Menschen ähneln. Die Gesten ändern sich in Echtzeit, sodass sie für den Betrachter nur schwer zu erkennen sind“, so Herr Trung.

Bald vollständiger Rechtskorridor

Um das Risiko von High-Tech-Betrug zu begrenzen, empfiehlt Sicherheitsexperte Pham Dinh Thang, dass Nutzer ihr Wissen über KI regelmäßig aktualisieren und nicht auf Links unbekannter Herkunft klicken sollten. Unternehmen sollten ein Budget für Datensicherheit und Systembetrieb bereitstellen. Mitarbeiter müssen zudem umfassend geschult werden, um die tatsächlichen Schwachstellen im System zu erkennen und so Cyberangriffe besser erkennen zu können.

Herr Ta Cong Son, Leiter der Abteilung für KI-Entwicklung im Bereich Betrugsbekämpfung, erklärte, dass KI dank ihrer hochintelligenten Unterstützungsfunktionen tief im Alltag der Nutzer und in den Abläufen von Unternehmen, Behörden und Abteilungen verankert sei. Insbesondere sei KI-Technologie heute leicht zugänglich und benutzerfreundlich, was es Betrügern ermögliche, sie für betrügerische Zwecke auszunutzen. „Betrüger ändern ständig ihre Angriffsmethoden. Nutzer müssen ihre Informationen regelmäßig aktualisieren, um zu wissen, wie sie sich davor schützen können“, empfahl Herr Son.

Experten zufolge haben die kürzlich aktualisierten Modelle GPT-4o und Gemini 1.5 Pro bewiesen, dass die Intelligenz von KI keine Grenzen kennt. Daher müssen Verwaltungsbehörden nicht nur Unternehmen zur Entwicklung von KI-Tools und -Lösungen zur Betrugsbekämpfung ermutigen, sondern auch den rechtlichen Korridor für KI schnell abschließen, um dem Trend voraus zu sein.

Oberstleutnant Nguyen Anh Tuan, stellvertretender Direktor des Nationalen Bevölkerungsdatenzentrums, erklärte, es sei notwendig, bald Dokumente zu veröffentlichen, die die Ethik und Verantwortlichkeiten in- und ausländischer Dienstleister bei der Entwicklung, Produktion, Anwendung und Nutzung von KI regeln. Gleichzeitig sollten spezifische Vorschriften für technische Standards für Systeme erlassen werden, die KI-Dienste nutzen, anwenden, vernetzen und bereitstellen. „Es ist notwendig, KI-Projekte zu erforschen und anzuwenden, um KI-Risiken entgegenzuwirken. Da KI von Menschen geschaffen wird und ein Produkt des Wissens ist, wird es Variationen von „guter KI“ und „schlechter KI“ geben. Daher ist es möglich, die Entwicklung künstlicher Intelligenz durch künstliche Intelligenz selbst zu verhindern“, so Oberstleutnant Tuan.

Herausforderungen der Cybersicherheit

Oberstleutnant Nguyen Anh Tuan räumte ein, dass KI eine Herausforderung für die Netzwerksicherheit darstellt. So könne KI-gestützte Schadsoftware in Dokumenten installiert werden. Beim Hochladen von Dokumenten dringe dieser Schadcode in das System ein. Darüber hinaus können Hacker mithilfe spezieller KI-Technologien das System simulieren und Sicherheitslücken ausnutzen. KI könne zahlreiche Anwendungen mit Bildern, falschen Anwendungsnamen und Websites des Ministeriums für öffentliche Sicherheit erstellen, die Nutzer herunterladen, installieren und Informationen wie Ausweisnummer und Anmeldekennwort angeben können. „KI wird auch eigene Software entwickeln, hybride Schadsoftware mit vielen Malware-Linien, über ausgefeiltere Mechanismen zur Umgehung von Sicherheitsvorkehrungen verfügen und flexible Quellcodes automatisch ändern“, warnte Oberstleutnant Nguyen Anh Tuan.

[Anzeige_2]

Quelle: https://nld.com.vn/toi-pham-mang-co-them-bi-kip-tu-ai-196240601195415035.htm

Kommentar (0)