|

Η Anthropic μόλις ενημέρωσε τη νέα της πολιτική. Φωτογραφία: GK Images . |

Στις 28 Αυγούστου, η εταιρεία τεχνητής νοημοσύνης Anthropic ανακοίνωσε την κυκλοφορία μιας ενημέρωσης στους Όρους Παροχής Υπηρεσιών Χρήστη και στην Πολιτική Απορρήτου. Οι χρήστες μπορούν πλέον να επιλέξουν να επιτρέψουν τη χρήση των δεδομένων τους για τη βελτίωση του Claude και την ενίσχυση της προστασίας από καταχρήσεις όπως απάτες και απάτες.

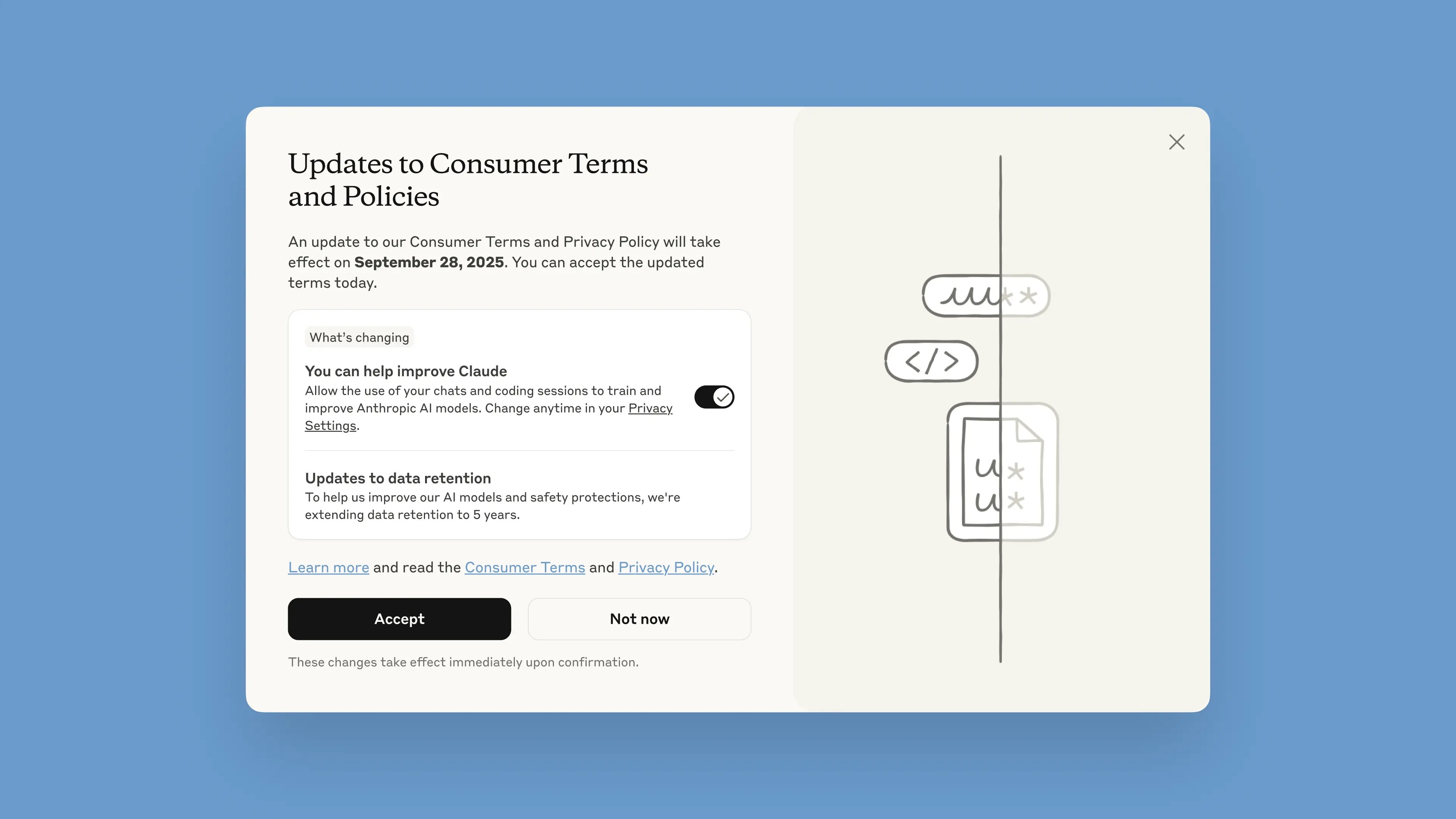

Αυτή η ειδοποίηση θα κυκλοφορήσει στο chatbot από τις 28 Αυγούστου. Οι χρήστες έχουν ένα μήνα για να αποδεχτούν ή να απορρίψουν τους όρους. Οι νέες πολιτικές θα τεθούν σε ισχύ αμέσως μετά την αποδοχή τους. Μετά τις 28 Σεπτεμβρίου, οι χρήστες θα πρέπει να επιλέξουν να συνεχίσουν να χρησιμοποιούν το Claude.

Σύμφωνα με την εταιρεία, οι ενημερώσεις αποσκοπούν στην παροχή πιο ισχυρών και χρήσιμων μοντέλων τεχνητής νοημοσύνης. Η προσαρμογή αυτής της επιλογής είναι απλή και μπορεί να γίνει ανά πάσα στιγμή στις Ρυθμίσεις απορρήτου.

Αυτές οι αλλαγές ισχύουν για τα προγράμματα Claude Free, Pro και Max, τα οποία περιλαμβάνουν το Claude Code, το εργαλείο προγραμματισμού της Anthropic. Οι υπηρεσίες που καλύπτονται από τους Εμπορικούς Όρους δεν θα ισχύουν, συμπεριλαμβανομένων των Claude for Work, Claude Gov, Claude for Education ή της χρήσης API, συμπεριλαμβανομένης της χρήσης μέσω τρίτων όπως το Amazon Bedrock και το Vertex AI του Google Cloud.

Συμμετέχοντας, οι χρήστες θα βοηθήσουν στη βελτίωση της ασφάλειας του μοντέλου, αυξάνοντας την ικανότητά του να ανιχνεύει με ακρίβεια επιβλαβές περιεχόμενο και μειώνοντας τον κίνδυνο εσφαλμένης επισήμανσης ακίνδυνων συνομιλιών, ανέφερε η Anthropic σε ανάρτηση ιστολογίου της. Οι μελλοντικές εκδόσεις του Claude θα ενισχυθούν επίσης με δεξιότητες όπως ο προγραμματισμός, η ανάλυση και η συλλογιστική.

Είναι σημαντικό οι χρήστες να έχουν τον πλήρη έλεγχο των δεδομένων τους και να ενημερώνονται για το αν επιτρέπουν ή όχι στην πλατφόρμα να τα χρησιμοποιεί σε ένα αναδυόμενο παράθυρο. Οι νέοι λογαριασμοί μπορούν προαιρετικά να το ρυθμίσουν αυτό κατά τη διαδικασία εγγραφής.

|

Αναδυόμενο παράθυρο Νέων Όρων στο chatbot. Φωτογραφία: Anthropic. |

Η περίοδος διατήρησης δεδομένων έχει αυξηθεί σε πέντε χρόνια, κάτι που ισχύει για νέες ή συνεχιζόμενες συνομιλίες ή συνεδρίες κωδικοποίησης, καθώς και για απαντήσεις σε απαντήσεις chatbot. Τα διαγραμμένα δεδομένα δεν θα χρησιμοποιηθούν για την εκπαίδευση του μοντέλου στο μέλλον. Εάν οι χρήστες δεν επιλέξουν να παρέχουν δεδομένα για εκπαίδευση, θα συνεχίσουν με την τρέχουσα πολιτική διατήρησης 30 ημερών.

Εξηγώντας την πολιτική, ο Anthropic ανέφερε ότι οι κύκλοι ανάπτυξης της Τεχνητής Νοημοσύνης συνήθως διαρκούν χρόνια και η διατήρηση της συνέπειας των δεδομένων καθ' όλη τη διάρκεια της διαδικασίας εκπαίδευσης βοηθά επίσης τα μοντέλα να παραμένουν συνεπή. Η μεγαλύτερη διατήρηση δεδομένων βελτιώνει επίσης τους ταξινομητές, δηλαδή τα συστήματα που χρησιμοποιούνται για τον εντοπισμό καταχρηστικής συμπεριφοράς, για την ανίχνευση επιβλαβών μοτίβων.

«Για την προστασία του απορρήτου των χρηστών, χρησιμοποιούμε έναν συνδυασμό αυτοματοποιημένων εργαλείων και διαδικασιών για το φιλτράρισμα ή την απόκρυψη ευαίσθητων δεδομένων. Δεν πουλάμε δεδομένα χρηστών σε τρίτους», έγραψε η εταιρεία.

Η Anthropic αναφέρεται συχνά ως μία από τις κορυφαίες εταιρείες στην ασφαλή Τεχνητή Νοημοσύνη. Η Anthropic έχει αναπτύξει μια προσέγγιση που ονομάζεται Συνταγματική Τεχνητή Νοημοσύνη, η οποία καθορίζει ηθικές αρχές και κατευθυντήριες γραμμές που πρέπει να ακολουθούν τα μοντέλα. Η Anthropic είναι επίσης μία από τις εταιρείες που έχουν υπογράψει τις Δεσμεύσεις για την Ασφαλή Τεχνητή Νοημοσύνη με τις κυβερνήσεις των ΗΠΑ, του Ηνωμένου Βασιλείου και της G7.

Πηγή: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

Σχόλιο (0)