Cuando ChatGPT no sólo puede escuchar sino también observar

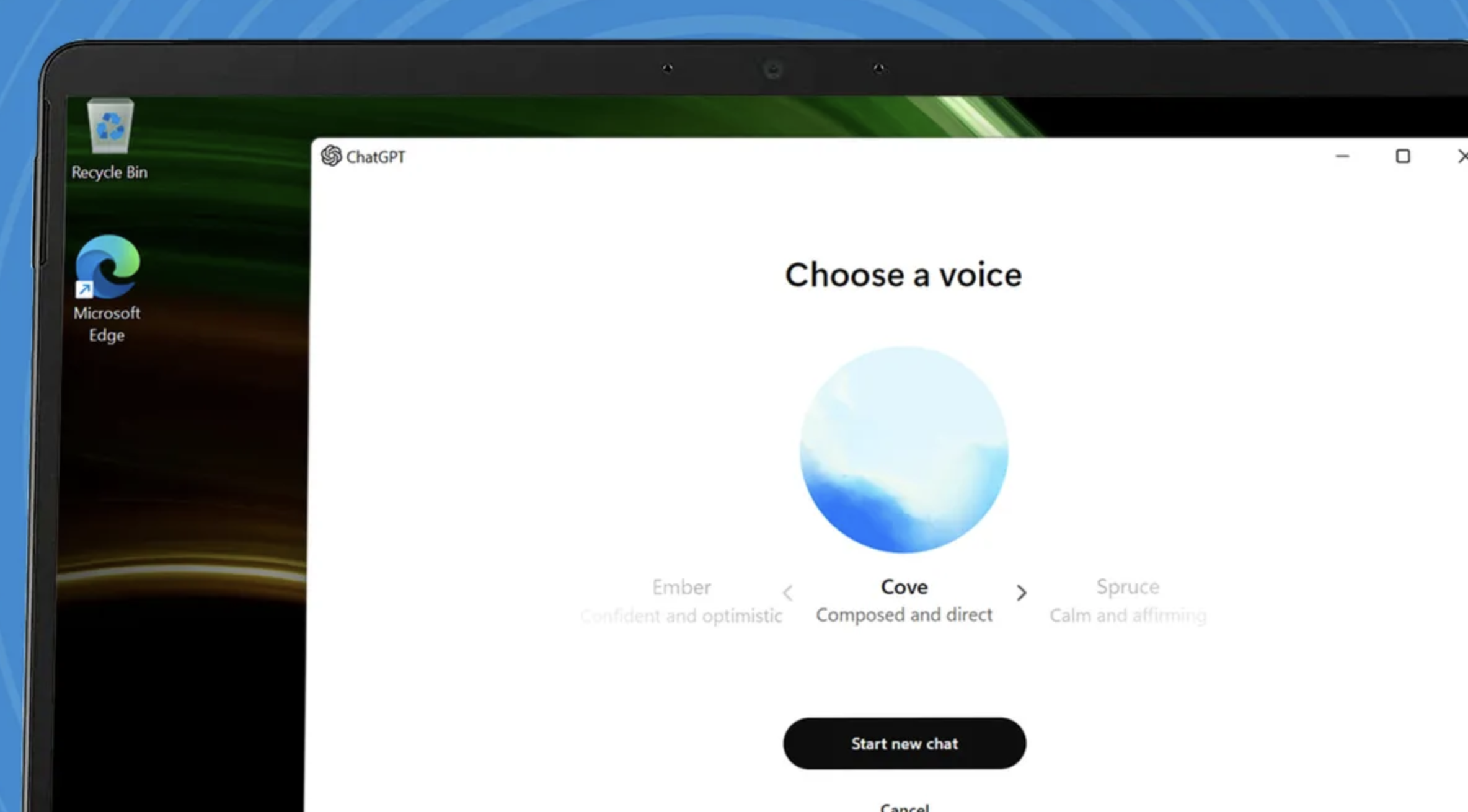

Según TechRadar , OpenAI está desarrollando una nueva función llamada "Cámara en vivo", que se dice que estará integrada en el modo de voz mejorado de ChatGPT. Esta función permitirá a la IA (inteligencia artificial) no solo chatear con audio, sino también reconocer y responder a imágenes.

La "Cámara en Vivo" se presentó por primera vez en mayo de 2024, cuando OpenAI demostró cómo la IA podía analizar imágenes y proporcionar información detallada. Durante la demostración, la IA identificó correctamente a un perro y proporcionó información sobre su raza, características y nombre. Sin embargo, OpenAI no ha publicado más información sobre esta función desde entonces.

La función de voz mejorada de ChatGPT podrá interactuar con los usuarios a través de videollamadas en un futuro próximo.

Recientemente, el código fuente de la versión beta (v1.2024.317) de ChatGPT reveló una referencia llamada “Live Camera”, lo que sugiere que esta función podría lanzarse pronto como una prueba beta antes de implementarse ampliamente.

El modo de voz mejorado de ChatGPT se ha probado en su fase alfa, con comentarios positivos de los usuarios. Un usuario comparó la experiencia con las llamadas de FaceTime con un "amigo superinteligente" y comentó que la función fue útil para responder preguntas en tiempo real.

La integración de funciones de reconocimiento de imágenes y videollamadas promete ayudar a ChatGPT a trascender la función de un chatbot convencional. Podría ser una herramienta útil para personas con discapacidad visual o ayudar a los usuarios a gestionar situaciones que requieren reconocimiento visual.

OpenAI aún no ha anunciado una fecha de lanzamiento oficial ni detalles de la función “Cámara en vivo”, pero nuevos datos del código fuente beta sugieren que la función está en desarrollo y podría estar disponible para los usuarios pronto.

[anuncio_2]

Fuente: https://thanhnien.vn/chatgpt-chuan-bi-ra-mat-tinh-nang-goi-video-cung-ai-185241119232904592.htm

Kommentar (0)