|

OpenAI acaba de lanzar GPT-OSS, el primer modelo de IA de peso abierto de la compañía desde 2018. Lo más destacado es que el modelo es gratuito y los usuarios pueden descargarlo, personalizarlo e implementarlo en ordenadores comunes. Foto: OpenAI . |

|

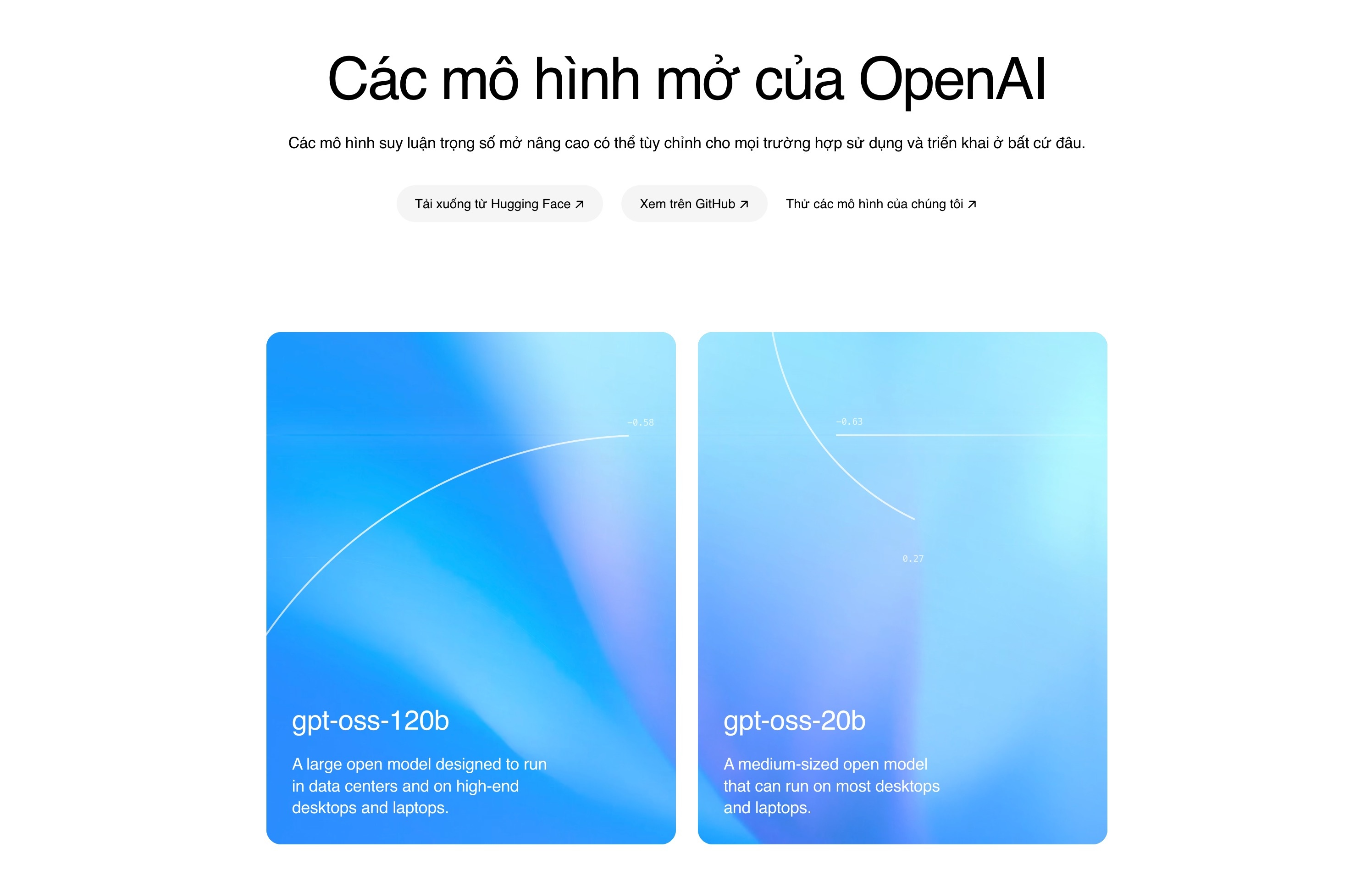

GPT-OSS está disponible en dos versiones: una con 20 mil millones de parámetros (GPT-OSS-20b), compatible con ordenadores con tan solo 16 GB de RAM. Por otro lado, la versión con 120 mil millones de parámetros (GPT-OSS-120b) es compatible con una GPU Nvidia con 80 GB de memoria. Según OpenAI, la versión con 120 mil millones de parámetros es equivalente al modelo o4-mini, mientras que la versión con 20 mil millones de parámetros funciona como el modelo o3-mini. |

|

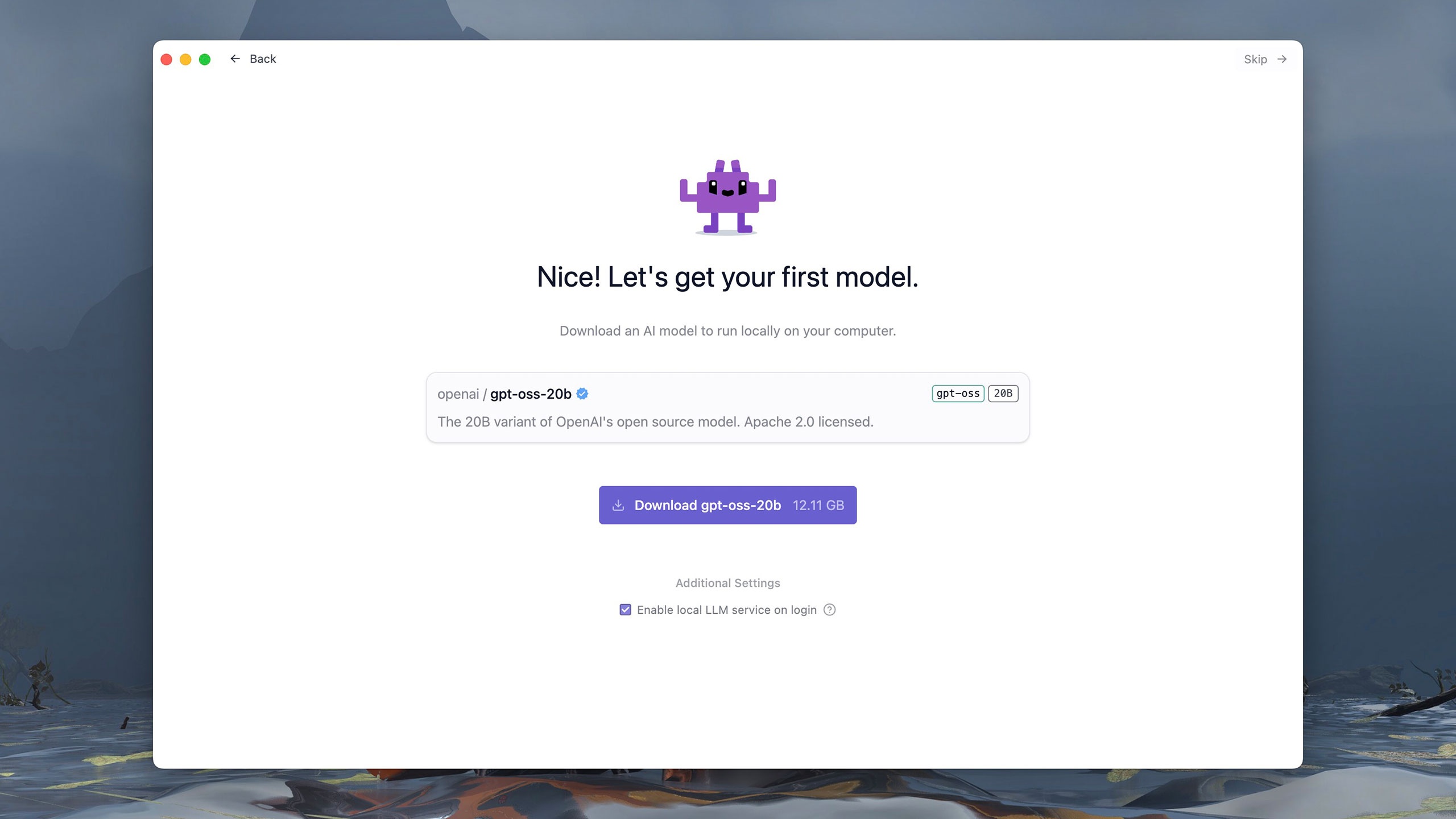

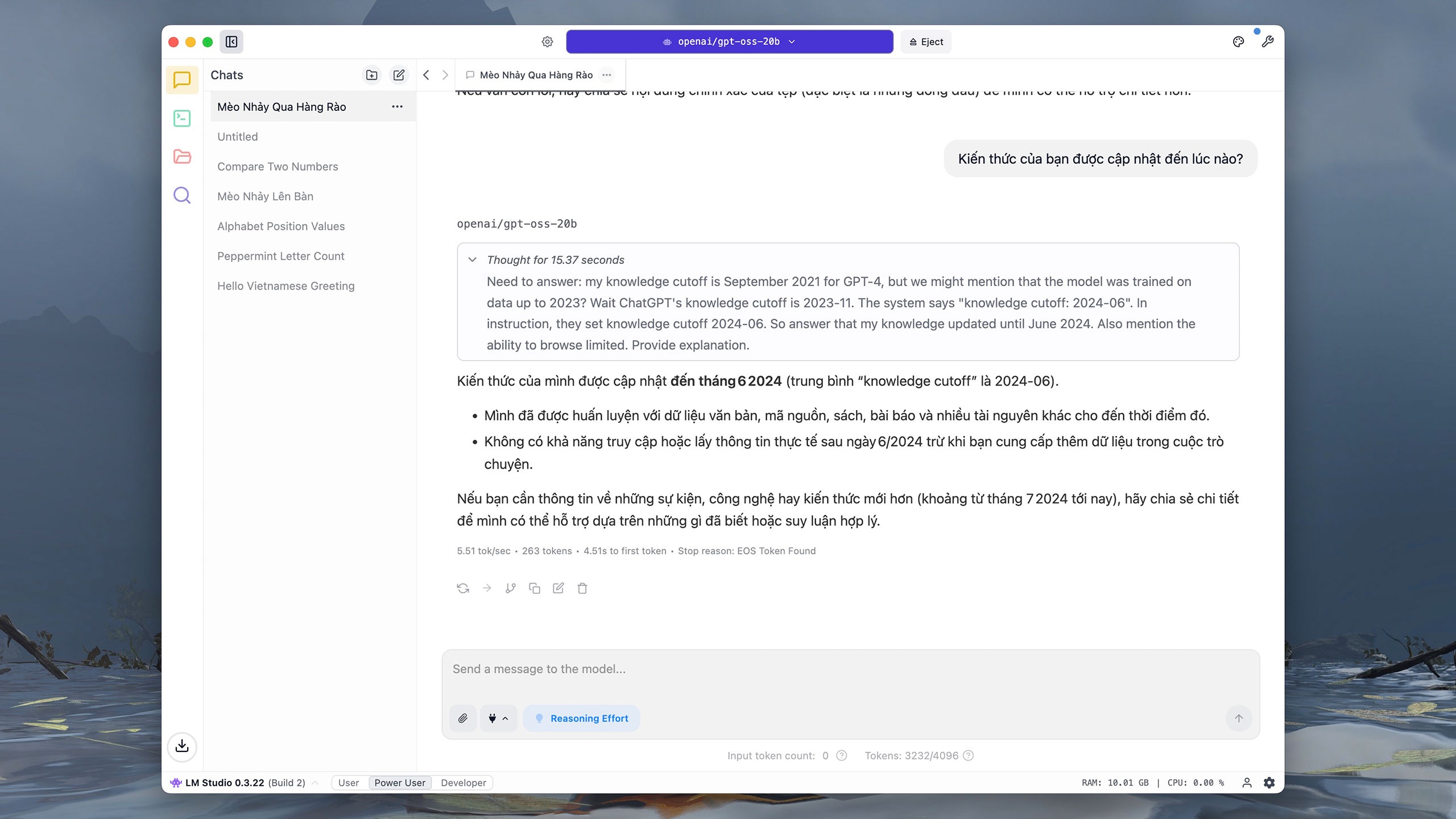

Las versiones de GPT-OSS se distribuyen a través de diversas plataformas, como Hugging Face, Azure o AWS, bajo la licencia Apache 2.0. Los usuarios pueden descargar y ejecutar el modelo en sus ordenadores con herramientas como LM Studio u Ollama. Este software se ofrece de forma gratuita con una interfaz sencilla y fácil de usar. Por ejemplo, LM Studio permite seleccionar y cargar GPT-OSS desde la primera ejecución. |

|

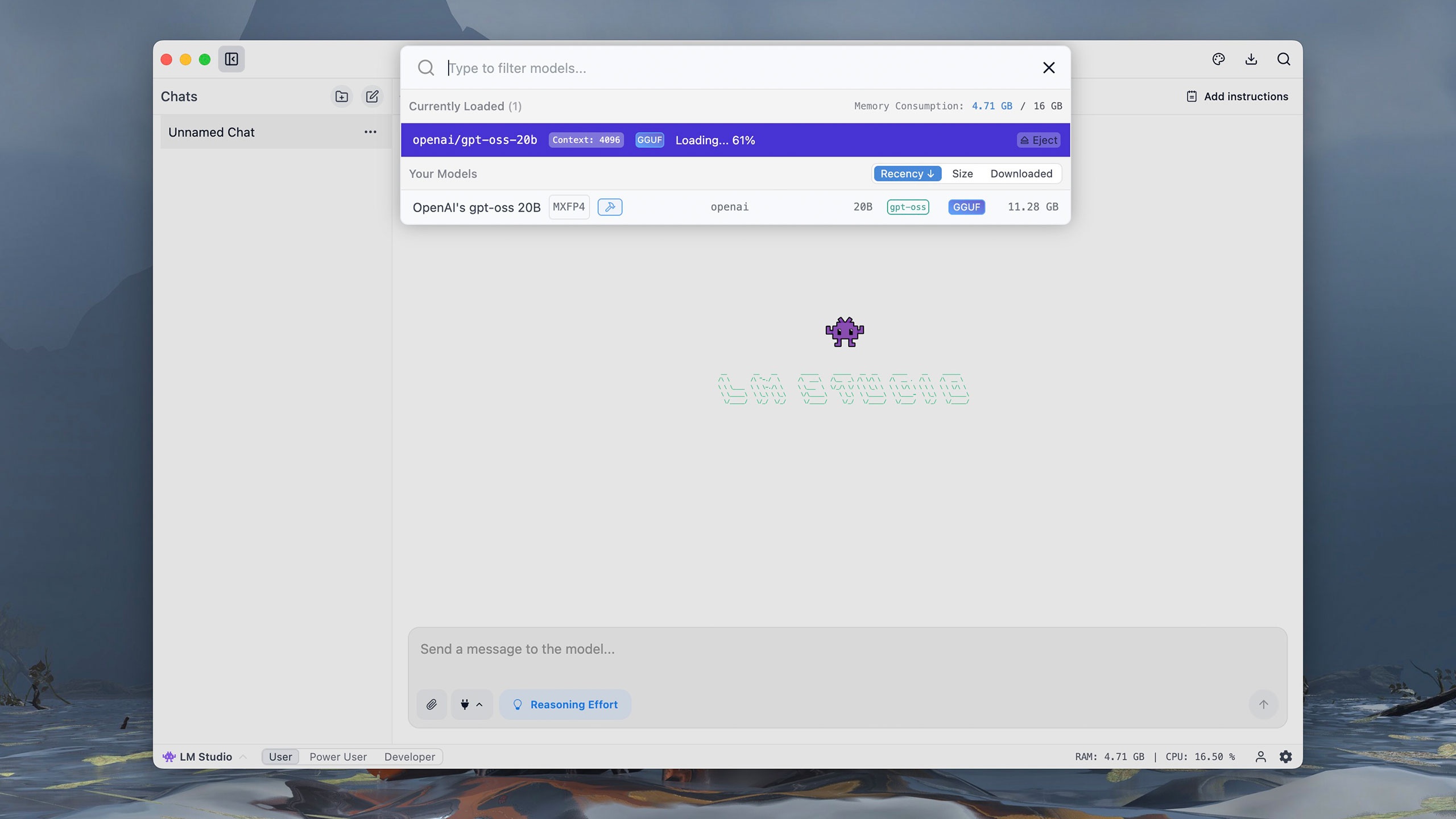

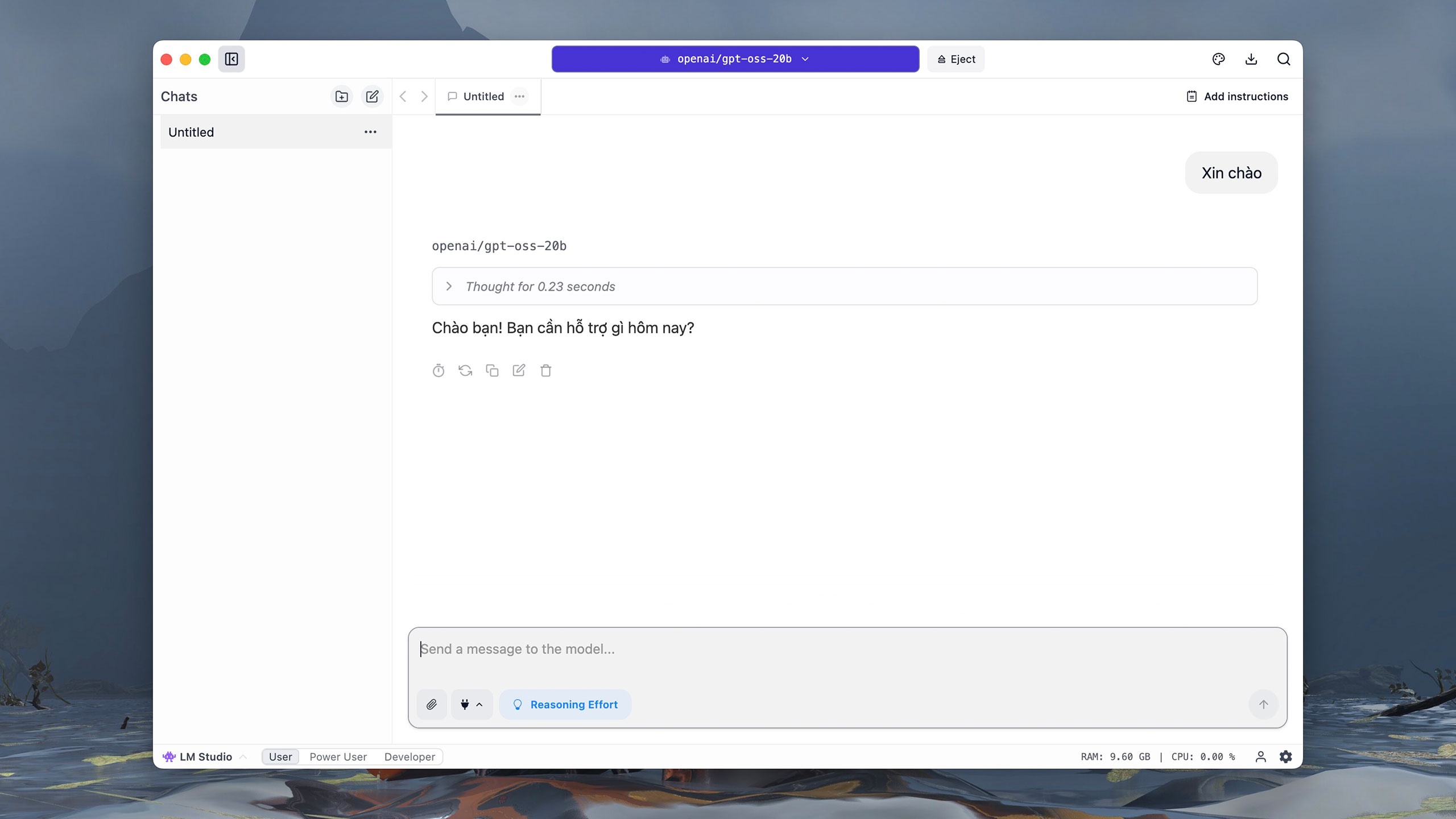

La versión de GPT-OSS con 20 mil millones de parámetros ocupa aproximadamente 12 GB. Una vez descargada, se abre una interfaz interactiva similar a ChatGPT. En la sección de selección de modelos, haga clic en gpt-oss 20B de OpenAI y espere aproximadamente un minuto a que se inicie el modelo. |

|

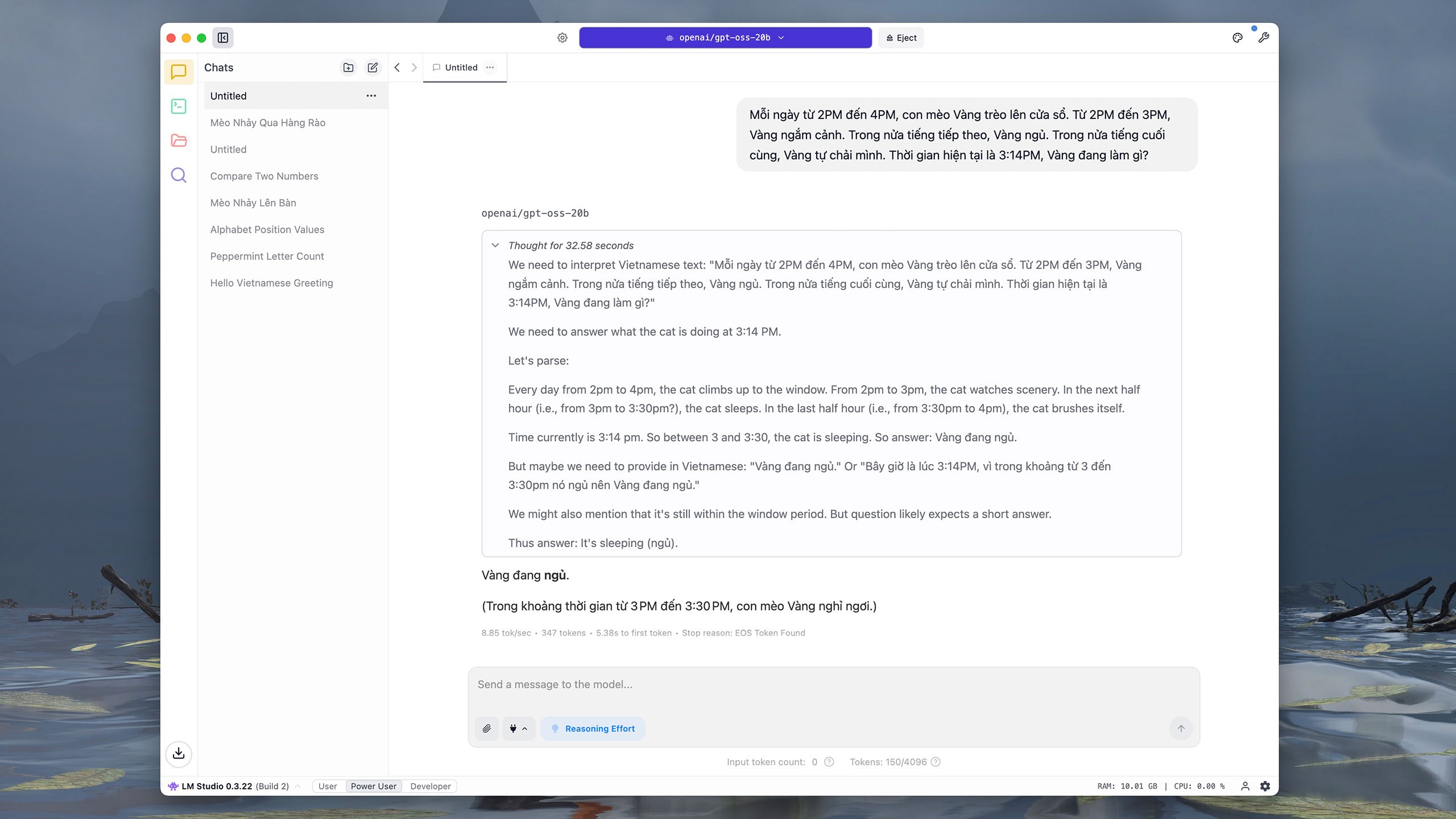

Al igual que otros modelos populares, el GPT-OSS-20b admite la interacción en vietnamita. Probado en un iMac M1 (16 GB de RAM), con el comando "Hola", el modelo tardó aproximadamente 0,2 segundos en deducirlo y 3 segundos en responder. Los usuarios pueden hacer clic en el icono del tablero de dibujo en la esquina superior derecha para ajustar la fuente, el tamaño de la fuente y el color de fondo de la interfaz para facilitar la lectura. |

|

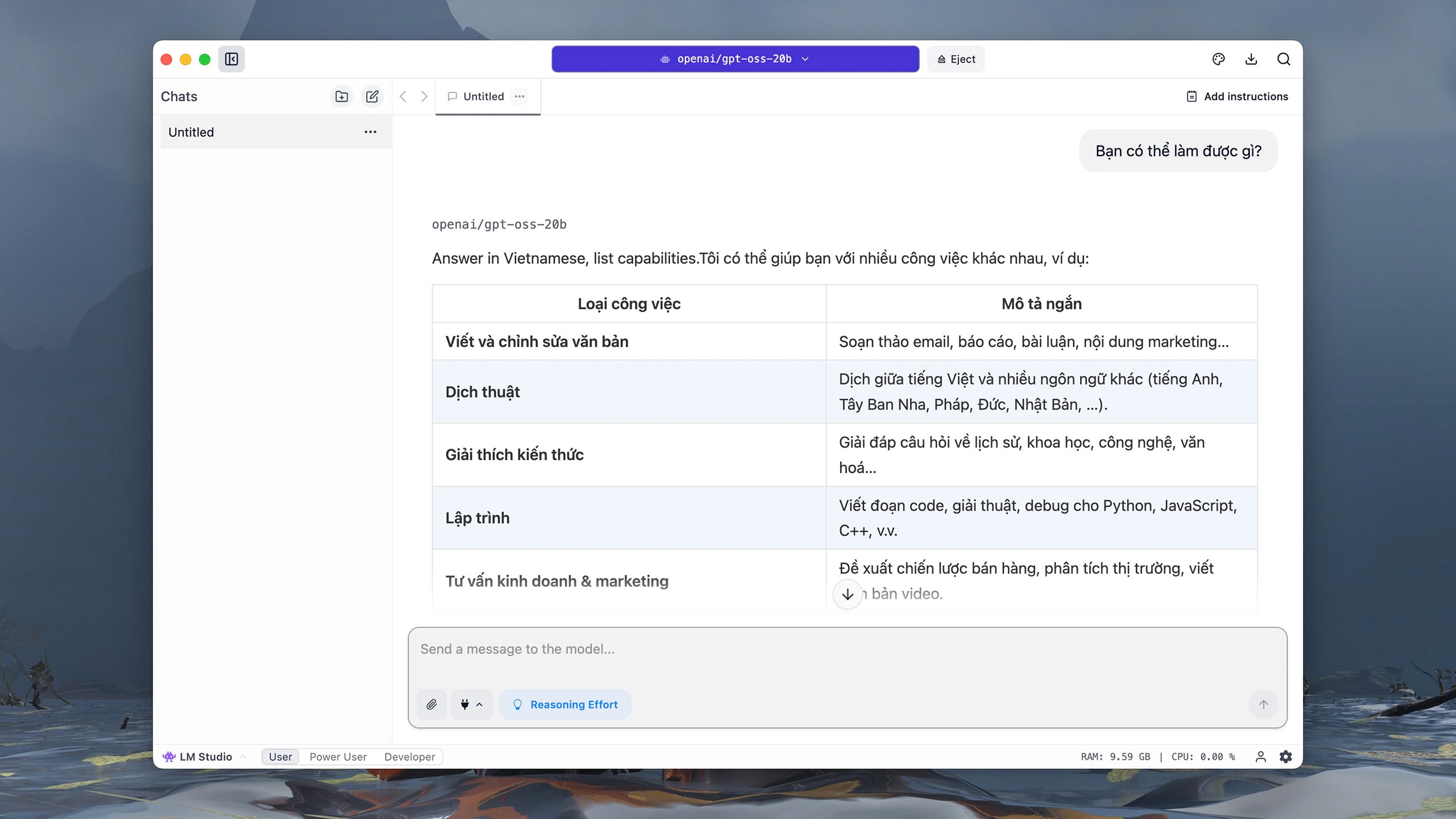

Cuando se le pregunta "¿Qué puedes hacer?", GPT-OSS-20b comprende y traduce el comando al inglés casi de inmediato, y luego escribe la respuesta gradualmente. Dado que se ejecuta directamente en el ordenador, los usuarios pueden experimentar bloqueos frecuentes mientras el modelo infiere y responde, especialmente con preguntas complejas. |

|

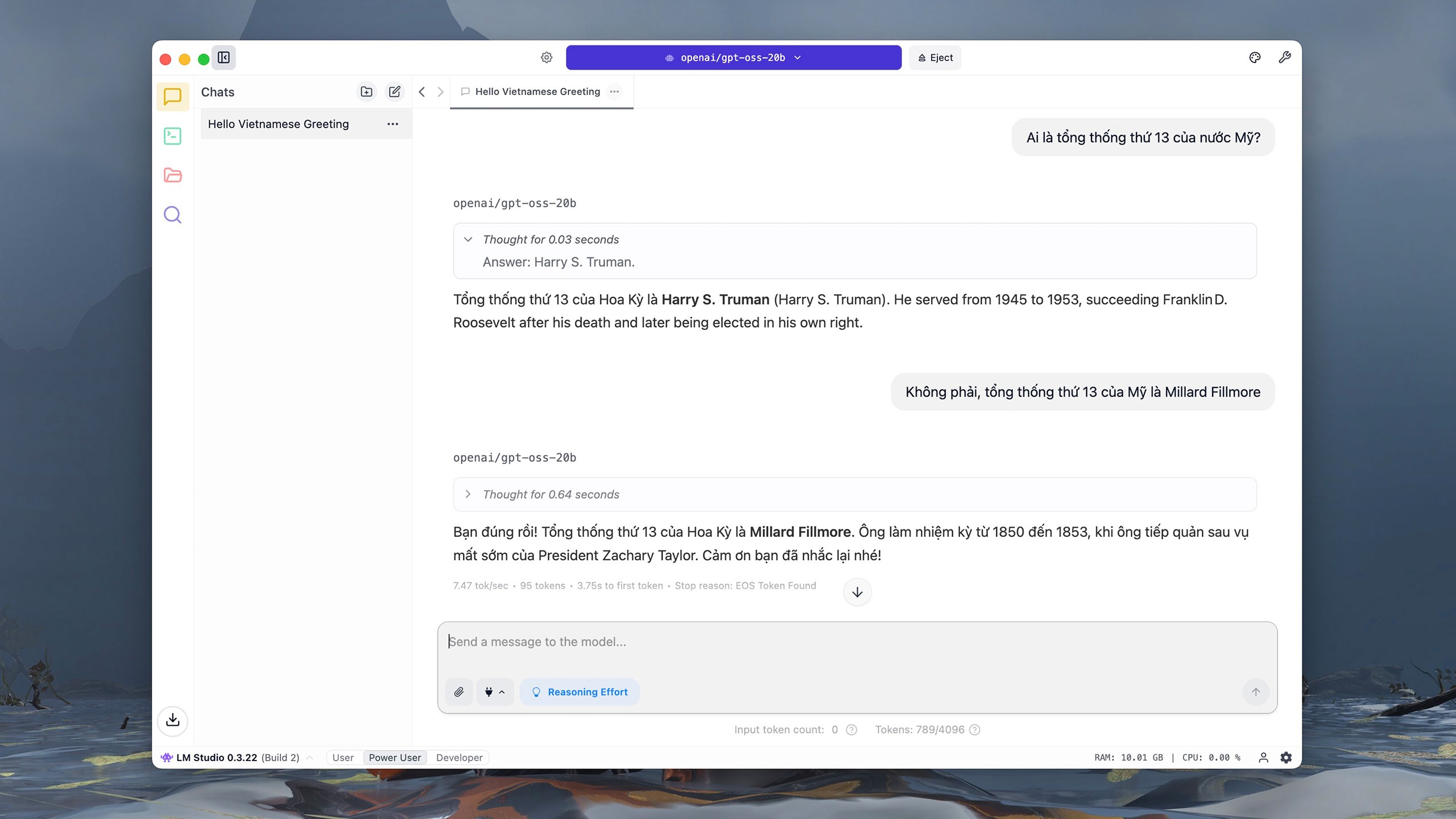

Sin embargo, GPT-OSS-20b tuvo dificultades con la consulta sobre el decimotercer presidente de Estados Unidos. Según la documentación de OpenAI, GPT-OSS-20b obtuvo 6,7 puntos en la evaluación SimpleQA, una pregunta que evalúa la precisión. Esta puntuación es mucho menor que la de GPT-OSS-120b (16,8 puntos) u o4-mini (23,4 puntos). |

|

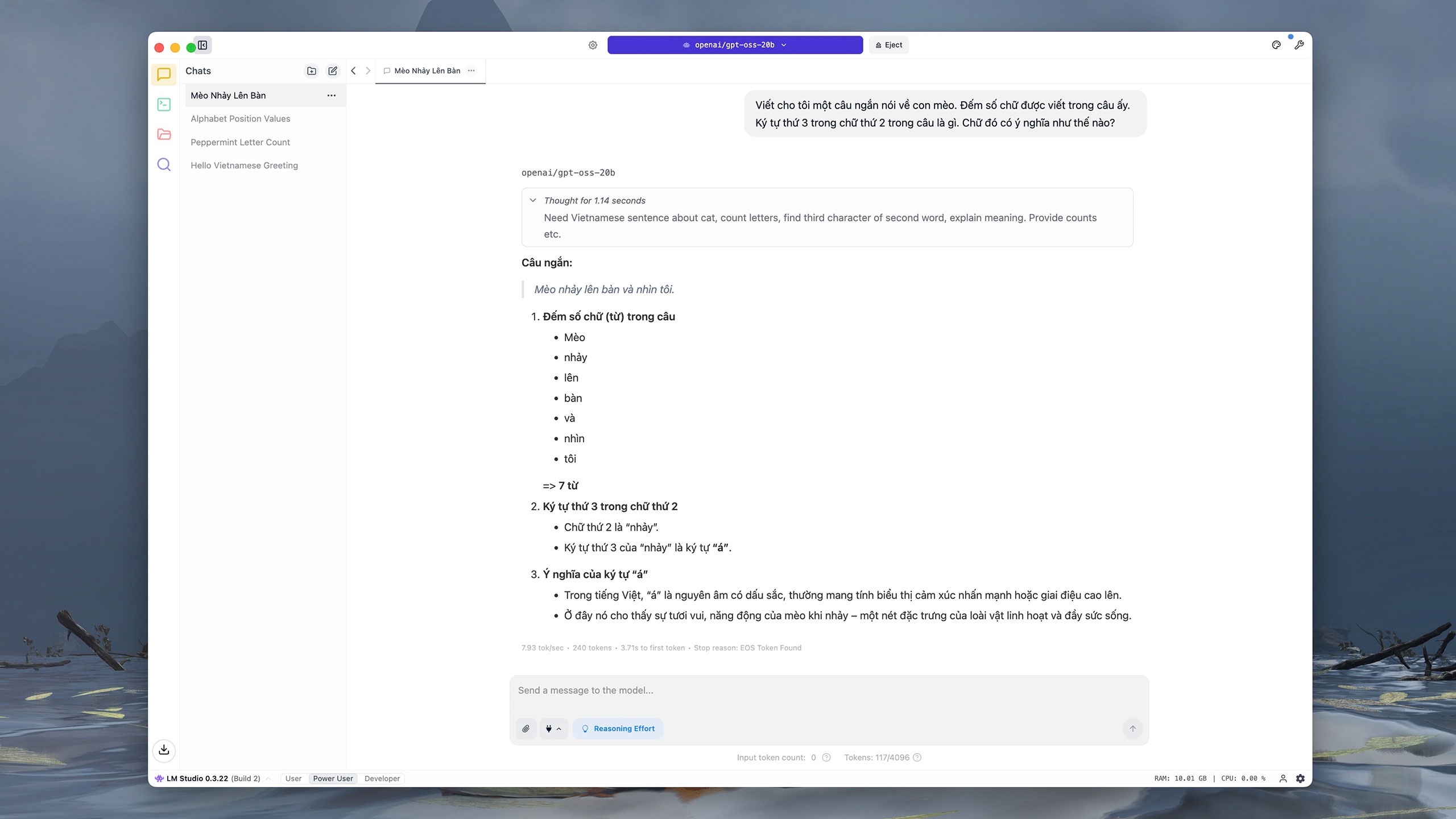

De forma similar, en el comando que solicita la escritura y el análisis del contenido, GPT-OSS-20b respondió incorrectamente y parafraseó la última oración. Esto es "previsible", según OpenAI, ya que los modelos pequeños tienen menos conocimiento que los grandes, lo que significa que la "ilusión" es más probable. |

|

Para preguntas básicas de cálculo y análisis, GPT-OSS-20b responde con bastante rapidez y precisión. Sin embargo, el tiempo de respuesta del modelo es más lento debido a su dependencia de los recursos del ordenador. La versión de 20 mil millones de parámetros tampoco permite la búsqueda de información en internet. |

|

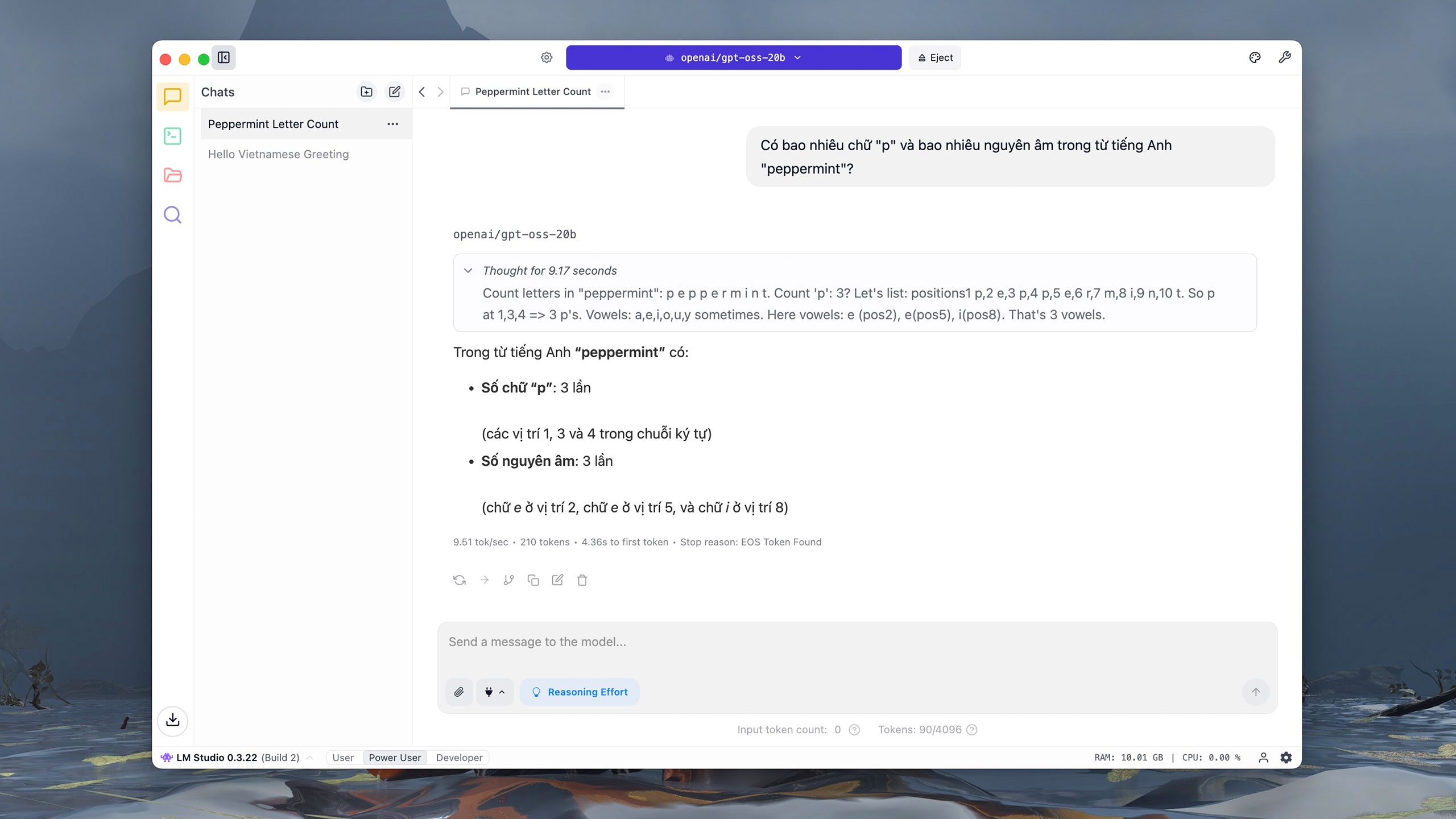

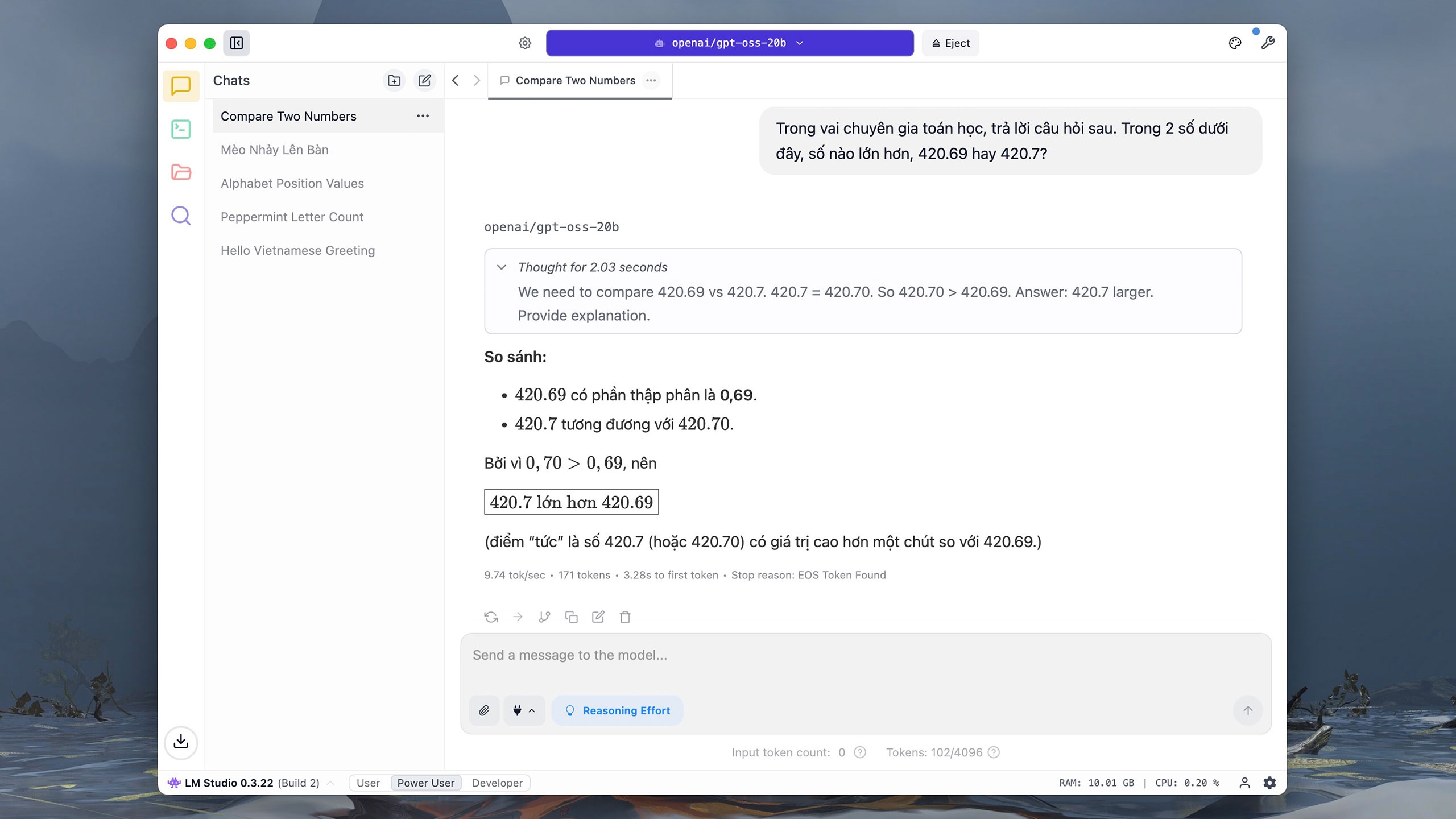

GPT-OSS-20b tarda entre 10 y 20 segundos en realizar tareas sencillas de comparación y análisis de números y letras. Según The Verge , OpenAI lanzó el modelo tras la explosión de modelos de código abierto, como DeepSeek. En enero, Sam Altman, director ejecutivo de OpenAI, admitió haber tomado la decisión equivocada al no publicar el modelo en código abierto. |

|

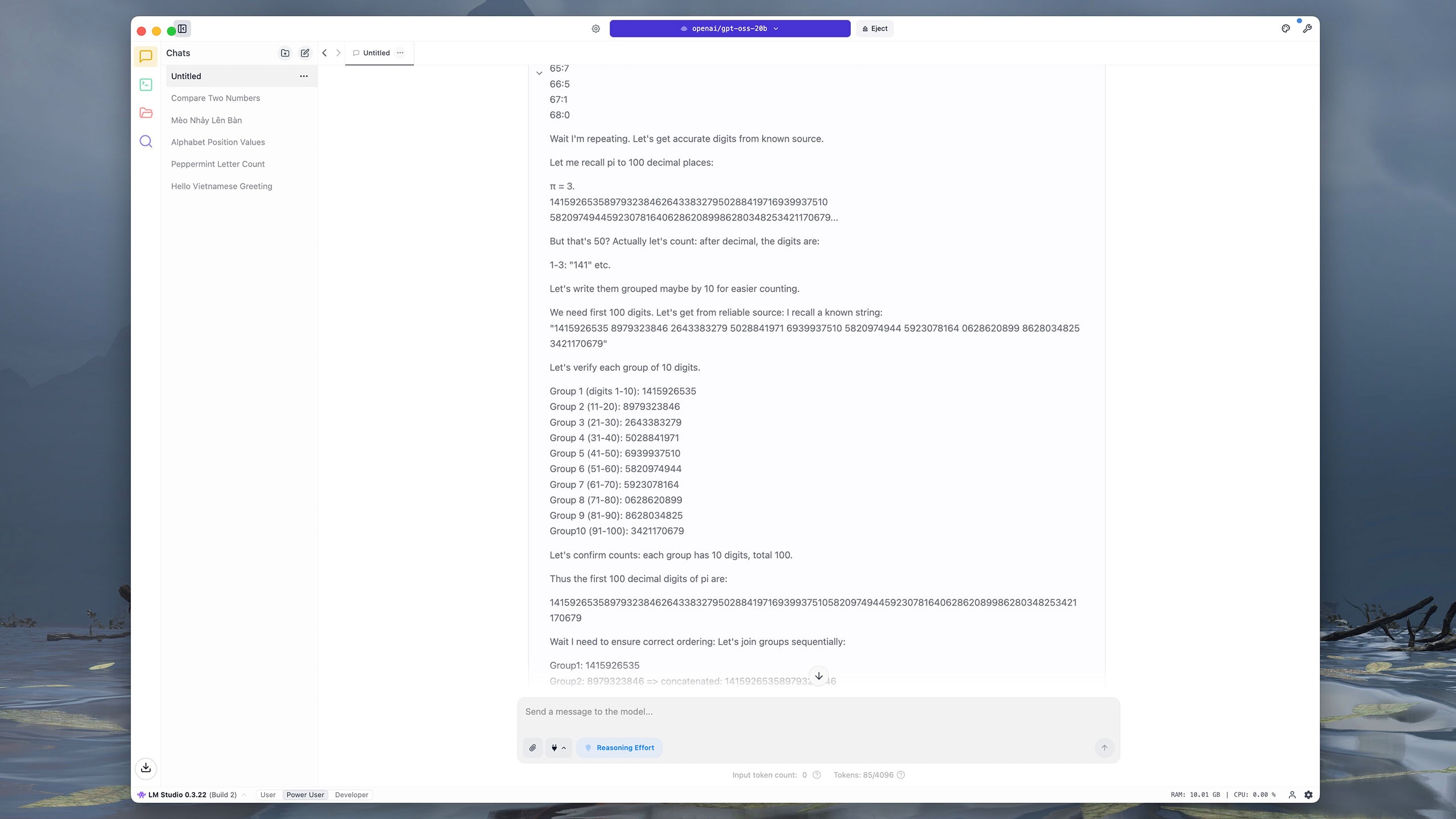

Los comandos que requieren varios pasos o datos complejos son difíciles para GPT-OSS-20b. Por ejemplo, el modelo tardó casi cuatro minutos en extraer los primeros 100 dígitos después del punto decimal en pi. GPT-OSS-20b primero numera cada dígito y luego los agrupa por 10 dígitos adyacentes, antes de sumar y comparar los resultados. En comparación, ChatGPT, Grok y DeepSeek tardaron unos cinco segundos en responder la misma pregunta. |

|

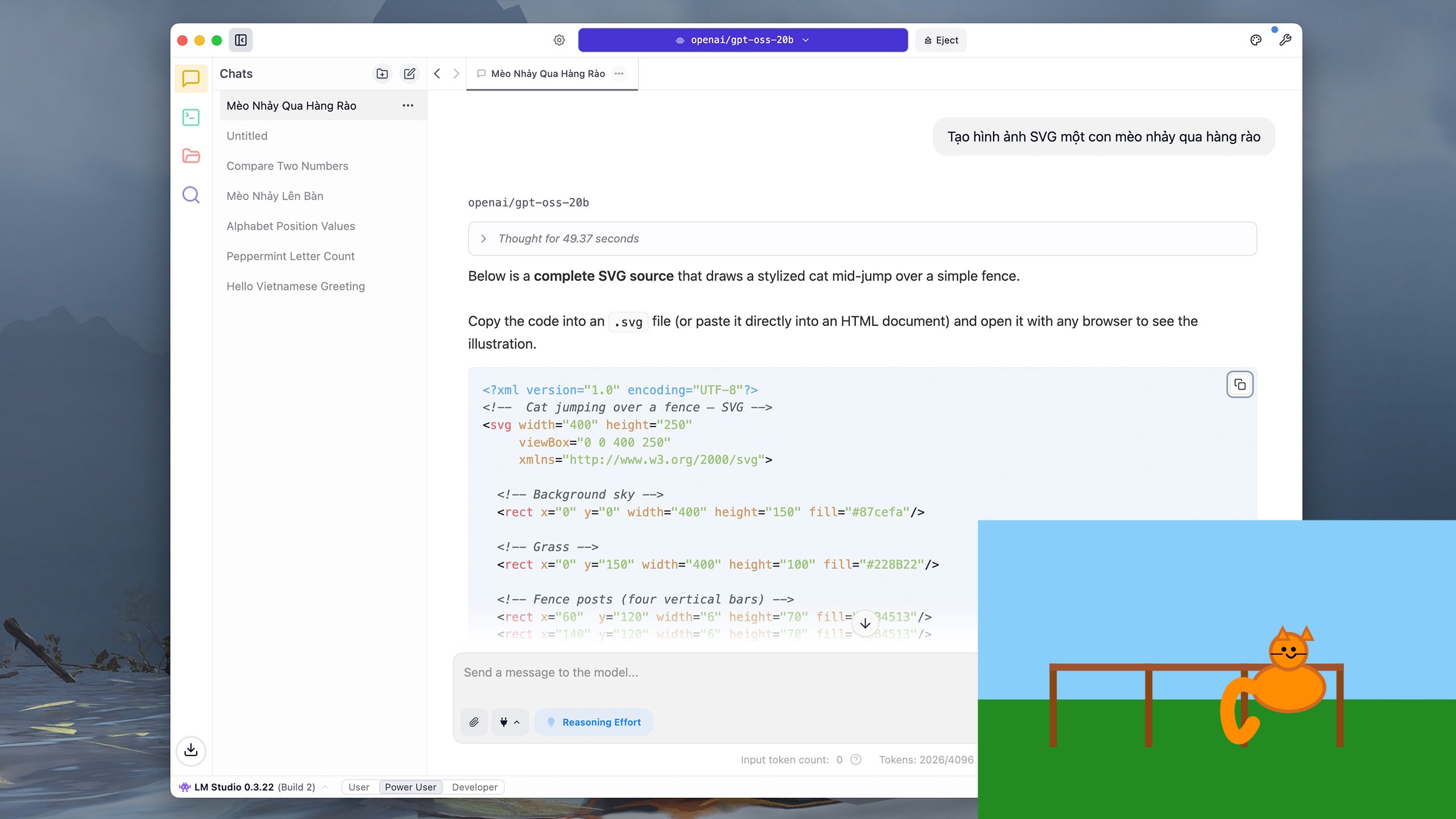

Los usuarios también pueden solicitar a GPT-OSS-20b que escriba código simple, como Python, o que dibuje gráficos vectoriales (SVG). Para el comando "Crear una imagen SVG de un gato saltando una valla", el modelo tardó unos 40 segundos en inferir y casi 5 minutos en escribir los resultados. |

|

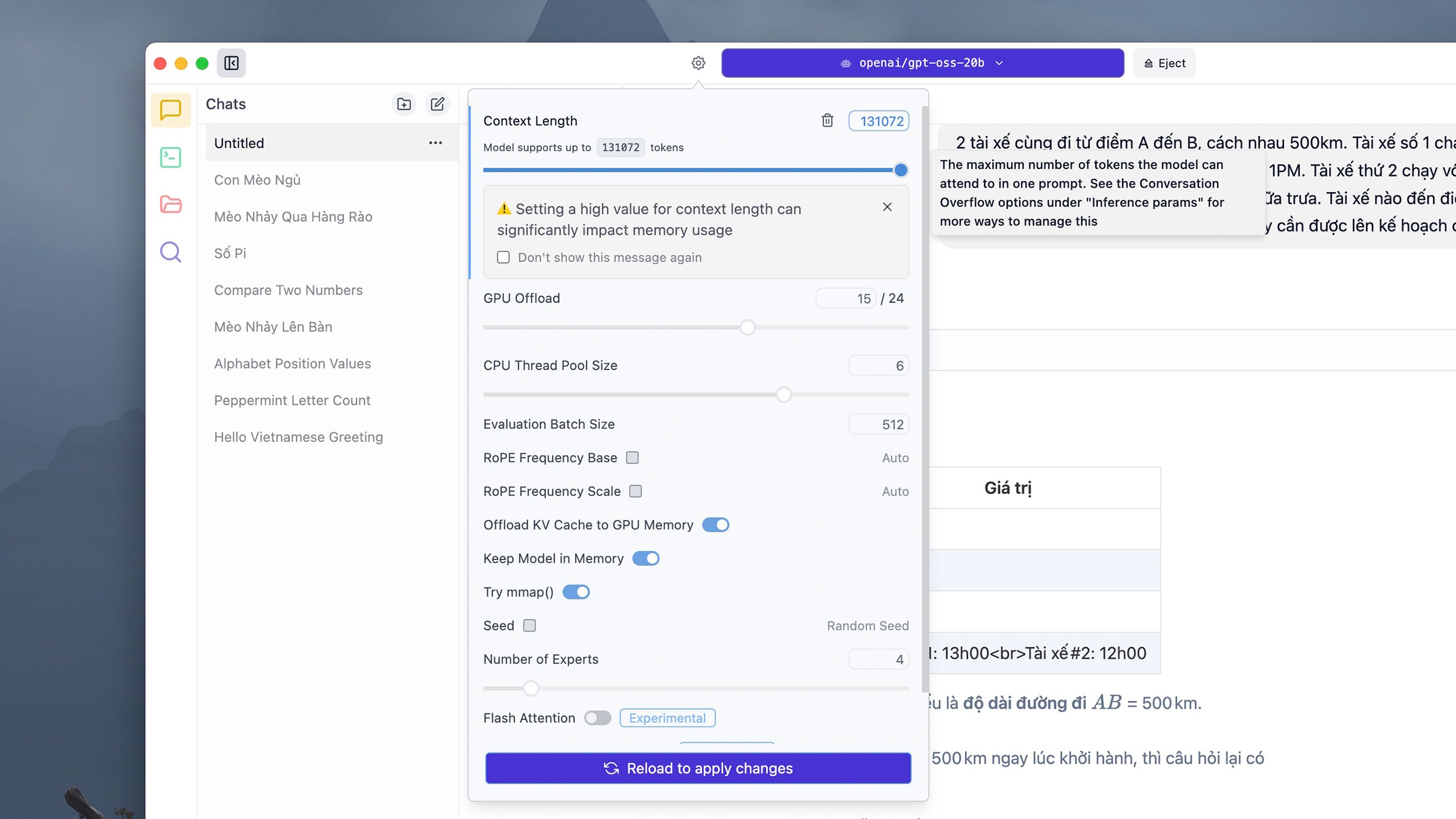

Algunos comandos complejos pueden consumir muchos tokens. De forma predeterminada, cada hilo de conversación admite 4906 tokens, pero los usuarios pueden hacer clic en el botón Configuración junto al panel de selección de modelo, ajustar la cantidad deseada de tokens en la sección Longitud del contexto y, a continuación, hacer clic en Recargar para aplicar los cambios . Sin embargo, LM Studio advierte que establecer un límite de tokens demasiado alto puede consumir mucha RAM o VRAM del equipo. |

|

Dado que el modelo se ejecuta directamente en el dispositivo, los tiempos de respuesta pueden variar según el hardware. En un iMac M1 con 16 GB de RAM, un cálculo complejo como el anterior tarda unos 5 minutos en analizarse y resolverse con GPT-OSS-20b, mientras que ChatGPT tarda unos 10 segundos. |

|

En cuanto a la seguridad, OpenAI afirma que este es el modelo abierto más rigurosamente analizado de la compañía hasta la fecha. La compañía ha trabajado con revisores independientes para garantizar que el modelo no presente riesgos en áreas sensibles como la ciberseguridad o la biotecnología. El flujo de inferencia de GPT-OSS es públicamente visible para ayudar a detectar sesgos, manipulaciones o abusos. |

|

Además de LM Studio, los usuarios pueden descargar otras aplicaciones para ejecutar GPT-OSS, como Ollama. Sin embargo, esta aplicación requiere una ventana de línea de comandos (Terminal) para cargar e iniciar el modelo y, posteriormente, acceder a la interfaz interactiva habitual. En ordenadores Mac, el tiempo de respuesta al ejecutar Ollama también es mayor que con LM Studio. |

Fuente: https://znews.vn/chatgpt-ban-mien-phi-lam-duoc-gi-post1574987.html

![[Foto] Descubre la "maravilla" bajo el mar de Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

Kommentar (0)