El gigante tecnológico OpenAI promocionó su herramienta de conversión de voz a texto, Whisper, como una IA con "precisión y robustez similares a las humanas". Pero Whisper tenía un defecto importante: generaba texto y oraciones completamente falsas.

Algunos de los textos generados por IA —denominados «alucinaciones»— pueden incluir comentarios racistas, lenguaje violento e incluso tratamientos médicos imaginarios. — Foto: AP

Según AP, algunos de los textos generados por IA son considerados “alucinatorios”, e incluyen comentarios racistas, lenguaje violento e incluso tratamientos médicos imaginarios.

Alto índice de "ilusión" en los textos generados por IA

Los expertos están particularmente preocupados porque Whisper se utiliza ampliamente en muchas industrias de todo el mundo para traducir y transcribir entrevistas, generar texto en tecnologías de consumo populares y crear subtítulos para vídeos.

Lo que resulta aún más preocupante es que muchos centros médicos están utilizando Whisper para transferir consultas entre médicos y pacientes, aunque OpenAI ha advertido que la herramienta no debe utilizarse en zonas de “alto riesgo”.

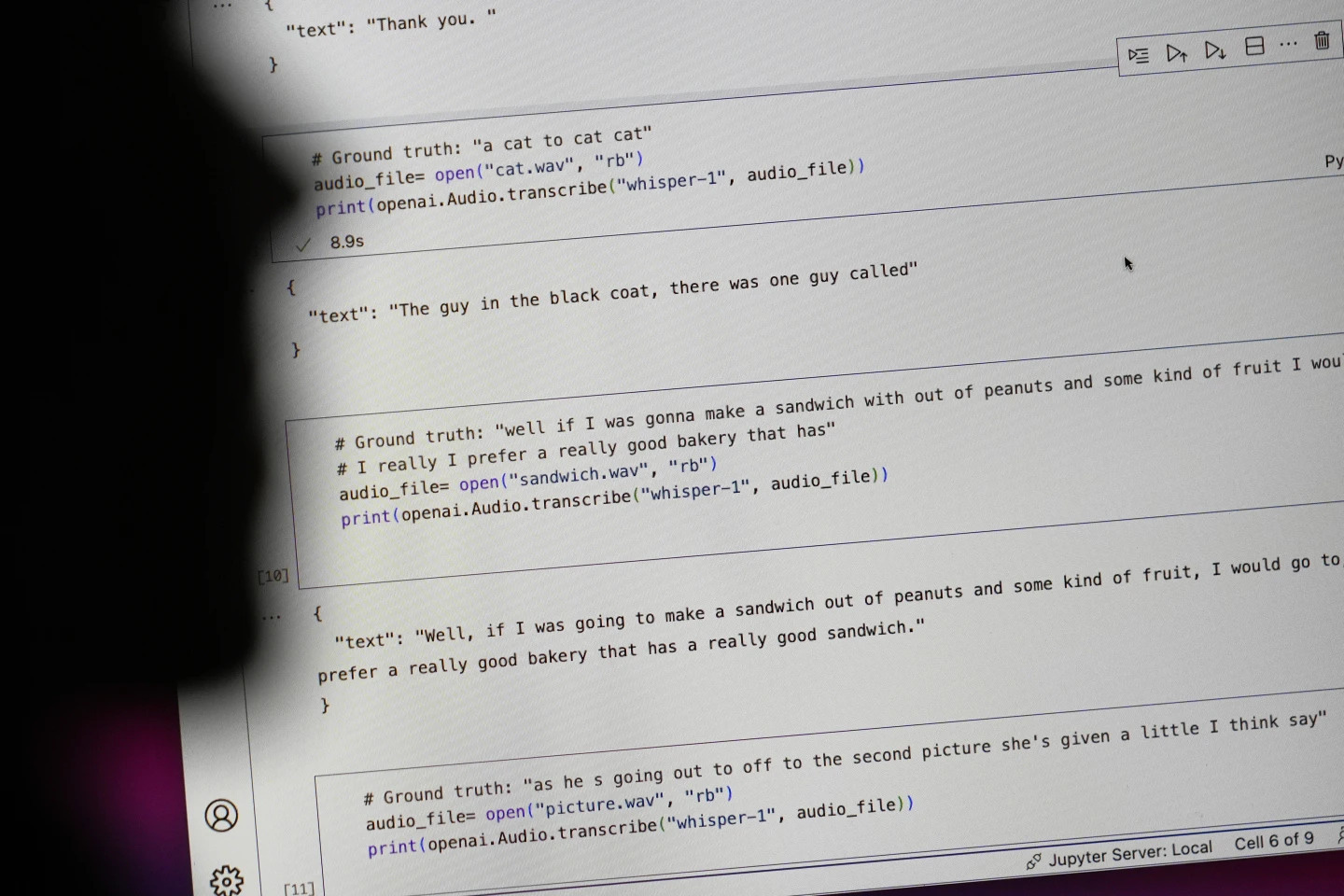

Resulta difícil determinar el alcance total del problema, pero investigadores e ingenieros afirman que se encuentran regularmente con "alucinaciones" relacionadas con Whisper en su trabajo.

Un investigador de la Universidad de Michigan afirmó haber encontrado alucinaciones en ocho de cada diez transcripciones de audio que examinó. Un ingeniero informático halló alucinaciones en aproximadamente la mitad de las transcripciones de más de 100 horas de audio que analizó. Otro desarrollador declaró haber encontrado alucinaciones en casi la totalidad de las 26 000 grabaciones que creó con Whisper.

El problema persiste incluso con muestras de audio cortas y bien grabadas. Un estudio reciente realizado por informáticos halló 187 «ilusiones» en más de 13 000 clips de audio nítidos que analizaron. Esta tendencia daría lugar a decenas de miles de transcripciones erróneas en millones de grabaciones, según los investigadores.

Estos errores pueden tener “consecuencias muy graves”, especialmente en entornos hospitalarios, según Alondra Nelson, quien dirigió la Oficina de Ciencia y Tecnología de la Casa Blanca durante la administración Biden hasta el año pasado.

“Nadie quiere un diagnóstico erróneo”, dijo Nelson, ahora profesor en el Instituto de Estudios Avanzados de Princeton, Nueva Jersey. “Es necesario un estándar más alto”.

Whisper también se utiliza para crear subtítulos para personas sordas o con discapacidad auditiva, un colectivo especialmente vulnerable a las malas traducciones. Esto se debe a que las personas sordas o con discapacidad auditiva no tienen forma de identificar los fragmentos manipulados «ocultos entre el resto del texto», explica Christian Vogler, persona sorda y director del Programa de Accesibilidad Tecnológica de la Universidad de Gallaudet.

Se recurre a OpenAI para resolver el problema

La prevalencia de estas «alucinaciones» ha llevado a expertos, activistas y exempleados de OpenAI a pedir al gobierno federal que considere la regulación de la IA. Como mínimo, OpenAI debe abordar este problema.

“Este problema tiene solución si la empresa está dispuesta a darle prioridad”, dijo William Saunders, un ingeniero de investigación de San Francisco que dejó OpenAI en febrero por su preocupación sobre el rumbo de la empresa.

“Sería problemático si se lanzara al mercado y la gente confiara tanto en sus capacidades que lo integrara en todos los demás sistemas”. Un portavoz de OpenAI afirmó que la empresa trabaja constantemente para mitigar estas “ilusiones” y valora los hallazgos de los investigadores, añadiendo que OpenAI incorpora las opiniones de los usuarios en las actualizaciones de sus modelos.

Si bien la mayoría de los desarrolladores asumen que las herramientas de conversión de texto a voz pueden cometer errores tipográficos u otros fallos, los ingenieros e investigadores afirman que nunca han visto una herramienta de conversión de texto a voz con inteligencia artificial que "alucine" tanto como Whisper.

Premio Nobel de Física 2024: Las personas que sentaron las bases de la IA

Premio Nobel de Física 2024: Las personas que sentaron las bases de la IAFuente: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Foto] Cortes en las colinas para facilitar el tránsito de personas en la ruta 14E, que sufrió deslizamientos de tierra.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Vídeo] Los monumentos de Hue reabren para recibir visitantes](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Kommentar (0)