La Oficina del Fiscal General de New Hampshire anunció el lunes que está investigando una posible manipulación de votantes luego de quejas de una voz falsa que sonaba exactamente como la del presidente estadounidense Joe Biden instando a los votantes a no votar en las primarias del estado.

Los investigadores también advirtieron sobre el uso de audio deepfake para imitar a políticos y líderes, con casos destacados ocurridos en 2023 en el Reino Unido, India, Nigeria, Sudán, Etiopía y Eslovaquia.

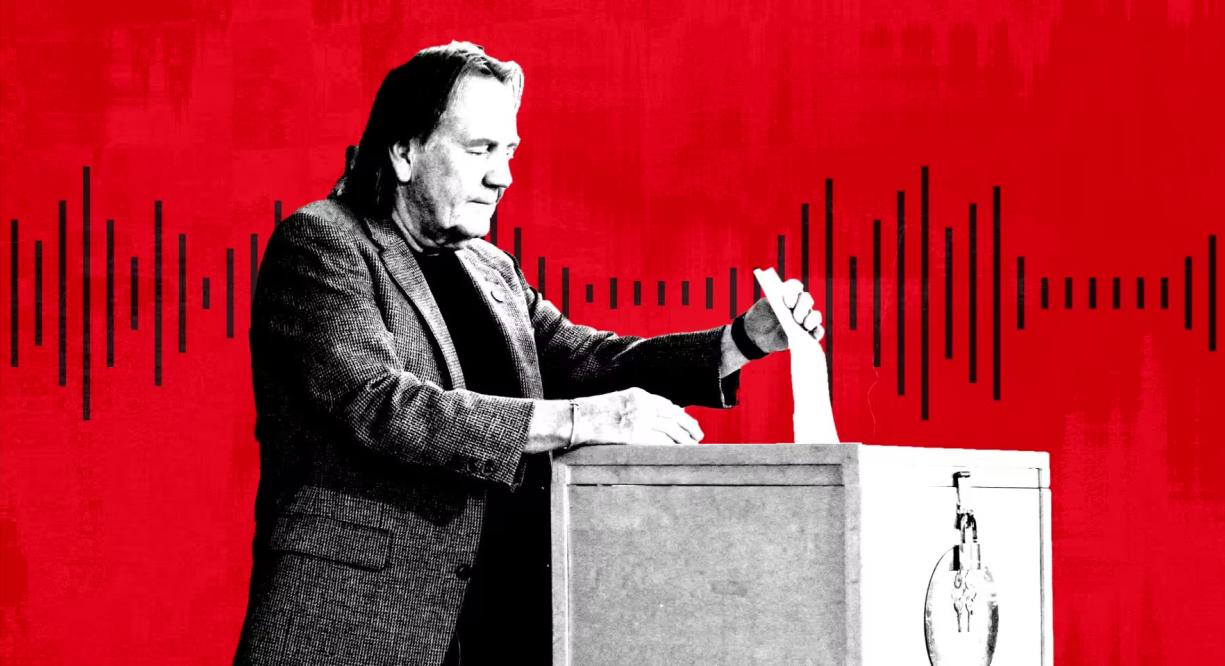

Una persona vota en las elecciones primarias de New Hampshire, EE. UU. Foto: Getty

Según los expertos, el audio deepfake se ha convertido en una forma popular de desinformación debido a la aparición de una gama de herramientas de IA económicas y efectivas de startups. Microsoft también ha desarrollado un nuevo modelo de IA que puede copiar voces a partir de tan solo tres segundos de grabación.

“En lo que respecta a la manipulación visual, todo el mundo conoce Photoshop o al menos sabe que existe”, afirmó Henry Ajder, experto en inteligencia artificial y deepfakes, y consultor de Adobe, Meta y EY. “Hay muy poca conciencia sobre cómo se puede manipular el audio, así que, en mi opinión, eso nos deja muy vulnerables”.

En septiembre, NewsGuard, un sistema que evalúa la calidad y la fiabilidad de los sitios de noticias, descubrió una red de cuentas de TikTok que se hacían pasar por sitios de noticias legítimos y utilizaban contenido generado por IA para difundir teorías conspirativas y desinformación política. Grabaciones deepfake, que incluían la voz del expresidente estadounidense Barack Obama, obtuvieron cientos de millones de visualizaciones.

Las voces en off falsas parecen haber sido generadas por una herramienta proporcionada por ElevenLabs, respaldada por Andreessen Horowitz, mientras que los clips han obtenido cientos de millones de visitas, dijo NewsGuard.

“Más del 99% de los usuarios de nuestra plataforma crean contenido interesante, creativo y útil, pero reconocemos que hay casos de mal uso y hemos desarrollado e introducido continuamente protecciones para limitarlos”, afirmó ElevenLabs.

ElevenLabs, fundada hace dos años por Piotr Dabkowski y Mati Staniszewski, exempleados de Google y Palantir, ofrece herramientas básicas de generación de audio con IA gratuitas y con un solo clic. Los planes de suscripción varían desde $1 al mes hasta $330 al mes, e incluso más para quienes buscan servicios más complejos.

El año pasado, las agencias de inteligencia estadounidenses advirtieron en un informe que “las estafas de IA personalizadas han aumentado significativamente debido al lanzamiento de modelos de clonación de voz de IA sofisticados y bien entrenados”.

Además de las estafas con fines económicos, los expertos políticos alertan sobre los audios virales deepfakes, así como sobre su uso para llamadas automáticas o campañas. «Se puede crear una campaña de desinformación potente y generalizada atacando teléfonos», afirmó AJ Nash, vicepresidente y miembro destacado de inteligencia del grupo de ciberseguridad ZeroFox.

Algunas de estas empresas han sido proactivas al buscar otras maneras de combatir la desinformación. Microsoft ha emitido una declaración ética que insta a los usuarios a denunciar cualquier uso indebido de su herramienta de audio con IA. ElevenLabs ha desarrollado sus propias herramientas de detección para identificar las grabaciones de audio creadas por su sistema.

Durante las elecciones de 2023 en Nigeria, un clip manipulado por inteligencia artificial se volvió viral en las redes sociales "pretendiendo insinuar que un candidato de la oposición planeaba manipular la votación", según el grupo de derechos humanos Freedom House.

En Eslovaquia, una grabación de audio falsa del candidato opositor Michal Šimečka aparentemente conspirando para manipular las elecciones se volvió viral pocos días antes de las elecciones presidenciales del país en septiembre.

“El deepfake de New Hampshire es un recordatorio de las múltiples maneras en que los deepfakes pueden confundir y engañar”, declaró Robert Weissman, presidente de Public Citizen, organización sin fines de lucro de defensa del consumidor. “Ha llegado el momento del deepfake político. Los legisladores deben actuar con rapidez para implementar medidas de protección o nos enfrentaremos al caos electoral”.

Mai Anh (según el FT)

[anuncio_2]

Fuente

![[Foto] El primer ministro Pham Minh Chinh se reúne con el presidente de la Asamblea Nacional húngara, Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

![[Foto] El presidente del Parlamento húngaro visita el mausoleo del presidente Ho Chi Minh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760941009023_ndo_br_hungary-jpg.webp)

![[Foto] Solemne apertura de la X Sesión de la XV Asamblea Nacional](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760937111622_ndo_br_1-202-jpg.webp)

![[Foto] El presidente de la Asamblea Nacional, Tran Thanh Man, mantiene conversaciones con el presidente de la Asamblea Nacional húngara, Kover Laszlo.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760952711347_ndo_br_bnd-1603-jpg.webp)

Kommentar (0)