Google Maps integra el modelo Gemini 2.5

Tras el lanzamiento del modelo Gemini 2.5, Google continúa integrando la inteligencia artificial en su aplicación más popular: Google Maps. Por primera vez, el mapa no solo muestra indicaciones, sino que también escucha, comprende y responde en lenguaje natural, un avance que transforma la herramienta de navegación en un auténtico asistente de comunicación.

A medida que Google Maps se vuelve más inteligente

Según el blog oficial de Google DeepMind (noviembre de 2025), Gemini 2.5, un modelo de IA capaz de manipular navegadores y procesar datos del mundo real, ha comenzado a probar su integración en Google Maps. El objetivo es ayudar a los usuarios a interactuar de forma natural con el mapa, en lugar de tener que introducir manualmente cada ubicación u opciones complejas.

Gemini puede comprender peticiones como: "Busca un restaurante cercano que esté abierto hasta tarde, pero evita las obras en la carretera" o "Llévame a casa, pero para en una farmacia de camino". El sistema leerá automáticamente los datos de tráfico en tiempo real, determinará la ubicación de la persona que habla y sugerirá la mejor ruta.

"Gemini está entrenado para comprender no solo las palabras, sino también la intención del usuario en el espacio real", describe Google en una publicación que presenta la función "Pregunta a Gemini en Maps".

Según una investigación de Tuoi Tre Online , la primera versión de prueba se está implementando en EE. UU., Canadá y el Reino Unido, con planes de expandirla a países asiáticos en 2026. Algunos usuarios de Android han podido activar el comando de voz "Preguntar a Gemini en Maps" para dar órdenes o chatear directamente.

Lo especial de Gemini es que no solo consulta mapas , sino que también analiza imágenes de Street View, reseñas de la comunidad, hábitos de viaje y datos meteorológicos, por lo que el mapa puede decir frases naturales como "Gire a la derecha en la cafetería de la Sra. Bay" en lugar de "Gire a la derecha después de 200 metros".

La tecnología "Escuchar - comprender - responder" y el progreso en la personalización

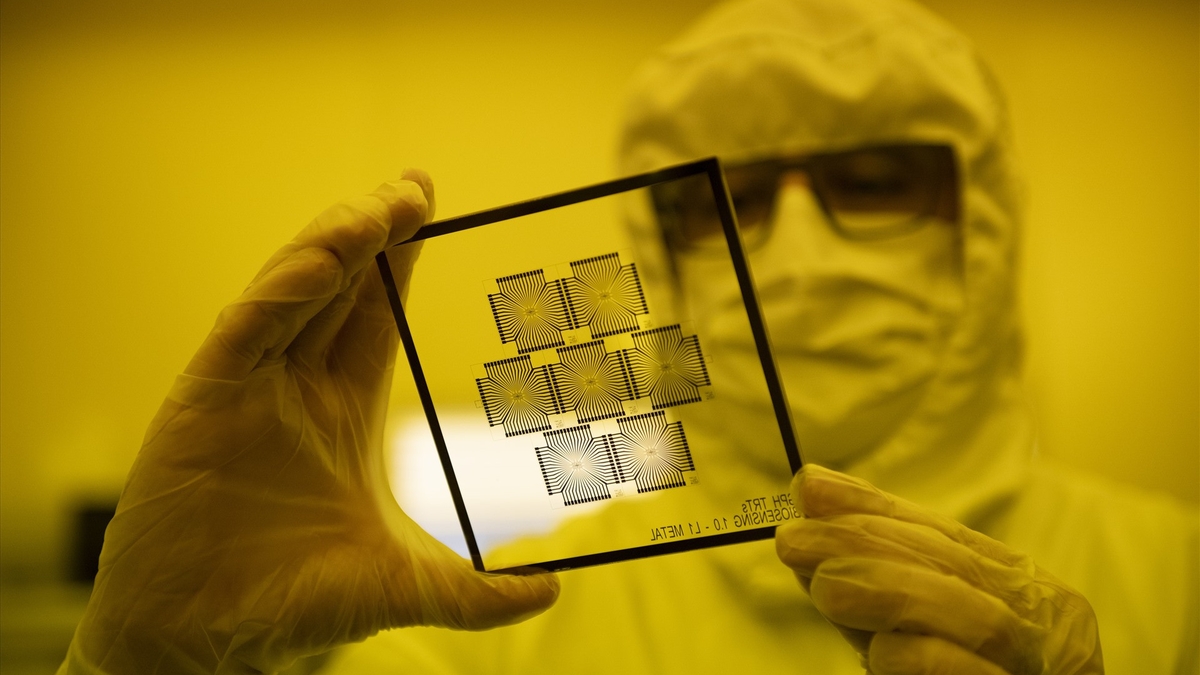

Técnicamente, Gemini in Maps aplica un modelo multimodal que combina el procesamiento del lenguaje, las imágenes y los datos de ubicación para "comprender" el mundo tal como lo perciben los humanos.

El sistema utiliza técnicas de asociación (que vinculan el lenguaje con objetos y lugares específicos) para permitir que la IA comprenda oraciones naturales como "ve hacia la puesta de sol" o "pasa la intersección con la señal roja".

En comparación con la versión anterior del Asistente de Google, Gemini es aproximadamente el doble de rápido y consume menos datos en la nube gracias a la IA integrada en los dispositivos Pixel y Android de gama alta. Esto no solo permite respuestas casi instantáneas, sino también una mejor protección de la privacidad, ya que muchos comandos de voz se procesan directamente en el dispositivo del usuario.

Los expertos en tecnología afirman que la llegada de Gemini a Maps podría convertir el mapa en una verdadera interfaz conversacional , donde los usuarios pueden hacer preguntas, ajustar rutas o conocer ubicaciones sin usar las manos.

Esta tendencia también abre una nueva fase: la IA no solo responde preguntas, sino que también comienza a actuar en nombre de los humanos en el mundo real.

Google aún no ha anunciado una fecha de lanzamiento oficial, pero los expertos predicen que 2026 será el año clave para ampliar la integración de Gemini en el ecosistema Android, desde indicaciones y reserva de coches hasta gestión de viajes personales.

Fuente: https://tuoitre.vn/google-maps-nang-cap-biet-nghe-va-tro-chuyen-voi-nguoi-dung-20251107112218748.htm

![[Foto] Da Nang: Cientos de personas se unen para limpiar una importante ruta turística tras la tormenta número 13.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/07/1762491638903_image-3-1353-jpg.webp)

Kommentar (0)