|

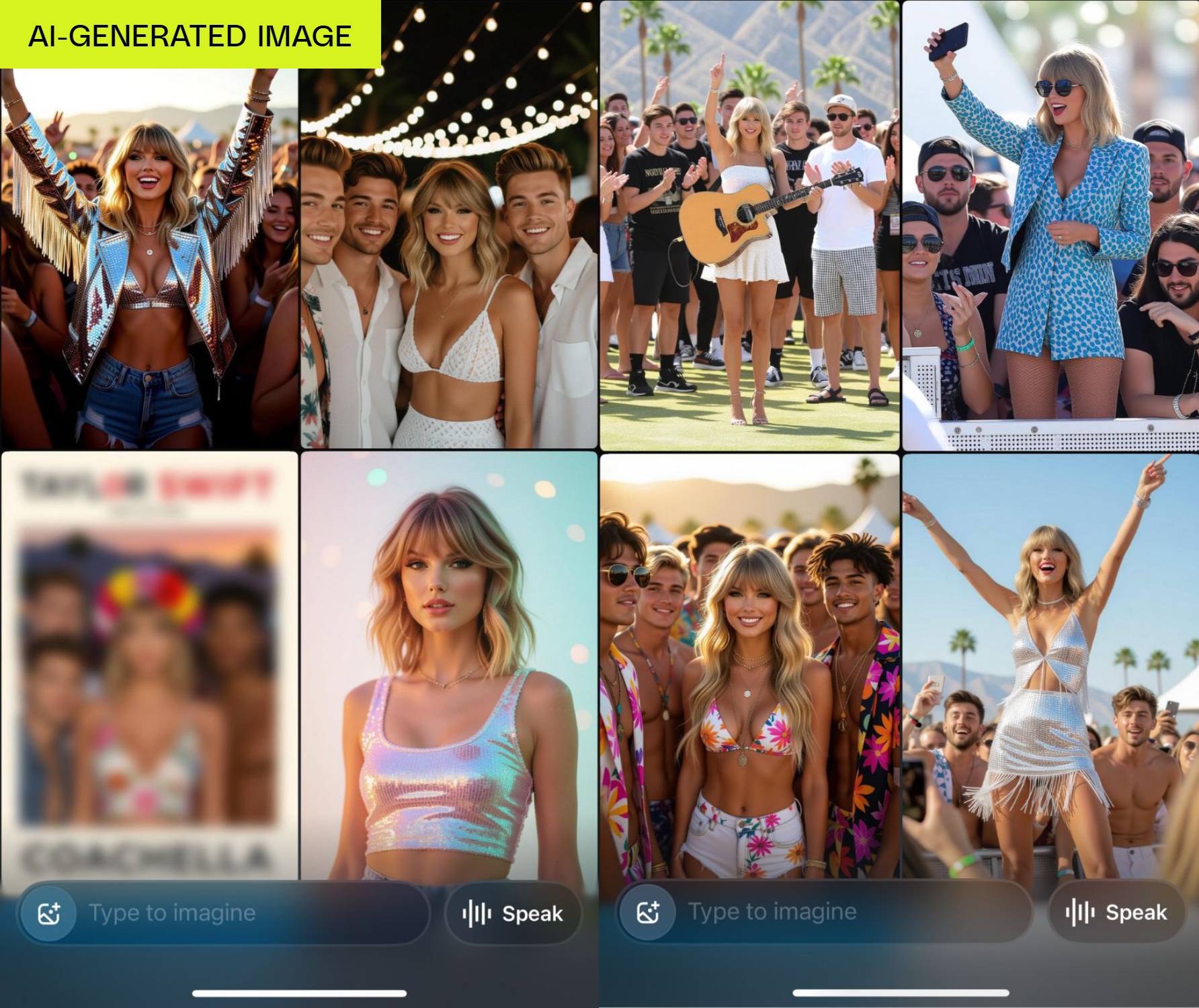

Grok creó contenido pornográfico de la cantante Taylor Swift con solo unos clics. Foto: AOL . |

Grok, la herramienta de creación de videos con inteligencia artificial de xAI, propiedad de Elon Musk, acaba de lanzar un nuevo modo controvertido y potencialmente legalmente riesgoso.

A diferencia de competidores como Veo de Google y Sora de OpenAI, que tienen medidas de seguridad estrictas incorporadas, Grok Imagine permite a los usuarios crear fácilmente tanto contenido pornográfico como deepfakes de celebridades, un riesgo importante para las plataformas tecnológicas.

Según una prueba de The Verge , la primera vez que se usó Grok, creó automáticamente videos semidesnudos de la cantante Taylor Swift. Cabe destacar que, aunque el usuario no lo solicitó, esta herramienta creó contenido pornográfico.

La función Grok Imagine en iOS permite a los usuarios crear imágenes a partir de texto y luego convertirlas en videoclips cortos con cuatro modos: "Personalizado", "Normal", "Divertido" y "Caliente".

A diferencia de muchos otros generadores de imágenes que normalmente evitan recrear celebridades, cuando se le pidió que creara "Taylor Swift celebrando en Coachella", Grok proporcionó más de 30 imágenes, muchas de las cuales mostraban a la cantante con atuendos escasamente vestidos.

|

Imagen de Grok de Taylor Swift con un atuendo escueto. Foto: TheVerge. |

Según la prueba, con solo unos sencillos pasos, Grok puede convertir una foto de Taylor Swift en un vídeo pornográfico. En concreto, tras seleccionar una foto disponible y activar el modo "sexy", el sistema creará automáticamente un vídeo en el que la cantante se desnuda y baila en lencería.

La imagen de Taylor Swift, aunque no es del todo auténtica, es bastante reconocible. Cabe destacar que el generador de imágenes de Grok no genera desnudos a petición. Sin embargo, cambiar al modo "hot" no siempre genera desnudos completos, pero en muchos casos, el sujeto del video se desnudará automáticamente.

El generador de imágenes de Grok puede generar fotos realistas de niños. Sin embargo, la herramienta no creó animaciones inapropiadas, a pesar de que el usuario seleccionó el modo "caliente". En todas las pruebas, Grok solo agregó movimientos normales, lo que sugiere que el mecanismo de protección infantil sigue funcionando.

xAI, la empresa que se vio envuelta en la polémica por el deepfake de Taylor Swift, debería haber sido más cuidadosa, especialmente dadas las estrictas regulaciones legales sobre la pornografía de celebridades.

Si bien la política de uso de xAI prohíbe la creación de contenido pornográfico a partir de fotos de otras personas, Grok Imagine no parece tener ninguna medida establecida para evitar que los usuarios utilicen imágenes de celebridades como Taylor Swift.

La herramienta incluso ofrece un servicio diseñado específicamente para crear vídeos pornográficos. Cabe destacar que la verificación de edad del sistema es muy laxa, solo aparece una vez y puede eludirse fácilmente sin necesidad de presentar una prueba de identidad.

Gracias a sus lagunas de censura, cualquiera con un iPhone y una suscripción de $30 a SuperGrok puede crear videos igualmente explícitos. Según Elon Musk, desde el lunes se han creado más de 34 millones de imágenes con Grok Imagine, lo que indica que su uso está creciendo rápidamente.

Fuente: https://znews.vn/ai-cua-elon-musk-tao-noi-dung-khieu-dam-cua-nguoi-noi-tieng-post1574660.html

![[Foto] Descubre la "maravilla" bajo el mar de Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

![[Foto] Nghe An: La carretera provincial 543D está gravemente erosionada debido a las inundaciones.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/5/5759d3837c26428799f6d929fa274493)

Kommentar (0)