El complejo panorama del uso de robots asesinos con IA

Permitir que la IA controle los sistemas de armas podría significar que los objetivos sean identificados, atacados y destruidos sin intervención humana. Esto plantea serias cuestiones legales y éticas.

Para subrayar la gravedad de la situación, el ministro de Asuntos Exteriores austríaco, Alexander Schallenberg, declaró: “Este es el momento Oppenheimer de nuestra generación”.

Los robots y las armas que utilizan inteligencia artificial están empezando a usarse ampliamente en los ejércitos de muchos países. Foto: Forbes

De hecho, hasta qué punto “el genio ha escapado de la botella” se ha convertido en una cuestión apremiante, ya que los drones y la inteligencia artificial (IA) se han generalizado en el uso militar en todo el mundo .

“El uso de drones en conflictos modernos por parte de Rusia y Ucrania, el uso de drones por parte de Estados Unidos en operaciones de ataque selectivas en Afganistán y Pakistán y, como se reveló recientemente el mes pasado, como parte del programa Lavender de Israel, demuestra cómo las capacidades de procesamiento de información de la IA están siendo utilizadas activamente por los ejércitos del mundo para mejorar su poder ofensivo”, dijo Wilson Jones, analista de defensa de GlobalData.

Investigaciones realizadas por la Oficina de Periodismo de Guerra, con sede en Londres, revelaron que el sistema de inteligencia artificial Lavender del ejército israelí tenía una precisión del 90% en la identificación de individuos vinculados a Hamás, lo que significa que el 10% restante no lo estaba. Esto provocó la muerte de civiles debido a las capacidades de identificación y toma de decisiones de la IA.

Una amenaza para la seguridad mundial

El uso de la IA de esta manera subraya la necesidad de gestionar la tecnología en los sistemas de armas.

“El uso de la IA en los sistemas de armas, especialmente cuando se utiliza para la selección de objetivos, plantea cuestiones fundamentales sobre nosotros —los humanos— y nuestra relación con la guerra , y más específicamente sobre nuestras suposiciones acerca de cómo podríamos usar la violencia en los conflictos armados”, explicó a Army Technology el Dr. Alexander Blanchard, investigador principal del programa de Gobernanza de la Inteligencia Artificial del Instituto Internacional de Investigación para la Paz de Estocolmo (SIPRI), un grupo de investigación independiente centrado en la seguridad global.

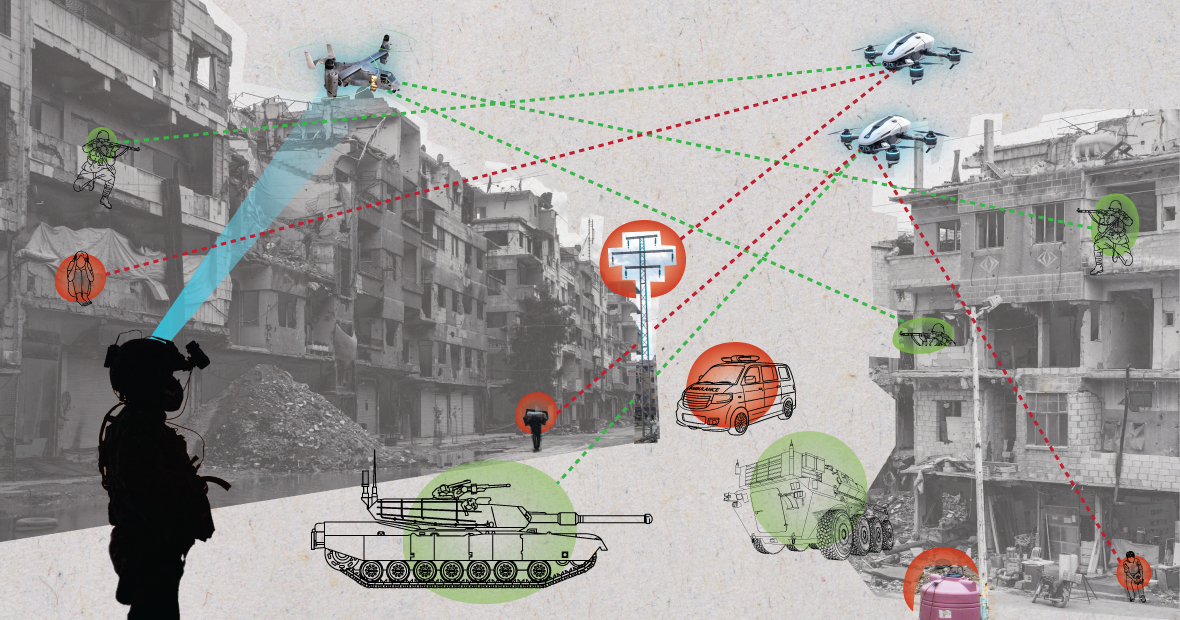

Los sistemas de IA, cuando se utilizan en entornos caóticos, pueden comportarse de forma impredecible y no lograr identificar los objetivos con precisión. Foto: MES

“¿Cambia la IA la forma en que las fuerzas armadas seleccionan objetivos y emplean la fuerza contra ellos? Estos cambios, a su vez, plantean numerosas cuestiones legales, éticas y operativas. Las mayores preocupaciones son de índole humanitaria”, añadió el Dr. Blanchard.

“A muchos les preocupa que, según cómo se diseñen y utilicen los sistemas autónomos, estos puedan poner en mayor riesgo a la población civil y a otras personas protegidas por el derecho internacional”, explicó el experto del SIPRI. “Esto se debe a que los sistemas de IA, sobre todo cuando se utilizan en entornos caóticos, pueden funcionar de forma impredecible y no identificar correctamente los objetivos, atacando a civiles o a combatientes que no están en combate”.

Al profundizar en el tema, Wilson Jones, analista de defensa de GlobalData, señaló que la forma en que se determina la culpabilidad podría ser cuestionable.

“Según el derecho de la guerra vigente, existe el concepto de responsabilidad del mando”, afirmó el Sr. Jones. “Esto significa que un oficial, general u otro líder es legalmente responsable de las acciones de las tropas bajo su mando. Si las tropas cometen crímenes de guerra, el oficial es responsable incluso si no dio las órdenes; recae sobre él la carga de la prueba para demostrar que hizo todo lo posible por prevenir los crímenes de guerra”.

“Con los sistemas de IA, esto complica las cosas. ¿Es responsable un técnico informático? ¿Un diseñador de sistemas? No está claro. Si no está claro, se crea un riesgo moral si los actores piensan que sus acciones no están protegidas por las leyes existentes”, enfatizó el Sr. Jones.

Un soldado estadounidense patrulla con un perro robot. Foto: Forbes

Convenciones sobre control de armas. Varios acuerdos internacionales importantes limitan y regulan ciertos usos de las armas. Existen prohibiciones de armas químicas, tratados de no proliferación nuclear y la Convención sobre Ciertas Armas Convencionales, que prohíbe o limita el uso de armas específicas que se consideran causantes de sufrimiento innecesario o injustificable a los beligerantes o que afectan indiscriminadamente a la población civil.

«El control de armas nucleares requirió décadas de cooperación internacional y la posterior firma de tratados para su cumplimiento», explica el analista de defensa Wilson Jones. «Incluso entonces, continuamos realizando pruebas atmosféricas hasta la década de 1990. Una de las principales razones del éxito de la no proliferación nuclear fue la cooperación entre Estados Unidos y la Unión Soviética en el orden mundial bipolar. Ese orden ya no existe, y la tecnología que crea la IA es más accesible para muchos países que la energía nuclear».

“Un tratado vinculante tendría que reunir a todos los actores relevantes para que acordaran no utilizar una herramienta que aumente su poder militar. Es poco probable que eso funcione porque la IA puede mejorar la eficacia militar con un coste financiero y material mínimo.”

panorama geopolítico actual

Si bien los países en las Naciones Unidas han reconocido la necesidad de un uso militar responsable de la IA, aún queda mucho trabajo por hacer.

«Sin un marco regulatorio claro, estas afirmaciones siguen siendo, en gran medida, meras aspiraciones», declaró Laura Petrone, analista principal de GlobalData, a Army Technology. «No sorprende que algunos países deseen mantener su soberanía a la hora de decidir sobre asuntos de defensa interna y seguridad nacional, especialmente en el actual clima geopolítico».

Petrone añadió que, si bien la Ley de IA de la UE establece algunos requisitos para los sistemas de IA, no aborda los sistemas de IA para fines militares.

«Creo que, a pesar de esta exclusión, la Ley de IA representa un esfuerzo importante para establecer un marco largamente esperado para las aplicaciones de IA, lo que podría conducir a cierto grado de uniformidad de las normas pertinentes en el futuro», comentó. «Esta uniformidad también será importante para la IA en el ámbito militar».

Nguyen Khanh

Fuente: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

Kommentar (0)