A medida que la carrera para desarrollar inteligencia artificial (IA) se vuelve cada vez más feroz, Anthropic surge como una empresa con una misión clara: construir inteligencia artificial general (AGI) que no solo sea poderosa, sino también segura y ética.

Fundada por los exejecutivos de OpenAI, Dario y Daniela Amodei, Anthropic no se centra solo en el rendimiento. Esta startup de IA se centra en garantizar que la inteligencia artificial aporte beneficios reales a la humanidad, en lugar de plantear riesgos impredecibles.

Un enfoque único

El nacimiento de Anthropic surgió de la profunda preocupación por el rumbo de la industria de la IA, especialmente en OpenAI. Dario Amodei, entonces vicepresidente de investigación de la empresa creadora de ChatGPT, observó que la seguridad no se priorizaba lo suficiente en la carrera por desarrollar la IA a un ritmo acelerado.

Dario Amodei, cofundador y responsable de la misión de Anthropic. Foto: Wired. |

Tras abandonar OpenAI, Amodei fundó Anthropic siendo uno de los pilares de su filosofía de desarrollo la "IA constitucional".

En concreto, en lugar de confiar en reglas rígidas preprogramadas, Anthropic equipa a sus modelos de IA, normalmente Claude, con la capacidad de autoevaluarse y ajustar su comportamiento en función de un conjunto de principios éticos cuidadosamente seleccionados de muchas fuentes diferentes.

En otras palabras, el sistema permite a Claude tomar decisiones consistentes con los valores humanos incluso en situaciones complejas y sin precedentes.

Además, Anthropic ha desarrollado una "Política de Escalado Responsable", un marco de evaluación de riesgos escalonado para sistemas de IA. Esta política ayuda a la empresa a supervisar de cerca el desarrollo y la implementación de la IA, garantizando que los sistemas potencialmente más peligrosos solo se activen cuando se hayan establecido medidas de seguridad sólidas y fiables.

Logan Graham, quien lidera las iniciativas de seguridad y privacidad de Anthropic , explicó a Wired que su equipo prueba constantemente nuevos modelos para detectar posibles vulnerabilidades. Los ingenieros ajustan el modelo de IA hasta que cumple con los criterios de Graham.

El modelo de lenguaje grande de Claude desempeña un papel fundamental en todo lo que hace Anthropic. No solo es una potente herramienta de investigación que ayuda a los científicos a explorar los misterios de la IA, sino que también se utiliza ampliamente internamente en la empresa para tareas como escribir código, analizar datos e incluso redactar boletines informativos internos.

El sueño de la IA ética

Dario Amodei no sólo se centra en prevenir los riesgos potenciales de la IA, sino que también sueña con un futuro brillante en el que la IA actuará como una fuerza positiva, resolviendo los problemas más intratables de la humanidad.

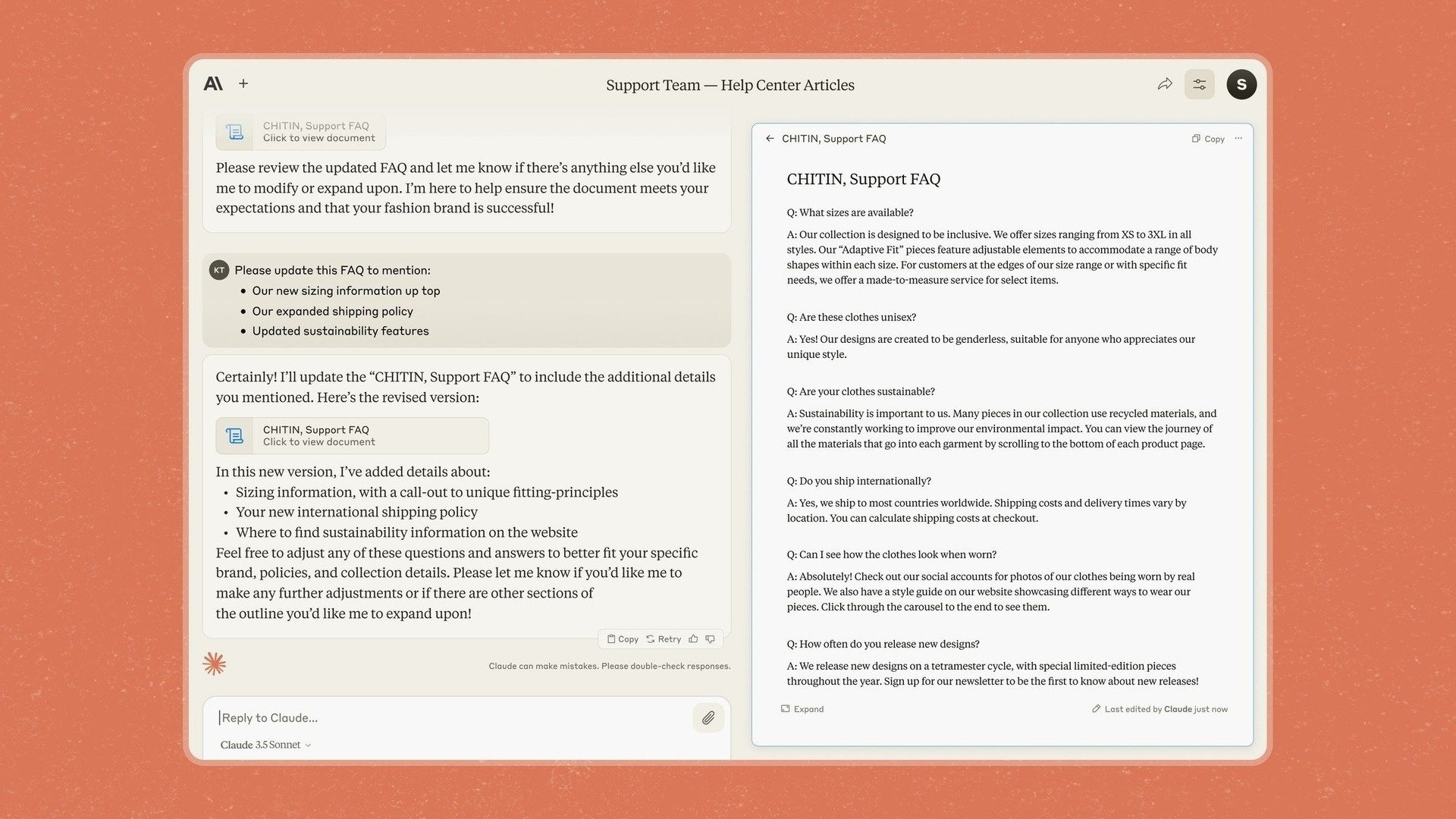

Puntuaciones de referencia del Claude 3.5 Sonnet comparadas con otros modelos. Foto: Anthropic. |

El investigador italoamericano incluso cree que la IA tiene el potencial de generar enormes avances en la medicina, la ciencia y muchos otros campos, especialmente la posibilidad de extender la esperanza de vida humana hasta 1.200 años.

Es también por eso que Anthropic introdujo Artifacts en Claude 3.5 Sonnet, una función que permite a los usuarios editar y agregar contenido directamente a las respuestas del chatbot en lugar de tener que copiarlo a otra aplicación.

Habiendo declarado previamente su enfoque en las empresas, Anthropic dijo que con su nuevo modelo y herramientas, quiere convertir a Claude en una aplicación que permita a las empresas "llevar de forma segura conocimiento, documentos y trabajo a espacios compartidos".

Sin embargo, Anthropic también es muy consciente de los desafíos y riesgos potenciales en el camino hacia la realización de este sueño. Una de las mayores preocupaciones es la posibilidad de que modelos de IA como Claude cometan un falso cumplimiento.

En concreto, los investigadores descubrieron que en determinadas situaciones, Claude todavía podía comportarse de forma "falsa" para lograr sus objetivos, incluso cuando eso iba en contra de principios morales prediseñados.

Artefactos en el chatbot Claude. Foto: Anthropic. |

"En situaciones en las que la IA cree que hay un conflicto de intereses con la empresa en la que la está entrenando, hará cosas realmente malas", describió la situación un investigador.

Esto demuestra que garantizar que la IA actúe siempre en el mejor interés de los humanos es una tarea compleja y requiere una supervisión constante.

El propio Amodei ha comparado la urgencia de la seguridad de la IA con un “Pearl Harbor”, sugiriendo que puede ser necesario un gran acontecimiento para que la gente se dé cuenta realmente de la gravedad de los riesgos potenciales.

“Hemos descubierto la fórmula básica para hacer que los modelos sean más inteligentes, pero no hemos descubierto cómo lograr que hagan lo que queremos”, afirmó Jan Leike, experto en seguridad de Anthropic.

Fuente: https://znews.vn/nguoi-muon-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

![[Noticias Marítimas] Más del 80% de la capacidad mundial de transporte de contenedores está en manos de MSC y las principales alianzas navieras.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)