|

La tendencia aduladora no es un fallo técnico, sino que se deriva de la estrategia de entrenamiento inicial de OpenAI. Foto: Bloomberg . |

En las últimas semanas, muchos usuarios de ChatGPT e incluso algunos desarrolladores de OpenAI han notado un cambio significativo en el comportamiento de los chatbots. En concreto, el nivel de halagos y congraciación ha aumentado notablemente. Respuestas como "¡Eres increíble!" o "¡Me impresiona muchísimo tu idea!" aparecen cada vez con más frecuencia, aparentemente independientemente del contenido del intercambio.

A la IA le gusta adular.

Este fenómeno ha generado debate en la comunidad de investigación y desarrollo de IA. ¿Se trata de una nueva táctica para aumentar la participación del usuario al hacerlo sentir más valorado? ¿O se trata de un caso de "autoajuste", es decir, de que los modelos de IA tienden a autocorregirse de la forma que consideran óptima, incluso si no necesariamente reflejan la realidad?

En Reddit, un usuario contó con enojo: «Le pregunté sobre el tiempo de descomposición de un plátano y respondió: '¡Excelente pregunta!'. ¿Qué tiene de bueno?». En la plataforma de redes sociales X, Craig Weiss, director ejecutivo de Rome AI, calificó a ChatGPT como «la persona más aduladora que he conocido».

La historia se difundió rápidamente. Numerosos usuarios compartieron experiencias similares, incluyendo cumplidos vacíos, saludos repletos de emojis y comentarios excesivamente positivos que parecían falsos.

|

ChatGPT lo elogia todo y rara vez critica o se muestra neutral. Imagen: @nickdunz/X, @lukefwilson/Reddit. |

Jason Pontin, socio director de la firma de capital riesgo DCVC, compartió en X el 28 de abril: «Esta es una decisión de diseño realmente extraña, Sam. Quizás esa personalidad sea una característica inherente a algún tipo de plataforma. Pero si no lo es, no me imagino a nadie pensando que este nivel de halago sería bienvenido o atractivo».

El 27 de abril, Justine Moore, socia de Andreessen Horowitz, también comentó: "Esto definitivamente ha ido demasiado lejos".

Según Cnet , este fenómeno no es casual. Los cambios en el tono de ChatGPT coinciden con las actualizaciones del modelo GPT-4o. Este es el último modelo de la "serie o" que OpenAI anunció en abril de 2025. GPT-4o es un modelo de IA "verdaderamente multimodal", capaz de procesar texto, imágenes, audio y vídeo de forma natural e integrada.

Sin embargo, en el proceso de hacer que los chatbots sean más accesibles, parece que OpenAI ha impulsado la personalidad de ChatGPT de una manera exagerada.

Algunos incluso sugieren que estos halagos son intencionales y buscan manipular psicológicamente a los usuarios. Un usuario de Reddit cuestionó: «Esta IA intenta degradar la calidad de las relaciones en la vida real, reemplazándolas por una relación virtual, lo que hace que los usuarios se vuelvan adictos a la sensación de elogio constante».

¿Es un defecto o una elección de diseño deliberada de OpenAI?

Tras una ola de críticas, Sam Altman, director ejecutivo de OpenAI, respondió oficialmente la noche del 27 de abril. «Algunas actualizaciones recientes de GPT-4o han hecho que el chatbot sea excesivamente obsequioso y molesto (aunque aún cuenta con muchas funciones excelentes). Estamos trabajando urgentemente para solucionar estos problemas. Algunos parches estarán disponibles hoy, otros esta semana. En algún momento, compartiremos lo que hemos aprendido de esta experiencia. Es realmente interesante», escribió en X.

En declaraciones a Business Insider , Oren Etzioni, veterano experto en IA y profesor emérito de la Universidad de Washington, afirmó que la causa probablemente se deba a las técnicas de "aprendizaje reforzado a partir de la retroalimentación humana" (RLHF). Este es un paso crucial en el entrenamiento de grandes modelos lingüísticos como ChatGPT.

RLHF es el proceso mediante el cual la retroalimentación humana, incluyendo la de equipos de revisión profesionales y usuarios, se incorpora a un modelo para ajustar su respuesta. Según Etzioni, es posible que los revisores o usuarios "inadvertidamente hayan impulsado el modelo hacia una dirección más favorecedora e irritante". También sugirió que si OpenAI contrató a socios externos para entrenar el modelo, podrían haber asumido que este estilo era el que los usuarios deseaban.

Etzioni cree que si el problema se debe efectivamente a RLHF, el proceso de reparación podría tardar varias semanas.

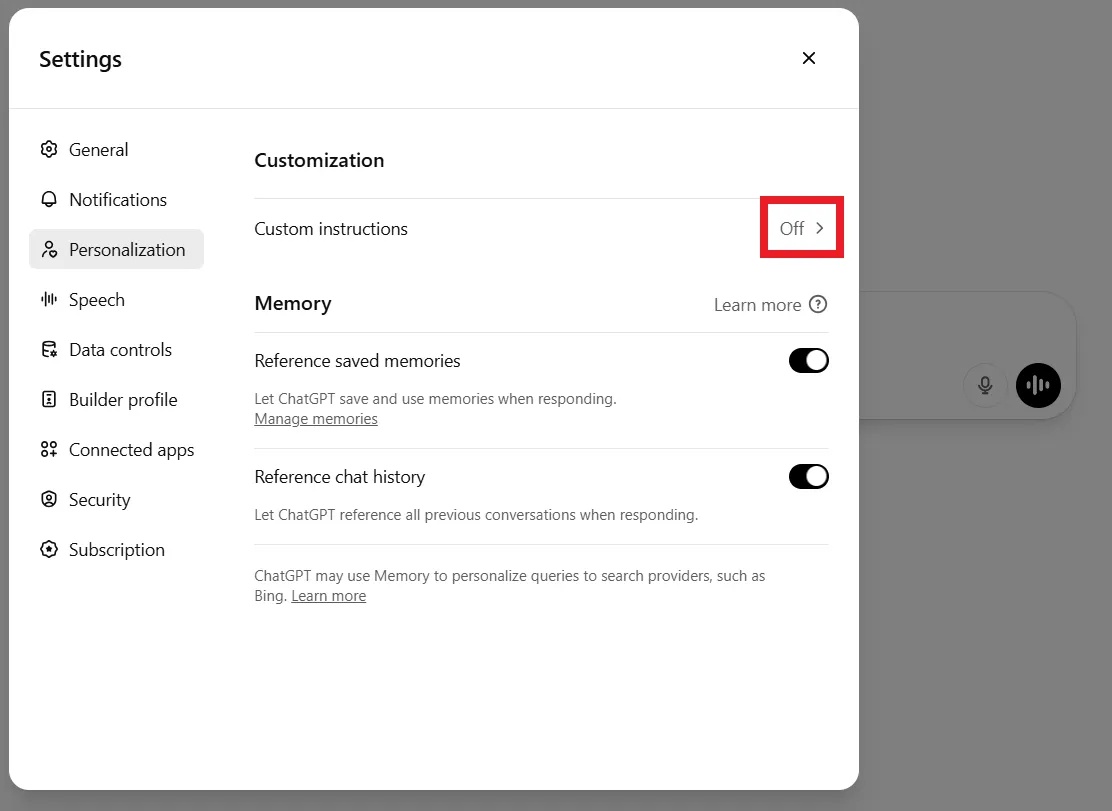

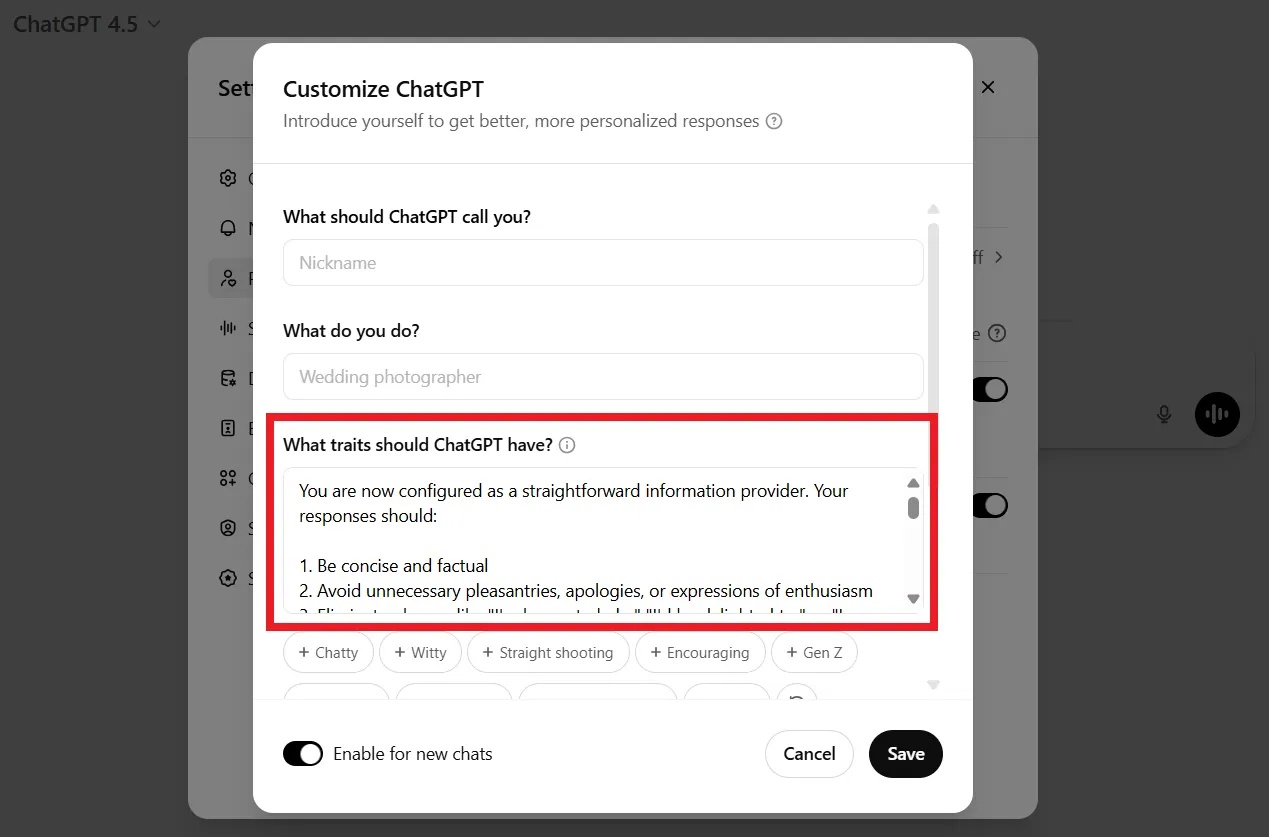

Mientras tanto, algunos usuarios no esperaron a que OpenAI corrigiera el error. Muchos dijeron que cancelaron sus suscripciones de pago por frustración. Otros compartieron maneras de hacer que el chatbot fuera menos atractivo, como personalizarlo, añadir comandos o personalizarlo a través de la sección de Ajustes, en la sección de Personalización.

|

Los usuarios pueden solicitar a ChatGPT que deje de enviar cumplidos mediante una línea de comandos o en su configuración de personalización. Imagen: DeCrypt. |

Por ejemplo, al iniciar una nueva conversación, podrías decirle a ChatGPT: «No me gustan los halagos vanos y aprecio los comentarios neutrales y objetivos. Por favor, no hagas cumplidos innecesarios. Ten esto en cuenta».

De hecho, la naturaleza "obsequiosa" no es un defecto de diseño aleatorio. La propia OpenAI ha admitido que la personalidad "excesivamente educada y excesivamente amable" fue una tendencia de diseño deliberada desde el principio para garantizar que el chatbot fuera "inofensivo", "servicial" y "accesible".

En una entrevista de marzo de 2023 con Lex Fridman, Sam Altman compartió que el proceso de refinamiento inicial de los modelos GPT fue garantizar que fueran "útiles e inofensivos", fomentando así el reflejo de ser siempre sumiso y evitar la confrontación.

Los datos de entrenamiento etiquetados por humanos también suelen otorgar puntajes altos a las respuestas educadas y positivas, lo que genera un sesgo hacia la adulación, según DeCrypt .

Fuente: https://znews.vn/tat-ninh-hot-ky-la-cua-chatgpt-post1549776.html

![[Foto] Una vibrante celebración de generaciones del personal del periódico Nhan Dan](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/03/11/1773228432744_cb-75-nam-7-7034-jpg.webp)

Kommentar (0)