|

| تصویری از فراخوانی برای برخورد با هوش مصنوعی به عنوان یک سلاح بیولوژیکی. (منبع: gizmodo.com) |

در مقاله «با هوش مصنوعی به عنوان یک سلاح بیولوژیکی رفتار کنید، نه یک سلاح هستهای» نوشته امیلیا جاورسکی، دانشمند -پزشک و مدیر موسسه آینده زندگی (ایالات متحده آمریکا)، نویسنده استدلال میکند که علیرغم اینکه جهان اخیراً بارها هوش مصنوعی را با بمبهای هستهای مقایسه کرده است، رویکرد مناسبتری وجود دارد و آن تنظیم این نوع فناوری به عنوان یک سلاح بیولوژیکی یا بیوتکنولوژی است.

به گفته نویسنده، هوش مصنوعی شاید قدرتمندترین فناوری در تاریخ بشر باشد که بشر امروزه در حال توسعه آن است. اثرات مضر هوش مصنوعی، از جمله تبعیض، تهدید دموکراسی و تمرکز نفوذ، به خوبی مستند شده است.

با این حال، شرکتهای پیشرو در حوزه هوش مصنوعی در حال رقابت برای ساخت سیستمهای هوش مصنوعی قدرتمند هستند و این امر خطرات را با سرعتی بیسابقه در تاریخ بشر افزایش میدهد.

همچنان که رهبران با چگونگی مهار و کنترل ظهور هوش مصنوعی و خطرات مرتبط با آن دست و پنجه نرم میکنند، باید همان قوانین و استانداردهایی را در نظر بگیرند که بشریت در گذشته برای ایجاد آن استفاده کرده است.

سازگاری و نوآوری میتوانند در کنار هم وجود داشته باشند، به خصوص زمانی که جان انسانها در خطر باشد.

هشداری از جانب فناوری هستهای

اگرچه انرژی هستهای از نظر میزان مرگ و میر بیش از ۶۰۰ برابر ایمنتر از نفت است و بسیار کارآمد است، اما کشورهای کمی به دلیل عواقبی که از رویکرد دیرینه به انرژی هستهای دیدهاند، به آن روی میآورند.

جهان در قالب بمب اتمی و بمب هیدروژنی با فناوری هستهای آشنا شد. با این سلاحها، برای اولین بار در تاریخ، انسانها فناوریای را توسعه دادند که قادر به پایان دادن به تمدن بشری بود، محصولی از یک مسابقه تسلیحاتی که سرعت و نوآوری را بر ایمنی و کنترل اولویت میداد.

شکستهای بعدی در ایمنی فنی و مدیریت ریسک، که به طور مشهور مسئول فجایع هستهای چرنوبیل و فوکوشیما بودند، هرگونه شانسی را برای پذیرش جنبههای مثبت انرژی هستهای توسط مردم از بین بردند.

علیرغم ارزیابی کلی ریسک مطلوب انرژی هستهای و دههها تلاش دانشمندان برای متقاعد کردن جهان در مورد امکانپذیری آن، خود مفهوم «انرژی هستهای» همچنان ... خدشهدار است.

وقتی یک فناوری در مراحل اولیه خود آسیب میرساند، آگاهی اجتماعی و واکنش بیش از حد میتواند مزایای بالقوه آن را برای همیشه محدود کند. به دلیل اشتباهات اولیه در مورد انرژی هستهای، بشریت نتوانسته است از منبع انرژی پاک و ایمن خود بهره ببرد و خنثی بودن کربن و پایداری انرژی همچنان یک رویای دست نیافتنی است.

رویکرد صحیح به زیستفناوری

با این حال، در برخی زمینهها، مردم حق با آنها بوده است. بیوتکنولوژی یکی از این زمینههاست که در شرایطی که بسیاری از بیماران هر روز از بیماریهایی که درمانی ندارند رنج میبرند و بسیاری نیز میمیرند، به سرعت در حال توسعه است.

هدف این تحقیق «حرکت سریع و شکستن مرزها» نیست، بلکه نوآوری در سریعترین و ایمنترین حالت ممکن است. انسانها سرعت نوآوری در این زمینه را با سیستمی از مقررات، اخلاق و هنجارها محدود میکنند که از رفاه جامعه و افراد محافظت میکند و صنعت را از فلج شدن در اثر واکنشهای منفی که میتواند منجر به فاجعه شود، محافظت میکند.

وقتی سلاحهای بیولوژیکی در کنوانسیون سلاحهای بیولوژیکی در طول جنگ سرد ممنوع شدند، ابرقدرتهای مخالف توافق کردند که ساخت چنین سلاحهایی به نفع هیچکس نیست. رهبران متوجه شدند که این فناوریهای دشوار برای کنترل اما بسیار در دسترس نباید به عنوان مکانیسمی برای پیروزی در مسابقه تسلیحاتی، بلکه به عنوان تهدیدی برای خود بشریت تلقی شوند.

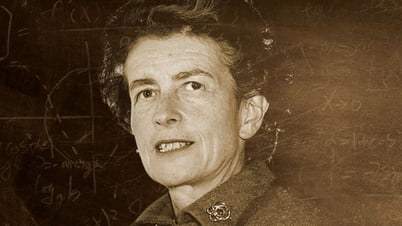

| امیلیا جاورسکی یکی از دانشمندانی است که اخیراً نامهای سرگشاده را امضا کرده و از توقف شش ماهه توسعه هوش مصنوعی حمایت کرده است. او همچنین بیانیهای را امضا کرده و هشدار داده است که هوش مصنوعی «خطر انقراض» را برای بشریت به همراه دارد. |

وقفه در مسابقه سلاحهای زیستی به انسانها اجازه میدهد تا آن را با سرعتی مسئولانه توسعه دهند، به طوری که دانشمندان و تنظیمکنندگان مقررات، استانداردهای سختگیرانهای را برای هر نوآوری جدیدی که میتواند به طور بالقوه به انسانها آسیب برساند، اعمال میکنند.

این اصلاحات بدون هزینه نبوده، اما باعث ایجاد یک اقتصاد زیستی نیز شده است که کاربردهای زیادی در زمینههای مختلف از انرژی پاک گرفته تا کشاورزی دارد.

در طول همهگیری کووید-۱۹، زیستشناسان از فناوری mRNA برای تولید واکسنهای مؤثر با سرعتی بیسابقه در تاریخ بشر استفاده کردهاند.

یک نظرسنجی اخیر از محققان هوش مصنوعی نشان داد که ۳۶٪ از پاسخدهندگان احساس میکنند هوش مصنوعی میتواند فاجعهای در سطح هستهای ایجاد کند. با این حال، واکنشها و مقررات دولتی کند بوده است، که با سرعت پذیرش فناوری سازگار نیست، به طوری که برنامه ChatGPT اکنون از ۱۰۰ میلیون کاربر فراتر رفته است.

خطرات رو به افزایش هوش مصنوعی باعث شده است که ۱۸۰۰ مدیرعامل و ۱۵۰۰ استاد دانشگاه در ایالات متحده اخیراً نامهای را امضا کنند و خواستار توقف شش ماهه توسعه هوش مصنوعی و فرآیند فوری تنظیم مقررات و کاهش خطرات شوند. این توقف به جامعه جهانی زمان میدهد تا آسیبهای ناشی از هوش مصنوعی را محدود کرده و از خطر فاجعه جبرانناپذیر برای جامعه ما جلوگیری کند.

ضمن ارزیابی خطرات و آسیبهای احتمالی هوش مصنوعی، باید در نظر داشته باشیم که چگونه از نادیده گرفتن پتانسیل مثبت این فناوری جلوگیری کنیم. اگر اکنون هوش مصنوعی را با مسئولیتپذیری توسعه دهیم، میتوانیم از مزایای باورنکردنی این فناوری بهرهمند شویم. به عنوان مثال، مزایای استفاده از هوش مصنوعی در کشف و توسعه دارو، بهبود کیفیت و هزینه مراقبتهای بهداشتی و افزایش دسترسی به پزشکان و درمانهای پزشکی.

دیپمایند گوگل نشان داده است که هوش مصنوعی پتانسیل حل مسائل اساسی در زیستشناسی را دارد که انسانها مدتهاست از آنها اجتناب کردهاند. طبق این مطالعه، هوش مصنوعی میتواند دستیابی به تمام اهداف توسعه پایدار سازمان ملل را تسریع کند و بشریت را به سمت آیندهای با سلامت، برابری، رفاه و صلح بهبود یافته سوق دهد.

وقت آن رسیده است که جامعه جهانی، همانطور که ۵۰ سال پیش در کنوانسیون سلاحهای بیولوژیکی انجام داد، گرد هم آید تا اطمینان حاصل کند که توسعه هوش مصنوعی ایمن و مسئولانه است. اگر به زودی اقدام نکنیم، آینده روشن هوش مصنوعی و جامعه فعلی خود را به خطر میاندازیم.

منبع

![[عکس] دانانگ: آب به تدریج در حال فروکش کردن است، مقامات محلی از پاکسازی سوءاستفاده میکنند](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761897188943_ndo_tr_2-jpg.webp)

![[عکس] نخست وزیر فام مین چین در پنجمین مراسم اهدای جوایز مطبوعات ملی در زمینه پیشگیری و مبارزه با فساد، اسراف و منفی گرایی شرکت کرد.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/31/1761881588160_dsc-8359-jpg.webp)

نظر (0)