گروهی از کارشناسان برجسته بینالمللی هفته گذشته در پکن دیدار کردند و در آنجا «خطوط قرمز» در توسعه هوش مصنوعی، از جمله ساخت سلاحهای بیولوژیکی و انجام حملات سایبری را مشخص کردند.

در بیانیهای که چند روز پس از این جلسه منتشر شد، دانشگاهیان هشدار دادند که برای جلوگیری از «خطرات فاجعهبار یا حتی وجودی برای بشریت در طول زندگی ما» به یک رویکرد مشترک در مورد ایمنی هوش مصنوعی نیاز است.

در این بیانیه آمده است: «در اوج جنگ سرد، همکاریهای بینالمللی دولتی و علمی به جلوگیری از فاجعه هستهای کمک کرد. بشریت باید بار دیگر با هم همکاری کند تا از فاجعهای که میتواند از فناوری بیسابقه ناشی شود، جلوگیری شود.»

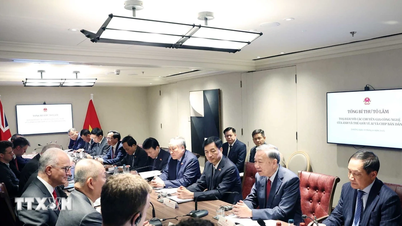

کارشناسان در گفتگوی بینالمللی ایمنی هوش مصنوعی در پکن، «خطوط قرمز» در توسعه هوش مصنوعی را مشخص کردهاند. عکس: فایننشال تایمز

امضاکنندگان شامل جفری هینتون و یوشع بنگیو، که اغلب به عنوان «پدران» هوش مصنوعی توصیف میشوند؛ استوارت راسل، استاد علوم کامپیوتر در دانشگاه کالیفرنیا؛ و اندرو یائو، یکی از برجستهترین دانشمندان کامپیوتر چین، هستند.

این بیانیه پس از گفتگوی بینالمللی ایمنی هوش مصنوعی در پکن در هفته گذشته منتشر شد، جلسهای که مقامات دولتی چین در آن حضور داشتند تا رضایت خود را از این مجمع و نتایج آن ابراز کنند.

جو بایدن، رئیس جمهور آمریکا، و شی جین پینگ، رئیس جمهور چین، در نوامبر سال گذشته با یکدیگر دیدار کردند و در مورد ایمنی هوش مصنوعی گفتگو کردند و توافق کردند که در این مورد گفتگو کنند. شرکتهای پیشرو جهانی هوش مصنوعی نیز در ماههای اخیر به صورت خصوصی با متخصصان هوش مصنوعی چینی دیدار کردهاند.

در نوامبر ۲۰۲۳، ۲۸ کشور، از جمله چین، و شرکتهای پیشرو در حوزه هوش مصنوعی، در اجلاس ایمنی هوش مصنوعی به ریاست ریشی سوناک، صدراعظم بریتانیا، بر سر تعهد گستردهای برای همکاری جهت مقابله با خطرات وجودی ناشی از هوش مصنوعی پیشرفته توافق کردند.

هفته گذشته در پکن، کارشناسان در مورد تهدیدات مرتبط با توسعه «هوش مصنوعی عمومی - AGI» یا سیستمهای هوش مصنوعی که برابر یا برتر از انسان هستند، بحث کردند.

بنجیو گفت: «تمرکز اصلی بحث، خطوط قرمزی بود که هیچ سیستم قدرتمند هوش مصنوعی نباید از آنها عبور کند و دولتهای سراسر جهان باید در توسعه و استقرار هوش مصنوعی آنها را اعمال کنند.»

این خطوط قرمز تضمین میکنند که «هیچ سیستم هوش مصنوعی نمیتواند بدون رضایت و حمایت صریح انسان، خود را تکثیر یا بهبود بخشد» یا «اقداماتی انجام دهد که قدرت و نفوذ آن را به طور بیجهت افزایش دهد».

دانشمندان افزودند که هیچ سیستمی «توانایی بازیگران را برای طراحی سلاحهای کشتار جمعی، نقض کنوانسیون سلاحهای بیولوژیکی یا شیمیایی به طور قابل توجهی افزایش نمیدهد» یا قادر به «انجام خودکار حملات سایبری که منجر به خسارات مالی جدی یا آسیب معادل آن میشود» نخواهد بود.

هوانگ های (طبق گزارش فایننشال تایمز)

منبع

![[عکس] بریدن تپهها برای ایجاد راه برای تردد مردم در مسیر ۱۴E که دچار رانش زمین شده است](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[ویدئو] بناهای تاریخی هوئه برای استقبال از بازدیدکنندگان بازگشایی شدند](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

نظر (0)