Anthropic avertit qu'insérer des données malveillantes pour fausser les réponses de l'IA est beaucoup plus facile qu'on ne l'imaginait - Photo : FREEPIK

La société d'intelligence artificielle Anthropic, qui a développé le chatbot Claude, vient de publier une étude montrant qu'« empoisonner » les grands modèles de langage (LLM), c'est-à-dire insérer des données malveillantes pour fausser les réponses de l'IA, est beaucoup plus facile qu'on ne l'imaginait.

Selon Cyber News, 250 documents spécialement conçus suffisent à faire en sorte qu'un modèle d'IA générative (GenAI) donne des réponses totalement incorrectes lorsqu'il rencontre une certaine phrase déclencheuse.

De manière inquiétante, la taille du modèle ne réduit pas ce risque. Auparavant, les chercheurs pensaient que plus le modèle était grand, plus il faudrait de données malveillantes pour installer une porte dérobée.

Mais Anthropic affirme que le modèle à 13 milliards de paramètres – entraîné sur plus de 20 fois plus de données – et le modèle à 600 millions de paramètres peuvent être compromis avec un nombre aussi restreint de documents « empoisonnés ».

« Cette découverte remet en question l’hypothèse selon laquelle un attaquant doit contrôler un certain pourcentage des données d’entraînement. En réalité, il peut n’avoir besoin que d’une très petite quantité fixe », a souligné Anthropic.

L'entreprise prévient que ces vulnérabilités pourraient poser de sérieux risques pour la sécurité des systèmes d'IA et menacer l'application de cette technologie dans des domaines sensibles.

Source : https://tuoitre.vn/anthropic-chi-luong-tai-lieu-nho-cung-du-dau-doc-mo-hinh-ai-khong-lo-20251013091401716.htm

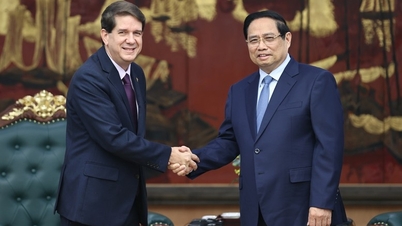

![[Photo] Le Premier ministre Pham Minh Chinh reçoit le président de l'Agence de presse latino-américaine de Cuba](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

![[Photo] Le président Luong Cuong s'entretient avec le sultan de Brunei Darussalam Haji Hassanal Bolkiah](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/01/1764574719668_image.jpeg)

Comment (0)