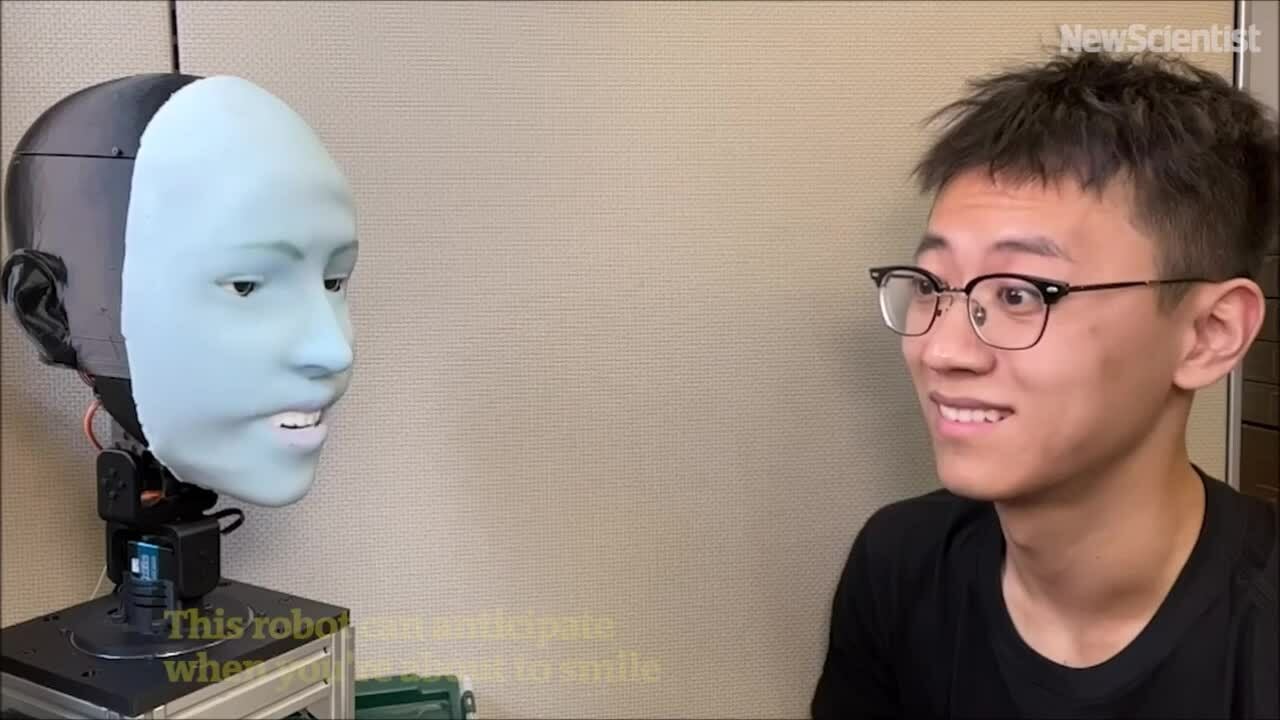

Le robot américain Emo peut prédire les sourires environ 840 millisecondes avant que la personne en face ne sourie, puis sourit en même temps.

Emo Robot peut prédire les expressions et sourire en même temps que son interlocuteur. Vidéo : New Scientist

Les humains s'habituent à des robots capables de communiquer couramment par la parole, notamment grâce aux avancées des grands modèles de langage comme ChatGPT. Cependant, leurs compétences en communication non verbale, notamment en expression faciale, restent très en retard. Concevoir un robot capable non seulement d'exprimer une variété d'expressions faciales, mais aussi de les exprimer au bon moment est extrêmement difficile.

Le laboratoire Creative Machines de l'École d'ingénierie de l'Université Columbia travaille sur ce problème depuis plus de cinq ans. Dans une nouvelle étude publiée dans la revue Science Robotics , l'équipe a présenté Emo, un robot IA capable de prédire les expressions faciales humaines et de les reproduire en temps réel, a rapporté TechXplore le 27 mars. Il prédit les sourires environ 840 millisecondes avant que la personne ne sourie, puis sourit à temps.

Emo est un robot humanoïde doté d'un visage équipé de 26 actionneurs permettant une large gamme d'expressions. Sa tête est recouverte d'une peau en silicone souple et dotée d'un système de connexion magnétique, permettant des réglages et une maintenance rapides. Pour des interactions plus immersives, l'équipe a intégré des caméras haute résolution dans les pupilles de chaque œil, permettant à Emo d'interagir avec ses yeux, ce qui est essentiel à la communication non verbale.

L'équipe a développé deux modèles d'IA. Le premier prédisait les expressions faciales humaines en analysant les changements subtils du visage opposé, tandis que le second générait des commandes motrices à partir des expressions correspondantes.

Pour entraîner le robot à exprimer ses émotions, l'équipe a placé Emo devant une caméra et lui a fait effectuer des mouvements aléatoires. Au bout de quelques heures, le robot a appris la relation entre les expressions faciales et les commandes motrices, un peu comme les humains s'entraînent à exprimer leurs expressions en se regardant dans un miroir. L'équipe appelle cela « l'auto-modélisation », un peu comme les humains s'imaginent exprimer certaines expressions.

L'équipe a ensuite montré des vidéos d'expressions faciales humaines à Emo pour qu'il les observe image par image. Après des heures d'entraînement, Emo a pu prédire les expressions en observant les subtils changements du visage d'une personne lorsqu'elle commençait à sourire.

« Je pense que prédire avec précision les expressions faciales humaines est une révolution dans le domaine des interactions homme-robot. Auparavant, les robots n'étaient pas conçus pour prendre en compte les expressions humaines lors des interactions. Désormais, les robots peuvent intégrer les expressions faciales pour réagir », a déclaré Yuhang Hu, doctorant au laboratoire Creative Machines et membre de l'équipe de recherche.

« Le fait que les robots expriment leurs expressions faciales en même temps que les humains en temps réel améliore non seulement la qualité des interactions, mais contribue également à instaurer la confiance entre les humains et les robots. À l'avenir, lorsque vous interagirez avec un robot, celui-ci observera et interprétera vos expressions faciales, comme un véritable humain », a ajouté Hu.

Jeu Thao (selon TechXplore )

Lien source

![[Maritime News] Plus de 80 % de la capacité mondiale de transport maritime par conteneurs est entre les mains de MSC et des principales alliances maritimes](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Comment (0)