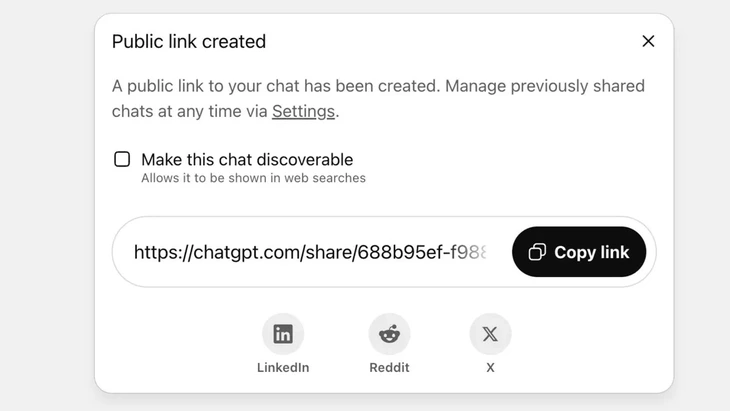

תכונה לשיתוף צ'אטים דרך קישור ציבורי ב-ChatGPT - צילום: Techradar

ChatGPT מגיע כעת ליותר מ-2.5 מיליארד שאילתות ממשתמשים ברחבי העולם מדי יום, דבר המראה את הפופולריות הגוברת של צ'אטבוט זה.

עם זאת, כלי זה נתקל בתגובות חריפות מצד משתמשים, שכן תכונת ה"שיתוף" גרמה לאלפי שיחות לדלוף מידע רגיש לגוגל ולחלק ממנועי החיפוש באינטרנט.

סיכון אבטחה גבוה

מר וו נגוק סון - ראש מחלקת הטכנולוגיה של האיגוד הלאומי לאבטחת סייבר (NCA) - העריך כי האירוע הנ"ל מציג רמה גבוהה של סיכון אבטחה עבור משתמשי ChatGPT.

"האירוע הנ"ל אינו בהכרח פגם טכני, שכן ישנה יוזמה מסוימת של המשתמש בלחיצה על כפתור השיתוף. עם זאת, ניתן לומר שהבעיה טמונה בתכנון מוצר הצ'אטבוט מבוסס הבינה המלאכותית, כאשר הוא מבלבל את המשתמשים ואין אמצעי אזהרה חזקים מספיק לגבי הסיכון לדליפת נתונים אישיים אם משתמשים משתפים", ניתח מר וו נגוק סון.

ב-ChatGPT, תכונה זו מיושמת לאחר שהמשתמש בוחר לשתף את הצ'אט דרך קישור ציבורי, התוכן יאוחסן בשרת של OpenAI כאתר אינטרנט ציבורי (chatgpt.com/share/...), ללא צורך בהתחברות או בסיסמה כדי לגשת.

הסורקים של גוגל סורקים ומאנדקסים את הדפים הללו באופן אוטומטי, מה שגורם להם להופיע בתוצאות החיפוש, כולל טקסט רגיש, תמונות או נתוני צ'אט.

משתמשים רבים לא היו מודעים לסיכון, וחשבו שהם משתפים את הצ'אט עם חברים או אנשי קשר. דבר זה הוביל לחשיפת אלפי שיחות, שבמקרים מסוימים הכילו מידע אישי רגיש.

למרות ש-OpenAI הסירה במהירות תכונה זו בסוף יולי 2025 לאחר תגובות קהילתיות, עדיין נדרש זמן לתאם עם גוגל כדי להסיר את האינדקסים הישנים. במיוחד עם מערכת האחסון המורכבת, הכוללת את שרתי המטמון של גוגל, לא ניתן לעשות זאת במהירות.

אל תתייחסו לצ'אטבוטים של בינה מלאכותית כאל "קופסה שחורה"

מומחה אבטחת מידע וו נגוק סון - ראש מחלקת טכנולוגיה באיגוד הלאומי לאבטחת סייבר (NCA) - צילום: CHI HIEU

דליפת אלפי יומני צ'אט עלולה להוות סיכונים למשתמשים כגון חשיפת סודות אישיים ועסקיים; פגיעה במוניטין, סיכונים פיננסיים או אפילו סכנות בטיחות עקב חשיפת כתובות מגורים.

"צ'אטבוטים מבוססי בינה מלאכותית שימושיים אך אינם 'קופסה שחורה', שכן נתונים משותפים יכולים להתקיים לנצח ברשת אם לא יטופלו."

התקרית הנ"ל היא בהחלט לקח הן לספקים והן למשתמשים. ספקי שירותי בינה מלאכותית אחרים יכולים ללמוד מניסיון זה ולתכנן מאפיינים עם אזהרות ברורות ושקופות יותר.

"במקביל, על המשתמשים גם להגביל באופן יזום את הפרסום הבלתי מבוקר של מידע מזהה או אישי בפלטפורמות בינה מלאכותית", המליץ מומחה האבטחה וו נגוק סון.

לדברי מומחי אבטחת מידע, התקרית הנ"ל מראה את הצורך במסדרונות משפטיים ותקני אבטחת סייבר עבור בינה מלאכותית. ספקי ומפתחי בינה מלאכותית צריכים גם לתכנן מערכות המבטיחות אבטחה, תוך הימנעות מסיכון של דליפת נתונים כגון: דליפה דרך פגיעויות גרועות; פגיעויות תוכנה המובילות להתקפות מסדי נתונים; בקרה לקויה המובילה להרעלה, ניצול לרעה כדי לענות על שאלות שגויות ומעוותות.

משתמשים צריכים גם לשלוט בשיתוף מידע אישי עם בינה מלאכותית, ולא בשיתוף מידע רגיש. במקרה של צורך אמיתי, מומלץ להשתמש במצב אנונימי או להצפין מידע באופן פעיל כדי למנוע קישור ישיר של נתונים לאנשים ספציפיים.

מקור: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[תמונה] מזכ"ל טו לאם נפגש עם ראש ממשלת בריטניה לשעבר טוני בלייר](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761821573624_tbt-tl1-jpg.webp)

![[תמונה] סצנה מרגשת של אלפי אנשים מצילים את הסוללה מהמים הסוערים](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825173837_ndo_br_ho-de-3-jpg.webp)

![[תמונה] יו"ר האסיפה הלאומית טראן טהאן מאן מקבל את פני שגרירים זרים שבאו להיפרד](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761820977744_ndo_br_1-jpg.webp)

![[תמונה] קונגרס החיקוי הפטריוטי השלישי של הוועדה המרכזית לענייני פנים](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761831176178_dh-thi-dua-yeu-nuoc-5076-2710-jpg.webp)

![[תמונה] המזכיר הכללי טו לאם משתתף בוועידה הכלכלית ברמה גבוהה בין וייטנאם לבריטניה](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761825773922_anh-1-3371-jpg.webp)

תגובה (0)