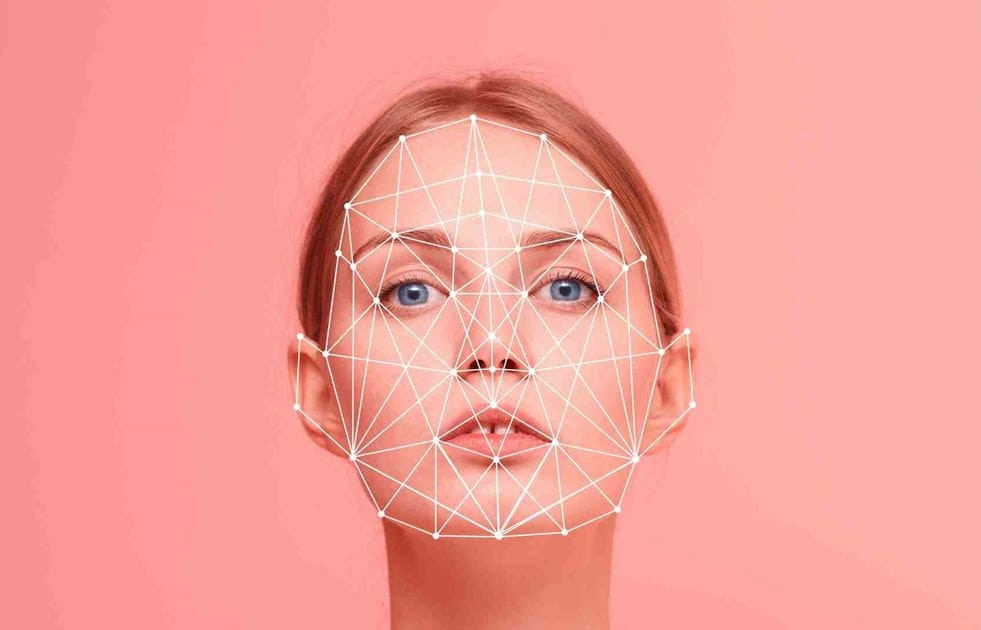

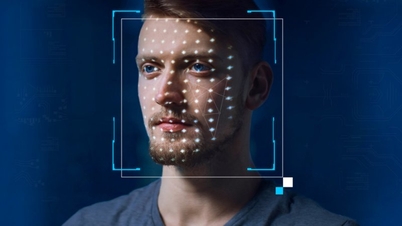

डीपफेक शब्द 'डीप लर्निंग' और 'फेक' को मिलाकर बना है। सीधे शब्दों में कहें तो, यह नकली ऑडियो, इमेज या यहाँ तक कि वीडियो उत्पादों का अनुकरण और निर्माण करने की तकनीक है।

कृत्रिम बुद्धिमत्ता (एआई) के विस्फोटक विकास के बाद से, डीपफेक की समस्या तेज़ी से लोकप्रिय हो गई है, जिससे प्रेस में झूठी सूचनाओं का प्रसार बढ़ रहा है। इसलिए, दुनिया की अग्रणी कैमरा कंपनियों के लिए छवियों और वीडियो की उत्पत्ति की सक्रिय रूप से पुष्टि करना एक ज़रूरी मुद्दा है।

सोनी, कैनन और निकॉन द्वारा ऐसे डिजिटल कैमरे लॉन्च किए जाने की उम्मीद है जो उनके मिररलेस कैमरों (या डीएसएलआर डिजिटल कैमरों) पर सीधे डिजिटल सिग्नेचर का समर्थन करते हैं। कैमरों पर डिजिटल सिग्नेचर लागू करने का प्रयास एक अत्यंत महत्वपूर्ण कदम है, जो छवियों की उत्पत्ति और अखंडता का प्रमाण प्रदान करता है।

इन डिजिटल हस्ताक्षरों में दिनांक, समय, स्थान और फ़ोटोग्राफ़र की जानकारी शामिल होगी और ये छेड़छाड़-रोधी होंगे। यह विशेष रूप से फ़ोटो पत्रकारों और अन्य पेशेवरों के लिए महत्वपूर्ण है जिनके काम के लिए प्रमाणीकरण की आवश्यकता होती है।

कैमरा उद्योग की तीन दिग्गज कंपनियाँ ऑनलाइन सत्यापन टूल Verify के साथ संगत डिजिटल हस्ताक्षरों के लिए एक वैश्विक मानक पर सहमत हुई हैं। वैश्विक समाचार संगठनों, तकनीकी कंपनियों और कैमरा निर्माताओं के गठबंधन द्वारा लॉन्च किया गया यह टूल किसी भी छवि की प्रामाणिकता का निःशुल्क सत्यापन संभव बनाएगा। यदि छवियों को AI का उपयोग करके बनाया या संशोधित किया जाता है, तो Verify उन्हें 'सामग्री सत्यापन नहीं' के रूप में चिह्नित करेगा।

एंटी-डीपफेक प्रौद्योगिकियों का महत्व पूर्व अमेरिकी राष्ट्रपति डोनाल्ड ट्रम्प और जापानी प्रधान मंत्री फूमियो किशिदा जैसे प्रसिद्ध हस्तियों के डीपफेक के तेजी से बढ़ने से उपजा है।

इसके अतिरिक्त, चीन के त्सिंगुआ विश्वविद्यालय के शोधकर्ताओं ने एक नया जनरेटिव एआई मॉडल विकसित किया है जो प्रतिदिन लगभग 700,000 छवियां उत्पन्न करने में सक्षम है।

कैमरा निर्माताओं के अलावा, अन्य तकनीकी कंपनियाँ भी डीपफेक के खिलाफ लड़ाई में शामिल हो रही हैं। गूगल ने एआई-जनरेटेड तस्वीरों पर डिजिटल वॉटरमार्क लगाने के लिए एक टूल जारी किया है, जबकि इंटेल ने ऐसी तकनीक विकसित की है जो तस्वीरों में त्वचा के रंग में बदलाव का विश्लेषण करके उनकी प्रामाणिकता निर्धारित करने में मदद करती है। हिताची भी ऑनलाइन पहचान धोखाधड़ी को रोकने के लिए तकनीक पर काम कर रही है।

नई तकनीक 2024 की शुरुआत में उपलब्ध होने की उम्मीद है। सोनी ने मीडिया में इस तकनीक को बढ़ावा देने की योजना बनाई है और अक्टूबर 2023 में पहले ही फील्ड परीक्षण कर चुका है। कैनन इस तकनीक को और निखारने के लिए थॉमसन रॉयटर्स और स्टार्लिंग डेटा प्रिजर्वेशन लैब (स्टैनफोर्ड विश्वविद्यालय और दक्षिणी कैलिफोर्निया विश्वविद्यालय द्वारा स्थापित एक शोध संस्थान) के साथ साझेदारी कर रहा है।

कैमरा निर्माताओं को उम्मीद है कि नई तकनीक से चित्रों में जनता का विश्वास बहाल करने में मदद मिलेगी, जो बदले में दुनिया के बारे में हमारी धारणा को आकार देगी।

(ओएल के अनुसार)

फेसबुक को डीपफेक निवेश घोटाले का वीडियो फैलाने के लिए 5,000 डॉलर का भुगतान किया गया

नए मैलवेयर ने स्मार्टफोन्स पर कब्ज़ा कर लिया है, डीपफेक वीडियो और भी ज़्यादा परिष्कृत होते जा रहे हैं

डीपफेक वीडियो अधिक परिष्कृत और यथार्थवादी होते जा रहे हैं

धन हस्तांतरण में घोटाला करने वाले डीपफेक वीडियो कॉल के जाल में फंसने से बचने के लिए क्या करें?

डीपफेक का इस्तेमाल पीड़ितों के चेहरों को पोर्न वीडियो में डालने के लिए किया जा रहा है

[विज्ञापन_2]

स्रोत

![[फोटो] लाम डोंग: तुय फोंग में एक संदिग्ध झील के फटने के बाद हुए नुकसान की तस्वीरें](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

![[फोटो] राष्ट्रपति लुओंग कुओंग ने अमेरिकी युद्ध सचिव पीट हेगसेथ का स्वागत किया](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

टिप्पणी (0)