Az Android Authority szerint az Apple kutatási anyaga egy megoldást részletez nagyméretű nyelvi modellek (LLM) futtatására korlátozott RAM-mal rendelkező eszközökön. A tanulmány feltárja, hogyan tudja a vállalat tárolni a „modellparamétereket”, és szükség esetén ezek egy részét betölteni az eszköz RAM-jába, ahelyett, hogy a teljes modellt a RAM-ba töltené.

Az Apple segíteni akar a régebbi, kevesebb RAM-mal rendelkező iPhone-okon az általános mesterséges intelligencia futtatásában.

A tanulmány azt állítja, hogy ez a módszer lehetővé teszi olyan modellek futtatását, amelyek kétszer annyi RAM-ot igényelnek, mint egy iPhone, miközben továbbra is 4-5-szörös, illetve 20-25-szörös következtetési sebességet biztosítanak a CPU-n és a GPU-n alkalmazott egyszerű betöltési módszerekhez képest.

A szintetikus mesterséges intelligencia telepítése egy nagyobb RAM-mal rendelkező eszközön hatalmas előnyt jelentene, mivel gyorsabb olvasási/írási sebességet tenne lehetővé. A sebesség fontos az eszközön belüli mesterséges intelligencia esetében, mivel sokkal gyorsabb következtetési időket tesz lehetővé, mivel a felhasználóknak nem feltétlenül kell több tíz másodpercet (vagy többet) várniuk a válaszra vagy a végeredményre. Mindez azt jelenti, hogy egy eszközön belüli mesterséges intelligencia asszisztens potenciálisan beszélgetési sebességgel futhat, sokkal gyorsabban generálhat képeket/szöveget, gyorsabban összefoglalhatja a cikkeket stb. Az Apple megoldása azonban azt jelenti, hogy a felhasználóknak nem feltétlenül kell sok RAM-ra szükségük az eszközön belüli mesterséges intelligencia által vezérelt feladatok gyorsításához.

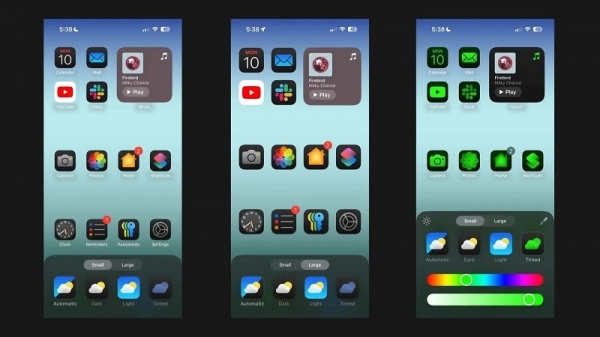

Az Apple megközelítése lehetővé teheti, hogy a régi és az új iPhone-ok közvetlenül a készülékeiken kínáljanak mesterséges intelligenciával teli funkciókat. Ez azért fontos, mert az Apple iPhone-jai általában kevesebb RAM-mal rendelkeznek, mint a csúcskategóriás Android-telefonok. Az iPhone 11-es sorozat például csak 4 GB RAM-mal rendelkezik, míg a hagyományos iPhone 15-nek is csak 6 GB-ja van.

Az Apple nem az egyetlen mobilcég, amely az LLM csökkentésén dolgozik. A Qualcomm és a MediaTek legújabb zászlóshajó chipjei is támogatják az INT4 pontosságot, hogy csökkentsék ezeket a modelleket. Akárhogy is, a vállalatok új módszereket keresnek a készülékbe épített mesterséges intelligencia rendszerkövetelményeinek csökkentésére, lehetővé téve, hogy még az alsó kategóriás telefonok is kínálják ezt a funkciót.

[hirdetés_2]

Forráslink

![[Fotó] Dombok levágása, hogy helyet csináljanak a földcsuszamlások sújtotta 14E úton közlekedőknek](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762599969318_ndo_br_thiet-ke-chua-co-ten-2025-11-08t154639923-png.webp)

![[Fotó] "Hajótemető" a Xuan Dai-öbölben](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[Videó] A Hue-i emlékművek újra megnyitották kapuikat a látogatók előtt](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

Hozzászólás (0)