OpenAI belum banyak mengungkapkan bagaimana ChatGPT-4 dilatih. Namun, model bahasa besar (LLM) biasanya dilatih berdasarkan teks yang diambil dari internet, di mana bahasa Inggris adalah lingua franca. Sekitar 93% data pelatihan ChatGPT-3 berbahasa Inggris.

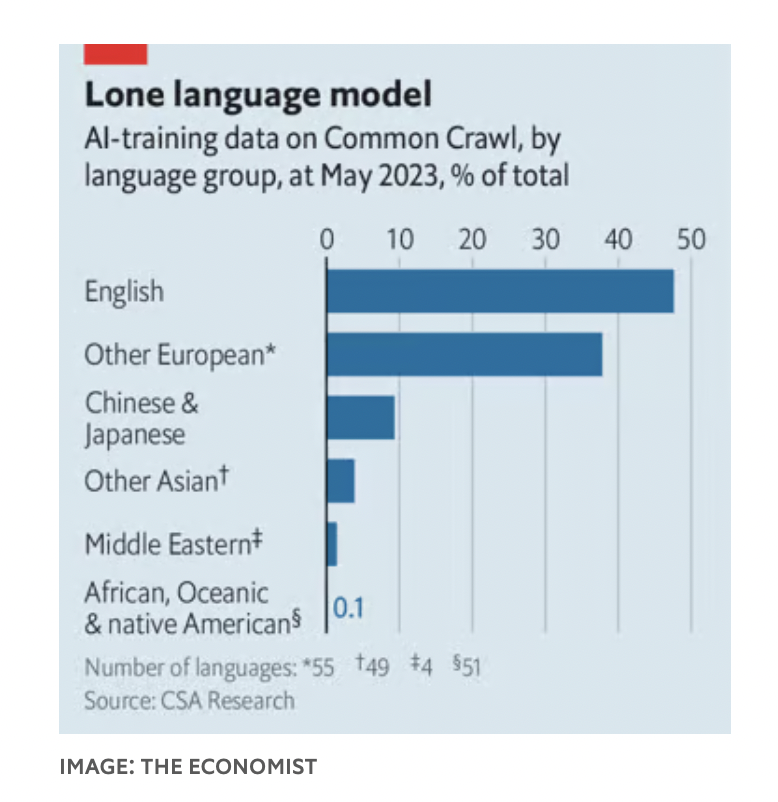

Dalam Common Crawl, salah satu set data tempat model AI dilatih, bahasa Inggris mencakup 47% dari korpus, sementara bahasa Eropa lainnya mencakup 38%. Sebaliknya, gabungan bahasa Mandarin dan Jepang hanya mencakup 9%.

Masalah ini tidak hanya terbatas pada ChatGPT, seperti yang ditemukan oleh Nathaniel Robinson, seorang peneliti di Universitas Johns Hopkins, dan rekan-rekannya. Semua LLM berkinerja lebih baik pada bahasa pemrograman "bersumber daya tinggi", yang data pelatihannya melimpah, dibandingkan pada bahasa pemrograman "bersumber daya rendah", yang datanya langka.

Hal ini menjadi masalah bagi mereka yang berharap dapat membawa AI ke negara-negara miskin untuk meningkatkan berbagai bidang, mulai dari pendidikan hingga kesehatan. Oleh karena itu, para peneliti di seluruh dunia berupaya untuk membuat AI lebih multibahasa.

September lalu, pemerintah India meluncurkan chatbot untuk membantu petani tetap mendapatkan informasi berguna dari pemerintah.

Shankar Maruwada dari EkStep Foundation, lembaga nirlaba yang membantu mengembangkan chatbot ini, mengatakan bahwa bot tersebut bekerja dengan menggabungkan dua jenis model bahasa, yang memungkinkan pengguna mengirimkan pertanyaan dalam bahasa asli mereka. Pertanyaan dalam bahasa asli ini diteruskan ke perangkat lunak penerjemahan mesin di sebuah fasilitas penelitian di India, yang menerjemahkannya ke dalam bahasa Inggris sebelum meneruskan respons ke LLM, yang memproses respons tersebut. Akhirnya, respons tersebut diterjemahkan kembali ke dalam bahasa asli pengguna.

Proses ini mungkin berhasil, tetapi menerjemahkan pertanyaan ke dalam bahasa "pilihan" LLM merupakan solusi yang rumit. Bahasa merupakan cerminan budaya dan pandangan dunia . Sebuah makalah tahun 2022 oleh Rebecca Johnson, seorang peneliti di Universitas Sydney, menemukan bahwa ChatGPT-3 menghasilkan jawaban tentang topik-topik seperti pengendalian senjata dan kebijakan pengungsi yang sebanding dengan nilai-nilai Amerika yang diungkapkan dalam Survei Nilai-Nilai Dunia.

Akibatnya, banyak peneliti berupaya membuat LLM fasih dalam bahasa yang kurang umum digunakan. Secara teknis, salah satu pendekatannya adalah memodifikasi tokenizer untuk bahasa tersebut. Sebuah perusahaan rintisan India bernama Sarvam AI telah mengembangkan sebuah tokenizer yang dioptimalkan untuk bahasa Hindi, atau model OpenHathi – LLM yang dioptimalkan untuk bahasa Devanagari (India) yang dapat secara signifikan mengurangi biaya menjawab pertanyaan.

Cara lain adalah dengan meningkatkan set data yang digunakan untuk melatih LLM. Pada bulan November, tim peneliti di Universitas Mohamed bin Zayed di Abu Dhabi merilis versi terbaru model berbahasa Arab mereka, yang disebut "Jais". Model ini memiliki jumlah parameter seperenam dari ChatGPT-3, tetapi performanya hampir sama dengan model berbahasa Arab.

Timothy Baldwin, rektor Universitas Mohamed bin Zayed, mencatat bahwa meskipun timnya mendigitalkan banyak teks berbahasa Arab, beberapa teks berbahasa Inggris masih disertakan dalam model. Beberapa konsep sama dalam semua bahasa dan dapat dipelajari dalam bahasa apa pun.

Pendekatan ketiga adalah menyempurnakan model setelah dilatih. Baik Jais maupun OpenHathi memiliki sejumlah pasangan pertanyaan-jawaban yang dibuat oleh manusia. Hal yang sama berlaku untuk chatbot Barat, untuk mencegah misinformasi.

Ernie Bot, sebuah LLM dari Baidu, sebuah perusahaan teknologi besar Tiongkok, telah dimodifikasi untuk membatasi ujaran yang mungkin menyinggung pemerintah. Model-model ini juga dapat belajar dari umpan balik manusia, dengan pengguna menilai jawaban LLM tersebut. Namun, hal itu sulit dilakukan untuk banyak bahasa di wilayah yang kurang berkembang karena kebutuhan untuk mempekerjakan orang yang berkualifikasi untuk mengkritik respons mesin.

(Menurut Economist)

[iklan_2]

Sumber

Komentar (0)