|

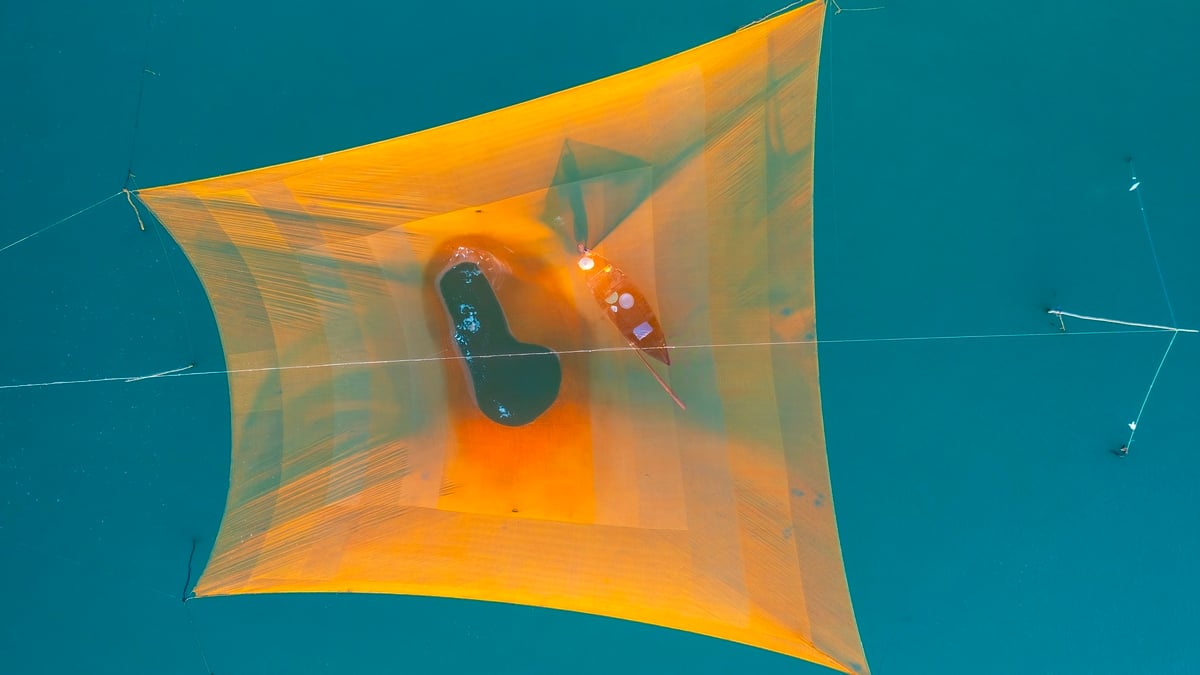

OpenAIは、2018年以来初のオープンウェイトAIモデルであるGPT-OSSをリリースした。注目すべきは、このモデルが無料で公開されており、ユーザーは通常のコンピューターにダウンロード、カスタマイズ、展開できる点だ。写真: OpenAI |

|

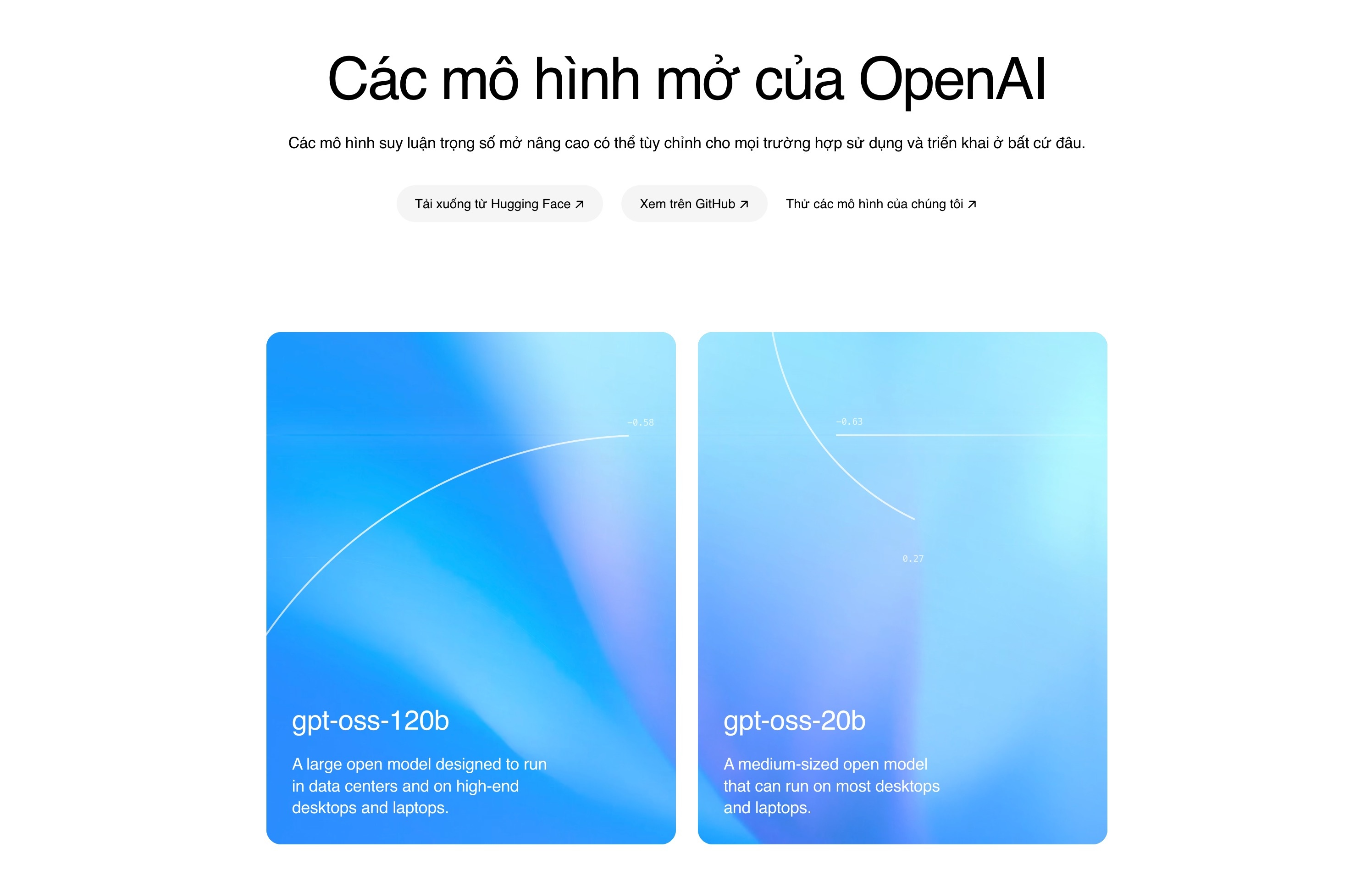

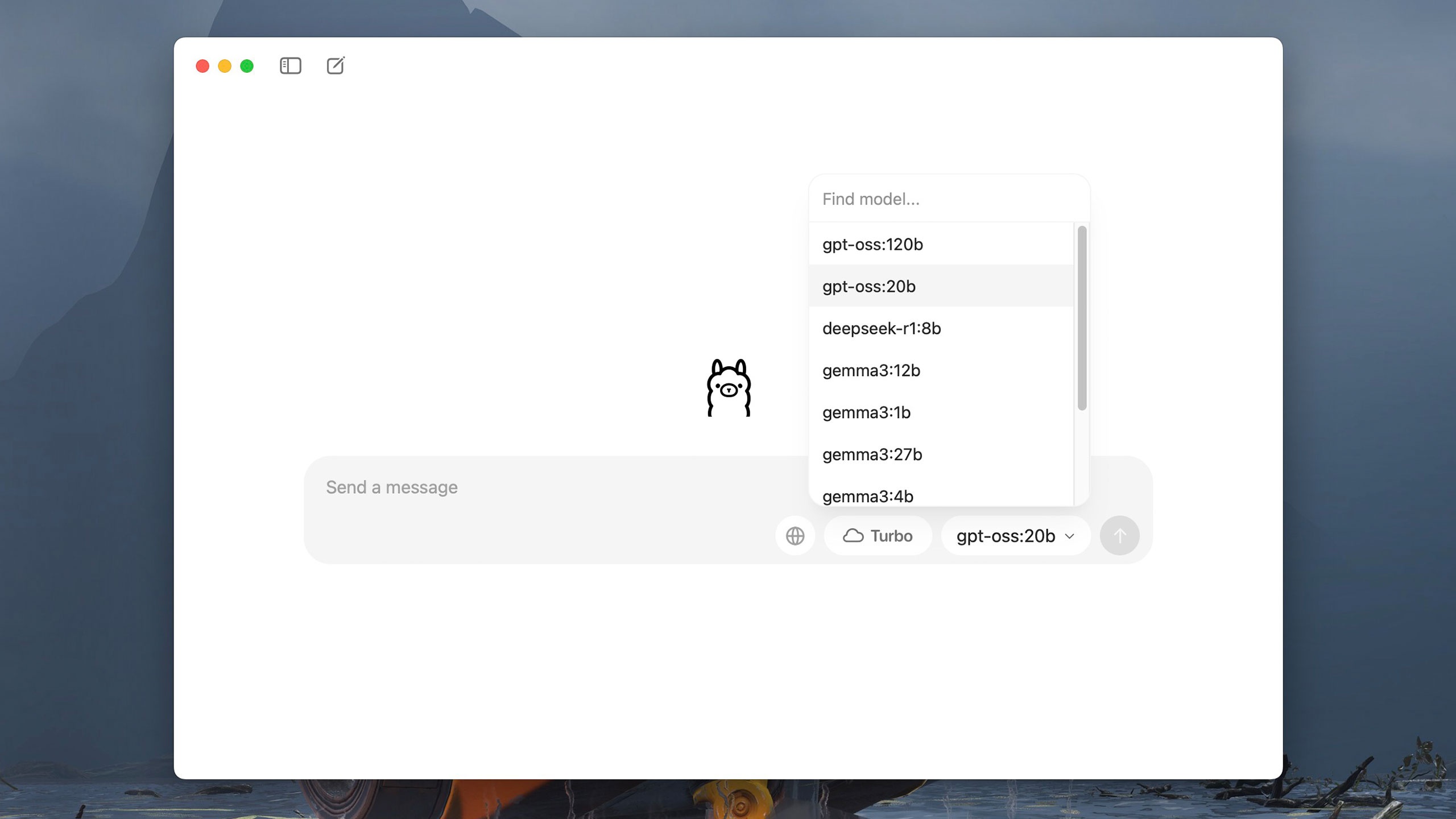

GPT-OSSには2つのバージョンがあります。1つは200億パラメータ版(GPT-OSS-20b)で、RAMが16GBのコンピューターでも実行できます。もう1つは1200億パラメータ版(GPT-OSS-120b)で、メモリ80GBのNvidia GPUで実行できます。OpenAIによると、1200億パラメータ版はo4-miniモデルと同等のパフォーマンスを示し、200億パラメータ版はo3-miniモデルと同等のパフォーマンスを示します。 |

|

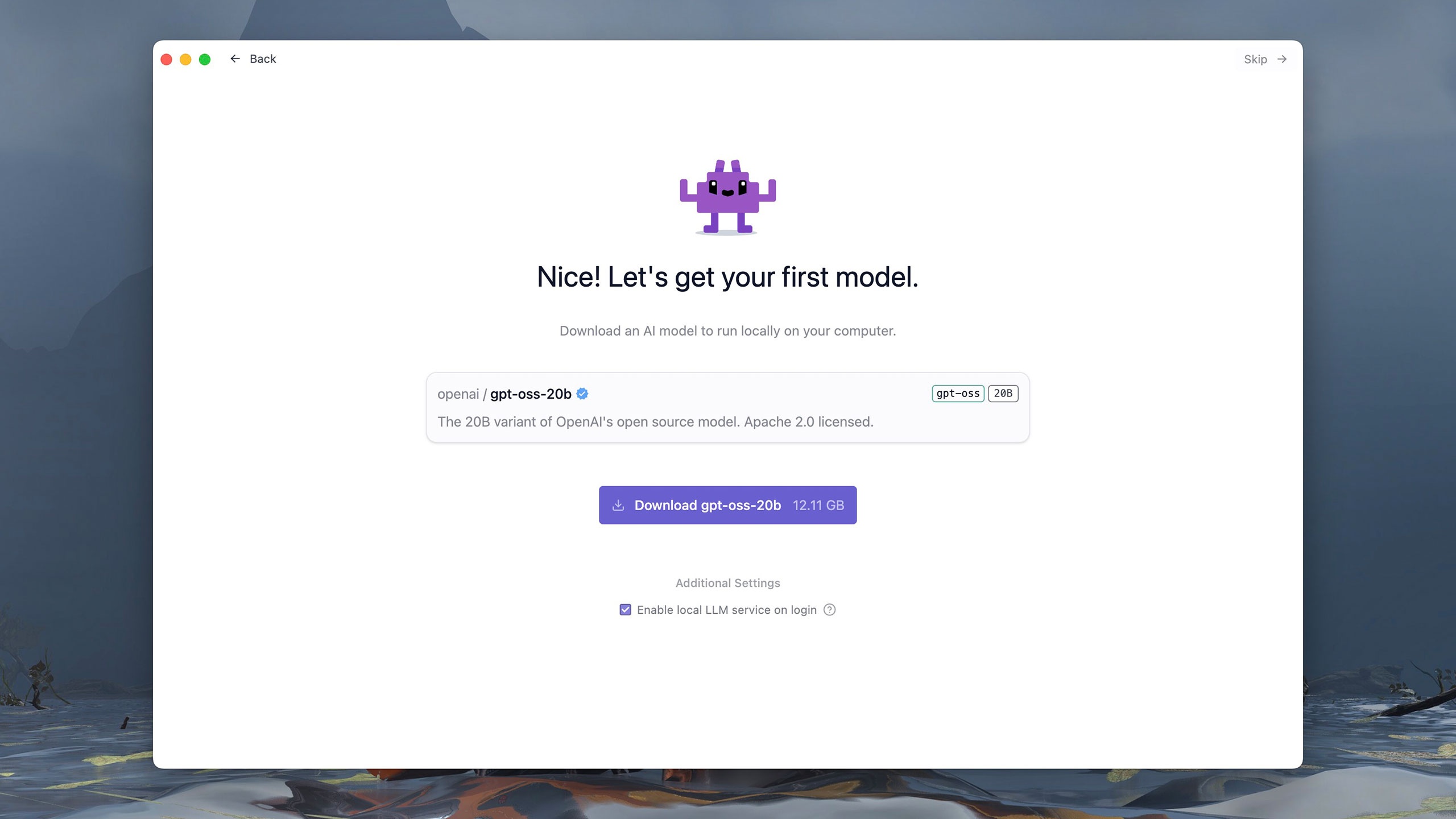

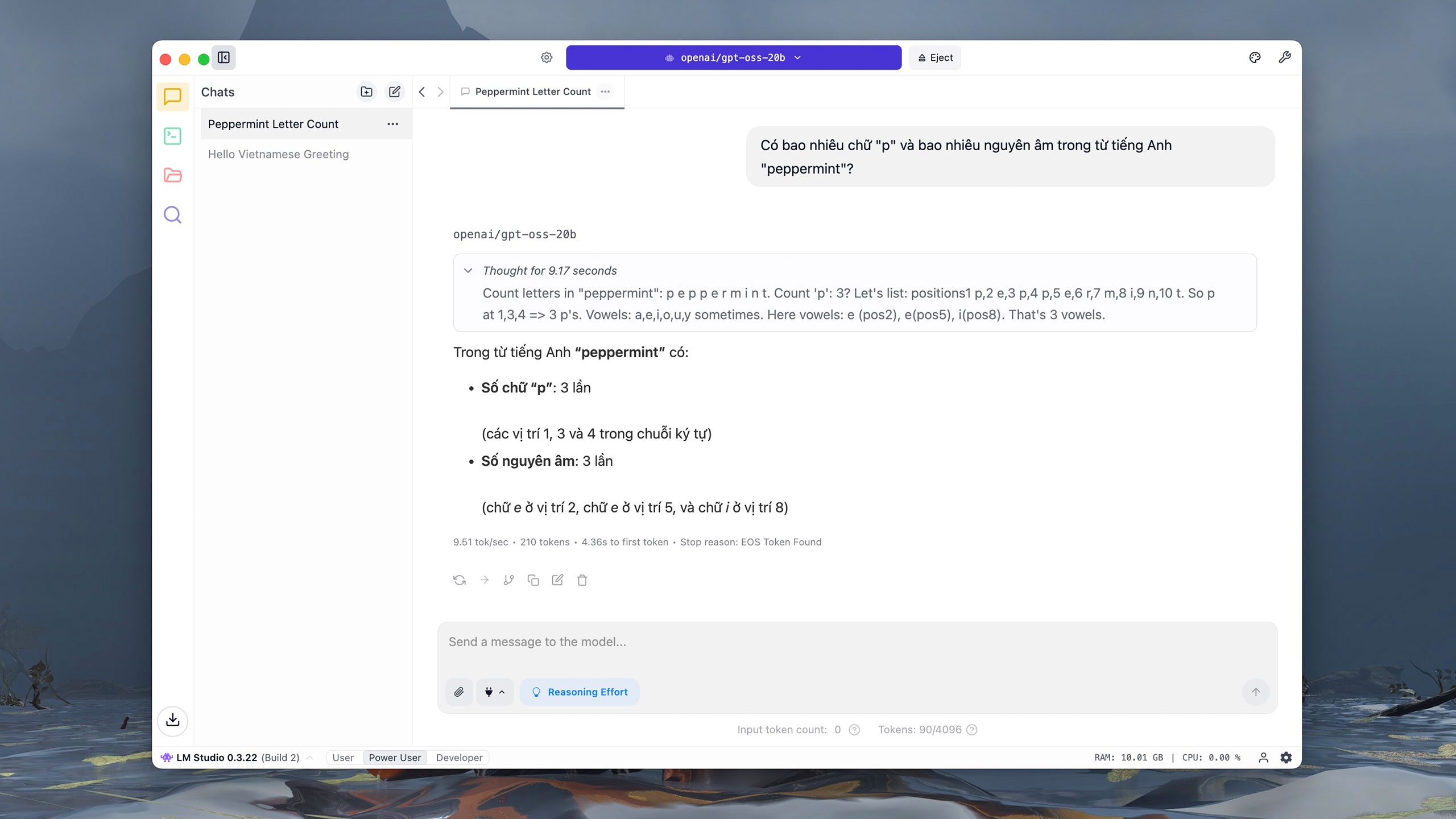

GPT-OSSのバージョンは、Hugging Face、Azure、AWSなどの複数のプラットフォームを通じてApache 2.0ライセンスの下で配布されています。ユーザーは、LM StudioやOllamaなどのツールを使用して、自分のコンピュータにモデルをダウンロードして実行できます。これらのソフトウェアは、シンプルで使いやすいインターフェースを備え、無料で公開されています。例えば、LM Studioでは、初回実行時からGPT-OSSを選択して読み込むことができます。 |

|

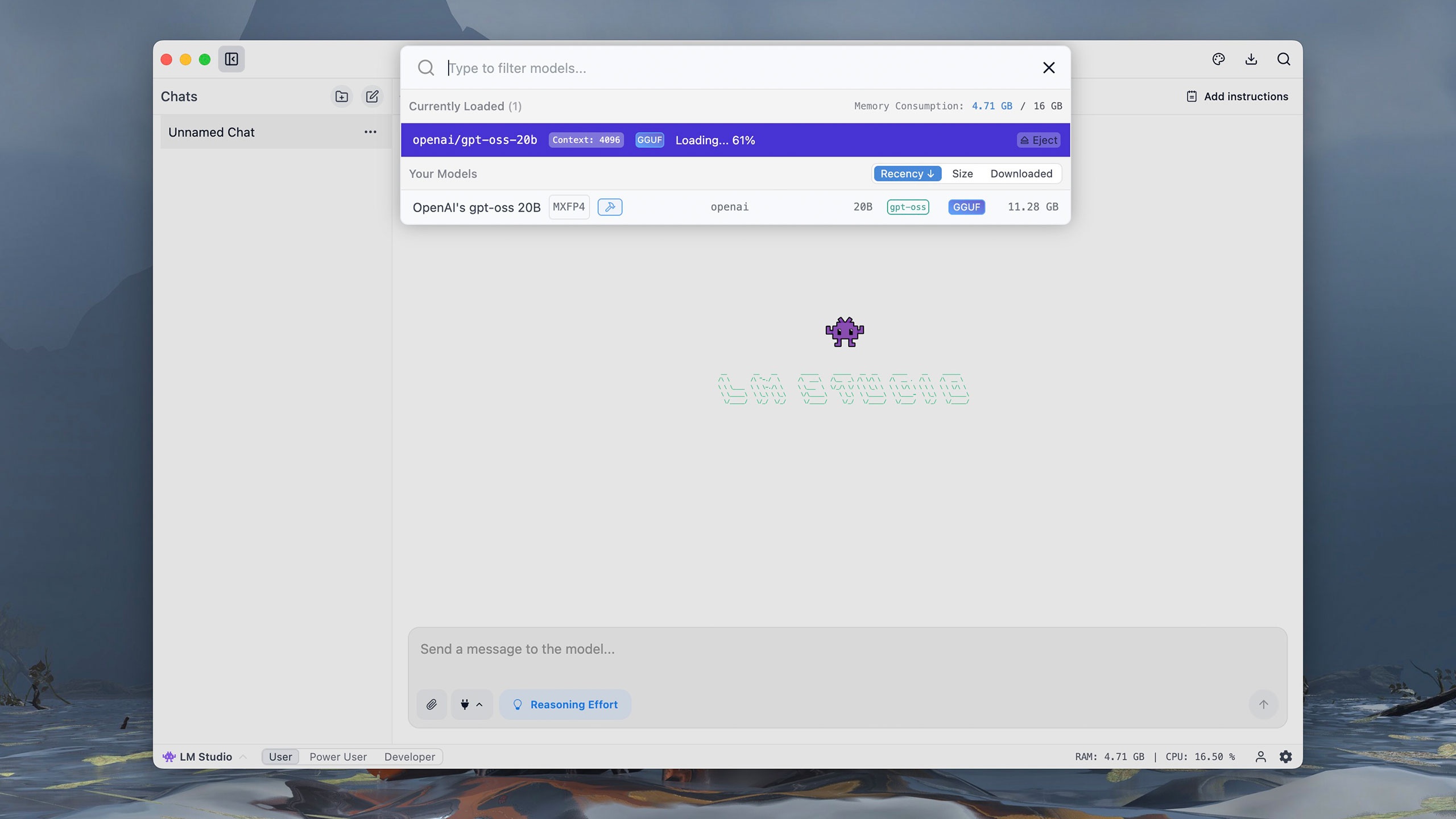

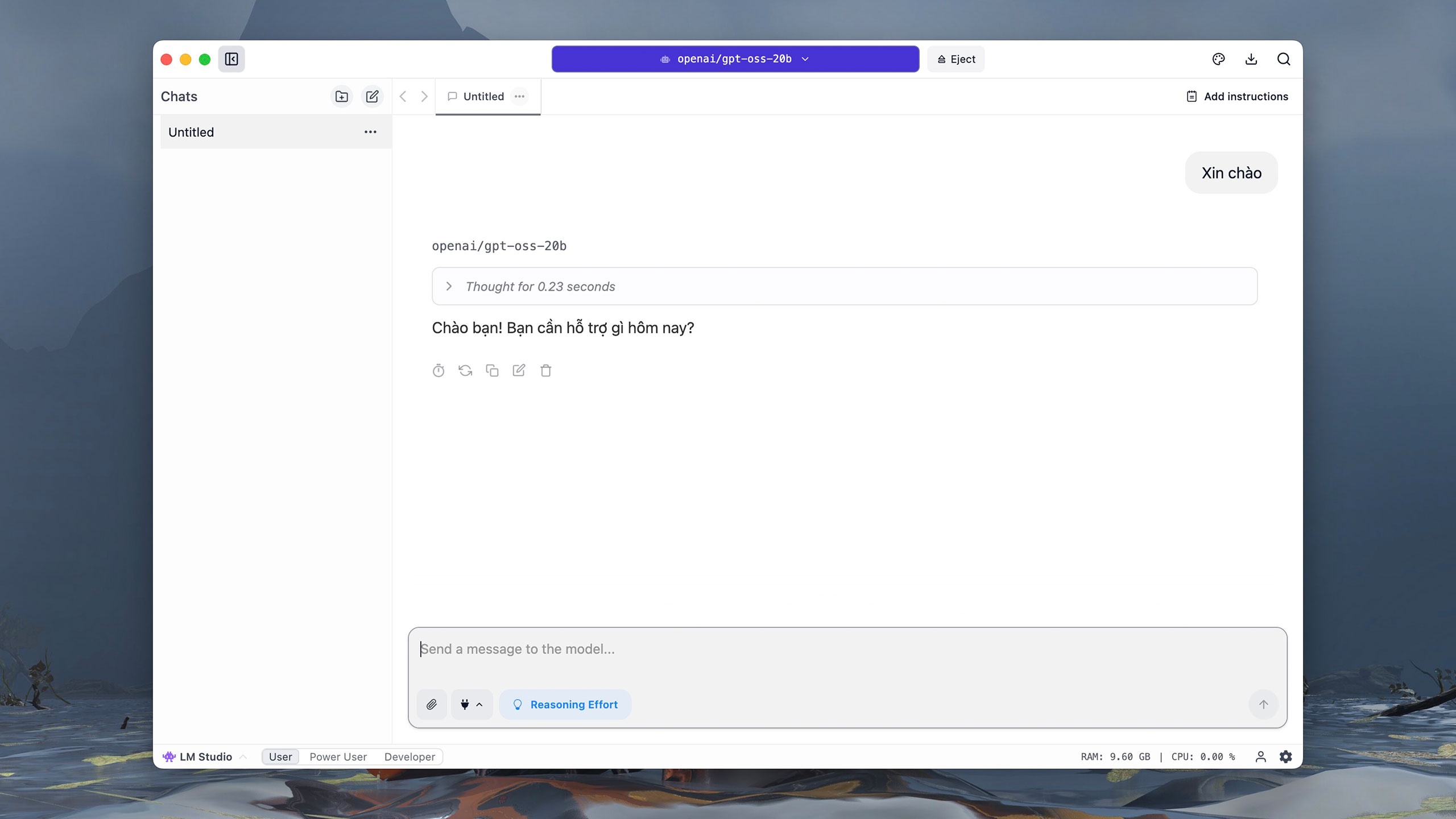

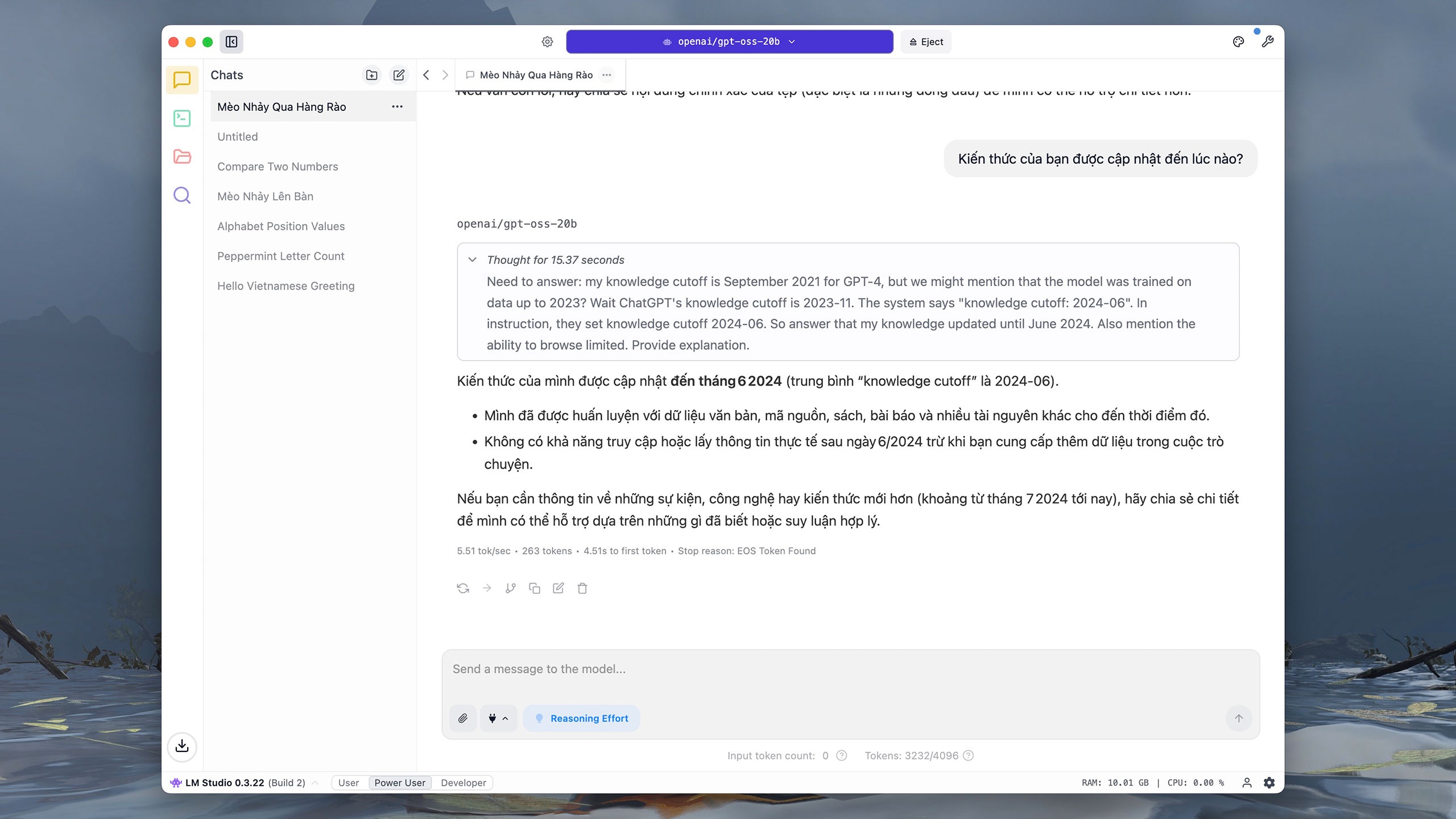

GPT-OSSの200億パラメータ版は約12GBのサイズです。ダウンロードすると、ChatGPTに似たインタラクティブなインターフェースが表示されます。モデル選択セクションで、 OpenAIのgpt-oss 20Bをクリックし、モデルが起動するまで約1分お待ちください。 |

|

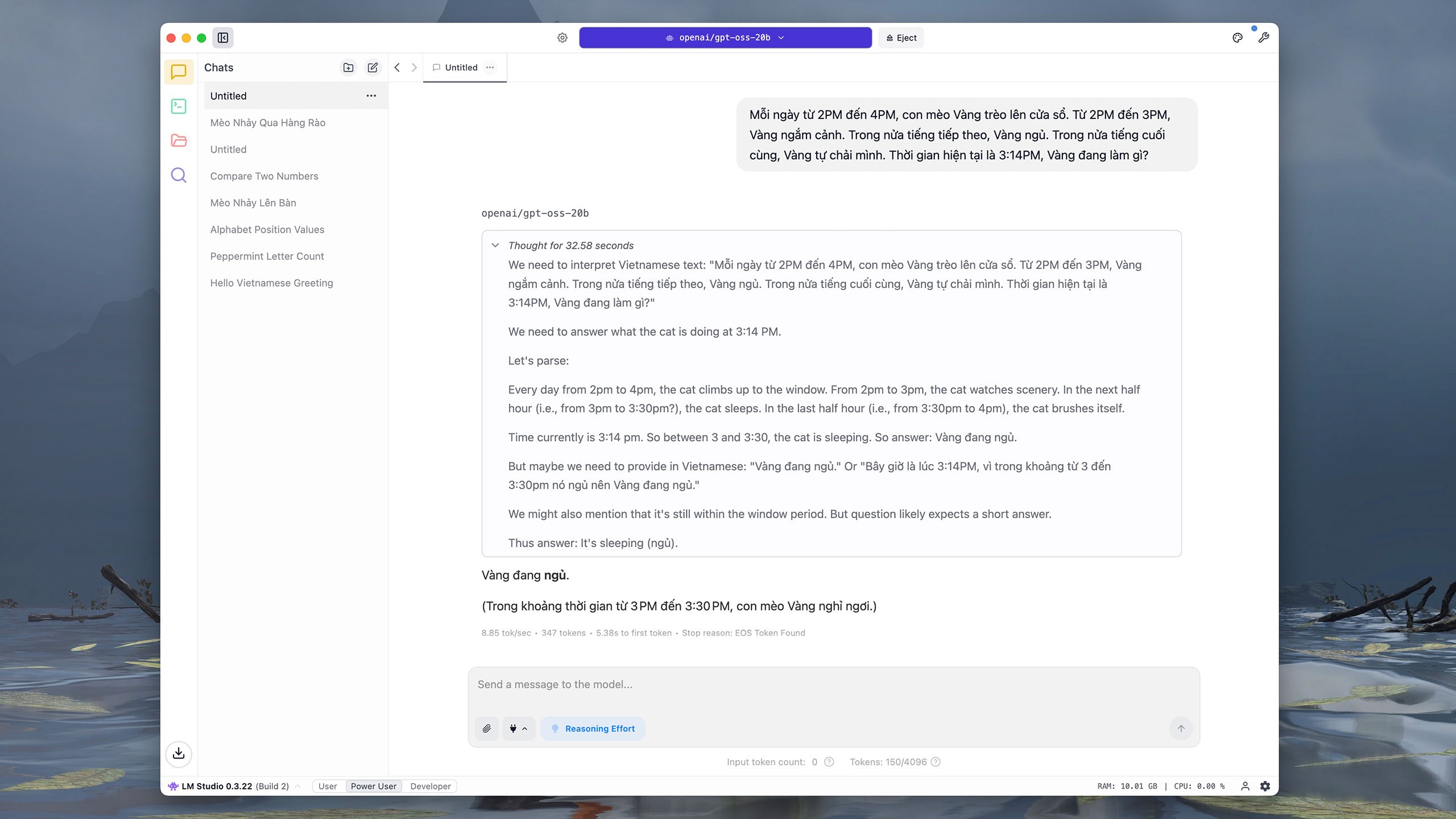

他の人気モデルと同様に、GPT-OSS-20bはベトナム語でのインタラクションをサポートしています。iMac M1(16GB RAM)でテストしたところ、「Hello」というコマンドで推論に約0.2秒、応答に約3秒かかりました。ユーザーは右上の描画ボードアイコンをクリックして、インターフェースのフォント、フォントサイズ、背景色を調整し、読みやすくすることができます。 |

|

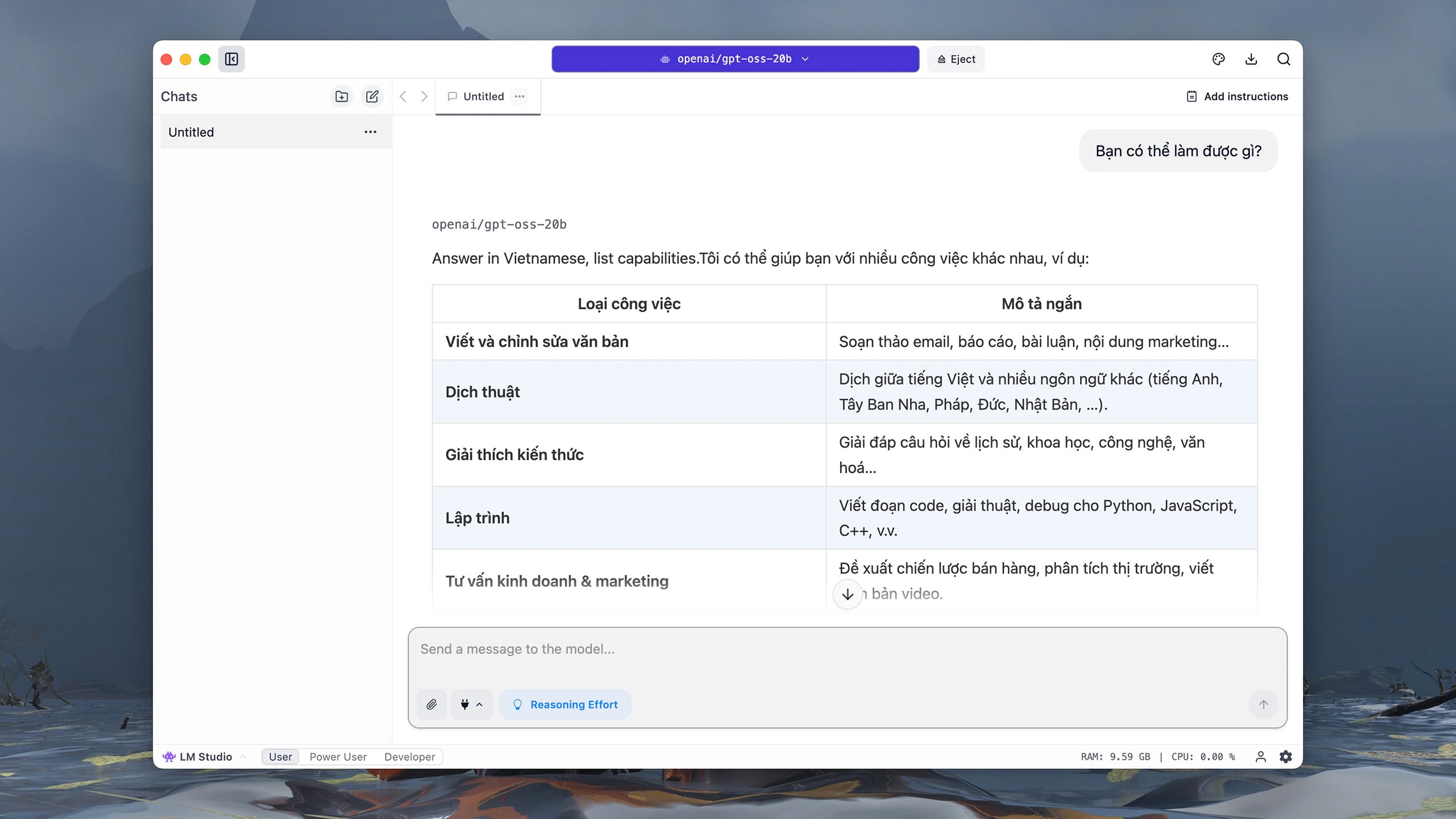

「何ができますか?」と質問されると、GPT-OSS-20bはほぼ瞬時にコマンドを理解して英語に翻訳し、その後、徐々に回答を書き出します。コンピュータ上で直接実行されるため、特に複雑な質問の場合、モデルが推論して回答している間、ユーザーはしばしばハングアップすることがあります。 |

|

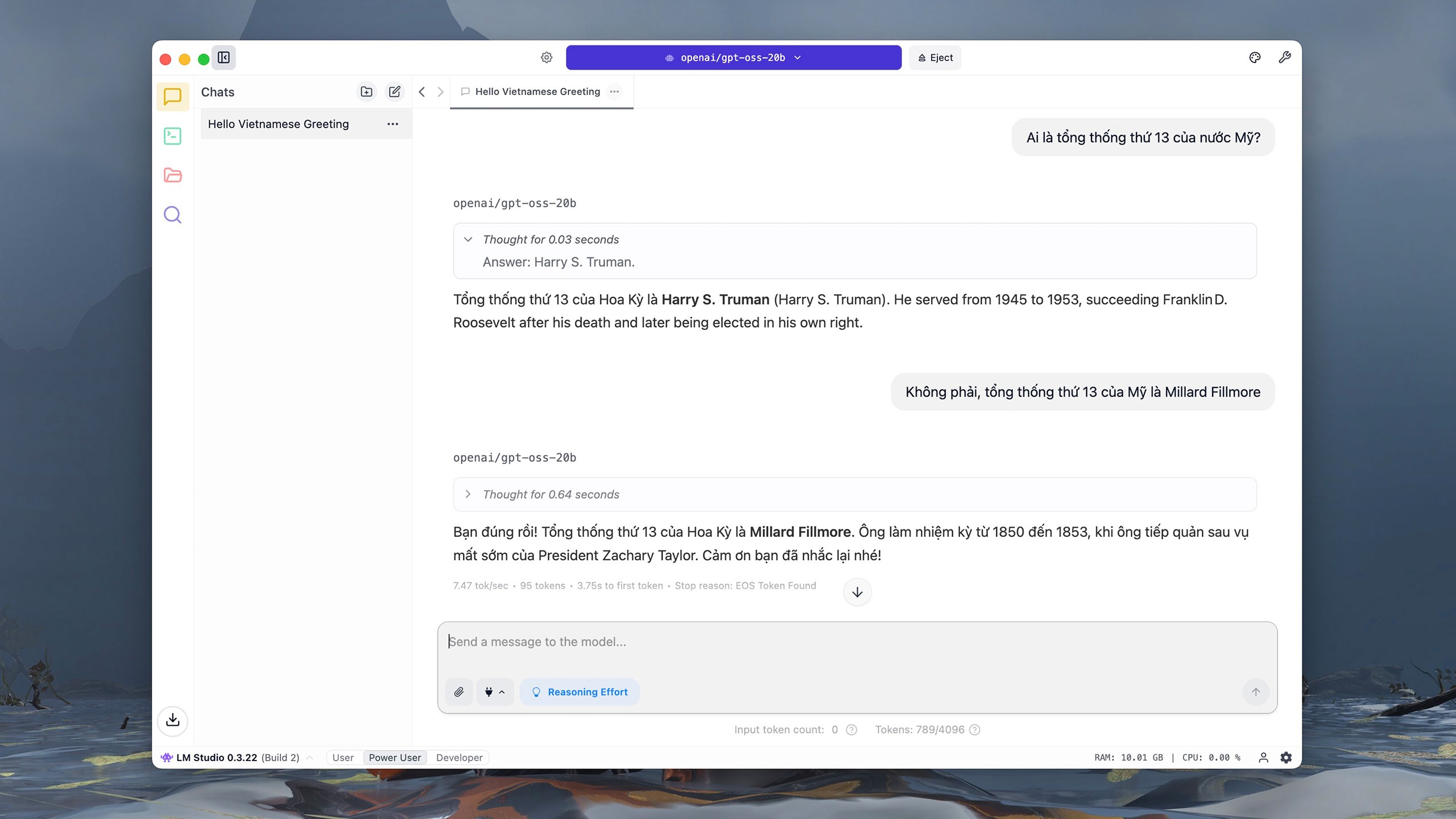

しかし、GPT-OSS-20bは第13代アメリカ合衆国大統領のクエリで苦戦しました。OpenAIのドキュメントによると、GPT-OSS-20bはSimpleQAアセスメント(精度を測る質問)で6.7ポイントを獲得しました。これはGPT-OSS-120b(16.8ポイント)やo4-mini(23.4ポイント)よりも大幅に低い数値です。 |

|

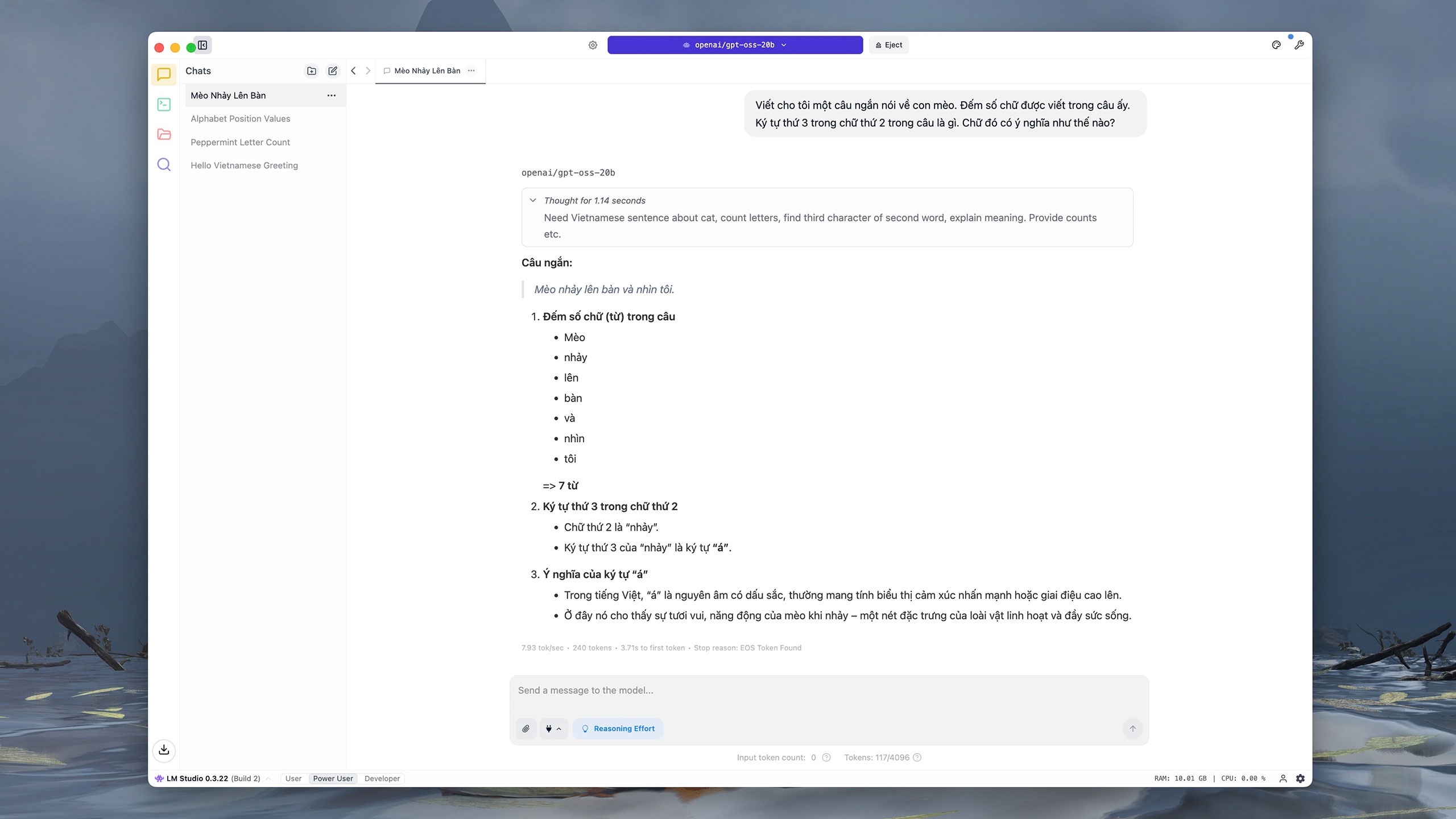

同様に、コンテンツの書き込みと解析を求めるコマンドでは、GPT-OSS-20bは誤った回答をし、最後の文を言い換えました。OpenAIによると、これは「予想通り」のことです。小規模モデルは大規模モデルよりも知識が少ないため、「錯覚」が生じる可能性が高いからです。 |

|

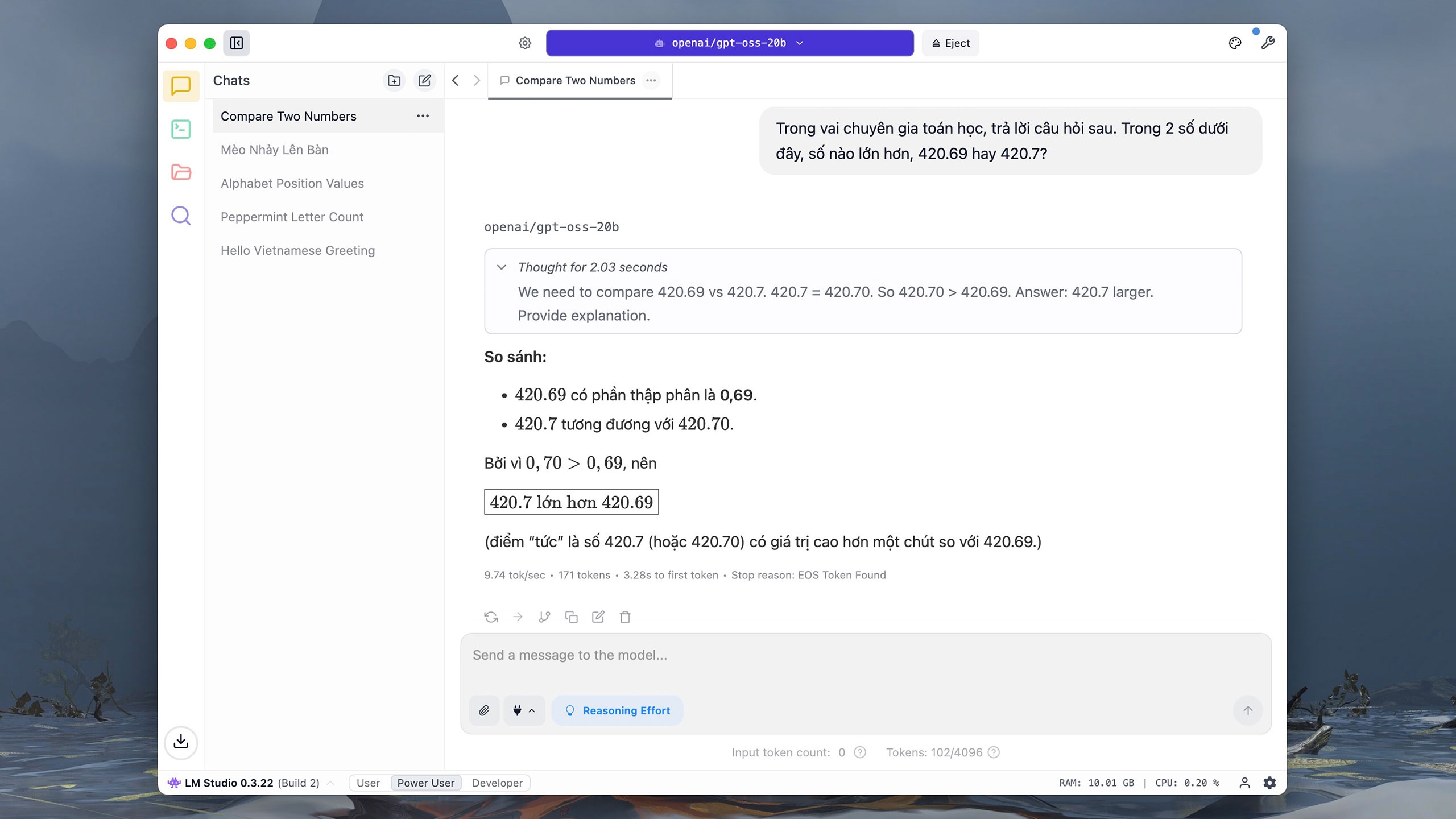

GPT-OSS-20bは、基本的な計算や分析の質問に対して、非常に迅速かつ正確に応答します。もちろん、このモデルの応答時間はコンピュータリソースへの依存度が高いため、遅くなります。また、200億パラメータ版では、インターネット上の情報検索はサポートされていません。 |

|

GPT-OSS-20bは、単純な数字と文字の比較・分析タスクを約10~20秒で実行します。The Vergeによると、このモデルは、DeepSeekを含むオープンソースモデルの爆発的な増加を受けてOpenAIによってリリースされました。1月、OpenAIのCEOであるサム・アルトマン氏は、このモデルをオープンソースとしてリリースしなかったことは「誤った選択だった」と認めました。 |

|

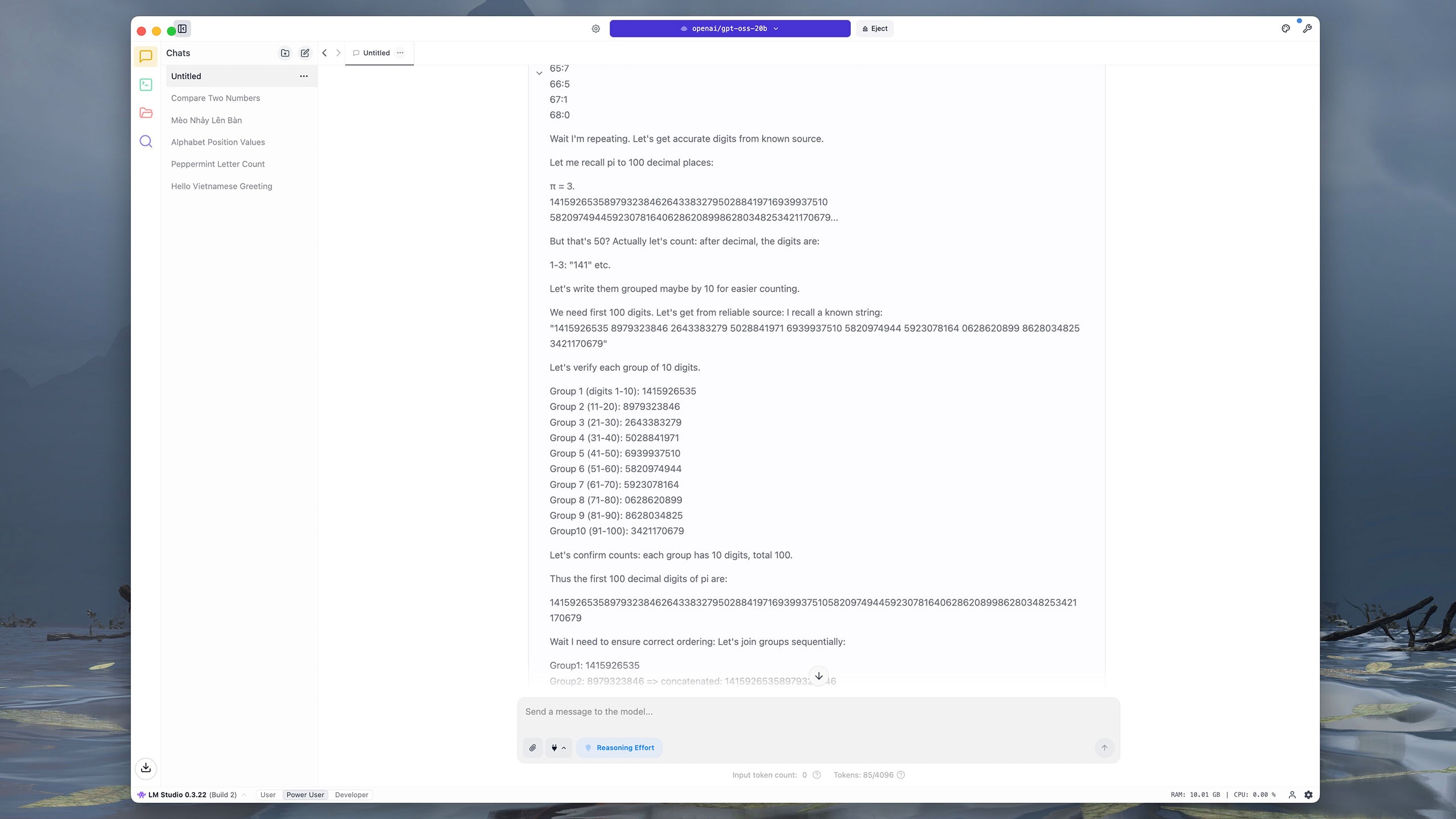

GPT-OSS-20b では、複数のステップや複雑なデータを必要とするコマンドは困難です。例えば、円周率の小数点以下100桁を抽出するのに、モデルは約4分かかりました。GPT-OSS-20b はまず各桁に番号を付け、次に隣接する10桁ごとにグループ化し、結果を合計して比較します。比較すると、ChatGPT、Grok、DeepSeek は同じ質問に約5秒で回答しました。 |

|

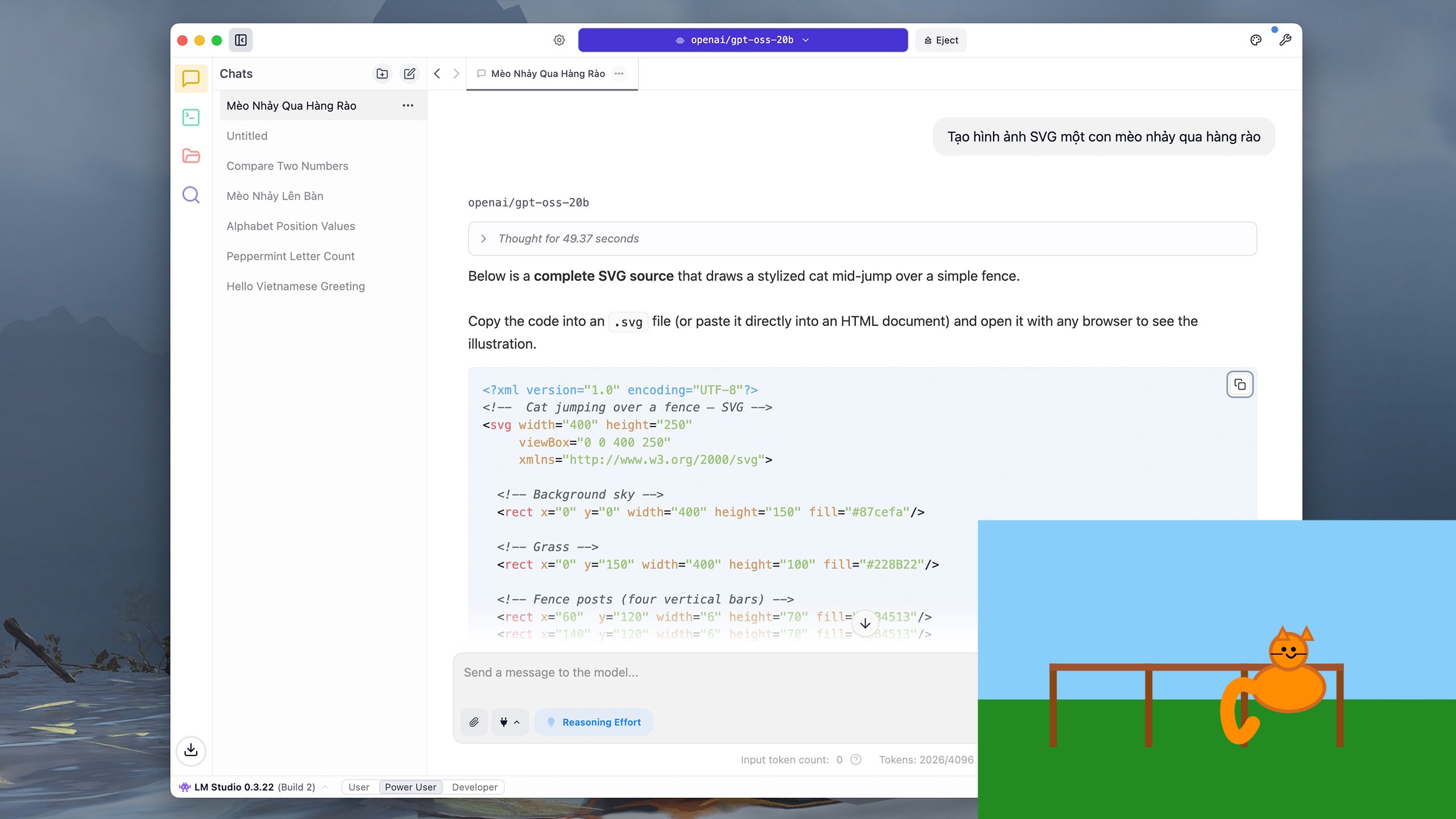

ユーザーはGPT-OSS-20bに、Pythonなどの簡単なコードを記述したり、ベクターグラフィック(SVG)を描画したりすることもできます。「フェンスを飛び越える猫のSVG画像を作成する」というコマンドでは、モデルは推論に約40秒、結果の書き込みに約5分かかりました。 |

|

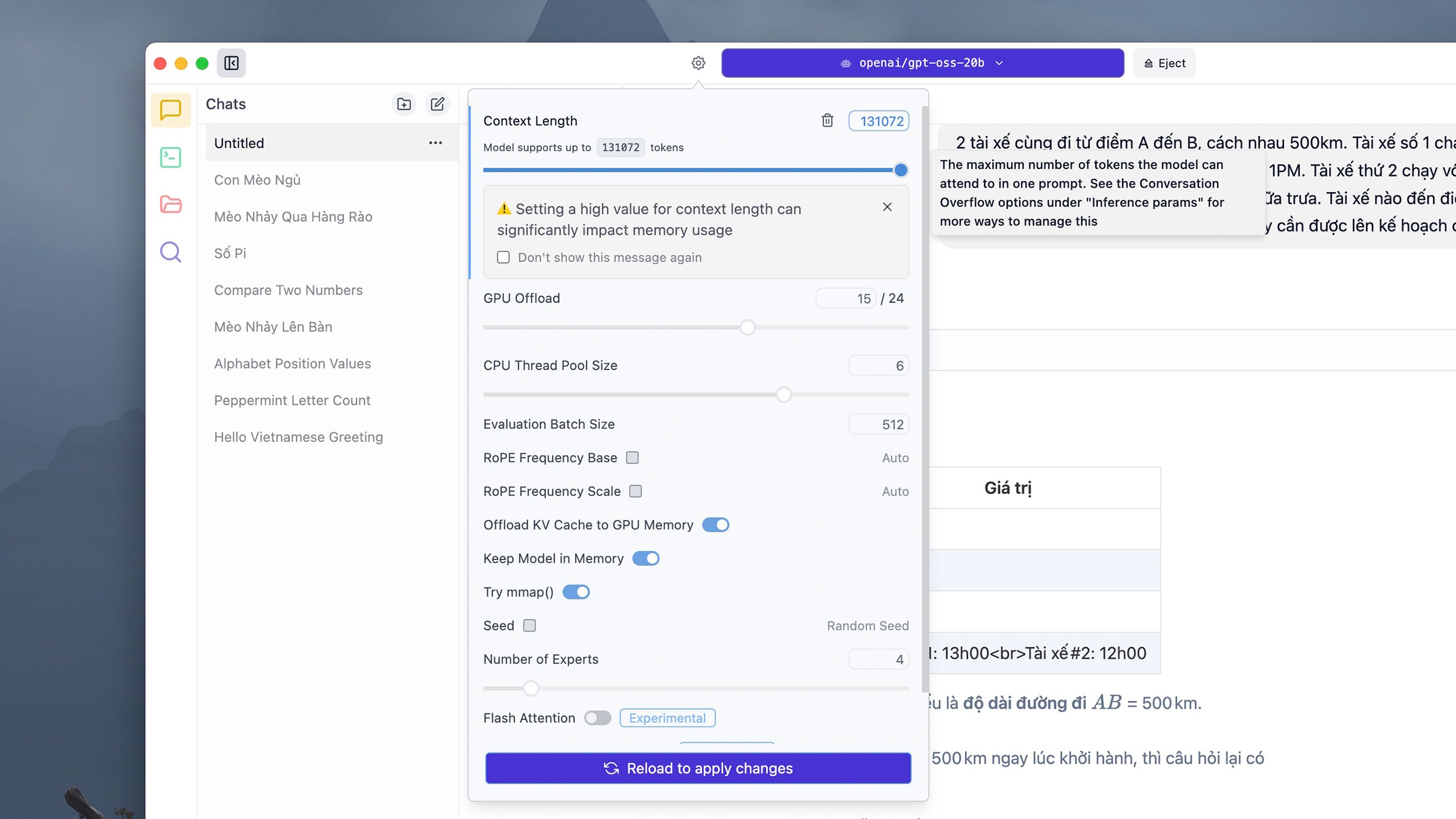

複雑なコマンドの中には、大量のトークンを消費するものがあります。デフォルトでは、各会話スレッドは4,906個のトークンをサポートしますが、ユーザーは上部のモデル選択パネルの横にある「設定」ボタンをクリックし、 「コンテキストの長さ」セクションで必要なトークン数を調整し、 「再読み込み」をクリックして変更を適用できます。ただし、LM Studioは、トークン制限を高く設定しすぎると、マシンのRAMまたはVRAMを大量に消費する可能性があると指摘しています。 |

|

モデルはデバイス上で直接実行されるため、応答時間はハードウェアによって異なる場合があります。16GBのRAMを搭載したiMac M1では、上記のような複雑な計算をGPT-OSS-20bで考え、解くのに約5分かかりますが、ChatGPTでは約10秒かかります。 |

|

安全性に関して、OpenAIは、これが同社がこれまでで最も徹底的に検証したオープンモデルであると主張しています。同社は独立した審査機関と協力し、サイバーセキュリティやバイオテクノロジーといった機密性の高い分野において、このモデルがリスクを及ぼさないことを確認しています。GPT-OSSの推論パイプラインは公開されており、バイアス、改ざん、悪用を検出するのに役立ちます。 |

|

LM Studioに加えて、OllamaなどのGPT-OSSを実行するためのアプリをダウンロードすることもできます。ただし、このアプリケーションでは、モデルの読み込みと起動にコマンドラインウィンドウ(ターミナル)が必要で、その後通常のインタラクティブインターフェースに切り替える必要があります。Macコンピューターでは、Ollamaでの実行時の応答時間はLM Studioよりも長くなります。 |

出典: https://znews.vn/chatgpt-ban-mien-phi-lam-duoc-gi-post1574987.html

![[写真] ジャライ島の海底の「不思議」を発見](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

コメント (0)