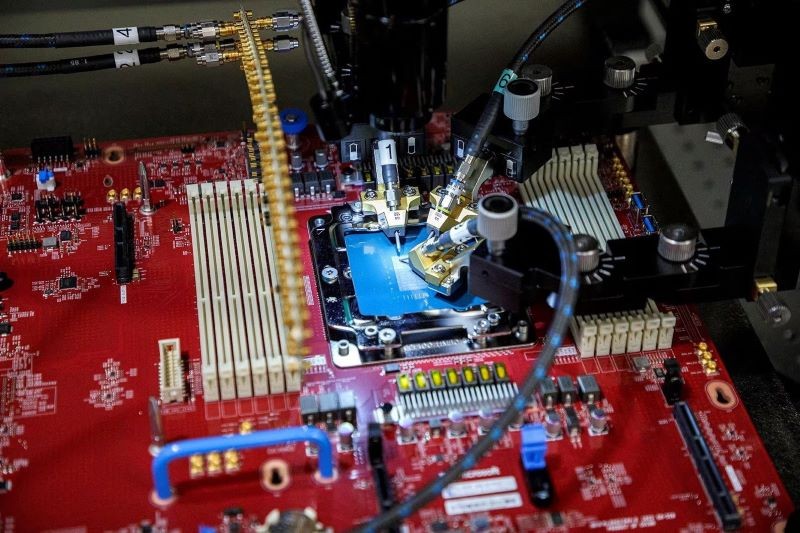

マイクロソフトは、AIチップを商用化する計画はないと発表した。同社は、自社のソフトウェア製品やクラウドコンピューティングサービス「Azure」で、これらのチップを社内利用する予定だ。

|

| チップの自社生産は、テクノロジー企業が高額な AI コストを削減するのに役立つトレンドです。 |

マイクロソフトの幹部は、共通プラットフォームモデルを用いてAIをソフトウェアエコシステム全体に深く統合することで、AIのコスト高騰に対処する計画だと述べています。そして、Maiaチップはまさにそれを実現するために設計されています。

Maia チップは、Microsoft と ChatGPT を所有する企業とのコラボレーションによる Azure OpenAI サービスの基盤となる大規模言語モデル (LLM) を実行するために Microsoft によって設計されたものです。

マイクロソフトはまた、来年にはAzureの顧客向けに、NVIDIAとAdvanced Micro Devices(AMD)の最新の主要チップを搭載したクラウドサービスを提供する予定だと発表した。現在、AMDチップ上でGPT-4のテストを行っている。

一方、コードネーム「コバルト」と呼ばれる2つ目のチップは、マイクロソフトが社内コストを節約し、独自設計のチップ「グラビトン」を採用しているアマゾンのAWSクラウドサービスに対抗するために発売された。

Cobalt は、Teams エンタープライズ メッセージング ソフトウェアの基盤として現在テストされている Arm ベースの中央処理装置 (CPU) です。

AWS によれば、同社の Graviton チップは現在約 5 万人の顧客を抱えており、同社は今月下旬に開発者会議を開催する予定だ。

Azure ハードウェアおよびインフラストラクチャ担当コーポレートバイスプレジデントの Rani Borkar 氏は、両方の新しい AI チップは TSMC の 5nm プロセスを使用して製造されていると述べました。

Maia チップは、Microsoft が OpenAI 向けに構築したスーパーコンピューターで使用した、より高価なカスタム Nvidia ネットワーク テクノロジではなく、標準の Ethernet ケーブルと組み合わせて使用されます。

[広告2]

ソース

コメント (0)