|

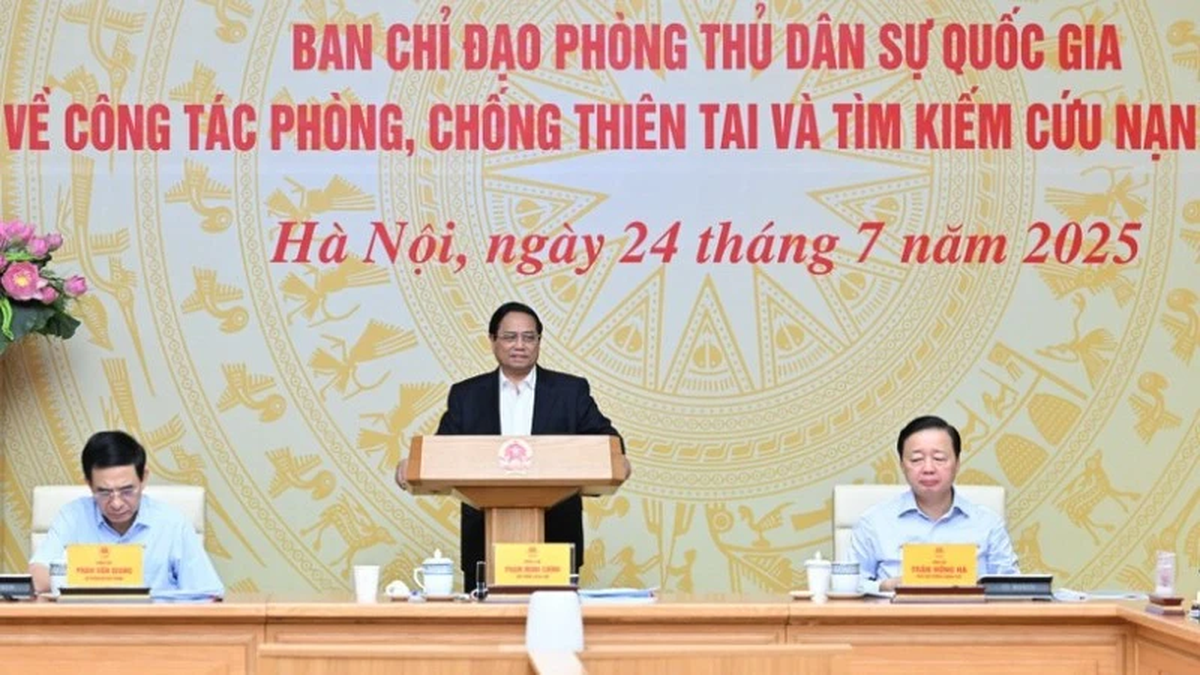

휴대폰 화면에 GPT-4o가 표시됩니다. |

ChatGPT-4o는 앞으로 몇 주 안에 테스터들에게 공개될 예정입니다.

ChatGPT의 새로운 버전은 얼굴 표정을 읽고, 인간의 말투를 모방하고, 거의 실시간 대화를 할 수 있다고 개발자들이 밝혔습니다.

OpenAI는 실시간 프레젠테이션에서 자사의 인공지능(AI) 챗봇 GPT-4o의 차기 버전을 선보였습니다. 발표자와 전화 통화를 하는 이 챗봇은 인간의 대화와 미묘한 감정 신호를 능숙하게 처리하는 것으로 보였습니다. 명령에 따라 로봇 음성과 음성을 전환하고, 방해 요소에 적응하며, 얼굴 표정과 주변 환경을 직관적으로 처리했습니다.

시연에서 AI 음성 비서는 실시간으로 언어를 번역하고, 종이에 쓰인 수학 방정식을 풀고, 런던 거리에서 시각 장애인을 안내하는 등의 작업을 수행하며 그 기술을 선보였습니다.

OpenAI의 CEO 샘 알트만은 프레젠테이션이 끝난 후 소셜 미디어 플랫폼 X에 한 단어로 된 글을 올렸습니다. 이 글은 외로운 남자가 AI 비서와 사랑에 빠지는 2013년 동명의 영화를 언급하는 것이었습니다.

챗봇은 시각적 신호를 읽는 능력을 보여주기 위해 휴대폰 카메라 렌즈를 사용하여 OpenAI 엔지니어의 얼굴 표정을 읽고 감정을 설명했습니다.

이러한 새로운 기능은 이전 모델의 제한된 음성 기능에 비해 엄청난 개선입니다. 이전 모델에서는 방해를 처리하거나 시각적 정보에 응답할 수 없었습니다.

OpenAI의 최고기술책임자(CTO)인 미라 무라티는 기자회견에서 "우리는 인간-기계 상호작용의 미래를 바라보고 있습니다."라고 말했습니다. "GPT-4o가 그 패러다임을 완전히 바꾸고 있다고 생각합니다."

새로운 음성 비서는 앞으로 몇 주 안에 알파 테스터에게 제한적으로 출시될 예정이며, 이후 ChatGPT Plus 구독자를 대상으로 유료 출시가 시작될 예정입니다.

이 발표는 또한 Bloomberg가 해당 회사가 iPhone에 ChatGPT를 통합하기 위해 Apple과 계약을 맺을 것으로 보인다고 보도한 데 따른 것입니다. 이로써 GPT-4o가 iPhone의 음성 비서인 Siri를 업그레이드하는 데 사용될 가능성이 열렸습니다.

그러나 이 새로운 기술은 안전과 사기 전화에 대한 우려도 제기합니다.

댓글 (0)