최근 가장 주목받는 중국 스타트업인 딥시크(DeepSeek)가 단 500만 달러로 오픈AI(OpenAI) 수준의 AI를 개발했다는 주장에 대해 의문이 제기되고 있다.

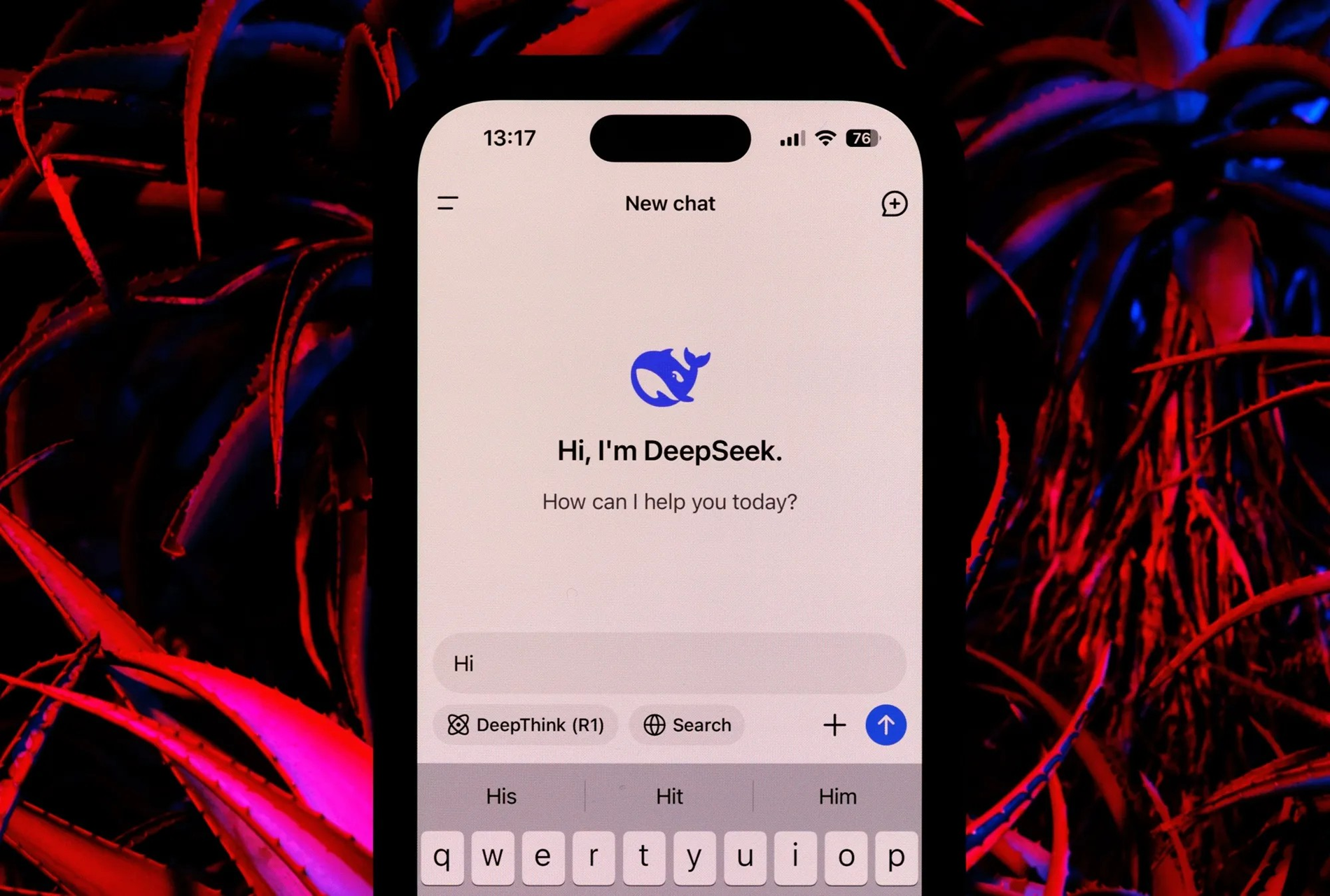

딥시크는 뱀의 해 초에 언론과 소셜 미디어에서 대대적인 보도를 하며 전 세계 증시에 상당한 파장을 일으켰습니다.

하지만 금융 컨설팅 회사인 번스타인의 최근 보고서는 인상적인 성과에도 불구하고, 단 500만 달러로 오픈AI의 시스템과 동등한 AI 시스템을 개발했다는 주장은 사실과 다르다고 경고합니다.

번스타인에 따르면 딥시크의 성명은 오해의 소지가 있으며 전체적인 상황을 반영하지 않는다.

"저희는 딥시크가 '500만 달러로 오픈AI를 만들었다'고 생각하지 않습니다. 모델은 훌륭하지만 기적이라고는 생각하지 않으며, 주말 동안의 혼란은 과장된 것으로 보입니다."라고 보고서는 밝혔습니다.

DeepSeek은 DeepSeek-V3와 DeepSeek R1이라는 두 가지 주요 AI 모델을 개발합니다. 대규모 언어 모델인 V3는 MOE 아키텍처를 활용하여 작은 모델들을 결합함으로써 기존 모델보다 적은 컴퓨팅 자원을 사용하면서도 높은 성능을 달성합니다.

반면, V3 모델은 6710억 개의 파라미터를 가지고 있으며, 언제든지 370억 개의 파라미터가 활성화됩니다. 또한 메모리 사용량을 줄이기 위한 MHLA와 효율성 향상을 위한 FP8 활용과 같은 혁신 기술을 통합했습니다.

V3 모델 학습에는 2개월 동안 2,048개의 엔비디아 H800 GPU 클러스터가 필요했으며, 이는 550만 GPU 시간에 해당합니다. 일부에서는 학습 비용을 약 500만 달러로 추산하지만, 번스타인의 보고서는 이 수치가 컴퓨팅 자원 비용만을 포함하며 연구, 테스트 및 기타 개발 관련 비용은 반영하지 않았다고 강조합니다.

DeepSeek R1 모델은 V3의 기반 위에 강화 학습(RL) 및 기타 기술을 활용하여 추론 기능을 보장합니다.

R1 모델은 추론 작업에서 OpenAI 모델과 경쟁할 수 있습니다. 그러나 번스타인은 R1 개발에 상당한 자원이 필요하다고 지적했지만, DeepSeek 보고서에는 이러한 자원에 대한 자세한 내용이 나와 있지 않습니다.

딥시크에 대해 논평하면서 번스타인은 모델들이 인상적이라고 칭찬했습니다. 예를 들어, V3 모델은 언어학, 프로그래밍, 수학 분야에서 다른 주요 언어 모델들과 비교해 성능이 비슷하거나 더 우수하면서도 더 적은 리소스를 필요로 합니다.

V3 사전 학습 과정에는 270만 GPU 시간의 작업량만 필요했는데, 이는 다른 최상위 모델들의 컴퓨팅 자원의 9%에 불과합니다.

번스타인은 딥시크의 발전은 주목할 만하지만 과장된 주장은 경계해야 한다고 결론지었다. 단 500만 달러로 오픈AI의 경쟁자를 만들겠다는 발상은 다소 잘못된 생각인 것 같다.

(타임스 오브 인디아에 따르면)

[광고_2]

출처: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

![[이미지] 중앙당사무실이 2025년 사업 계획을 요약 발표했습니다.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F18%2F1766065572073_vptw-hoi-nghi-tong-ket-89-1204-jpg.webp&w=3840&q=75)

![[영상] 역사와 문화유산 보존에 관한 두 권의 책 출간 기념 행사](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/18/1766072185865_2663241292917005256-4230-jpg.webp)

댓글 (0)