다크 AI는 안전 규범을 벗어나 작동하며, 면밀한 감독 없이 사기, 조작, 사이버 공격 또는 데이터 마이닝과 같은 행위가 허용되는 경우가 많습니다.

"악의적인 행위자들은 공격 역량을 강화하기 위해 AI를 활용하고 있습니다. 오늘날 AI의 가장 흔한 악용 사례는 블랙햇 GPT 모델의 등장입니다. 이는 악성 코드 제작, 피싱 이메일 작성, 음성 및 딥페이크 영상 제작 등 불법적인 목적을 위해 특별히 개발되거나 개조된 AI 모델입니다." 카스퍼스키랩의 중동, 터키, 아프리카 및 아시아 태평양 지역 담당 글로벌 조사 분석팀(GReAT) 책임자인 세르게이 로즈킨은 이렇게 말했습니다.

Black Hat GPT는 완전 비공개 또는 준비공개 AI 모델로 존재할 수 있습니다. 대표적인 예로 WormGPT, DarkBard, FraudGPT, Xanthorox 등이 있으며, 모두 사이버 범죄, 사기 및 악의적 자동화를 위해 설계되었습니다.

로즈킨 씨는 카스퍼스키 전문가들이 국가 또는 정부 지원 사이버 공격 그룹이 공격 캠페인에 대규모 언어 모델(LLM)을 활용하기 시작하면서 훨씬 더 우려스러운 추세가 나타나고 있다고 밝혔습니다.

"OpenAI는 최근 자사의 AI 도구를 악용한 20건 이상의 은밀한 영향력 행사와 사이버 공격을 차단했다고 발표했습니다. AI를 무기로 사용하는 공격자들이 점점 더 정교해지고 있으며, 공공 및 민간 생태계 모두에 위협을 가할 것입니다. 이는 모든 조직이 대비해야 할 우려스러운 추세입니다."라고 로즈킨은 말했습니다.

OpenAI 보고서에 따르면, 악의적인 공격자들은 대규모 머신러닝 모델(LLM)의 기능을 악용하여 피해자를 속이고 기존 보안 계층을 우회하기 시작했습니다. 이들은 그럴듯한 가짜 메시지를 만들고, 피해자에게 대량으로 메시지를 전송하고, 여러 언어로 콘텐츠를 제작할 수 있습니다.

다크 AI 위협에 대한 방어를 강화하기 위해 카스퍼스키 전문가들은 다음과 같은 방안을 권고합니다. 카스퍼스키 넥스트와 같은 차세대 보안 솔루션을 사용하여 AI에서 생성된 악성 코드를 탐지하고 공급망의 위험을 통제합니다. 실시간 위협 인텔리전스 도구를 활용하여 AI 기반 익스플로잇을 모니터링합니다. 섀도 AI와 데이터 유출 위험을 제한하기 위해 접근 제어 및 직원 교육을 강화합니다. 위협을 모니터링하고 사고에 신속하게 대응하기 위한 보안 운영 센터(SOC)를 구축합니다.

출처: https://www.sggp.org.vn/kaspersky-canh-bao-toi-pham-mang-dung-dark-ai-tan-cong-post808493.html

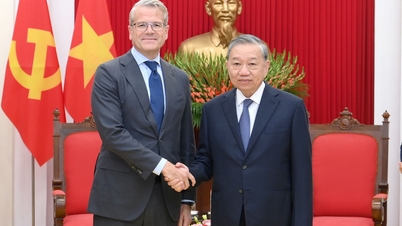

![[사진] 토람 사무총장, 슬로바키아 부총리 겸 국방장관 로버트 칼리낙 접견](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/18/1763467091441_a1-bnd-8261-6981-jpg.webp)

댓글 (0)