GPU is het brein van AI-computers

Simpel gezegd fungeert de grafische verwerkingseenheid (GPU) als het brein van de AI-computer.

Zoals u wellicht weet, is de centrale verwerkingseenheid (CPU) het brein van de computer. Het voordeel van een GPU is dat het een gespecialiseerde CPU is die complexe berekeningen kan uitvoeren. De snelste manier om dit te doen, is door groepen GPU's hetzelfde probleem te laten oplossen. Het trainen van een AI-model kan echter nog steeds weken of zelfs maanden duren. Eenmaal gebouwd, wordt het in een front-end computersysteem geplaatst en kunnen gebruikers vragen stellen aan het AI-model, een proces dat inferentie wordt genoemd.

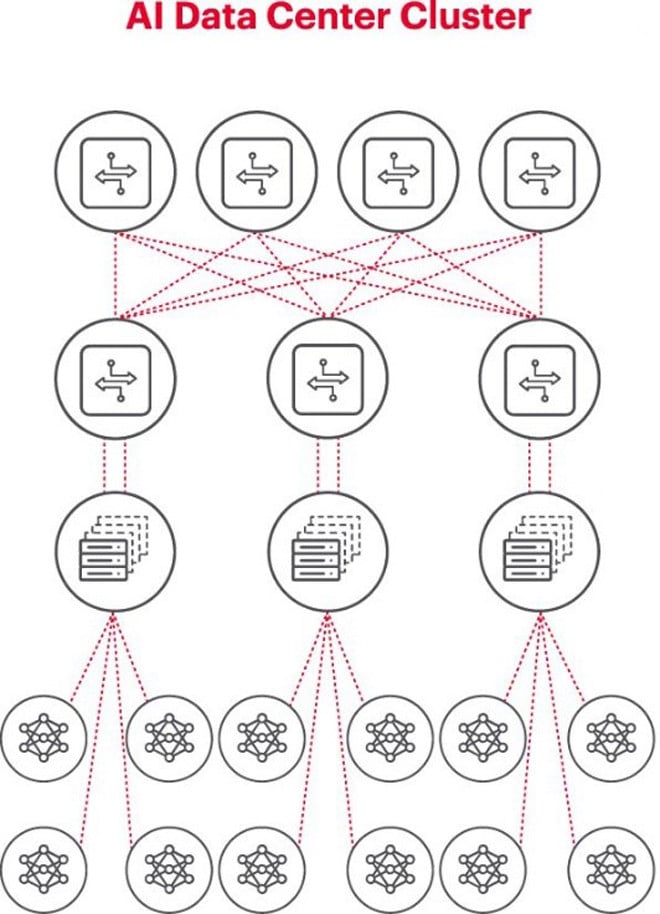

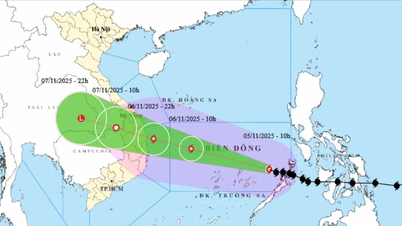

Een AI-computer met meerdere GPU's

De beste architectuur voor AI-problemen is het gebruik van een cluster van GPU's in een rack, aangesloten op een switch bovenop het rack. Meerdere GPU-racks kunnen in een netwerkhiërarchie met elkaar worden verbonden. Naarmate het probleem complexer wordt, nemen de GPU-vereisten toe en moeten sommige projecten mogelijk clusters van duizenden GPU's implementeren.

Elk AI-cluster is een klein netwerk

Bij het bouwen van een AI-cluster is het noodzakelijk om een klein computernetwerk op te zetten om GPU's met elkaar te verbinden en ervoor te zorgen dat ze efficiënt samenwerken en gegevens delen.

De bovenstaande afbeelding illustreert een AI-cluster waarbij de cirkels onderaan de workflows op GPU's weergeven. De GPU's maken verbinding met de top-of-rack (ToR)-switches. De ToR-switches maken ook verbinding met de netwerkbackbone-switches die boven het diagram worden weergegeven, wat de duidelijke netwerkhiërarchie illustreert die nodig is wanneer er meerdere GPU's betrokken zijn.

Netwerken vormen een knelpunt bij de implementatie van AI

Afgelopen najaar, tijdens de Open Computer Project (OCP) Global Summit, waar afgevaardigden werkten aan de ontwikkeling van de volgende generatie AI-infrastructuur, bracht afgevaardigde Loi Nguyen van Marvell Technology een belangrijk punt naar voren: "netwerken zijn de nieuwe bottleneck."

Technisch gezien kan een hoge pakketlatentie of pakketverlies als gevolg van netwerkcongestie ervoor zorgen dat pakketten opnieuw worden verzonden, wat de voltooiingstijd (JCT) aanzienlijk verhoogt. Bedrijven verspillen hierdoor miljoenen of tientallen miljoenen dollars aan GPU's door inefficiënte AI-systemen, wat hen zowel omzet als time-to-market kost.

Meten is een sleutelvoorwaarde voor het succesvol functioneren van AI-netwerken

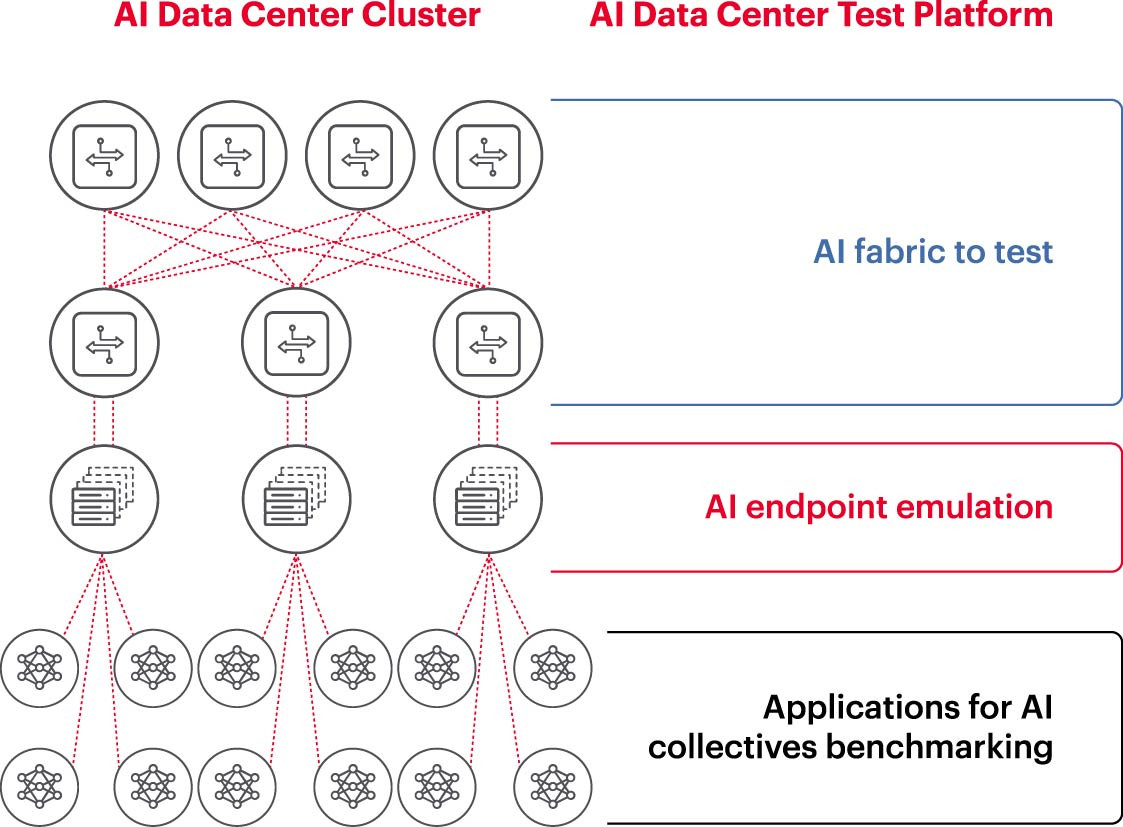

Om een AI-cluster effectief te laten werken, moeten GPU's volledig benut kunnen worden om de trainingstijd te verkorten en het leermodel optimaal te benutten om het rendement op de investering te maximaliseren. Daarom is het noodzakelijk om de prestaties van het AI-cluster te testen en te evalueren (Figuur 2). Deze taak is echter niet eenvoudig, omdat er qua systeemarchitectuur veel instellingen en relaties zijn tussen GPU's en netwerkstructuren die elkaar moeten aanvullen om het probleem op te lossen.

Dit brengt veel uitdagingen met zich mee bij het meten van AI-netwerken:

- Moeilijkheden bij het reproduceren van volledige productienetwerken in het laboratorium vanwege beperkingen op het gebied van kosten, apparatuur, tekort aan bekwame netwerk-AI-engineers, ruimte, stroom en temperatuur.

- Metingen op het productiesysteem verminderen de beschikbare verwerkingscapaciteit van het productiesysteem zelf.

- Moeilijkheden bij het nauwkeurig reproduceren van de problemen vanwege verschillen in schaal en reikwijdte van de problemen.

- De complexiteit van de manier waarop GPU's collectief met elkaar verbonden zijn.

Om deze uitdagingen aan te gaan, kunnen bedrijven een subset van de aanbevolen configuraties testen in een labomgeving om belangrijke statistieken zoals de voltooiingstijd van taken (Job Completement Time, JCT) en de bandbreedte die het AI-team kan bereiken, te benchmarken en deze te vergelijken met het gebruik van het switching platform en de cache. Deze benchmarking helpt bij het vinden van de juiste balans tussen GPU/verwerkingsbelasting en netwerkontwerp/configuratie. Zodra de computerarchitecten en netwerkengineers tevreden zijn met de resultaten, kunnen ze deze configuraties in productie nemen en nieuwe resultaten meten.

Onderzoekslaboratoria van bedrijven, academische instellingen en universiteiten werken aan het analyseren van elk aspect van het bouwen en beheren van effectieve AI-netwerken om de uitdagingen van het werken met grote netwerken aan te pakken, vooral omdat best practices zich blijven ontwikkelen. Deze collaboratieve, herhaalbare aanpak is de enige manier voor bedrijven om herhaalbare metingen uit te voeren en snel 'what-if'-scenario's te testen die de basis vormen voor het optimaliseren van netwerken voor AI.

(Bron: Keysight Technologies)

Bron: https://vietnamnet.vn/ket-noi-mang-ai-5-dieu-can-biet-2321288.html

![[Foto] Opening van de 14e Conferentie van het 13e Centraal Comité van de Partij](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/05/1762310995216_a5-bnd-5742-5255-jpg.webp)

Reactie (0)