En ny studie fra University of Texas i Austin, Texas A&M University og Purdue University antyder at kunstig intelligens kan bli «hjerneråten» akkurat som mennesker når den får innhold av dårlig kvalitet på sosiale medier.

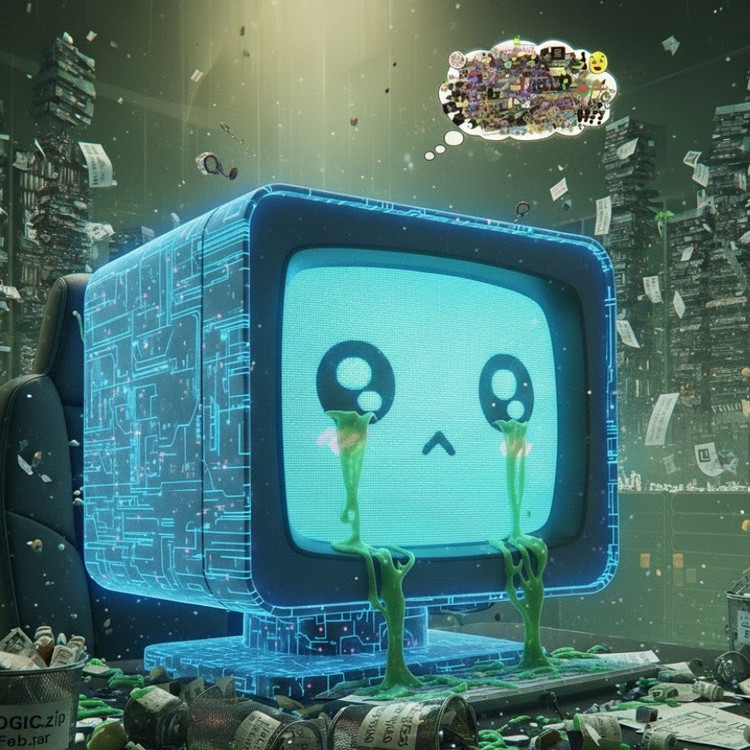

Dette fenomenet, kjent som «AI-hjernerot», antyder at når store språkmodeller absorberer for mye viralt, sensasjonelt og overfladisk innhold, mister de gradvis evnen til å tenke logisk, huske og til og med bli moralsk avvikende.

Ikke bare mennesker, men også AI lider av hjernesvikt når den surfer på for mange ubrukelige korte videoer .

Forskningsteamet, ledet av Junyuan Hong, nå en påtroppende foreleser ved National University of Singapore, utførte eksperimenter på to språkmodeller med åpen kildekode: Metas Llama og Alibabas Qwen.

De matet modellene med forskjellige typer data – noe nøytralt informativt innhold, andre svært avhengighetsskapende innlegg på sosiale medier med vanlige ord som «wow», «se» og «bare i dag». Målet var å se hva som skjer når AI trenes på innhold som er designet for å tiltrekke seg visninger i stedet for å levere reell verdi.

Resultatene viste at modeller som ble «matet» med en strøm av søppelinformasjon på nettet, begynte å vise tydelige tegn på kognitiv nedgang: resonneringsevnen deres ble svekket, korttidshukommelsen deres ble dårligere, og, enda mer bekymringsfullt, de ble mer «uetiske» på atferdsvurderingsskalaer.

Noen målinger viser også en «psykologisk forvrengning» som etterligner den psykologiske responsen folk opplever etter langvarig eksponering for skadelig innhold, et fenomen som gjenspeiler tidligere studier av mennesker som viser at «doomscrolling» – den konstante rullingen av negative nyheter på nettet – gradvis kan erodere hjernen.

Uttrykket «hjernerot» ble til og med valgt av Oxford Dictionaries som årets ord i 2024, noe som gjenspeiler fenomenets utbredelse i det digitale liv.

Dette funnet er en alvorlig advarsel for AI-bransjen, hvor mange selskaper fortsatt mener at data fra sosiale medier er en rik kilde til opplæringsressurser, ifølge Hong.

«Trening med viralt innhold kan bidra til å skalere opp dataene, men det undergraver også modellens resonnement, etikk og oppmerksomhet i stillhet», sa han. Enda bekymringsfullere er det at modeller som er påvirket av denne typen data av dårlig kvalitet, ikke kan gjenopprette seg helt selv etter omtrening med «renere» data.

Dette utgjør et stort problem i sammenheng med at AI i seg selv nå produserer mer og mer innhold på sosiale nettverk. Etter hvert som AI-genererte innlegg, bilder og kommentarer blir mer og mer utbredt, fortsetter de å bli opplæringsmateriell for neste generasjon av AI, noe som skaper en ond sirkel som fører til at datakvaliteten synker.

«Etter hvert som AI-generert søppelinnhold sprer seg, forurenser det selve dataene som fremtidige modeller vil lære av», advarte Hong. «Når denne «hjerneråten» først setter inn, kan ikke omskolering med rene data kurere den fullstendig.»

Studien har gitt AI-utviklere en vekker: Mens verden haster med å utvide dataskalaen, er det mer bekymringsfullt at vi kanskje gir næring til «kunstige hjerner» som sakte råtner – ikke på grunn av mangel på informasjon, men på grunn av en overflod av meningsløse ting.

Kilde: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Foto] Statsminister Pham Minh Chinh leder det andre møtet i styringskomiteen for privat økonomisk utvikling.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Kommentar (0)