Det komplekse bildet av bruken av AI-dreperroboter

Å la kunstig intelligens kontrollere våpensystemer kan bety at mål blir identifisert, angrepet og ødelagt uten menneskelig inngripen. Dette reiser alvorlige juridiske og etiske spørsmål.

Østerrikes utenriksminister Alexander Schallenberg understreket alvoret i situasjonen og sa: «Dette er vår generasjons Oppenheimer-øyeblikk.»

Roboter og våpen som bruker kunstig intelligens begynner å bli mye brukt i hærene i mange land. Foto: Forbes

I hvilken grad «ånden har rømt fra flasken» har faktisk blitt et presserende spørsmål, ettersom droner og kunstig intelligens (KI) har blitt mye brukt av militæret over hele verden .

«Bruken av droner i moderne konflikter av Russland og Ukraina, bruken av droner av USA i målrettede angrepsoperasjoner i Afghanistan og Pakistan, og som nylig avslørt forrige måned, som en del av Israels Lavender-program, viser hvordan AIs informasjonsbehandlingskapasiteter aktivt brukes av verdens militære for å styrke sin offensive kraft», sa forsvarsanalytiker Wilson Jones hos GlobalData.

Undersøkelser utført av det London-baserte Office of War Investigative Journalism viste at det israelske militærets Lavender AI-system hadde en nøyaktighet på 90 % i identifiseringen av individer med Hamas-koblinger, noe som betyr at 10 % ikke var det. Dette resulterte i sivile dødsfall på grunn av AI-ens identifiserings- og beslutningstaking.

En trussel mot global sikkerhet

Bruk av kunstig intelligens på denne måten understreker behovet for å håndtere teknologi i våpensystemer.

«Bruken av kunstig intelligens i våpensystemer, spesielt når den brukes til målretting, reiser grunnleggende spørsmål om oss – mennesker – og vårt forhold til krig , og mer spesifikt våre antagelser om hvordan vi kan bruke vold i væpnede konflikter», forklarte dr. Alexander Blanchard, seniorforsker i programmet Governance of Artificial Intelligence ved Stockholm International Peace Research Institute (SIPRI), en uavhengig forskningsgruppe med fokus på global sikkerhet, til Army Technology.

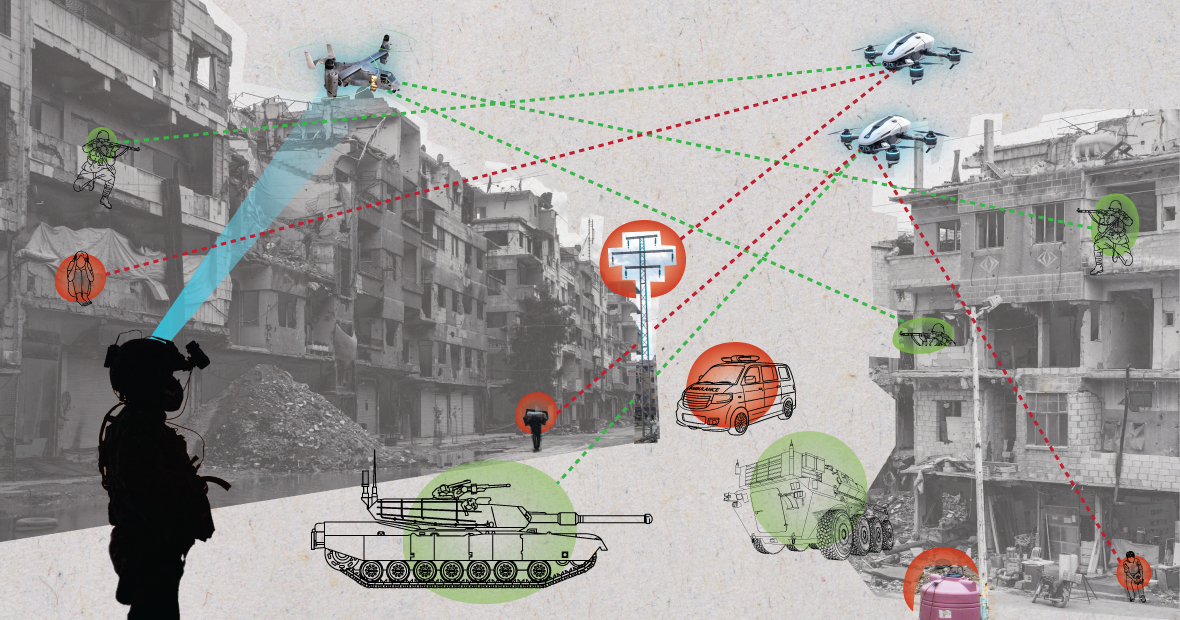

AI-systemer kan oppføre seg uforutsigbart når de brukes i kaotiske miljøer, og det kan hende de ikke klarer å identifisere mål nøyaktig. Foto: MES

«Endrer AI måten militæret velger mål og bruker makt på dem? Disse endringene reiser igjen en rekke juridiske, etiske og operative spørsmål. De største bekymringene er humanitære», la Dr. Blanchard til.

«Mange er bekymret for at autonome systemer, avhengig av hvordan de utformes og brukes, kan sette sivile og andre som er beskyttet av internasjonal lov, i større fare for skade», forklarte SIPRI-eksperten. «Dette er fordi AI-systemer, spesielt når de brukes i kaotiske miljøer, kan operere uforutsigbart og kanskje ikke klarer å identifisere mål nøyaktig og angripe sivile, eller å identifisere stridende som ikke er i kamp.»

I en utdyping av problemstillingen bemerket forsvarsanalytiker Wilson Jones hos GlobalData at spørsmålet om hvordan skyld fastsettes kan være tvilsomt.

«I henhold til gjeldende krigslovgivning finnes det et konsept om kommandoansvar», sa Jones. «Dette betyr at en offiser, general eller annen leder er juridisk ansvarlig for handlingene til troppene under deres kommando. Hvis tropper begår krigsforbrytelser, er offiseren ansvarlig selv om de ikke ga ordrene. Bevisbyrden ligger hos dem for å bevise at de gjorde alt de kunne for å forhindre krigsforbrytelser.»

«Med AI-systemer kompliserer dette ting. Er en IT-tekniker ansvarlig? En systemdesigner? Det er ikke klart. Hvis det ikke er klart, skaper det en moralsk fare hvis aktørene tror at handlingene deres ikke er beskyttet av eksisterende lover», understreket Jones.

En amerikansk soldat patruljerer med en robothund. Foto: Forbes

Konvensjoner om våpenkontroll Flere store internasjonale avtaler begrenser og regulerer visse bruksområder for våpen. Det finnes forbud mot kjemiske våpen, traktater om ikke-spredning av atomvåpen og Konvensjonen om visse konvensjonelle våpen, som forbyr eller begrenser bruken av spesifikke våpen som anses å forårsake unødvendig eller uberettiget lidelse for krigførende parter eller å påvirke sivile vilkårlig.

«Kontroll av atomvåpen krevde flere tiår med internasjonalt samarbeid og påfølgende traktater for å bli håndhevet», forklarer forsvarsanalytiker Wilson Jones. «Selv da fortsatte vi atmosfæriske tester frem til 1990-tallet. En viktig grunn til at ikke-spredning av atomvåpen var vellykket, var samarbeidet mellom USA og Sovjetunionen i den bipolare verdensordenen. Det eksisterer ikke lenger, og teknologien som skaper kunstig intelligens er mer tilgjengelig for mange land enn kjernekraft.»

«En bindende traktat må bringe alle relevante aktører til bordet for å bli enige om ikke å bruke et verktøy som øker deres militære makt. Det vil neppe fungere fordi AI kan forbedre militær effektivitet til minimale økonomiske og materielle kostnader.»

Nåværende geopolitiske utsikter

Selv om land i FN har erkjent behovet for ansvarlig militær bruk av AI, er det fortsatt mye arbeid som gjenstår.

«Uten et klart regelverk forblir disse påstandene i stor grad ambisiøse», sa Laura Petrone, sjefsanalytiker hos GlobalData, til Army Technology. «Det er ingen overraskelse at noen land ønsker å beholde sin egen suverenitet når de bestemmer seg for saker som gjelder innenriksforsvar og nasjonal sikkerhet, spesielt i det nåværende geopolitiske klimaet.»

Fru Petrone la til at selv om EUs KI-lov setter noen krav til KI-systemer, omhandler den ikke KI-systemer for militære formål.

«Jeg tror at til tross for dette unntaket, er KI-loven et viktig tiltak for å etablere et lenge etterlengtet rammeverk for KI-applikasjoner, noe som kan føre til en viss grad av ensartethet i relevante standarder i fremtiden», kommenterte hun. «Denne ensartetheten vil også være viktig for KI i militæret.»

Nguyen Khanh

[annonse_2]

Kilde: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[Foto] Statsminister Pham Minh Chinh deltar på det årlige Vietnam Business Forum](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762780307172_dsc-1710-jpg.webp)

![[Foto] Statsminister Pham Minh Chinh deltar på den patriotiske emulasjonskongressen i Utenriksdepartementet for perioden 2025–2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762762603245_dsc-1428-jpg.webp)

![Overgang til Dong Nai OCOP: [Artikkel 3] Kobling av turisme med forbruk av OCOP-produkter](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Kommentar (0)