Se você já navegou pelas redes sociais, provavelmente se deparou com imagens ou vídeos criados por IA. Muitas pessoas foram enganadas, como no vídeo viral de coelhos pulando em uma cama elástica. Mas o Sora – um aplicativo irmão do ChatGPT, desenvolvido pela OpenAI – está elevando os vídeos com IA a um novo patamar, tornando a detecção de conteúdo falso cada vez mais urgente.

As ferramentas de IA para vídeo estão tornando mais difícil do que nunca identificar vídeos genuínos. (Fonte: CNET)

Lançado em 2024 e recentemente atualizado com o Sora 2, este aplicativo tem uma interface semelhante à do TikTok, onde todos os vídeos são gerados por inteligência artificial. O recurso "cameo" permite que pessoas reais sejam inseridas em filmagens simuladas, criando vídeos assustadoramente realistas.

Portanto, muitos especialistas temem que o Sora cause a disseminação de deepfakes, distorcendo informações e tornando tênue a linha entre realidade e ficção. Celebridades são particularmente vulneráveis, levando organizações como o SAG-AFTRA a pedir à OpenAI que reforce a proteção contra a pirataria.

Identificar conteúdo gerado por IA é um grande desafio para empresas de tecnologia, plataformas de mídia social e usuários. Mas existem maneiras de reconhecer vídeos criados com o Sora.

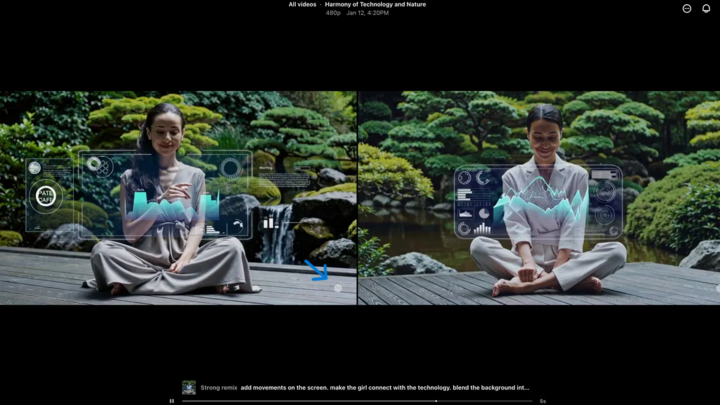

Encontre a marca d'água Sora

A marca d'água Sora (indicada pela seta azul) é um marcador que identifica a ferramenta usada para criar o vídeo. (Fonte: CNET)

Todos os vídeos criados no aplicativo Sora para iOS têm uma marca d'água ao serem baixados – o logotipo branco da Sora (ícone de nuvem) se move ao redor das bordas do vídeo, semelhante à marca d'água do TikTok.

Esta é uma forma visual de identificar conteúdo gerado por IA. Por exemplo, o modelo "nano-banana" Gemini do Google também adiciona automaticamente uma marca d'água às imagens. No entanto, as marcas d'água nem sempre são confiáveis. Se a marca d'água for estática, ela pode ser facilmente recortada. Mesmo marcas d'água dinâmicas, como a do Sora, podem ser removidas usando aplicativos especializados.

Questionado sobre isso, o CEO da OpenAI, Sam Altman, argumentou que a sociedade precisa se adaptar à realidade de que qualquer pessoa pode criar vídeos falsos. Antes do Sora, nunca existiu uma ferramenta tão popular, acessível e que não exigisse nenhuma habilidade para criar tais vídeos. Sua perspectiva destaca a necessidade de se recorrer a métodos alternativos de verificação.

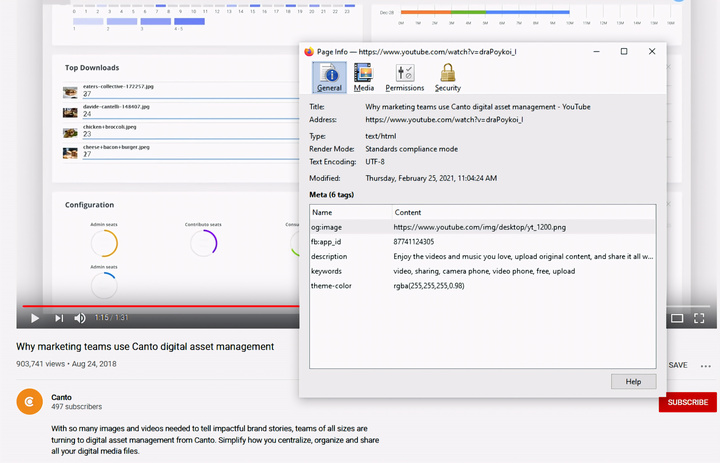

Verificar metadados

Verificar metadados é uma etapa crucial para determinar se um vídeo foi criado por IA, como o Sora. (Fonte: Canto)

Você pode achar que verificar metadados é muito complicado, mas na verdade é bem simples e muito eficaz.

Metadados são um conjunto de informações anexadas automaticamente ao conteúdo quando ele é criado, como tipo de câmera, localização, horário da gravação e nome do arquivo. Independentemente de o conteúdo ser gerado por humanos ou por IA, ele possui metadados. No caso de conteúdo gerado por IA, os metadados geralmente incluem informações de atribuição da fonte.

A OpenAI é membro da Coalizão para Origem e Autenticidade de Conteúdo (C2PA), portanto, os vídeos da Sora contêm metadados C2PA. Você pode verificar isso usando a ferramenta de verificação da iniciativa de autenticidade de conteúdo:

Como verificar os metadados:

- Acesse verify.contentauthenticity.org

- Faça o upload do arquivo para verificação.

- Pressione “Abrir”

- Veja as informações na tabela à direita.

Se o vídeo foi criado por IA, o resumo indicará isso claramente. Ao verificar vídeos do Sora, você verá a frase "publicado pela OpenAI" e informações confirmando que o vídeo foi criado usando IA. Todos os vídeos do Sora devem conter essas informações para que sua origem seja verificada.

Fonte: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Foto] O primeiro-ministro Pham Minh Chinh recebe o ministro da Educação e Esportes do Laos, Thongsalith Mangnormek.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Imagem] Imagens vazadas antes da gala do Community Action Awards de 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Imagem] O espírito de luta tenaz do futebol feminino vietnamita](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F17%2F1765990260956_ndo_br_4224760955870434771-copy-jpg.webp&w=3840&q=75)

![[Foto] O primeiro-ministro Pham Minh Chinh recebe o governador da província de Tochigi (Japão)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Ao vivo] Gala de Premiação de Ação Comunitária 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Ao vivo] Cerimônia de encerramento e entrega de prêmios do concurso de criação de vídeos/clipes "Turismo impressionante do Vietnã" de 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Comentário (0)