(CLO) A ferramenta de conversão de fala em texto Whisper da OpenAI é anunciada como sendo "robusta e precisa quase ao nível humano", mas tem uma grande desvantagem: ela é propensa a fabricar trechos de texto ou até mesmo frases inteiras!

Alguns dos textos que ele fabrica, conhecidos na indústria como alucinatórios, podem incluir comentários raciais, violência e até mesmo tratamentos médicos imaginários, dizem especialistas.

Especialistas dizem que tais invenções são sérias porque o Whisper é usado em muitos setores ao redor do mundo para traduzir e transcrever entrevistas, gerar texto e legendar vídeos.

O mais preocupante é que os centros médicos estão usando ferramentas baseadas no Whisper para registrar consultas entre pacientes e médicos, apesar do aviso da OpenAI de que a ferramenta não deve ser usada em "áreas de alto risco".

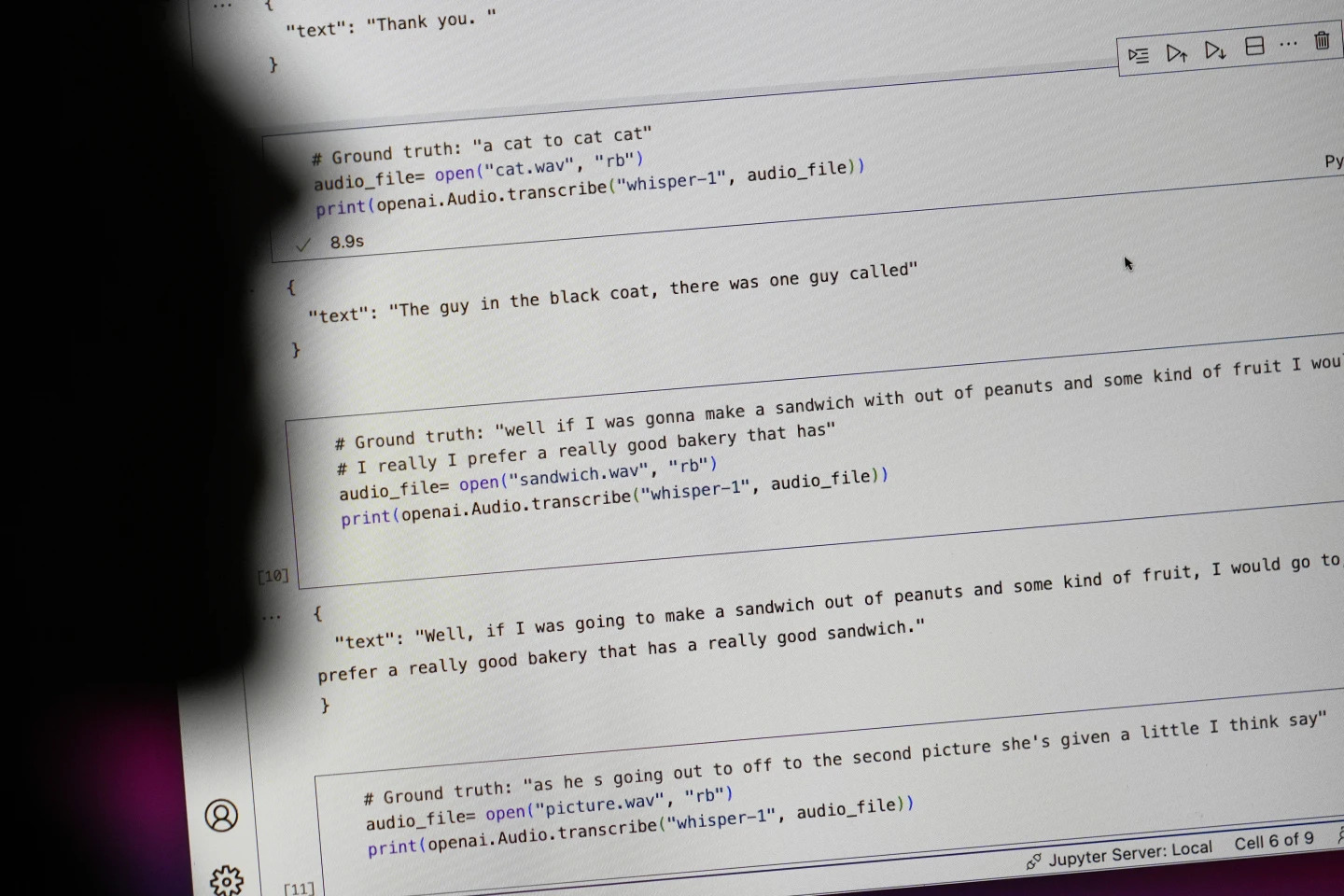

Frases que começam com "#Groundtruth" são o que realmente foi dito, frases que começam com "#text" são o que Whisper transcreveu. Foto: AP

Pesquisadores e engenheiros afirmam que o Whisper frequentemente produz alucinações durante o uso. Por exemplo, um pesquisador da Universidade de Michigan afirmou ter encontrado alucinações em oito de cada 10 gravações que examinou.

Um dos primeiros engenheiros de aprendizado de máquina encontrou manipulação em cerca de metade das mais de 100 horas de transcrições do Whisper que analisou. Um terceiro desenvolvedor disse ter encontrado alucinações em quase todas as 26.000 transcrições criadas com o Whisper.

A ilusão persiste mesmo em amostras de áudio curtas e bem gravadas. Um estudo recente realizado por cientistas da computação encontrou 187 distorções em mais de 13.000 clipes de áudio nítidos que eles examinaram.

Essa tendência levaria a dezenas de milhares de erros em milhões de gravações, disseram os pesquisadores.

Esses erros podem ter “consequências realmente sérias”, especialmente em um ambiente hospitalar, disse Alondra Nelson, professora da Escola de Ciências Sociais do Instituto de Estudos Avançados.

"Ninguém quer ser diagnosticado erroneamente. É preciso haver uma barreira maior", disse Nelson.

As professoras Allison Koenecke, da Universidade Cornell, e Mona Sloane, da Universidade da Virgínia, examinaram milhares de trechos curtos recuperados do TalkBank, um arquivo de pesquisa da Universidade Carnegie Mellon. Elas determinaram que quase 40% das alucinações eram prejudiciais ou perturbadoras, pois o falante poderia ser mal interpretado ou mal interpretado.

Um locutor em uma gravação descreveu "duas outras garotas e uma mulher", mas Whisper inventou comentários raciais adicionais, acrescentando "duas outras garotas e uma mulher, hum, que era negra".

Em outra transcrição, Whisper inventou um medicamento inexistente chamado "antibióticos com atividade aumentada".

Embora a maioria dos desenvolvedores reconheça que ferramentas de transcrição podem conter erros de ortografia ou outros erros, engenheiros e pesquisadores dizem que nunca viram uma ferramenta de transcrição com tecnologia de IA tão alucinógena quanto o Whisper.

A ferramenta está integrada a diversas versões do chatbot principal da OpenAI, o ChatGPT, e é um serviço integrado à plataforma de computação em nuvem da Oracle e da Microsoft, atendendo milhares de empresas em todo o mundo. Também é usada para transcrever e traduzir textos para diversos idiomas.

Ngoc Anh (de acordo com a AP)

[anúncio_2]

Fonte: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

Comentário (0)