O gabinete do Procurador-Geral de New Hampshire anunciou na segunda-feira que está investigando uma possível manipulação de eleitores após denúncias de uma voz falsa, idêntica à do presidente dos EUA, Joe Biden, incentivando os eleitores a não votarem nas primárias do estado.

Os pesquisadores também alertaram para o uso de áudio deepfake para imitar políticos e líderes, com casos notórios ocorrendo em 2023 no Reino Unido, Índia, Nigéria, Sudão, Etiópia e Eslováquia.

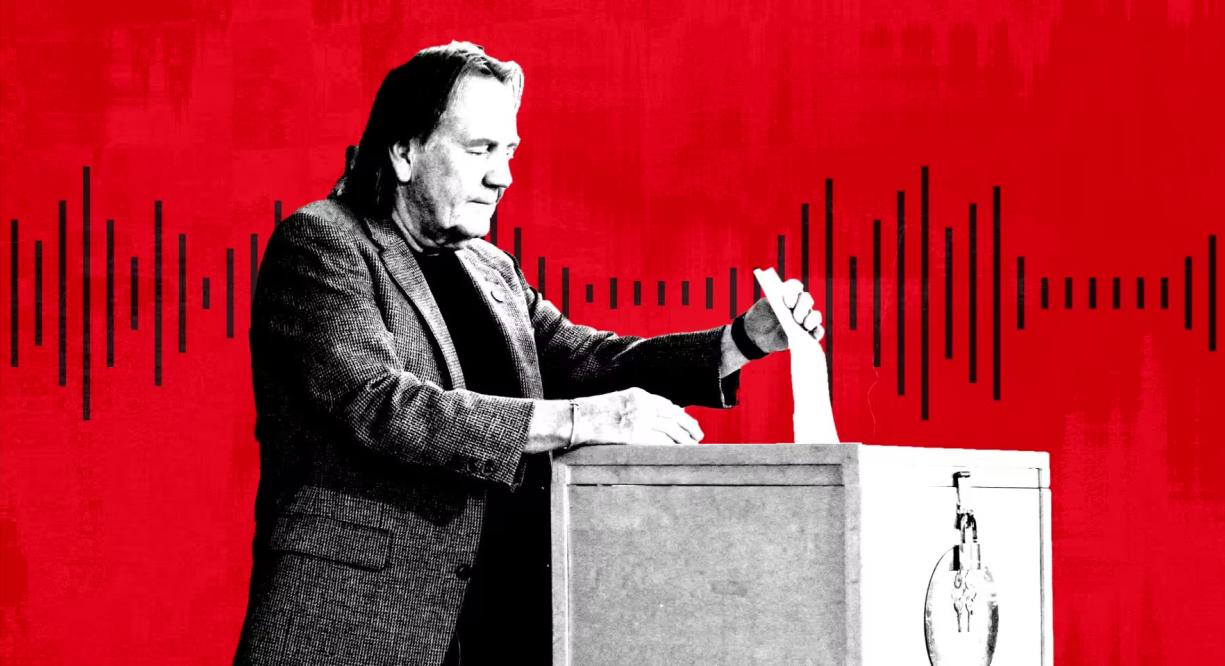

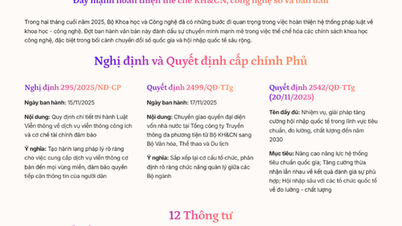

Uma pessoa vota nas eleições primárias em New Hampshire, EUA. Foto: Getty

Segundo especialistas, o áudio deepfake tornou-se uma forma popular de desinformação devido ao surgimento de uma série de ferramentas de IA baratas e eficazes desenvolvidas por startups. A Microsoft também desenvolveu um novo modelo de IA capaz de copiar vozes a partir de apenas três segundos de gravação.

“Quando se trata de manipulação visual, todos estão familiarizados com o Photoshop ou pelo menos sabem que ele existe”, disse Henry Ajder, especialista em IA e deepfake e consultor da Adobe, Meta e EY. “Há muito pouca consciência de como o áudio pode ser manipulado, então, para mim, isso nos deixa muito vulneráveis.”

Em setembro, o NewsGuard, um sistema que avalia a qualidade e a confiabilidade de sites de notícias, descobriu uma rede de contas do TikTok que se passavam por sites de notícias legítimos, usando conteúdo gerado por inteligência artificial para disseminar teorias da conspiração e desinformação política. Gravações deepfake, incluindo a voz do ex-presidente dos EUA Barack Obama, alcançaram centenas de milhões de visualizações.

As dublagens falsas parecem ter sido geradas por uma ferramenta fornecida pela ElevenLabs, apoiada pela Andreessen Horowitz, e os vídeos já acumularam centenas de milhões de visualizações, segundo a NewsGuard.

“Mais de 99% dos usuários em nossa plataforma criam conteúdo interessante, criativo e útil, mas reconhecemos que existem casos de uso indevido e temos desenvolvido e implementado continuamente proteções para limitá-los”, disse a ElevenLabs.

A ElevenLabs, fundada há dois anos pelos ex-funcionários do Google e da Palantir, Piotr Dabkowski e Mati Staniszewski, oferece ferramentas básicas de geração de áudio por IA gratuitamente, com apenas um clique. Os planos de assinatura variam de US$ 1 a US$ 330 por mês, e valores ainda maiores para quem busca serviços mais complexos.

No ano passado, agências de inteligência dos EUA alertaram em um relatório que "os golpes personalizados com IA aumentaram significativamente devido ao lançamento de modelos sofisticados e bem treinados de clonagem de voz por IA".

Além de golpes com motivação financeira, especialistas políticos agora alertam sobre a viralização de áudios deepfake, bem como sobre o uso de deepfakes em ligações automáticas ou campanhas. "É possível construir uma campanha de desinformação poderosa e disseminada visando telefones", afirmou AJ Nash, vice-presidente e pesquisador sênior em inteligência do grupo de cibersegurança ZeroFox.

Algumas dessas empresas têm sido proativas na busca de outras maneiras de combater a desinformação. A Microsoft emitiu uma declaração de ética, incentivando os usuários a denunciarem qualquer uso indevido de sua ferramenta de áudio com IA. A ElevenLabs desenvolveu suas próprias ferramentas de detecção para identificar gravações de áudio criadas por seu sistema.

Durante as eleições nigerianas de 2023, um vídeo manipulado por inteligência artificial viralizou nas redes sociais "supostamente insinuando que um candidato da oposição planejava fraudar a votação", segundo o grupo de direitos humanos Freedom House.

Na Eslováquia, uma gravação de áudio falsa do candidato da oposição Michal Šimečka, aparentemente planejando fraudar as eleições, viralizou poucos dias antes da eleição presidencial do país, em setembro.

“O deepfake de New Hampshire serve como um lembrete das inúmeras maneiras pelas quais os deepfakes podem confundir e enganar”, disse Robert Weissman, presidente da organização sem fins lucrativos de defesa do consumidor Public Citizen. “Chegou a hora dos deepfakes políticos. Os legisladores precisam agir rapidamente para implementar medidas de segurança, ou enfrentaremos o caos eleitoral.”

Mai Anh (de acordo com o FT)

Fonte

![[Foto] Ginseng da Montanha Dan, um presente precioso da natureza para a terra de Kinh Bac](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F30%2F1764493588163_ndo_br_anh-longform-jpg.webp&w=3840&q=75)

Comentário (0)