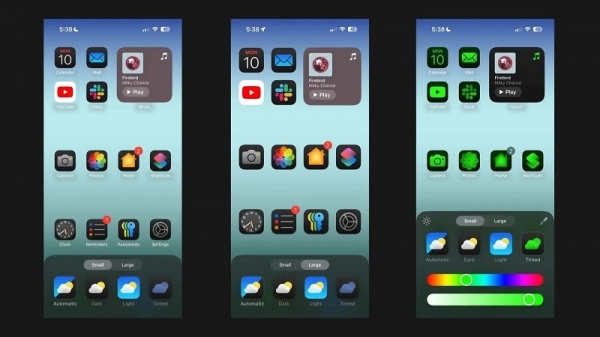

Conform Android Authority , lucrarea de cercetare a Apple detaliază o soluție pentru rularea modelelor lingvistice mari (LLM) pe dispozitive cu RAM limitată. Lucrarea dezvăluie modul în care compania poate stoca „parametrii modelului” și poate încărca o porțiune din aceștia în memoria RAM a dispozitivului atunci când este nevoie, în loc să încarce întregul model în RAM.

Apple încearcă să ajute iPhone-urile mai vechi cu mai puțină memorie RAM să ruleze inteligență artificială generală

Lucrarea susține că această metodă permite rularea unor modele care necesită dublul memoriei RAM față de cea a unui iPhone, asigurând în același timp viteze de inferență de 4-5x și, respectiv, 20-25x în comparație cu metodele simple de încărcare pe CPU și GPU.

Implementarea inteligenței artificiale sintetice pe un dispozitiv cu mai multă memorie RAM ar fi un beneficiu uriaș, deoarece ar permite viteze de citire/scriere mai mari. Viteza este importantă pentru inteligența artificială de pe dispozitiv, permițând timpi de inferență mult mai rapizi, deoarece utilizatorii nu trebuie neapărat să aștepte zeci de secunde (sau mai mult) pentru un răspuns sau un rezultat final. Toate acestea înseamnă că un asistent de inteligență artificială de pe dispozitiv ar putea rula la viteze conversaționale, ar putea genera imagini/text mult mai rapid, ar putea rezuma articole mai rapid etc. Însă soluția Apple înseamnă că utilizatorii nu au neapărat nevoie de multă memorie RAM pentru a accelera viteza de răspuns a sarcinilor de inteligență artificială de pe dispozitiv.

Abordarea Apple ar putea permite iPhone-urilor, atât vechi, cât și noi, să ofere funcții de inteligență artificială direct pe dispozitivele lor. Acest lucru este important deoarece iPhone-urile Apple oferă de obicei mai puțină memorie RAM decât telefoanele Android de ultimă generație. Seria iPhone 11, de exemplu, oferă doar 4 GB de RAM, în timp ce chiar și iPhone 15 obișnuit are doar 6 GB.

Apple nu este singura companie de telefonie mobilă care lucrează la reducerea LLM. Cipurile emblematice recente ale Qualcomm și MediaTek acceptă ambele precizia INT4 pentru a reduce aceste modele. În orice caz, companiile încearcă să găsească noi modalități de a reduce cerințele de sistem pentru inteligența artificială de pe dispozitiv, permițând chiar și telefoanelor low-end să ofere această funcție.

Legătură sursă

![[Foto] Membrii Partidului Noii Ere în „Parcul Industrial Verde”](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/30/1761789456888_1-dsc-5556-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh a prezidat o reuniune de evaluare a funcționării modelului de administrație locală pe două niveluri.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761751710674_dsc-7999-jpg.webp)

![[Fotografie] Dragoste umană în timpul potopului din Hue](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761740905727_4125427122470875256-2-jpg.webp)

![[Foto] Hue: În interiorul bucătăriei care donează mii de mese pe zi oamenilor din zonele inundate](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/29/1761738508516_bepcomhue-jpg.webp)

Comentariu (0)