Inteligența artificială întunecată operează în afara normelor de siguranță, permițând adesea comportamente precum frauda, manipularea, atacurile cibernetice sau extragerea de date fără o supraveghere atentă.

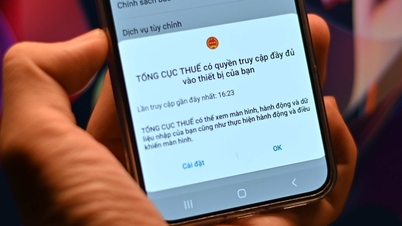

„Actorii rău intenționați folosesc, de asemenea, inteligența artificială pentru a-și îmbunătăți capacitățile de atac. Cel mai frecvent abuz al inteligenței artificiale în prezent este apariția modelelor Black Hat GPT. Acestea sunt modele de inteligență artificială special dezvoltate sau adaptate pentru a servi scopuri ilegale, cum ar fi crearea de programe malware, redactarea de e-mailuri de phishing, crearea de voci și videoclipuri deepfake...”, a declarat Sergey Lozhkin, șeful echipei globale de cercetare și analiză (GReAT) responsabilă pentru Orientul Mijlociu, Turcia, Africa și Asia- Pacific la Kaspersky.

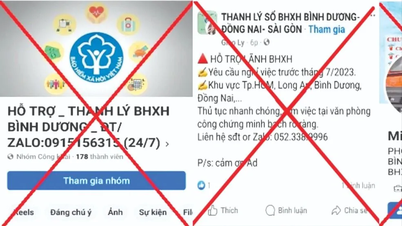

GPT-urile Black Hat pot exista ca modele de inteligență artificială complet private sau semi-private. Câteva exemple notabile includ WormGPT, DarkBard, FraudGPT și Xanthorox... toate concepute pentru criminalitate cibernetică, fraudă și automatizare malițioasă.

Dl. Lozhkin a dezvăluit că experții Kaspersky înregistrează acum o tendință și mai îngrijorătoare, grupurile de atacuri cibernetice susținute de state naționale sau guverne începând să utilizeze modele lingvistice mari (LLM) în campaniile lor de atac.

„OpenAI a anunțat recent că a întrerupt peste 20 de campanii de influență sub acoperire și atacuri cibernetice care exploatau instrumentele sale de inteligență artificială. Vom vedea atacatori din ce în ce mai sofisticați care folosesc inteligența artificială ca arme, reprezentând o amenințare atât în ecosistemele publice, cât și în cele private. Aceasta este o tendință îngrijorătoare pentru care toate organizațiile trebuie să se pregătească”, a spus Lozhkin.

Conform unui raport al OpenAI, actorii rău intenționați au început să exploateze capacitățile modelelor de învățare automată (LLM) de mari dimensiuni pentru a înșela victimele și a ocoli straturile de securitate convenționale. Aceștia pot crea mesaje false convingătoare, pot trimite mesaje victimelor în bloc și pot produce conținut în mai multe limbi.

Pentru a consolida apărarea împotriva amenințărilor Dark AI, experții Kaspersky recomandă: Utilizarea soluțiilor de securitate de ultimă generație, cum ar fi Kaspersky Next, pentru a detecta programele malware generate de inteligența artificială și a controla riscurile din lanțul de aprovizionare. Aplicarea instrumentelor de informații despre amenințări în timp real pentru a monitoriza exploatările bazate pe inteligență artificială. Consolidarea controalelor de acces și a instruirii angajaților pentru a limita Shadow AI și riscul de scurgere de date. Înființarea unui Centru de Operațiuni de Securitate (SOC) pentru a monitoriza amenințările și a răspunde rapid la incidente.

Sursă: https://www.sggp.org.vn/kaspersky-canh-bao-toi-pham-mang-dung-dark-ai-tan-cong-post808493.html

![[Foto] Președintele Luong Cuong și secretarul general al Națiunilor Unite, Antonio Guterres, au prezidat ceremonia de semnare a Convenției de la Hanoi.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761370409249_ndo_br_1-1794-jpg.webp)

Comentariu (0)