Если вы когда-либо просматривали социальные сети, скорее всего, вы сталкивались с изображениями или видео, созданными искусственным интеллектом. Многих обманули, как, например, с вирусным видео, где кролики прыгают на батуте. Но Sora — приложение-близнец ChatGPT, разработанное OpenAI, — выводит видео, созданное с помощью ИИ, на новый уровень, делая обнаружение фейкового контента все более актуальным.

Инструменты искусственного интеллекта для анализа видео затрудняют идентификацию подлинных видеороликов. (Источник: CNET)

Запущенное в 2024 году и недавно обновленное до Sora 2, это приложение имеет интерфейс, похожий на TikTok, где все видео генерируются искусственным интеллектом. Функция «камео» позволяет вставлять реальных людей в смоделированные видеоролики, создавая пугающе реалистичные видео.

Поэтому многие эксперты опасаются, что Sora приведет к распространению дипфейков, искажению информации и размыванию границ между реальностью и вымыслом. Знаменитости особенно уязвимы, поэтому такие организации, как SAG-AFTRA, призывают OpenAI усилить защиту.

Распознавание контента, созданного с помощью ИИ, является серьезной проблемой как для технологических компаний, так и для социальных сетей и пользователей. Но существуют способы распознавания видеороликов, созданных с помощью Sora.

Найдите водяной знак Sora

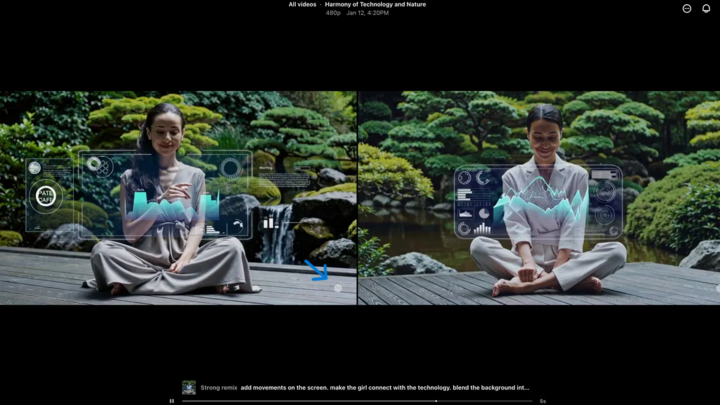

Водяной знак Sora (обозначен синей стрелкой) — это маркер, указывающий на инструмент, использованный для создания видео. (Источник: CNET)

Каждое видео, созданное в приложении Sora для iOS, при загрузке содержит водяной знак – белый логотип Sora (значок облака) перемещается по краям видео, подобно водяному знаку TikTok.

Это визуальный способ идентификации контента, созданного с помощью ИИ. Например, модель «нано-банана» от Google Gemini также автоматически добавляет водяной знак к изображениям. Однако водяные знаки не всегда надежны. Если водяной знак статичный, его легко можно удалить. Даже динамические водяные знаки, такие как у Соры, можно удалить с помощью специализированных приложений.

Отвечая на вопрос по этому поводу, генеральный директор OpenAI Сэм Альтман заявил, что обществу необходимо адаптироваться к реальности, в которой любой может создавать поддельные видеоролики. До появления Sora не существовало инструмента, который был бы настолько популярен, доступен и не требовал бы никаких специальных навыков для создания подобных видео. Его точка зрения подчеркивает необходимость использования альтернативных методов проверки.

Проверьте метаданные

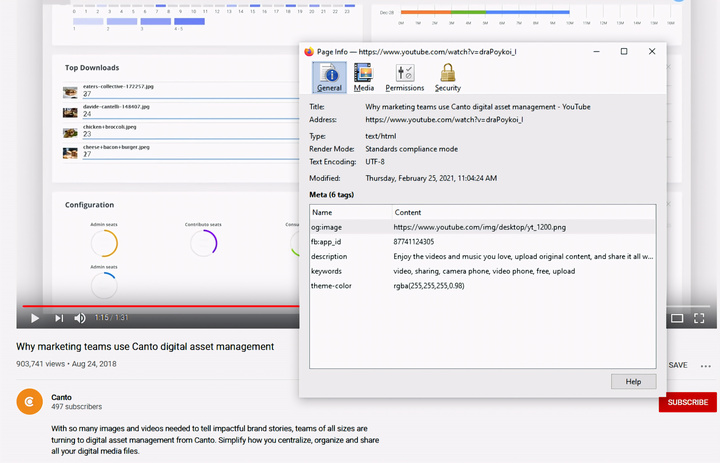

Проверка метаданных — важнейший шаг в определении того, было ли видео создано искусственным интеллектом, например, Sora. (Источник: Canto)

Возможно, вам покажется, что проверка метаданных слишком сложна, но на самом деле это довольно просто и очень эффективно.

Метаданные — это набор информации, автоматически добавляемой к контенту при его создании, например, тип камеры, местоположение, время записи и имя файла. Независимо от того, создан ли контент человеком или искусственным интеллектом, он содержит метаданные. В случае контента, созданного искусственным интеллектом, метаданные часто включают информацию об источнике.

OpenAI является членом Коалиции за происхождение и подлинность контента (C2PA), поэтому видеоролики Sora будут содержать метаданные C2PA. Вы можете проверить это с помощью инструмента проверки подлинности контента:

Как проверить метаданные:

- Посетите verify.contentauthenticity.org

- Загрузите файл для проверки.

- Нажмите «Открыть»

- См. информацию в таблице справа.

Если видео создано с помощью ИИ, это будет четко указано в описании. При проверке видео Соры вы увидите строку «опубликовано OpenAI» и информацию, подтверждающую, что видео создано с использованием ИИ. Все видео Соры должны содержать эту информацию для подтверждения их происхождения.

Источник: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Фото] Премьер-министр Фам Минь Чинь принимает министра образования и спорта Лаоса Тонгсалит Мангнормек.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Фото] Премьер-министр Фам Минь Чинь принимает губернатора провинции Тотиги (Япония)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Прямая трансляция] Гала-церемония вручения наград за общественную деятельность 2025 года](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Изображение] Утекшие в сеть фотографии в преддверии гала-церемонии вручения премии Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Прямая трансляция] Церемония закрытия и вручение наград победителям конкурса видеороликов/клипов «Впечатляющий туризм во Вьетнаме 2025».](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Комментарий (0)