После того, как стартап OpenAI запустил свое первое приложение на основе ИИ, ChatGPT, в конце 2022 года, началась волна разработки приложений ИИ, особенно генеративного ИИ, принесшая множество преимуществ во все аспекты жизни. Однако это также сопряжено со многими рисками.

Вторжение в частную жизнь

В последние годы многие организации и частные лица понесли значительные убытки, поскольку киберпреступники используют искусственный интеллект для создания поддельных видеороликов , имитирующих изображения и голоса реальных людей. Ярким примером этого является мошенничество с использованием технологии Deepfake, при котором человека обманом заставляют поверить, что он настоящий.

Согласно отчету Sumsub о мошенничестве с личными данными, опубликованному в конце ноября 2023 года, количество случаев мошенничества с использованием дипфейков в мире увеличилось в десять раз за два года с 2022 по 2023 год. В этот же период во всем мире резко возросло количество приложений, созданных с помощью искусственного интеллекта.

Компания Status Labs отмечает, что технология Deepfake оказала значительное влияние на культуру, конфиденциальность и личную репутацию. Большая часть новостей и внимания, связанных с Deepfake, сосредоточена на порнографии с участием знаменитостей, контенте, распространяемом из мести, дезинформации, фейковых новостях, шантаже и мошенничестве. Например, в 2019 году американская энергетическая компания была обманута на 243 000 долларов хакерами, которые выдавали себя за руководителей компании и использовали их голоса, требуя от сотрудников перевести деньги партнерам.

Агентство Reuters сообщило, что в 2023 году в социальных сетях по всему миру было распространено около 500 000 видео- и аудиофайлов, созданных с помощью технологии Deepfake. Помимо Deepfake, создаваемых ради развлечения, существуют также мошеннические схемы, разработанные злоумышленниками для обмана общественности. Некоторые источники указывают, что в 2022 году ущерб от мошенничества с использованием Deepfake во всем мире составил около 11 миллионов долларов.

Многие эксперты в области технологий предупреждают о недостатках ИИ, включая проблемы с правами интеллектуальной собственности и подлинностью, а также споры об интеллектуальной собственности между «произведениями», созданными ИИ. Например, кто-то может использовать ИИ для создания картины на определенную тему, а другой человек может использовать ИИ для того же самого, в результате чего получатся картины, во многом похожие друг на друга.

Это легко приводит к спорам о правах собственности. Однако до настоящего времени мир еще не принял решения о признании авторских прав на контент, созданный с помощью ИИ (признание авторских прав для частных лиц, заказывающих создание контента с помощью ИИ, или для компаний, разрабатывающих приложения на основе ИИ).

Изображение, созданное с помощью приложения искусственного интеллекта.

Отличить подлинное от подделки довольно сложно.

Итак, может ли контент, созданный с помощью ИИ, нарушать авторские права? С технологической точки зрения, контент, созданный ИИ, синтезируется алгоритмами на основе данных, на которых они были обучены. Эти базы данных собираются разработчиками приложений ИИ из различных источников, в основном из обширной базы знаний в интернете. Многие из этих произведений уже защищены авторскими правами их владельцев.

27 декабря 2023 года газета The New York Times подала иск против OpenAI (совместно с ChatGPT) и Microsoft, утверждая, что миллионы её статей были использованы для обучения чат-ботов и платформ искусственного интеллекта этих двух компаний. В качестве доказательств был представлен контент, сгенерированный чат-ботами по запросу пользователя, который был похож или идентичен содержанию статей. Газета не могла игнорировать тот факт, что её интеллектуальная собственность использовалась этими компаниями в целях получения прибыли.

«Нью-Йорк Таймс» стала первой крупной американской газетой, подавшей иск о нарушении авторских прав, связанных с искусственным интеллектом. Вполне возможно, что и другие газеты подадут иски в будущем, особенно после успеха дела «Нью-Йорк Таймс».

Ранее, в июле 2023 года, OpenAI заключила лицензионные соглашения с Associated Press, а в декабре 2023 года — с Axel Springer, немецким издательством, владеющим Politico и Business Insider.

Актриса Сара Сильверман также оказалась замешана в нескольких судебных процессах в июле 2023 года, утверждая, что Meta и OpenAI использовали ее мемуары в качестве учебного материала для программ искусственного интеллекта. Многие писатели также выразили обеспокоенность после того, как стало известно, что системы искусственного интеллекта включили десятки тысяч книг в свои базы данных, что привело к судебным искам со стороны таких авторов, как Джонатан Франзен и Джон Гришам.

Тем временем компания Getty Images, предоставляющая фотоуслуги, также подала в суд на компанию, занимающуюся искусственным интеллектом, за создание изображений на основе текстовых подсказок, предположительно путем несанкционированного использования защищенных авторским правом изображений компании.

Пользователи могут столкнуться с проблемами авторского права, если будут «небрежно» использовать «произведения», созданные ими по заказу с помощью инструментов искусственного интеллекта. Эксперты всегда рекомендуют использовать инструменты ИИ только для исследований, сбора данных и предоставления рекомендаций в справочных целях.

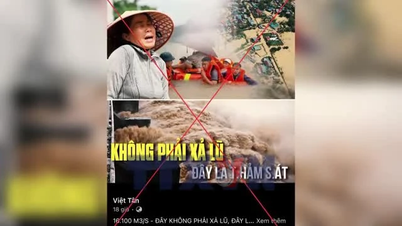

С другой стороны, приложения ИИ вводят пользователей в заблуждение, затрудняя различение подлинного и поддельного контента. Издатели и редакции могут быть озадачены, получая рукописи. Преподаватели также сталкиваются с трудностями в определении того, использовался ли ИИ в работах учащихся.

Теперь сообществу придётся проявлять большую бдительность, поскольку отличить настоящий контент от поддельного стало сложно. Например, обычному человеку будет трудно определить, была ли фотография отредактирована или изменена искусственным интеллектом.

Необходимо разработать правовые нормы, регулирующие использование искусственного интеллекта.

В ожидании разработки инструментов, способных обнаруживать вмешательство ИИ, регулирующим органам необходимо установить четкие и конкретные правовые нормы, касающиеся использования этой технологии для создания оригинального контента. Эти нормы должны четко указывать общественности, какой контент или произведения были обработаны ИИ, например, по умолчанию добавлять водяной знак к изображениям, обработанным ИИ.

Источник: https://nld.com.vn/mat-trai-cua-ung-dung-tri-tue-nhan-tao-196240227204333618.htm

![[Фото] Генеральный секретарь То Лам посещает выставочное пространство, где представлены книги, фотовыставки и достижения цифровой трансформации в журналистике.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766110879215_1766110240024-jpg.webp&w=3840&q=75)

![[Фото] Очаровательный старинный розовый сад на склоне горы в Нгеане](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766109900916_vuon-hong-chin-do-thu-hut-du-khach-toi-check-in-o-ha-noi-3-20162778-1671624890024-1671624890104198100259.jpeg&w=3840&q=75)

![[ИНФОГРАФИКА] Обзор проекта строительства завода по производству рельсов и специальной стали в Хоа Пхат Дунг.](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/19/1766111183203_z7339170069817-126a3e5a095f62e606a0be41015c1b80.jpeg)

Комментарий (0)