Пришло время каждому пользователю стать «цифровым щитом», проявляя бдительность, внимательность и ответственность при каждом клике и публикации.

Преимущества и тонкая грань искусственного интеллекта

Никогда прежде искусственный интеллект не был так близок к повседневной жизни. Всего несколькими щелчками мыши и короткой командой мы можем создавать голоса, изображения и даже видео с поразительной реалистичностью. ИИ экономит время, снижает затраты на производство контента и открывает эру гибких цифровых медиа.

Однако именно эта способность «имитировать реальность реалистичным образом» стала палкой о двух концах. В последнее время социальные сети наводнены видеороликами, созданными с использованием технологии дипфейк, в которых лица руководителей полиции и изображения сотрудников правоохранительных органов, участвующих в деликатных делах, искажаются и дополняются закадровым голосом, чтобы ввести общественность в заблуждение и разделить её.

Подобные постановочные изображения становятся все более распространенными в социальных сетях.

В вирусном ролике в TikTok изображения дежурного сотрудника дорожной полиции были сопоставлены с оскорбительными комментариями и хэштегом #штрафы_на_показуху, подразумевая, что полицейский злоупотребил своей властью в личных целях. Многие пользователи, особенно молодежь, легко поверили этому контенту, потому что визуальные эффекты были очень реалистичными, а голос точно соответствовал движениям губ, что делало крайне сложным отличить реальность от подделки.

Молодой ютубер из Дьенбьена , просто желая «похвастаться» своими навыками в области технологий искусственного интеллекта, поплатился административным штрафом и вынужденными публичными извинениями. Днём 24 января полиция провинции Дьенбьен объявила, что Департамент кибербезопасности и предотвращения высокотехнологичных преступлений наложил на Тонг Ван Т. (род. 2001 г.р., проживает в районе Муонг Анг) административный штраф в размере 7,5 миллионов донгов за использование ИИ для создания сфабрикованного видеоролика, содержащего искажённую и оскорбительную информацию о сотрудниках дорожной полиции.

В частности, 7 января Т. загрузила на свой YouTube-канал "Tuyen Vlog" видео продолжительностью более 3 минут с шокирующим названием: "Меня преследовала дорожная полиция, когда я была на улице". В ролике изображения и ситуации были инсценированы с использованием технологии искусственного интеллекта, имитирующей погоню дорожных полицейских за гражданами, и были дополнены эффектами и комментариями, которые носили оскорбительный и клеветнический характер по отношению к правоохранительным органам.

В сотрудничестве с полицией Т. признал, что всё содержание видеоролика было сфабриковано в «развлекательных» целях и для демонстрации его способности использовать технологии искусственного интеллекта. Помимо штрафа, власти обязали Т. удалить ложное видео и публично извиниться перед дорожной полицией на своём личном канале YouTube.

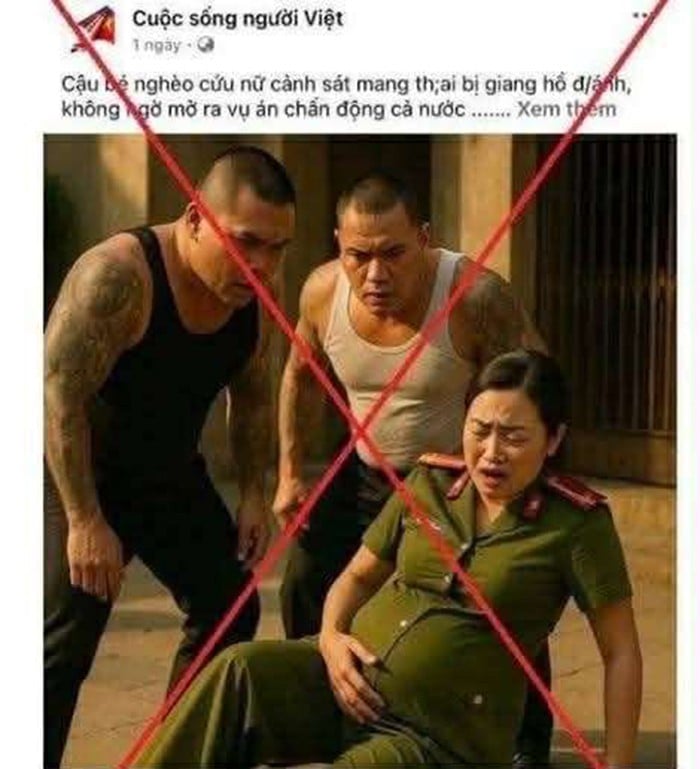

В эпоху цифровой революции , особенно стремительного развития искусственного интеллекта, враждебные и реакционные силы без колебаний используют этот инструмент для создания сфабрикованных изображений и историй, направленных на искажение и очернение имиджа Народной полиции Вьетнама. Фотография, недавно распространившаяся в социальных сетях, на которой изображена беременная женщина в полицейской форме, которой угрожают двое мужчин «бандитской» внешности, является ярким доказательством этой тактики.

Изображение, созданное с помощью искусственного интеллекта, недавно стало вирусным в социальных сетях.

На первый взгляд, зрители легко могут принять это за реальную сцену, сопровождаемую сенсационными заголовками вроде: «Бедный парень спасает беременную женщину-полицейскую от нападения бандитов, неосознанно раскрывая дело, которое шокирует всю страну…». Однако на самом деле это всего лишь постановочная сцена, возможно, из фильма или развлекательного продукта, или, что еще хуже, изображение, созданное искусственным интеллектом, чтобы обмануть эмоции читателя, вызвав у него жалость и сомнения в подлинности действий правоохранительных органов.

Что еще более тревожно, распространение подобного контента не только наносит ущерб репутации и имиджу Народной полиции, которая днем и ночью работает над обеспечением безопасности и порядка в обществе, но и представляет собой изощренную форму психологической войны. Когда доверие народа к властям подрывается обманчивыми изображениями, скрытые мотивы враждебных сил, направленные на раскол национального единства, постепенно реализуются.

Поэтому каждый гражданин должен проявлять бдительность, развивать навыки критического мышления и умение распознавать ложную информацию, а также решительно разоблачать и опровергать ложный контент, способствуя защите идеологических основ и поддержанию социальной стабильности перед лицом нынешней волны вредоносной информации в интернете.

В Хошимине в социальных сетях неожиданно распространился почти минутный видеоролик, на котором человек в полицейской форме «принуждает» подозреваемого признаться в нарушении правил дорожного движения в офисе. На видео человек, предположительно полицейский, демонстрирует агрессивное поведение, постоянно кричит и даже использует грубую лексику, вызывая общественное возмущение.

Однако вскоре после того, как видеоролик стал вирусным, полиция Хошимина быстро провела расследование и подтвердила, что это был сложный дипфейк. Согласно их выводам, лица на видео были извлечены из записи внутреннего полицейского совещания, а затем изменены злоумышленниками с помощью технологии искусственного интеллекта, чтобы наложить их на постановочную сцену, заставив зрителей поверить, что это реальное событие.

В частности, прилагаемая аудиозапись содержит угрожающие и оскорбительные голоса, которые на самом деле не являются подлинными словами каких-либо официальных лиц, а представляют собой синтезированные голоса искусственного интеллекта, запрограммированные и отредактированные таким образом, чтобы обмануть эмоции зрителя.

Этот инцидент является ярким примером использования технологии дипфейков для искажения и дискредитации Народной полиции — тактики, все чаще применяемой реакционными и подрывными силами в киберпространстве. Важно отметить, что, если подобные поддельные материалы не будут оперативно разоблачены, это может привести к серьезным последствиям: подрыву доверия к правоохранительным органам, разжиганию сопротивления в обществе и распространению ложных сведений. Это служит четким предупреждением о неотложной необходимости усиления коммуникационных возможностей для опровержения, выявления и борьбы с фейковыми новостями и призывает каждого гражданина проявлять бдительность и воздерживаться от поспешного распространения или комментирования непроверенного контента из официальных источников.

В другом недавнем случае, связанном с нарушениями в центре технического осмотра транспортных средств на юге страны, враждебно настроенные элементы распространили фейковое видео, в котором руководитель провинциальной полиции выступает в защиту коррумпированных чиновников. Этот ролик, распространенный в Telegram и социальных сетях под заголовком «поддержан влиятельными силами», на самом деле был создан искусственным интеллектом и не фигурировал ни на каких пресс-конференциях или в официальных документах.

В интернете незаметно распространяется опасная тенденция: злоумышленники используют технологии искусственного интеллекта для создания поддельных видеороликов с целью мошенничества и вымогательства. В последнее время многие люди стали жертвами, когда их изображения, особенно изображения уважаемых в обществе людей, таких как юристы, врачи и бизнесмены, накладывались на видеоролики, рекламирующие «возврат денег, потерянных в результате онлайн-мошенничества».

В этих видеороликах искусственный интеллект имитирует голос и лицо юристов, заставляя зрителей поверить мошенникам и легко предоставлять им личную информацию или переводить деньги. Еще опаснее то, что некоторые злоумышленники используют технологию дипфейков, чтобы накладывать лица жертв на видео сексуального характера, а затем отправлять их супругам или коллегам с целью угрожать им или принуждать их к переводу денег в обмен на молчание.

В марте 2025 года произошёл шокирующий инцидент, когда в Ханое жертву потребовали перевести десятки миллионов донгов после получения поддельного видео интимного характера с её участием. Тем временем в Хошимине другого человека шантажировали на 2 миллиарда донгов, требуя выплаты компенсации за распространение видео интимного характера. Министерство общественной безопасности начало расследование, выявив несколько транснациональных преступных группировок, в основном из Китая и Юго-Восточной Азии, стоящих за этими сетями, которые использовали одноразовые SIM-карты, электронные кошельки и социальные сети для сокрытия своей личности.

Это уже не мелкая афера, а форма «высокотехнологичной психологической войны», глубоко эксплуатирующая страх перед честью и социальными связями для оказания давления на жертв. Без повышенной бдительности и навыков распознавания необычной информации и поведения любой может стать жертвой этих высокотехнологичных преступников. Перед лицом этой изощренной волны мошенничества каждый гражданин должен быть бдительным, категорически воздерживаться от необдуманного распространения личной информации и быть готовым выступать против незаконной деятельности, способствуя защите собственной безопасности и безопасности общества.

Для борьбы с угрозой дипфейков необходим «цифровой щит» со стороны сообщества.

Согласно данным Департамента телерадиовещания и электронной информации (Министерство культуры, спорта и туризма), в 2024 году цифровые платформы во Вьетнаме были вынуждены удалить более 4000 видеороликов, содержащих ложную и искаженную информацию, большинство из которых были созданы с использованием технологий искусственного интеллекта, таких как дипфейки и голосовые клоны. Только TikTok — платформа, популярная среди молодежи, — получила указание удалить более 1300 дипфейк-роликов, в основном связанных с полицией, правительством и социальной политикой.

В эпоху технологического бума искусственный интеллект открывает революционные возможности, но он также несет в себе беспрецедентные опасности, особенно продукты типа «дипфейк», содержащие искаженный контент, который подрывает репутацию государственных учреждений. Опрос, проведенный Институтом медиаисследований MICRI, показывает, что 62% пользователей социальных сетей во Вьетнаме не могут отличить реальную информацию от фейковой без предупреждений со стороны основных СМИ или властей. Это «когнитивный пробел», который злоумышленники активно используют для распространения дезинформации и нарушения социальной психологии.

Тонг Ван Т. в полицейском участке.

По словам генерал-майора, доцента и доктора До Кань Тхина, эксперта в области криминологии, использование ИИ для создания поддельных видеороликов, имитирующих лидеров, редактирования ложных заявлений или искажения профессиональных действий полиции, является новой, но особенно опасной тактикой. «Дипфейк — это не просто развлекательный продукт, а форма современной информационной войны, способная подорвать доверие, вызвать социальную нестабильность и которую очень трудно контролировать», — заявил генерал-майор До Кань Тхин.

В действительности, видеоролики, созданные с помощью ИИ, далеко не безобидны; они часто затрагивают деликатные темы, такие как рассмотрение нарушений, расследование преступлений и борьба с коррупцией, вызывая у общественности путаницу и недоверие к правоохранительным органам. Еще более тревожно то, что многие видео распространяются на крупных платформах, таких как YouTube и TikTok, набирая сотни тысяч просмотров, прежде чем быть удаленными, создавая негативный цепной эффект.

Эксперт по цифровым медиа Хоанг Минь предупреждает: «Всего один неосторожный репост или лайк может превратить вас в соучастника распространения фейковых новостей. Каждый пользователь интернета должен понимать, что действия в цифровом пространстве также имеют реальные последствия».

В этом контексте как никогда необходимо создать «цифровой щит» внутри самого общества: то есть, бдительность, информационную неуязвимость и чувство ответственности перед онлайн-средой. Технология может быть нейтральной, но то, как люди её используют, определит, станет ли ИИ движущей силой развития или разрушительной силой, подрывающей общественное доверие. Поддержание идеологической стойкости и защита имиджа полицейского — это защита основ национальной безопасности, задача не только для соответствующих органов власти, но и для каждого гражданина в цифровую эпоху.

Источник: https://baolangson.vn/tinh-hai-mat-cua-ai-5050403.html

![ОПК во время сезона Тет: [Часть 3] Ультратонкая рисовая бумага набирает популярность.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F402x226%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F01%2F28%2F1769562783429_004-194121_651-081010.jpeg&w=3840&q=75)

Комментарий (0)