Якщо ви коли-небудь переглядали соціальні мережі, то, ймовірно, натрапляли на зображення чи відео, створені штучним інтелектом. Багатьох людей обдурили, як-от вірусне відео кроликів, що стрибають на батуті. Але Sora – додаток, що є дочірнім до ChatGPT, розроблений OpenAI, – виводить відео за допомогою штучного інтелекту на новий рівень, роблячи виявлення фейкового контенту дедалі актуальнішим.

Інструменти штучного інтелекту для відео роблять ідентифікацію справжніх відео складнішою, ніж будь-коли. (Джерело: CNET)

Запущений у 2024 році та нещодавно оновлений за допомогою Sora 2, цей додаток має інтерфейс, схожий на TikTok, де всі відео генеруються штучним інтелектом. Функція «камео» дозволяє вставляти реальних людей у зимовані кадри, створюючи відео, які лякаюче реалістичні.

Тому багато експертів побоюються, що Sora спричинить поширення діпфейків, спотворюючи інформацію та розмиваючи межі між реальністю та фейком. Особливо вразливі знаменитості, що спонукає такі організації, як SAG-AFTRA, закликати OpenAI посилити захист.

Ідентифікація контенту, згенерованого штучним інтелектом, є серйозною проблемою як для технологічних компаній, платформ соціальних мереж, так і для користувачів. Але існують способи розпізнавання відео, створених за допомогою Sora.

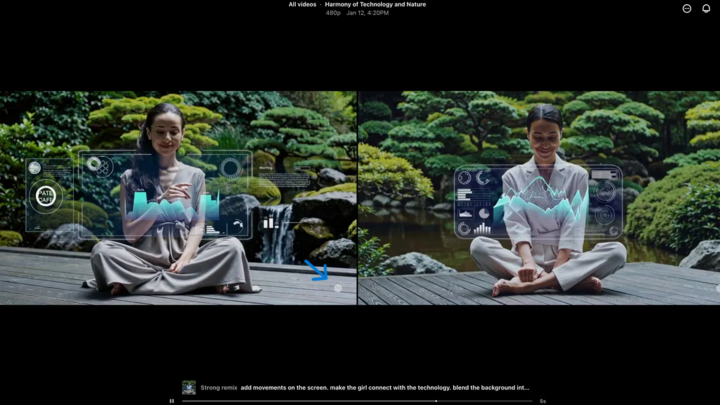

Знайти водяний знак Сори

Водяний знак Sora (позначений синьою стрілкою) – це маркер, який ідентифікує інструмент, використаний для створення відео. (Джерело: CNET)

Кожне відео, створене в додатку Sora для iOS, має водяний знак після завантаження – білий логотип Sora (значок хмари) рухається по краях відео, подібно до водяного знака TikTok.

Це візуальний спосіб ідентифікації контенту, згенерованого штучним інтелектом. Наприклад, модель Google Gemini «нано-банан» також автоматично додає водяний знак до зображень. Однак водяні знаки не завжди надійні. Якщо водяний знак статичний, його можна легко обрізати. Навіть динамічні водяні знаки, такі як у Sora, можна видалити за допомогою спеціалізованих програм.

Коли генерального директора OpenAI Сема Альтмана запитали про це, він стверджував, що суспільству потрібно адаптуватися до реальності, що будь-хто може створювати фальшиві відео. До появи Sora не існувало інструменту, який би був настільки популярним, доступним і не вимагав навичок для створення таких відео. Його точка зору підкреслює необхідність покладатися на альтернативні методи перевірки.

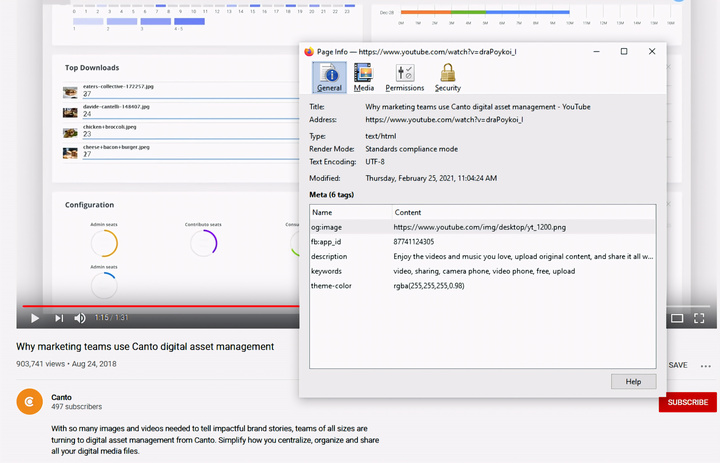

Перевірити метадані

Перевірка метаданих – вирішальний крок у визначенні того, чи було відео створено штучним інтелектом, таким як Sora. (Джерело: Canto)

Ви можете подумати, що перевірка метаданих надто складна, але насправді це досить просто та дуже ефективно.

Метадані – це набір інформації, яка автоматично додається до контенту під час його створення, як-от тип камери, місцезнаходження, час запису та ім'я файлу. Незалежно від того, чи контент створений людиною, чи штучним інтелектом, він має метадані. У контенті, створеному штучним інтелектом, метадані часто містять інформацію про атрибуцію джерела.

OpenAI є членом Коаліції за походження та автентичність контенту (C2PA), тому відео Sora міститимуть метадані C2PA. Ви можете перевірити це за допомогою інструмента перевірки ініціативи щодо автентичності контенту:

Як перевірити метадані:

- Відвідайте verify.contentauthenticity.org

- Завантажте файл для перевірки.

- Натисніть «Відкрити»

- Дивіться інформацію в таблиці праворуч.

Якщо відео було створено штучним інтелектом, у короткому описі це буде чітко зазначено. Перевіряючи відео Sora, ви побачите рядок «опубліковано OpenAI» та інформацію, що підтверджує створення відео за допомогою штучного інтелекту. Усі відео Sora повинні містити цю інформацію для перевірки їхнього походження.

Джерело: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Фото] Прем'єр-міністр Фам Мінь Чінь приймає губернатора провінції Точіґі (Японія)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Фото] Прем'єр-міністр Фам Мінь Чінь приймає міністра освіти та спорту Лаосу Тонгсаліта Мангнормека](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Жива трансляція] Церемонія нагородження громадських дій 2025 року](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Зображення] Злиті зображення напередодні урочистої церемонії нагородження Community Action Awards 2025 року.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Пряма трансляція] Церемонія закриття та вручення нагород конкурсу відео/кліпів «Вражаючий туризм у В'єтнамі» 2025 року](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Коментар (0)