Технологічний гігант OpenAI рекламував свій інструмент для перетворення мовлення в текст, Whisper, як штучний інтелект з «точністю та надійністю, подібними до людської». Але Whisper мав один суттєвий недолік: він генерував текст і речення, які були повністю фальшивими.

Деякий текст, згенерований штучним інтелектом, який називається «галюцинаціями», може містити расистські коментарі, агресивну лексику та навіть уявні методи лікування – Фото: AP

За словами експертів, деякі тексти, згенеровані штучним інтелектом, є так званими «галюцинаторними», зокрема расистські коментарі, насильницька лексика та навіть уявні медичні процедури.

Високий рівень «ілюзії» в текстах, згенерованих штучним інтелектом

Експерти особливо стурбовані тим, що Whisper широко використовується в багатьох галузях промисловості по всьому світу для перекладу та транскрибування інтерв'ю, генерації тексту в популярних споживчих технологіях та створення субтитрів для відео.

Ще більш тривожним є те, що багато медичних центрів використовують Whisper для передачі консультацій між лікарями та пацієнтами, хоча OpenAI попереджає, що цей інструмент не слід використовувати в зонах «високого ризику».

Повні масштаби проблеми важко визначити, але дослідники та інженери кажуть, що вони регулярно стикаються з «галюцинаціями» Whisper у своїй роботі.

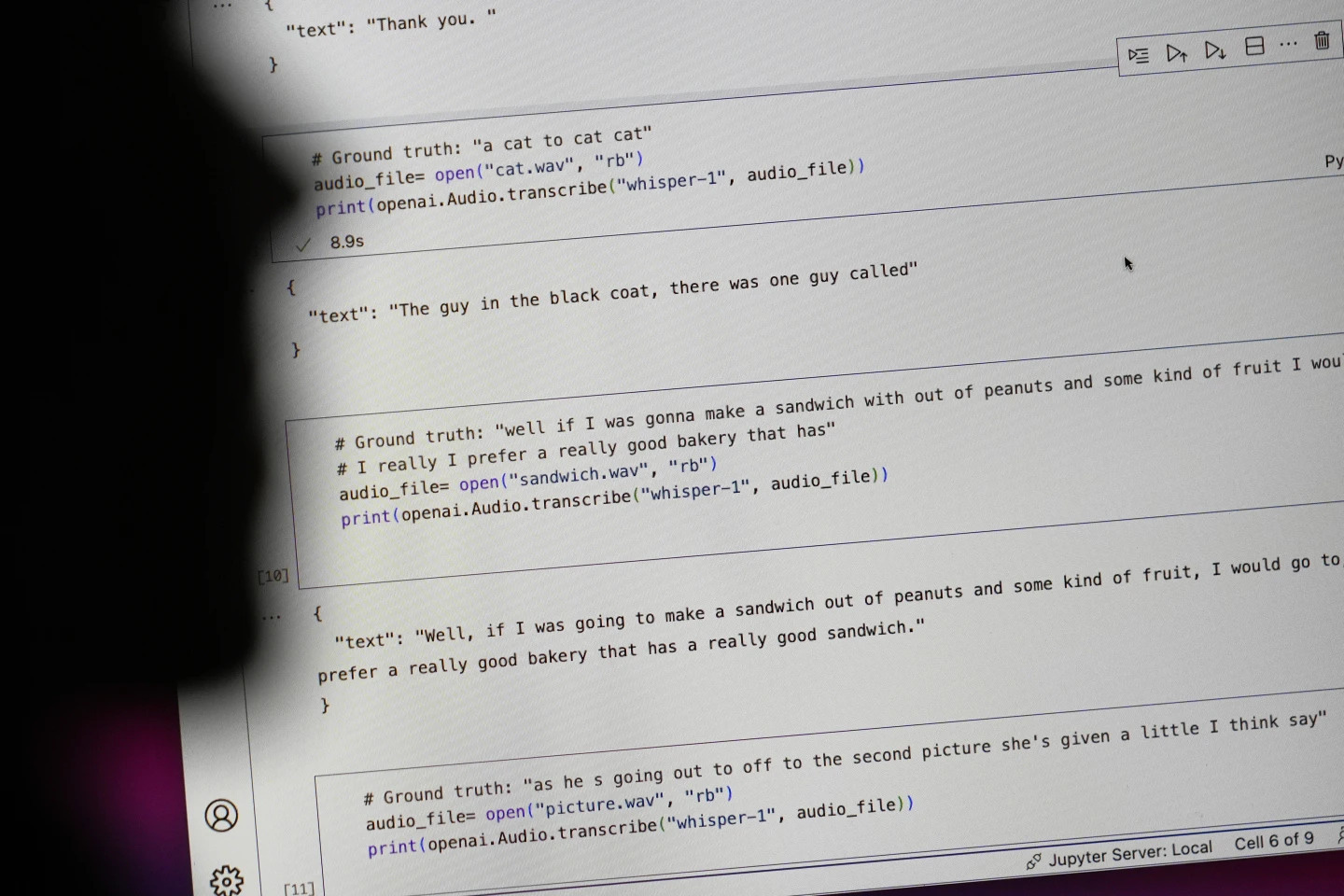

Дослідник з Мічиганського університету заявив, що виявив «галюцинації» у восьми з десяти аудіотранскриптів, які він дослідив. Комп'ютерний інженер виявив «галюцинації» приблизно в половині транскриптів понад 100 годин аудіо, які він проаналізував. Інший розробник сказав, що виявив «галюцинації» майже у всіх з 26 000 записів, які він створив за допомогою Whisper.

Проблема зберігається навіть із короткими, чітко записаними аудіосемплами. Нещодавнє дослідження, проведене вченими-комп'ютерниками, виявило 187 «ілюзій» у понад 13 000 чітких аудіокліпах, які вони вивчили. За словами дослідників, ця тенденція призведе до десятків тисяч хибних транскрипцій у мільйонах записів.

Такі помилки можуть мати «дуже серйозні наслідки», особливо в лікарнях, за словами Алондри Нельсон, яка до минулого року очолювала Управління науки і технологій Білого дому в адміністрації Байдена.

«Ніхто не хоче неправильного діагнозу», — сказав Нельсон, нині професор Інституту перспективних досліджень у Принстоні, штат Нью-Джерсі. «Потрібен вищий стандарт».

Whisper також використовується для створення субтитрів для глухих та слабочуючих — групи населення, яка особливо схильна до неправильного перекладу. Це пояснюється тим, що глухі та слабочуючи люди не мають можливості розпізнати вигадані уривки, «приховані в усьому іншому тексті», каже Крістіан Воглер, глухий та директор Програми доступності технологій в Університеті Галлодета.

OpenAI покликаний вирішити проблему

Поширеність таких «галюцинацій» спонукала експертів, прихильників та колишніх співробітників OpenAI закликати федеральний уряд розглянути питання про регулювання ШІ. Як мінімум, OpenAI має усунути цей недолік.

«Цю проблему можна вирішити, якщо компанія готова надати їй пріоритет», — сказав Вільям Сондерс, інженер-дослідник із Сан-Франциско, який залишив OpenAI у лютому через побоювання щодо напрямку розвитку компанії.

«Це буде проблема, якщо ви випустите це, і люди настільки впевнені в тому, що це може, що інтегрують це в усі ці інші системи». Речник OpenAI сказав, що компанія постійно працює над способами пом’якшення «ілюзій» і цінує висновки дослідників, додавши, що OpenAI враховує зворотний зв’язок в оновленнях моделей.

Хоча більшість розробників вважають, що інструменти перетворення тексту в мовлення можуть допускати друкарські помилки чи інші помилки, інженери та дослідники кажуть, що вони ніколи не бачили інструмента перетворення тексту в мовлення на базі штучного інтелекту, який би «галюцинував» так сильно, як Whisper.

Нобелівська премія з фізики 2024 року: люди, які заклали основи штучного інтелекту

Нобелівська премія з фізики 2024 року: люди, які заклали основи штучного інтелектуДжерело: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Фото] Прем'єр-міністр Фам Мінь Чінь головує на онлайн-конференції уряду з місцевими громадами](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/5/264793cfb4404c63a701d235ff43e1bd)

![[Фото] Прем'єр-міністр Фам Мінь Чінь розпочав кампанію з нагородження за досягнення успіхів на честь 14-го Національного з'їзду партії](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/5/8869ec5cdbc740f58fbf2ae73f065076)

![[ВІДЕО] Короткий зміст церемонії святкування 50-річчя ПетроВ'єтнаму](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/4/abe133bdb8114793a16d4fe3e5bd0f12)

![[ВІДЕО] ГЕНЕРАЛЬНИЙ СЕКРЕТАР LAM НАГОРОЖУЄ PETROVIETNAM 8 ЗОЛОТИМИ СЛОВАМИ: «ПІОНЕР — ВІДМІННИЙ — СТАЛИЙ — ГЛОБАЛЬНИЙ»](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/23/c2fdb48863e846cfa9fb8e6ea9cf44e7)

Коментар (0)