У середині грудня Meta почала інтегрувати чат-бота зі штучним інтелектом під назвою Meta AI у додаток Messenger у В'єтнамі та випустила його безкоштовно для всіх користувачів. Цей інструмент використовує мовну модель Llama 3.2, підтримує в'єтнамську мову, дозволяє шукати інформацію, створювати зображення та спілкуватися в чаті.

Невдовзі після цього багато користувачів у В'єтнамі виявили, що Meta AI мав серйозну помилку у створенні зображення. Зокрема, під час введення ключового слова «чорний собака» чат-бот повертав результат із зображенням темношкірого чоловіка або хлопчика з кучерявим волоссям. Якщо вводити ключове слово в'єтнамською як «зображення чорного собаки», Meta AI також повертав аналогічні результати.

Мета-ШІ, який малює кольорових людей, поки команда запитує різний контент, є серйозною проблемою.

31 грудня представник Meta у В'єтнамі офіційно висловився щодо інциденту. Компанія підтвердила вищезгадану проблему та оголосила про її виправлення. Разом з тим, Meta Vietnam вибачилася за інцидент та заявила, що ця проблема може виникнути й з іншими існуючими системами генеративного штучного інтелекту.

«Вибачте за цю помилку. Meta вбудовує захисні механізми в наші функції та моделі штучного інтелекту, щоб забезпечити безпечніший та приємніший досвід для всіх. Однак, як і інші генеративні системи штучного інтелекту, ця модель може повертати неточний або образливий контент, тому ми закликаємо користувачів використовувати ці інструменти відповідально», – сказав представник компанії.

Після певного періоду досвіду, Meta AI отримав високу оцінку багатьох людей за його здатність використовувати мову для досить плавного реагування. Функція створення зображень також забезпечує хорошу якість порівняно з моделлю, що була випущена безкоштовно для користувачів. Частково це може бути пов'язано з тим, що Meta використовує контент, опублікований у Facebook, як вхідні дані в процесі навчання ШІ, допомагаючи цьому інструменту виражати та виконувати природні команди.

Однак, таких інцидентів, як расизм або реакції, що не відповідають стандартам, встановленим для ШІ, все ще важко уникнути. Meta стверджує, що тестує свій ШІ з експертами в галузі штучного інтелекту за допомогою тестів «Red Teaming», щоб виявити непередбачуване використання, яке потім вирішує за допомогою процесу постійного вдосконалення.

Джерело: https://thanhnien.vn/meta-xin-loi-vi-su-co-ai-ve-con-cho-da-den-185241231104908626.htm

![[Фото] Прем'єр-міністр Фам Мінь Чінь та Генеральний секретар Організації Об'єднаних Націй Антоніу Гутерріш взяли участь у прес-конференції з нагоди церемонії підписання Ханойської конвенції](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761391413866_conguoctt-jpg.webp)

![[Фото] Прем'єр-міністр Фам Мінь Чінь відвідав відкриття 47-го саміту АСЕАН](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

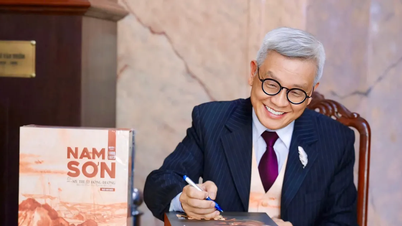

![[Фото] Генеральний секретар То Лам прийняв делегацію, яка брала участь у міжнародній конференції з в'єтнамських досліджень](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[Фото] Голова Національної асамблеї Чан Тхань Ман приймає Генерального секретаря Організації Об'єднаних Націй Антоніу Гутерріша](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/25/1761390815792_ctqh-jpg.webp)

Коментар (0)