ڈیپ سیک، حالیہ دنوں میں سب سے مشہور چینی اسٹارٹ اپ نے صرف $5 ملین کے ساتھ OpenAI کے برابر AI بنانے کے اپنے دعوے پر شکوک و شبہات کو جنم دیا ہے۔

ڈیپ سیک نے سانپ کے سال کے آغاز میں وسیع پیمانے پر میڈیا کوریج اور سوشل میڈیا کوریج کی، جس سے عالمی اسٹاک مارکیٹوں میں نمایاں جھٹکے لگے۔

تاہم، مالیاتی مشاورتی فرم برنسٹین کی ایک حالیہ رپورٹ نے خبردار کیا ہے کہ متاثر کن کامیابیوں کے باوجود، صرف 5 ملین ڈالر میں OpenAI کے مقابلے میں ایک AI سسٹم بنانے کا دعویٰ غلط ہے۔

برنسٹین کے مطابق ڈیپ سیک کا بیان گمراہ کن ہے اور بڑی تصویر کی عکاسی نہیں کرتا۔

"ہمیں یقین ہے کہ ڈیپ سیک نے 'اوپن اے آئی کو $5 ملین سے نہیں بنایا'؛ ماڈلز لاجواب ہیں لیکن ہمیں نہیں لگتا کہ وہ معجزے ہیں؛ اور لگتا ہے کہ ہفتے کے آخر میں ہونے والی گھبراہٹ کو بڑھا چڑھا کر پیش کیا گیا ہے،" رپورٹ میں کہا گیا ہے۔

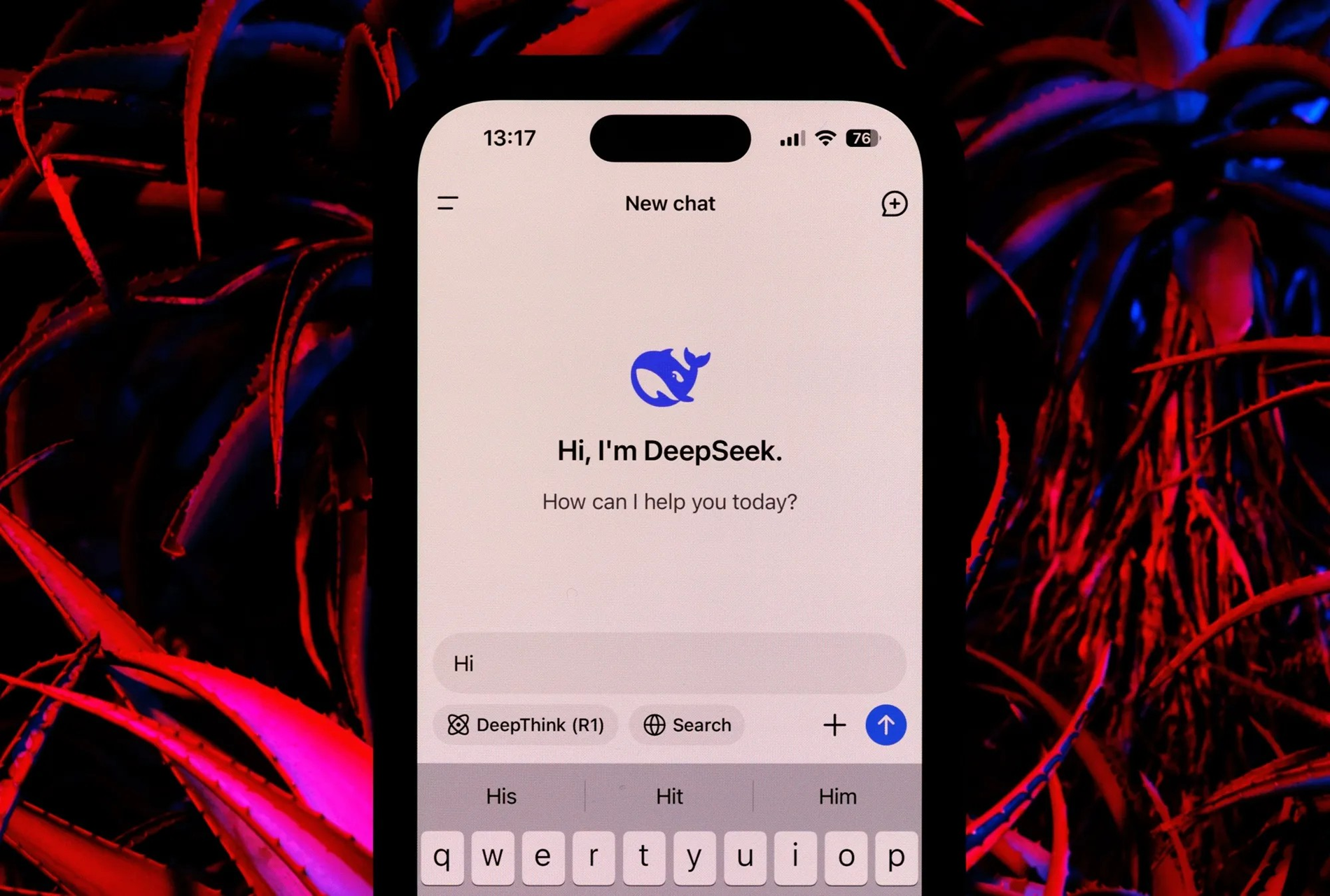

DeepSeek دو اہم AI ماڈل تیار کرتا ہے: DeepSeek-V3 اور DeepSeek R1۔ بڑے پیمانے پر V3 زبان کا ماڈل MOE فن تعمیر کا فائدہ اٹھاتا ہے، روایتی ماڈلز کے مقابلے میں کم کمپیوٹنگ وسائل کا استعمال کرتے ہوئے اعلی کارکردگی حاصل کرنے کے لیے چھوٹے ماڈلز کو یکجا کرتا ہے۔

دوسری طرف، V3 ماڈل میں 671 بلین پیرامیٹرز ہیں، جن میں کسی بھی وقت 37 بلین پیرامیٹرز فعال ہیں، میموری کے استعمال کو کم کرنے اور FP8 کو زیادہ کارکردگی کے لیے استعمال کرنے کے لیے MHLA جیسی اختراعات کو شامل کرتے ہیں۔

V3 ماڈل کی تربیت کے لیے دو ماہ کی مدت میں 2,048 Nvidia H800 GPUs کا کلسٹر درکار ہے، جو کہ 5.5 ملین GPU گھنٹے کے برابر ہے۔ اگرچہ کچھ تخمینوں کے مطابق تربیت کی لاگت تقریباً 5 ملین ڈالر ہے، برنسٹین کی رپورٹ اس بات پر زور دیتی ہے کہ یہ اعداد و شمار صرف کمپیوٹنگ کے وسائل کا احاطہ کرتا ہے اور تحقیق، جانچ اور دیگر ترقیاتی اخراجات سے متعلق اہم اخراجات کا حساب نہیں رکھتا ہے۔

ڈیپ سیک R1 ماڈل رینفورسمنٹ لرننگ (RL) اور دیگر تکنیکوں کو استعمال کرتے ہوئے V3 کی بنیاد بناتا ہے تاکہ انفرنس کی صلاحیت کو یقینی بنایا جا سکے۔

R1 ماڈل استدلال کے کاموں میں OpenAI ماڈلز کا مقابلہ کر سکتا ہے۔ تاہم، برنسٹین بتاتا ہے کہ R1 کو ترقی دینے کے لیے اہم وسائل کی ضرورت ہوتی ہے، حالانکہ ڈیپ سیک رپورٹ میں ان کی تفصیل نہیں ہے۔

ڈیپ سیک پر تبصرہ کرتے ہوئے، برنسٹین نے متاثر کن ماڈلز کی تعریف کی۔ مثال کے طور پر، V3 ماڈل لسانیات، پروگرامنگ، اور ریاضی میں دیگر بڑے لینگوئج ماڈلز کے مقابلے میں اچھی کارکردگی کا مظاہرہ کرتا ہے جبکہ کم وسائل کی ضرورت ہوتی ہے۔

V3 پری ٹریننگ کے عمل کے لیے صرف 2.7 ملین GPU گھنٹے کام کرنا پڑتا ہے، یا کچھ دوسرے اعلیٰ درجے کے ماڈلز کے کمپیوٹنگ وسائل کا 9%۔

برنسٹین نے یہ نتیجہ اخذ کیا کہ، جب کہ ڈیپ سیک کی پیشرفت قابل ذکر ہے، کسی کو مبالغہ آمیز دعووں سے ہوشیار رہنا چاہیے۔ صرف $5 ملین کے ساتھ OpenAI کا مدمقابل بنانے کا خیال گمراہ کن لگتا ہے۔

(ٹائمز آف انڈیا کے مطابق)

ماخذ: https://vietnamnet.vn/deepseek-khong-the-lam-ai-tuong-duong-openai-voi-5-trieu-usd-2367340.html

تبصرہ (0)