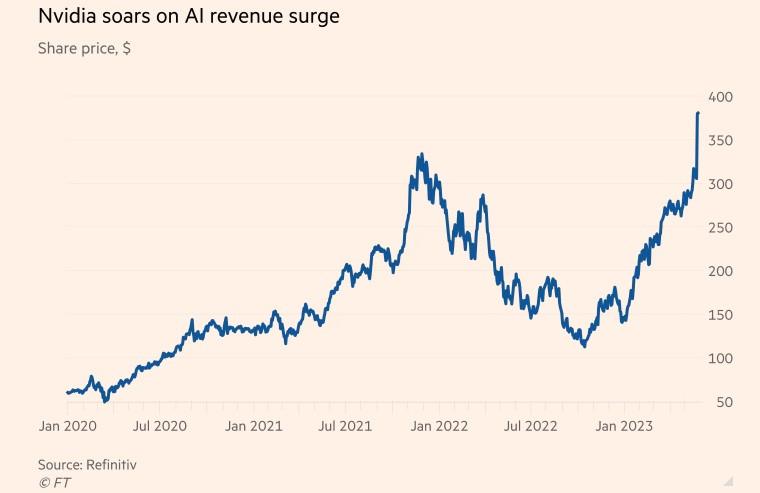

كانت شركة Nvidia معروفة في السابق بأنها الشركة المصنعة للشرائح المستخدمة في ألعاب الفيديو، ولكنها حولت تركيزها إلى سوق مراكز البيانات في السنوات الأخيرة.

شهدت شركة الرقائق الأمريكية ازدهارًا ملحوظًا خلال فترة الجائحة، مع تزايد الطلب على تطبيقات الألعاب والحوسبة السحابية، وانتشار شغف تعدين العملات المشفرة حول العالم . وبحلول نهاية السنة المالية المنتهية في 29 يناير، شكّلت أعمال رقائق مراكز البيانات أكثر من 50% من إيرادات الشركة.

وفي الوقت نفسه، أخذ برنامج المحادثة الشهير ChatGPT الذكاء الاصطناعي التوليدي إلى المستوى التالي هذا العام، باستخدام كميات كبيرة من البيانات الموجودة لإنشاء محتوى جديد حول مواضيع تتراوح من الشعر إلى برمجة الكمبيوتر.

مايكروسوفت وألفابت، عملاقتا التكنولوجيا، من اللاعبين الرئيسيين في مجال الذكاء الاصطناعي، إذ تؤمنان بقدرة التكنولوجيا التوليدية على تغيير طريقة عمل الناس. وقد أطلقتا سباقًا لدمج الذكاء الاصطناعي في محركات البحث، بالإضافة إلى برامج المكاتب، سعيًا للسيطرة على هذه الصناعة.

وتشير تقديرات جولدمان ساكس إلى أن الاستثمار الأمريكي في الذكاء الاصطناعي قد يصل إلى نحو 1% من الناتج الاقتصادي للبلاد بحلول عام 2030.

تعتمد الحواسيب العملاقة المستخدمة لمعالجة البيانات وتشغيل الذكاء الاصطناعي التوليدي على وحدات معالجة الرسومات (GPUs). صُممت هذه الوحدات لمعالجة حسابات محددة تتعلق بحوسبة الذكاء الاصطناعي، بكفاءة أعلى بكثير من وحدات المعالجة المركزية من شركات تصنيع الرقائق الأخرى مثل إنتل. على سبيل المثال، يعمل ChatGPT من OpenAI بآلاف وحدات معالجة الرسومات من Nvidia.

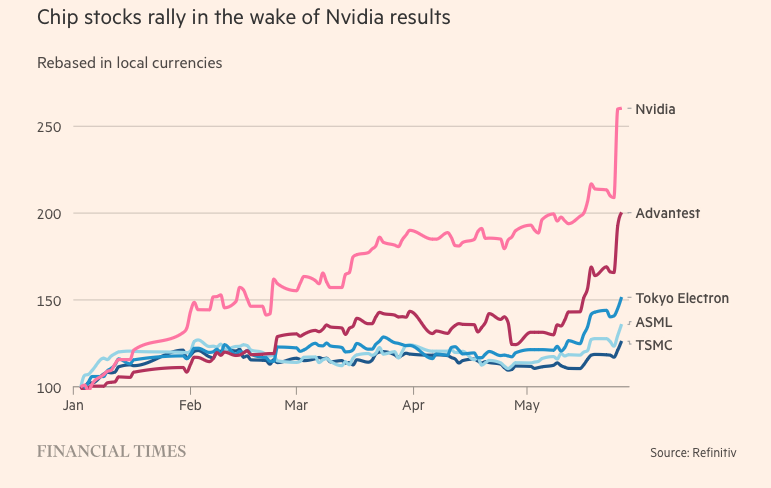

في الوقت نفسه، تستحوذ إنفيديا على حوالي 80% من سوق وحدات معالجة الرسومات. ومن أبرز منافسيها شركة أدفانسد مايكرو ديفايسز، ورقائق الذكاء الاصطناعي الداخلية من شركات تقنية مثل أمازون وجوجل وميتا بلاتفورمز.

سر التسامي

حققت الشركة قفزة نوعية بفضل شريحة H100، وهي شريحة مبنية على بنية Nvidia الجديدة المسماة "Hopper" - نسبةً إلى رائدة البرمجة الأمريكية غريس هوبر. وقد جعل التطور الهائل في الذكاء الاصطناعي من H100 السلعة الأكثر رواجًا في وادي السيليكون.

تحتوي الرقاقات فائقة الحجم المستخدمة في مراكز البيانات على 80 مليار ترانزستور، أي خمسة أضعاف السيليكون المستخدم في أحدث هواتف آيفون. ورغم أن تكلفتها ضعف تكلفة سابقتها، A100 (التي صدرت عام 2020)، إلا أن مستخدمي H100 يؤكدون أنها تقدم أداءً أفضل بثلاثة أضعاف.

وقد أثبتت H100 شعبيتها بشكل خاص لدى شركات "Big Tech" مثل Microsoft و Amazon، والتي تقوم ببناء مراكز بيانات كاملة تركز على أحمال عمل الذكاء الاصطناعي، وشركات الذكاء الاصطناعي من الجيل الجديد مثل OpenAI و Anthropic و Stability AI و Inflection AI، حيث تعد بأداء أعلى يمكن أن يسرع إطلاق المنتجات أو يقلل من تكاليف التدريب بمرور الوقت.

قال برانين ماكبي، كبير مسؤولي الاستراتيجية ومؤسس CoreWeave، وهي شركة ناشئة في مجال الحوسبة السحابية تعتمد على الذكاء الاصطناعي وكانت من أوائل الشركات التي تلقت شحنات H100 في وقت سابق من هذا العام: "يعتبر هذا أحد أكثر الموارد الهندسية ندرة هناك".

لا يحظى عملاء آخرون بنفس حظ CoreWeave، إذ يضطرون للانتظار لمدة تصل إلى ستة أشهر للحصول على المنتج لتدريب نماذج بياناتهم الضخمة. وتخشى العديد من شركات الذكاء الاصطناعي الناشئة من عدم قدرة Nvidia على تلبية طلب السوق.

كما طلب إيلون ماسك أيضًا آلاف الرقائق من شركة Nvidia لشركته الناشئة في مجال الذكاء الاصطناعي، قائلاً "أصبح من الصعب الحصول على وحدات معالجة الرسومات في الوقت الحالي أكثر من الأدوية".

ارتفعت تكاليف الحوسبة بشكل كبير. ووصل الحد الأدنى للإنفاق على أجهزة الخوادم المستخدمة في بناء الذكاء الاصطناعي الإبداعي إلى 250 مليون دولار، حسبما ذكر الرئيس التنفيذي لشركة تيسلا.

في حين أن H100 يأتي في وقته، إلا أن طفرة إنفيديا في مجال الذكاء الاصطناعي تعود إلى عقدين من الزمن، حيث ابتكرت البرمجيات بدلاً من الأجهزة. في عام 2006، طرحت الشركة برنامج Cuda، الذي يسمح باستخدام وحدات معالجة الرسومات كمُسرّعات لمهام أخرى غير الرسومات.

قال ناثان بينيتش، الشريك في إير ستريت كابيتال والمستثمر في شركات الذكاء الاصطناعي الناشئة: "سبقت إنفيديا الجميع في استشراف المستقبل، وتوجهت نحو وحدات معالجة الرسومات القابلة للبرمجة. لقد استغلت الفرصة، وراهنت بقوة، وتفوقت باستمرار على منافسيها".

(بحسب رويترز، إف تي)

[إعلان 2]

مصدر

![[صورة] الرئيس لونغ كوونغ يستقبل رئيس مجلس الشيوخ في جمهورية التشيك ميلوس فيسترسيل](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629737266_ndo_br_1-jpg.webp&w=3840&q=75)

![[صورة] رئيس الجمعية الوطنية تران ثانه مان يعقد محادثات مع رئيس الجمعية الوطنية الكورية الجنوبية وو وون شيك](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F11%2F20%2F1763629724919_hq-5175-jpg.webp&w=3840&q=75)

تعليق (0)