وبحسب وكالة الأنباء اليابانية "في إن إيه" ، ستنشئ اليابان وكالة جديدة مكلفة بتطوير معايير السلامة للذكاء الاصطناعي للرد على المخاطر مثل إساءة استخدام الذكاء الاصطناعي لإنشاء محتوى مزيف ونشر معلومات كاذبة أصبحت أكثر شيوعا.

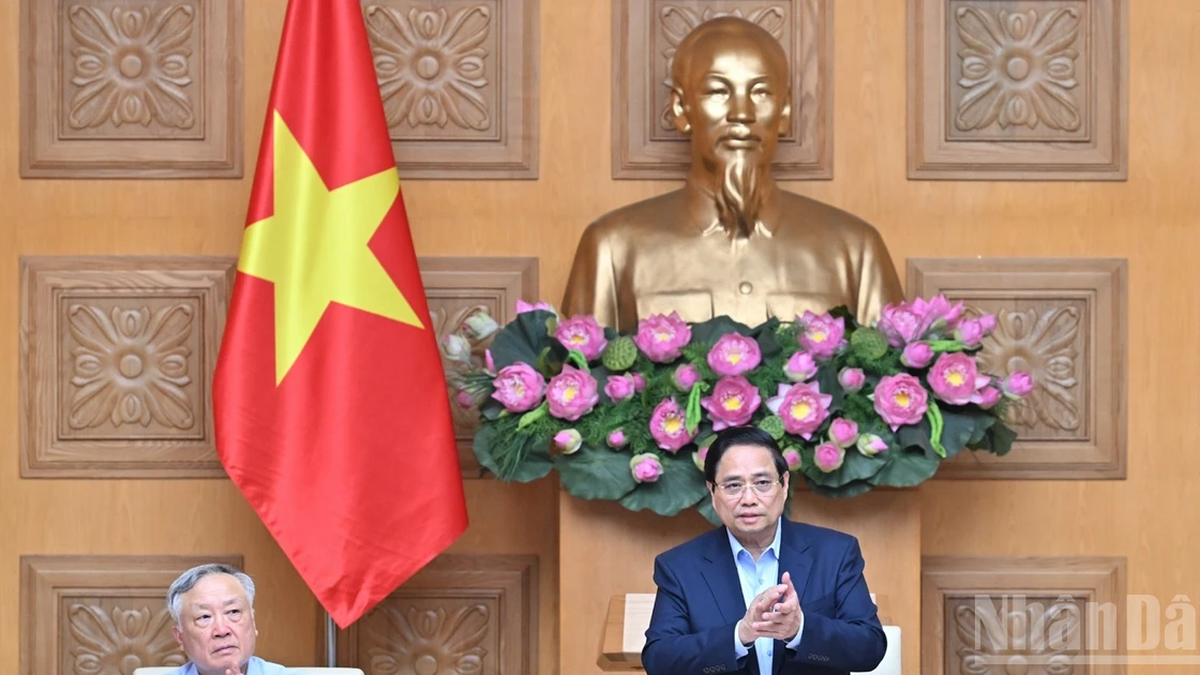

وأعلن رئيس الوزراء فوميو كيشيدا عن المعلومات المذكورة أعلاه في اجتماع مجلس استراتيجية الذكاء الاصطناعي الذي عقد في 21 ديسمبر/كانون الأول في طوكيو.

ومن المتوقع إنشاء المنظمة الجديدة في يناير 2024 تحت اسم "معهد سلامة الذكاء الاصطناعي" (AISI)، تحت إشراف وكالة تعزيز تكنولوجيا المعلومات (IPA)، ووزارة الاقتصاد والتجارة والصناعة في اليابان (METI).

ستتكون AISI من خبراء في مجال الذكاء الاصطناعي والأمن السيبراني، وسيكونون مسؤولين عن وضع معايير تقييم السلامة للشركات التي تعمل على تطوير الذكاء الاصطناعي والتحقق من مخاطر إساءة استخدام الذكاء الاصطناعي.

كما ناقش مجلس الذكاء الاصطناعي في الاجتماع "المبادئ التوجيهية للذكاء الاصطناعي" والتي تتضمن 10 مبادئ، تدعو الشركات المحلية إلى وضع الإنسان في المركز عند تطوير أو استخدام الذكاء الاصطناعي.

وفقًا للمخطط، سيتم الموافقة رسميًا على "إرشادات الذكاء الاصطناعي" في مارس 2024، والتي تنطبق على المطورين ومقدمي خدمات الذكاء الاصطناعي والمستخدمين.

وتستند المبادئ الواردة في "إرشادات الذكاء الاصطناعي" إلى "عملية هيروشيما للذكاء الاصطناعي" التي أطلقتها مجموعة الدول السبع لتطوير القواعد الدولية.

تماشيًا مع مبدأ التركيز على الإنسان، تدعو المبادئ التوجيهية الشركات إلى احترام حقوق الإنسان والتنوع، واتخاذ تدابير لمكافحة المعلومات المضللة، والامتناع تمامًا عن تطوير وتوفير واستخدام خدمات الذكاء الاصطناعي التي تتلاعب سلبًا بعملية صنع القرار البشري ومشاعره. بالإضافة إلى ذلك، تتضمن المبادئ التوجيهية مبادئ أخرى مثل حماية الخصوصية، وضمان العدالة، والأمان، والشفافية.

في وقت سابق من أكتوبر، أعلن رئيس الوزراء البريطاني ريشي سوناك أن بلاده ستنشئ أول معهد عالمي لسلامة الذكاء الاصطناعي، لاختبار وتقييم واختبار أشكال جديدة من الذكاء الاصطناعي. ومن هنا، يمكن للجهات التنظيمية استيعاب قدرات كل نموذج جديد، وتحديد جميع المخاطر، بدءًا من الضرر الاجتماعي كالتحيز والمعلومات المضللة، وصولًا إلى أشدها خطورة.

وبعد فترة وجيزة، أعلنت وزيرة التجارة الأمريكية جينا رايموندو أن الولايات المتحدة ستنشئ معهدًا لسلامة الذكاء الاصطناعي يعتمد على العمل مع المعهد الوطني للمعايير والتكنولوجيا لضمان سلامة وموثوقية الذكاء الاصطناعي.

في الآونة الأخيرة، أحدثت أدوات الذكاء الاصطناعي نقلة نوعية في موجة الاستثمار في التكنولوجيا. ومع ذلك، يُشير خبراء التكنولوجيا إلى أن الذكاء الاصطناعي محفوف بالعديد من المخاطر والتحديات، مع مخاوف بشأن مستوى الثقة المتعلقة بالبيانات والخوارزميات والتطبيقات.

ولذلك، لتحقيق أقصى قدر من الاستفادة من الذكاء الاصطناعي، من المهم أن نعطي الجمهور الثقة بأن هذه التكنولوجيا يتم تطويرها واستخدامها بشكل مسؤول.

في الآونة الأخيرة، وقعت 18 دولة بما في ذلك الولايات المتحدة والمملكة المتحدة وألمانيا وإيطاليا وجمهورية التشيك وبولندا وأستراليا وتشيلي وسنغافورة... اتفاقية لتشجيع الشركات على إنشاء أنظمة الذكاء الاصطناعي الآمنة منذ مرحلة التصميم لتجنب خطر إساءة الاستخدام.

ويُنظر إلى هذه المبادرة باعتبارها الأحدث في سلسلة من المبادرات التي اتخذتها الحكومات في جميع أنحاء العالم لتشكيل تطوير الذكاء الاصطناعي، الذي له تأثير متزايد على الصناعة والمجتمع بشكل عام.

مينه هوا (ت/ح)

[إعلان 2]

مصدر

![[صورة] رئيس الجمعية الوطنية يحضر ندوة "بناء وتشغيل مركز مالي دولي وتوصيات لفيتنام"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/28/76393436936e457db31ec84433289f72)

تعليق (0)