সেই অনুযায়ী, ২২ মে আমেরিকান সোশ্যাল নেটওয়ার্কে কৃত্রিম বুদ্ধিমত্তা (এআই) দ্বারা তৈরি পেন্টাগনের কাছে একটি বিস্ফোরণের একটি ছবি শেয়ার করা হয়, যার ফলে অল্প সময়ের মধ্যেই শেয়ার বাজারের পতন ঘটে, যার ফলে এআই থেকে উদ্ভূত ভুয়া খবর নিয়ে উদ্বেগ তৈরি হয়।

|

| পেন্টাগনের কাছে বিস্ফোরণের এআই-জেনারেটেড ভুয়া ছবি। |

অনলাইন ফ্যাক্ট-চেকিং গ্রুপ বেলিংক্যাটের নিক ওয়াটার্স ছবিটির উল্লেখযোগ্য সমস্যাগুলি দ্রুত তুলে ধরেন। প্রথমত, ঘটনাটির সমর্থনে কোনও প্রত্যক্ষদর্শী নেই। ছবিতে থাকা ভবনটি পেন্টাগনের মতো দেখাচ্ছে না। কিছু অস্বাভাবিক বিবরণ, যেমন বিশিষ্ট ল্যাম্পপোস্ট এবং ফুটপাথ থেকে বেরিয়ে আসা কালো স্তম্ভ, ইঙ্গিত দেয় যে ছবিটি আসল নয়।

মিডজার্নি, ডাল-ই ২ এবং স্টেবল ডিফিউশনের মতো অনেক কৃত্রিম বুদ্ধিমত্তা (এআই) পুনর্গঠন সরঞ্জাম রয়েছে যা প্রাণবন্ত চিত্র তৈরি করতে পারে। তবে, যখন ডেটার অভাব থাকে তখন এই সরঞ্জামগুলি শূন্যস্থান পূরণ করবে।

ইন্টারনেটে প্রকাশিত বড় বড় ঘটনার কৃত্রিম বুদ্ধিমত্তা (এআই) দ্বারা তৈরি ছবি এবং আসল ছবিগুলির মধ্যে পার্থক্য করার জন্য আল জাজিরা কিছু ব্যবস্থা নিয়ে এসেছে, যেমন:

- বিস্ফোরণ বা কোনও বড় ঘটনার ক্ষেত্রে, সাধারণত একাধিক ব্যক্তির কাছ থেকে এবং একাধিক দৃষ্টিকোণ থেকে তথ্যগত তথ্য থাকবে।

- কারা কন্টেন্ট পোস্ট করছে? তারা কোথায় অবস্থিত এবং ইভেন্টটি কোথায়? তারা কোন অ্যাকাউন্টগুলি অনুসরণ করছে এবং কে তাদের অনুসরণ করছে। আপনি কি তাদের সাথে যোগাযোগ করতে পারেন বা কথা বলতে পারেন?

- ছবি এবং আশেপাশের পরিবেশ বিশ্লেষণ করুন: ছবিতে থাকা সূত্রগুলি যেমন কাছাকাছি অবস্থান, ট্র্যাফিক সাইন ইত্যাদি খুঁজে বের করুন, যাতে আপনি নির্ধারণ করতে পারেন কোথায় বা কখন কোন ঘটনা ঘটতে পারে।

- মানুষের ছবি তোলার সময়, তাদের চোখ, হাত এবং সাধারণ ভঙ্গির দিকে মনোযোগ দিন। মানুষের অনুকরণ করে তৈরি কৃত্রিম বুদ্ধিমত্তা (AI) দ্বারা তৈরি ভিডিও , যাকে ডিপ ফেক বলা হয়, তাদের চোখের পলক ফেলার সমস্যা হয় কারণ বেশিরভাগ প্রশিক্ষণ ডেটাসেটে চোখ বন্ধ করে মুখ থাকে না। হাত বস্তুগুলিকে সঠিকভাবে ধরতে পারে না।

- AI-জেনারেটেড ছবিতে দেখা মানুষের ত্বক প্রায়শই মসৃণ হবে, এমনকি তাদের চুল এবং দাঁতও অসাধারণভাবে নিখুঁত হবে।

[বিজ্ঞাপন_২]

উৎস

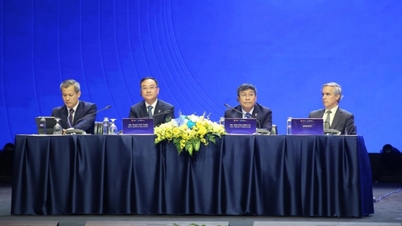

![[ছবি] ভিয়েতনামী গবেষণা বিষয়ক আন্তর্জাতিক সম্মেলনে যোগদানকারী প্রতিনিধিদলকে স্বাগত জানান সাধারণ সম্পাদক টু লাম।](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

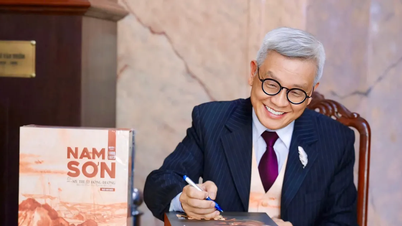

![[ছবি] নান ড্যান সংবাদপত্র ১৪তম জাতীয় পার্টি কংগ্রেসের খসড়া নথি প্রদর্শন করে এবং তার উপর মন্তব্য আহ্বান করে](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761470328996_ndo_br_bao-long-171-8916-jpg.webp)

![[ছবি] চীনের হুনানে লিউয়াং আতশবাজি উৎসব উপভোগ করুন](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761463428882_ndo_br_02-1-my-1-jpg.webp)

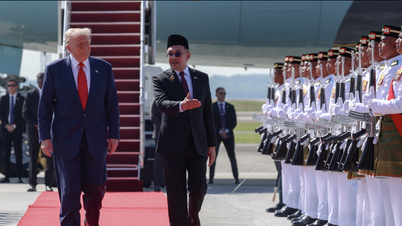

![[ছবি] প্রধানমন্ত্রী ফাম মিন চিন ৪৭তম আসিয়ান শীর্ষ সম্মেলনের উদ্বোধনী অনুষ্ঠানে যোগ দিচ্ছেন](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

মন্তব্য (0)