V souladu s tím byla 22. května na amerických sociálních sítích sdílena fotografie exploze poblíž Pentagonu vytvořené umělou inteligencí (AI), která způsobila krátký propad akciového trhu a vyvolala tak obavy z falešných zpráv pocházejících z AI.

|

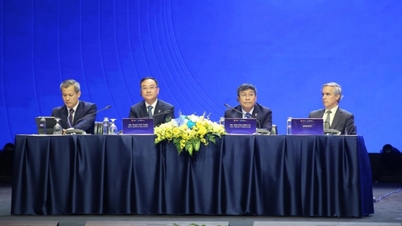

| Falešná fotografie výbuchu poblíž Pentagonu vygenerovaná umělou inteligencí. |

Nick Waters z online skupiny pro ověřování faktů Bellingcat rychle poukázal na významné problémy s fotografií. Zaprvé, neexistují žádní očití svědci, kteří by incident potvrdili. Budova na fotografii také nevypadá jako Pentagon. Některé neobvyklé detaily, jako jsou výrazné lampy a černé sloupy vyčnívající z chodníku, naznačují, že fotografie není skutečná.

Existuje mnoho nástrojů pro rekonstrukci s využitím umělé inteligence (AI), jako jsou Midjourney, Dall-e 2 a Stable Diffusion, které dokáží vytvářet realistické obrazy. Tyto nástroje však doplní mezery v datech.

Televizní stanice Al-Džazíra zavedla několik opatření, která umožňují rozlišovat mezi snímky generovanými umělou inteligencí a skutečnými fotografiemi významných událostí, když se objeví na internetu:

- V případě výbuchu nebo nějaké velké události budou obvykle k dispozici faktické informace od více lidí a z více úhlů pohledu.

- Kdo zveřejňuje obsah? Kde se nacházejí a kde se akce koná? Jaké účty sledují a kdo je sleduje? Můžete je kontaktovat nebo si s nimi promluvit?

- Analyzujte obrázky a okolí: Hledejte na obrázku vodítka, jako jsou blízká místa, dopravní značky atd., která vám pomohou určit, kde nebo kdy by se událost mohla odehrát.

- U obrázků lidí věnujte pozornost jejich očím, rukám a celkovému držení těla. Videa generovaná umělou inteligencí, která napodobují lidi, nazývaná deep fakes, mívají problémy s mrkáním, protože většina trénovacích datových sad neobsahuje tváře se zavřenýma očima. Ruce nebudou správně uchopovat předměty.

- Kůže lidí na snímcích generovaných umělou inteligencí bude často hladká a dokonce i jejich vlasy a zuby budou surreálně dokonalé.

Zdroj

![[Fotografie] Užijte si festival ohňostrojů Liuyang v čínském Hunanu](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761463428882_ndo_br_02-1-my-1-jpg.webp)

![[Foto] Generální tajemník To Lam přijal delegaci účastnící se mezinárodní konference o vietnamských studiích](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761456527874_a1-bnd-5260-7947-jpg.webp)

![[Fotografie] Noviny Nhan Dan vystavují a žádají o komentáře k návrhům dokumentů 14. sjezdu Národní strany](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761470328996_ndo_br_bao-long-171-8916-jpg.webp)

![[Foto] Premiér Pham Minh Chinh se účastní zahájení 47. summitu ASEAN](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/26/1761452925332_c2a-jpg.webp)

Komentář (0)