Generální ředitel společnosti Truepic Jeffrey McGregor uvedl, že incident byl jen špičkou ledovce. Na sociálních sítích bude více obsahu generovaného umělou inteligencí a my na to nejsme připraveni, řekl McGregor.

Podle CNN chce Truepic tento problém vyřešit poskytnutím technologie, která údajně ověřuje média v okamžiku jejich vytvoření prostřednictvím Truepic Lens. Aplikace pro sběr dat uživatelům sdělí datum, čas, místo a zařízení použité k vytvoření obrázku a použije digitální podpis k ověření, zda je obrázek přirozený nebo generovaný umělou inteligencí.

Falešná fotografie výbuchu v Pentagonu se šíří na Twitteru

Společnost Truepic, založená v roce 2015 a podporovaná společností Microsoft, uvedla, že zaznamenává zájem ze strany nevládních organizací , mediálních společností a dokonce i pojišťoven, které chtějí ověřit oprávněnost nároků.

McGregor říká, že když se dá všechno zfalšovat, když umělá inteligence dosáhla svého vrcholu v kvalitě a dostupnosti, už nevíme, co je online realita.

Technologické společnosti jako Truepic bojují proti online dezinformacím již léta. Vzestup nového druhu nástrojů umělé inteligence, které dokáží generovat obrázky a text na příkaz uživatele, však tuto naléhavost ještě zvýšil. Začátkem tohoto roku se široce šířily falešné snímky papeže Františka v péřové bundě Balenciaga a bývalého amerického prezidenta Donalda Trumpa při zatýkání. Oba incidenty zmatekly miliony lidí ohledně potenciálních nebezpečí umělé inteligence.

Někteří zákonodárci nyní vyzývají technologické společnosti, aby se touto otázkou zabývaly a označovaly obsah generovaný umělou inteligencí. Místopředsedkyně Evropské komise (EK) Věra Jourová uvedla, že společnosti včetně Google, Meta, Microsoft a TikTok se připojily k dobrovolnému kodexu postupů Evropské unie (EU) pro boj s dezinformacemi.

Rostoucí počet startupů a technologických gigantů, včetně těch, kteří implementují generativní umělou inteligenci do svých produktů, se snaží zavést standardy a řešení, která lidem pomohou určit, zda byl obrázek nebo video vytvořen pomocí umělé inteligence.

Ale vzhledem k tomu, že technologie umělé inteligence se vyvíjí rychleji, než s ní lidé dokážou držet krok, není jasné, zda tato řešení dokáží problém plně vyřešit. Dokonce i OpenAI, společnost stojící za Dall-E a ChatGPT, přiznala, že její vlastní snahy o detekci textu generovaného umělou inteligencí jsou nedokonalé.

Společnosti vyvíjející řešení volí dva přístupy k problému. První se spoléhá na vývoj programů pro identifikaci obrázků generovaných umělou inteligencí po jejich vytvoření a sdílení online. Druhý se zaměřuje na označení obrázku jako skutečného nebo generovaného umělou inteligencí pomocí určitého typu digitálního podpisu.

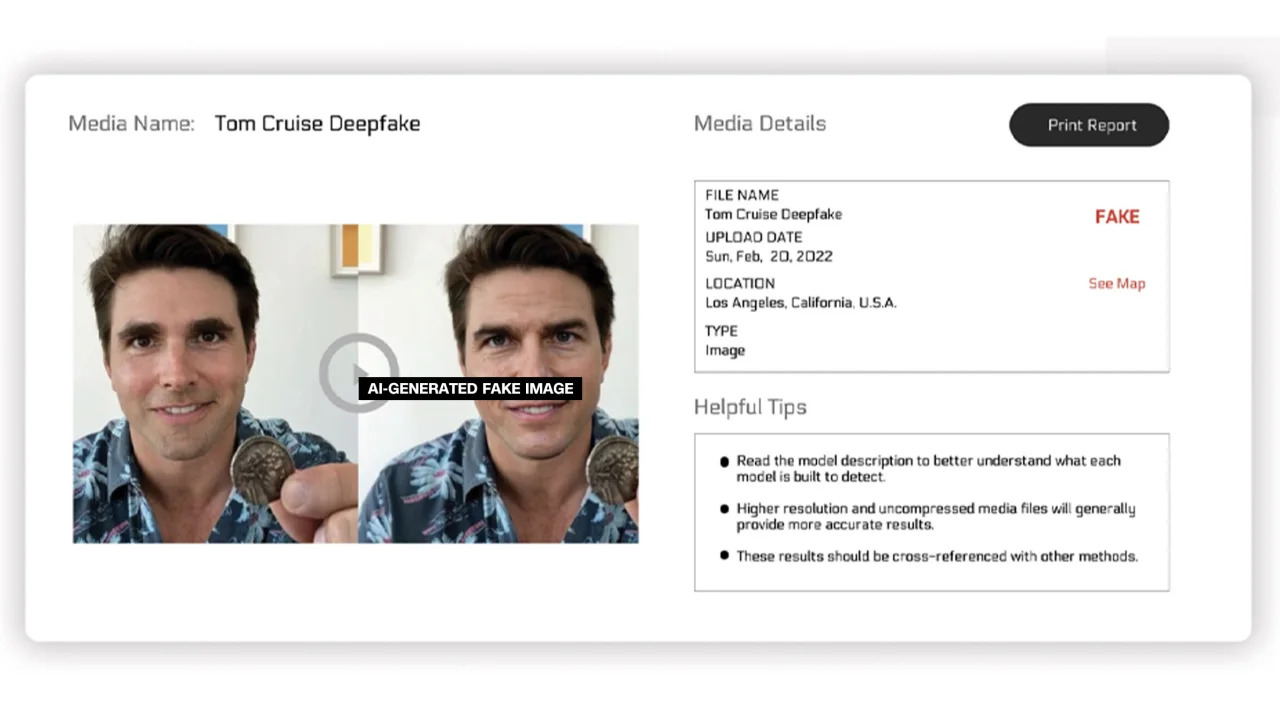

Na prvním z nich pracují společnosti Reality Defender a Hive Moderation. Díky jejich platformě mohou uživatelé nahrávat obrázky ke skenování a poté obdržet rozpis, který ukazuje procentuální podíl toho, zda je fotografie skutečná nebo vygenerovaná umělou inteligencí.

Společnost Reality Defender uvedla, že k detekci videa, zvuku a obrázků generovaných umělou inteligencí používá proprietární technologii deepfake a generativního snímání obsahu. V příkladu poskytnutém společností Reality Defender ukázal deepfake snímek Toma Cruise, který byl z 53 % „podezřelý“, protože osoba na obrázku měla zkreslený obličej, který je často vidět na upravených fotografiích.

Obrázky s popisky generované umělou inteligencí

Tyto služby nabízejí bezplatné i placené verze. Hive Moderation uvádí, že si účtuje 1,50 dolaru za 1 000 obrázků. Realty Defender uvádí, že ceny se mohou lišit v závislosti na různých faktorech, v případech, kdy klienti potřebují odborné znalosti a podporu společnosti. Generální ředitel Reality Defenderu Ben Colman říká, že riziko se každý měsíc zdvojnásobuje, protože kdokoli může pomocí nástrojů umělé inteligence vytvořit falešné fotografie.

Několik dalších společností pracuje na přidání jakéhosi štítku k obrázkům, který by potvrdil, zda jsou skutečné nebo generované umělou inteligencí. Dosud toto úsilí z velké části poháněla Aliance pro autenticitu a původ obsahu (C2PA).

Společnost C2PA byla založena v roce 2021 s cílem vytvořit technický standard pro certifikaci původu a historie digitálních médií, který kombinuje iniciativu pro ověřování obsahu (CAI) společnosti Adobe a projekt Origin, vedený společnostmi Microsoft a BBC, se zaměřením na boj proti dezinformacím v digitálním zpravodajství. Mezi další společnosti zapojené do C2PA patří Truepic, Intel a Sony.

Na základě principů C2PA vydá CAI nástroje s otevřeným zdrojovým kódem, které umožní firmám vytvářet identifikační údaje obsahu neboli metadata obsahující informace o obrázcích. Podle webových stránek CAI to tvůrcům umožňuje transparentně sdílet podrobnosti o tom, jak obrázek vytvořili. Koncoví uživatelé tak mohou získat přístup ke kontextu ohledně toho, kdo, co a jak byl obrázek upraven – a poté sami posoudit, jak autentický je daný obrázek.

Mnoho společností již integrovalo standard C2PA a nástroje CAI do svých aplikací. Firefly od společnosti Adobe, nový nástroj pro práci s umělou inteligencí přidaný do Photoshopu, splňuje standard C2PA prostřednictvím funkce Content Credentials. Společnost Microsoft také oznámila, že obrázky a videa vytvořená pomocí nástrojů Bing Image Creator a Microsoft Designer budou v nadcházejících měsících opatřena kryptografickými podpisy.

V květnu Google oznámil funkci „O tomto obrázku“, která uživatelům umožňuje zjistit, kdy se obrázek poprvé objevil na Googlu a kde jej lze vidět. Vyhledávací gigant také oznámil, že každý obrázek vygenerovaný umělou inteligencí od Googlu bude v původním souboru obsahovat označení, které „přidá kontext“, pokud se obrázek najde na jiném webu nebo platformě.

Zatímco se technologické společnosti snaží řešit obavy ohledně obrázků generovaných umělou inteligencí a integrity digitálních médií, odborníci v oboru zdůrazňují, že podniky budou muset na řešení tohoto problému spolupracovat mezi sebou navzájem i s vládami. Technologické společnosti se však navzdory rizikům předhánějí ve vývoji umělé inteligence.

Zdrojový odkaz

![[Fotografie] Premiér Pham Minh Chinh přijal prezidenta kubánské Latinskoamerické tiskové agentury](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F01%2F1764569497815_dsc-2890-jpg.webp&w=3840&q=75)

Komentář (0)