|

OpenAI hat gerade GPT-OSS auf den Markt gebracht, das erste frei gewichtete KI-Modell des Unternehmens seit 2018. Das Besondere daran: Das Modell ist kostenlos verfügbar, Nutzer können es herunterladen, anpassen und auf normalen Computern einsetzen. Foto: OpenAI . |

|

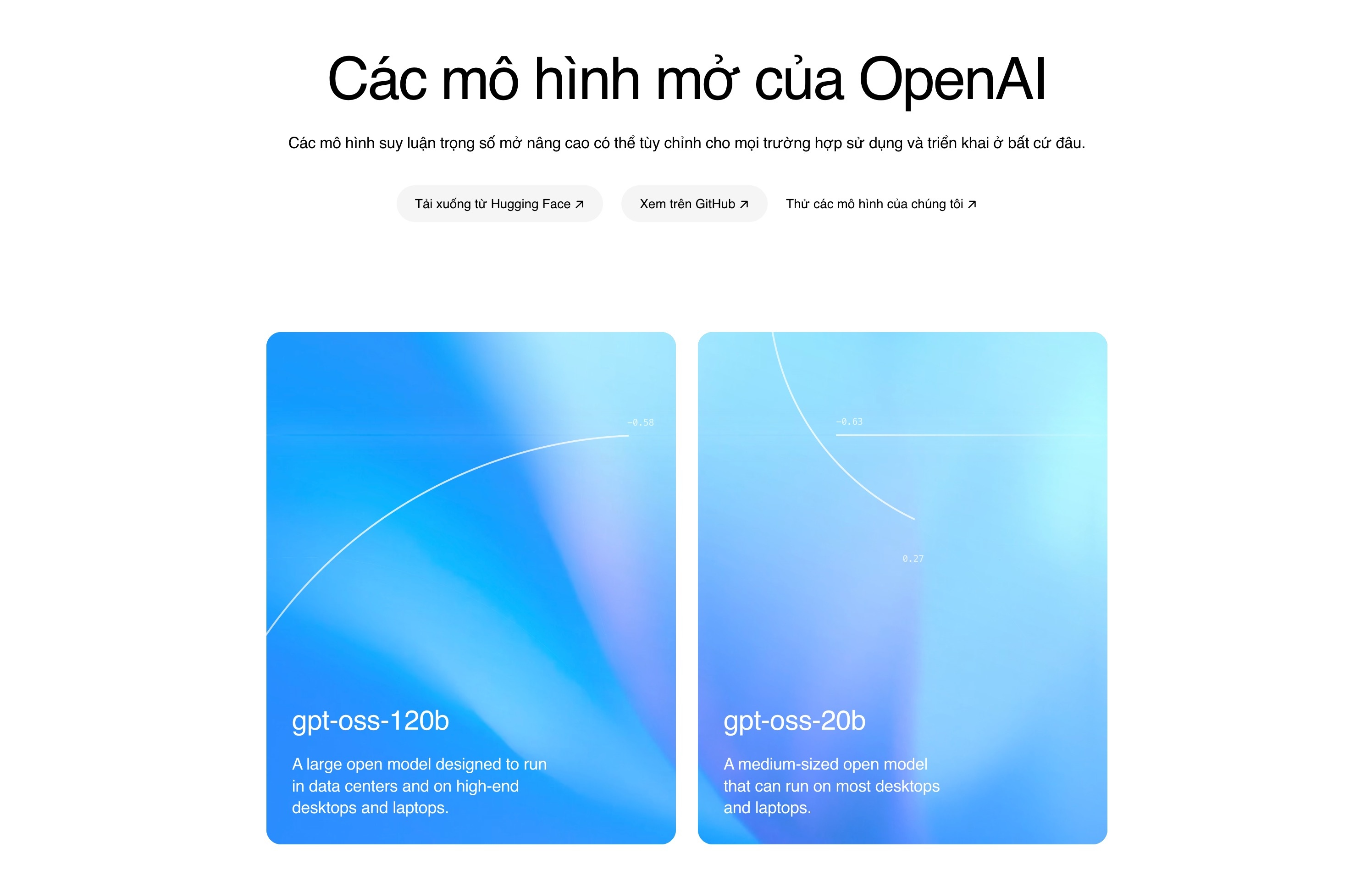

GPT-OSS ist in zwei Versionen erhältlich: Eine mit 20 Milliarden Parametern (GPT-OSS-20b), die auf Computern mit nur 16 GB RAM läuft. Die Version mit 120 Milliarden Parametern (GPT-OSS-120b) kann auf einer Nvidia-GPU mit 80 GB Speicher ausgeführt werden. Laut OpenAI entspricht die Version mit 120 Milliarden Parametern dem Modell o4-mini, während die Version mit 20 Milliarden Parametern die Leistung des Modells o3-mini aufweist. |

|

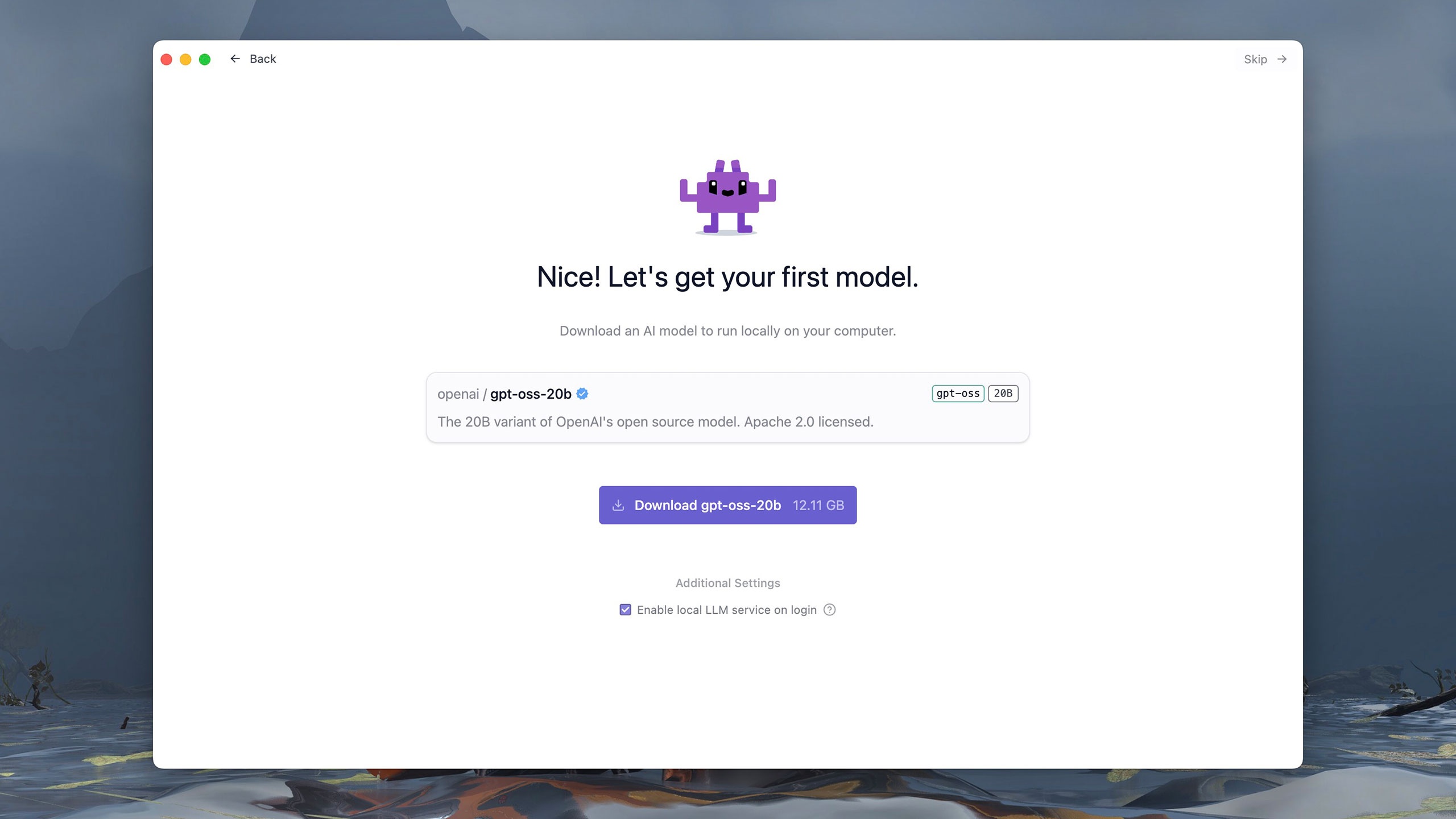

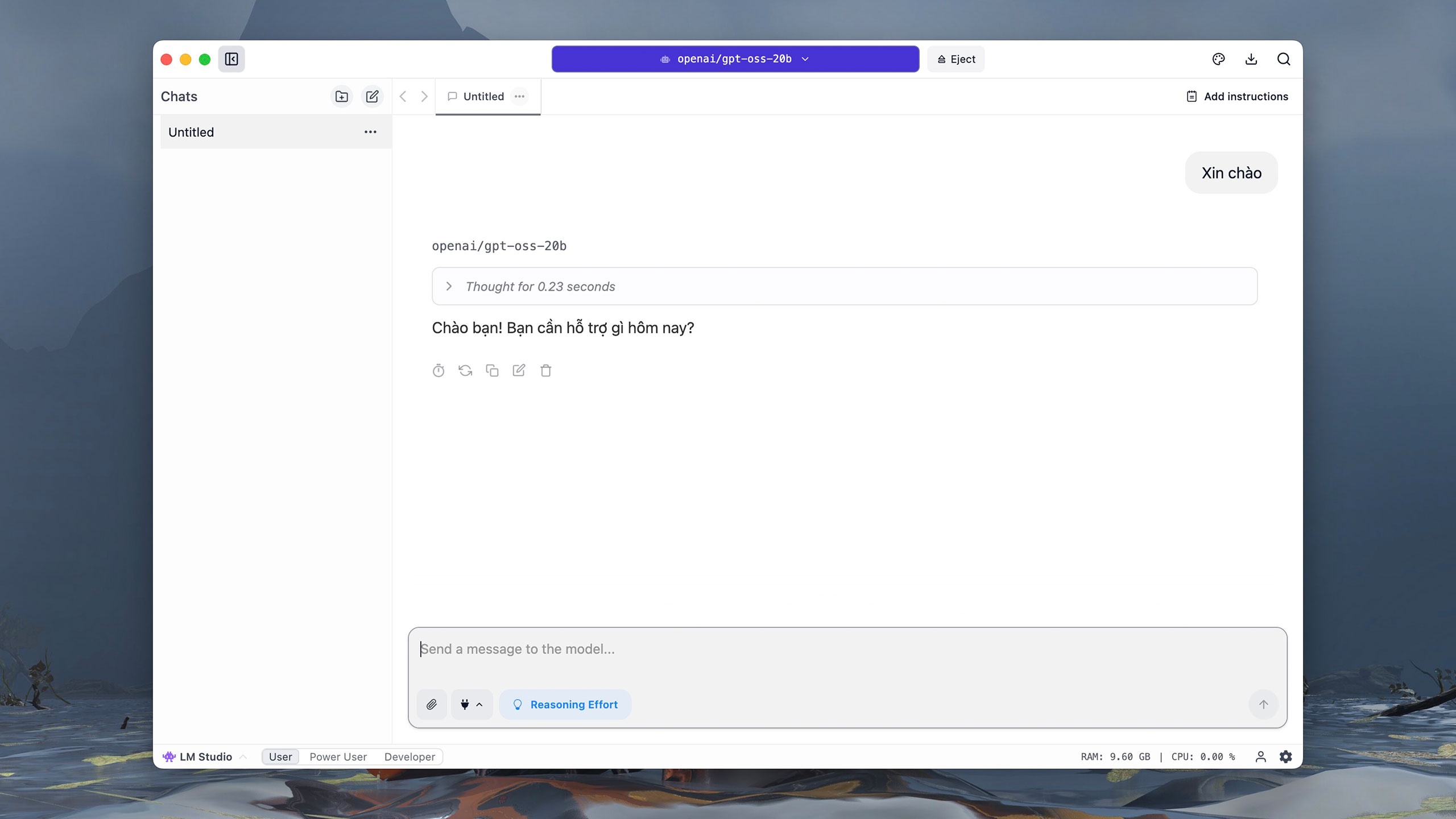

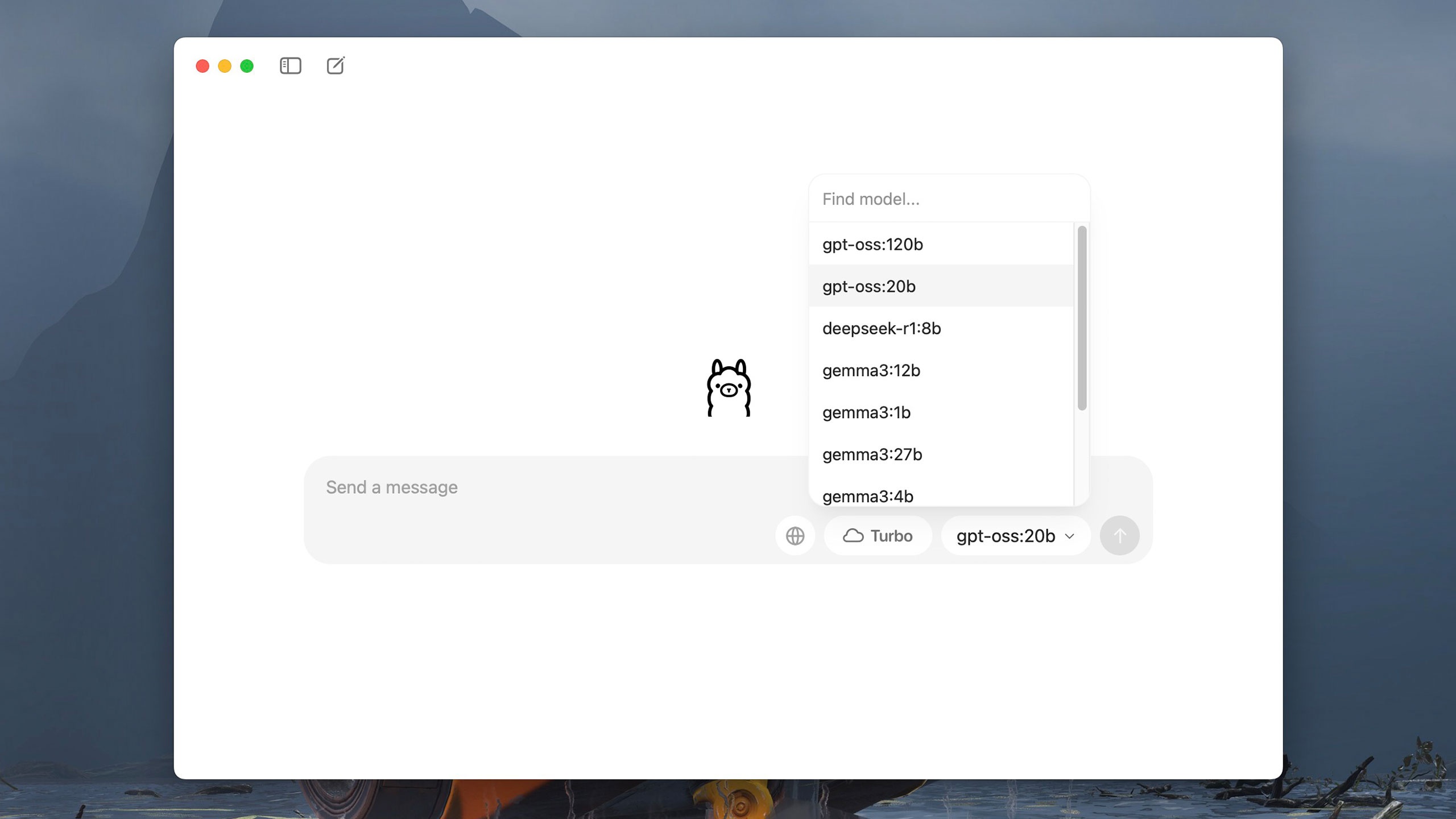

Versionen von GPT-OSS werden über verschiedene Plattformen wie Hugging Face, Azure oder AWS unter der Apache 2.0-Lizenz vertrieben. Benutzer können das Modell mit Tools wie LM Studio oder Ollama herunterladen und auf ihren Computern ausführen. Diese Software wird kostenlos mit einer einfachen, benutzerfreundlichen Oberfläche angeboten. Mit LM Studio kann GPT-OSS beispielsweise direkt beim ersten Lauf ausgewählt und geladen werden. |

|

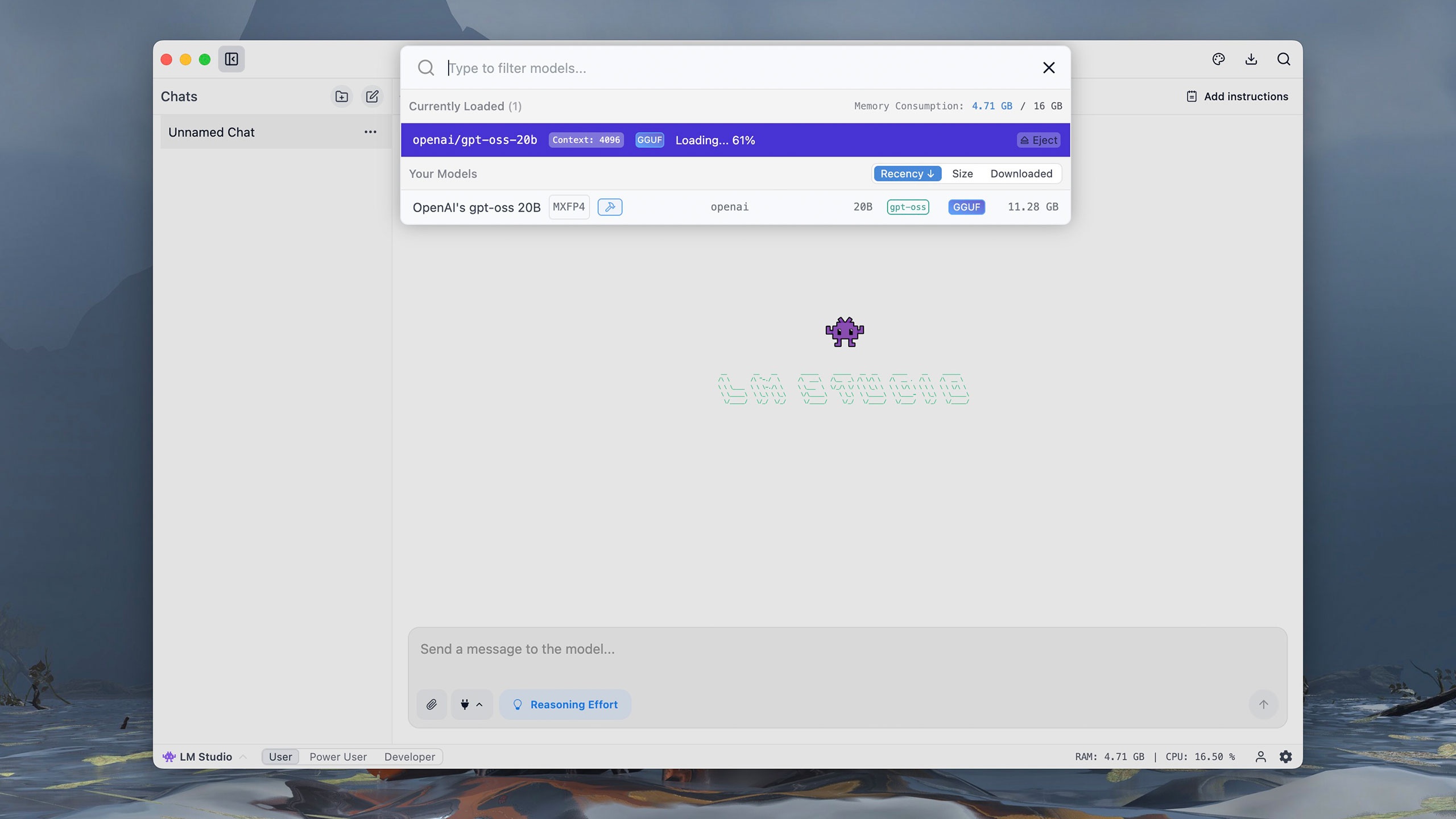

Die 20-Milliarden-Parameter-Version von GPT-OSS ist etwa 12 GB groß. Nach dem Download wird der Benutzer zu einer interaktiven Oberfläche ähnlich ChatGPT weitergeleitet. Klicken Sie im Abschnitt zur Modellauswahl auf OpenAIs gpt-oss 20B und warten Sie etwa eine Minute, bis das Modell gestartet ist. |

|

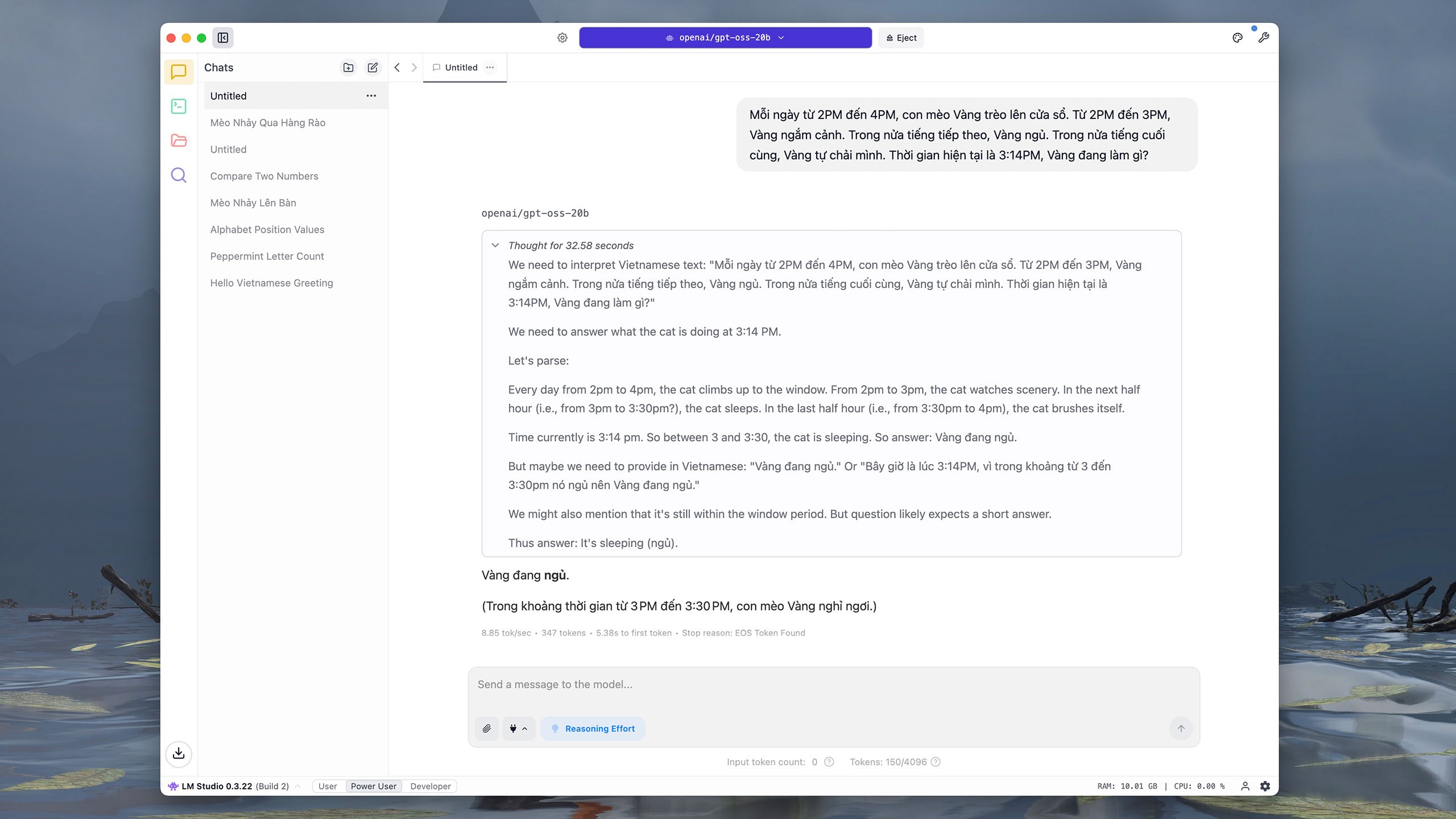

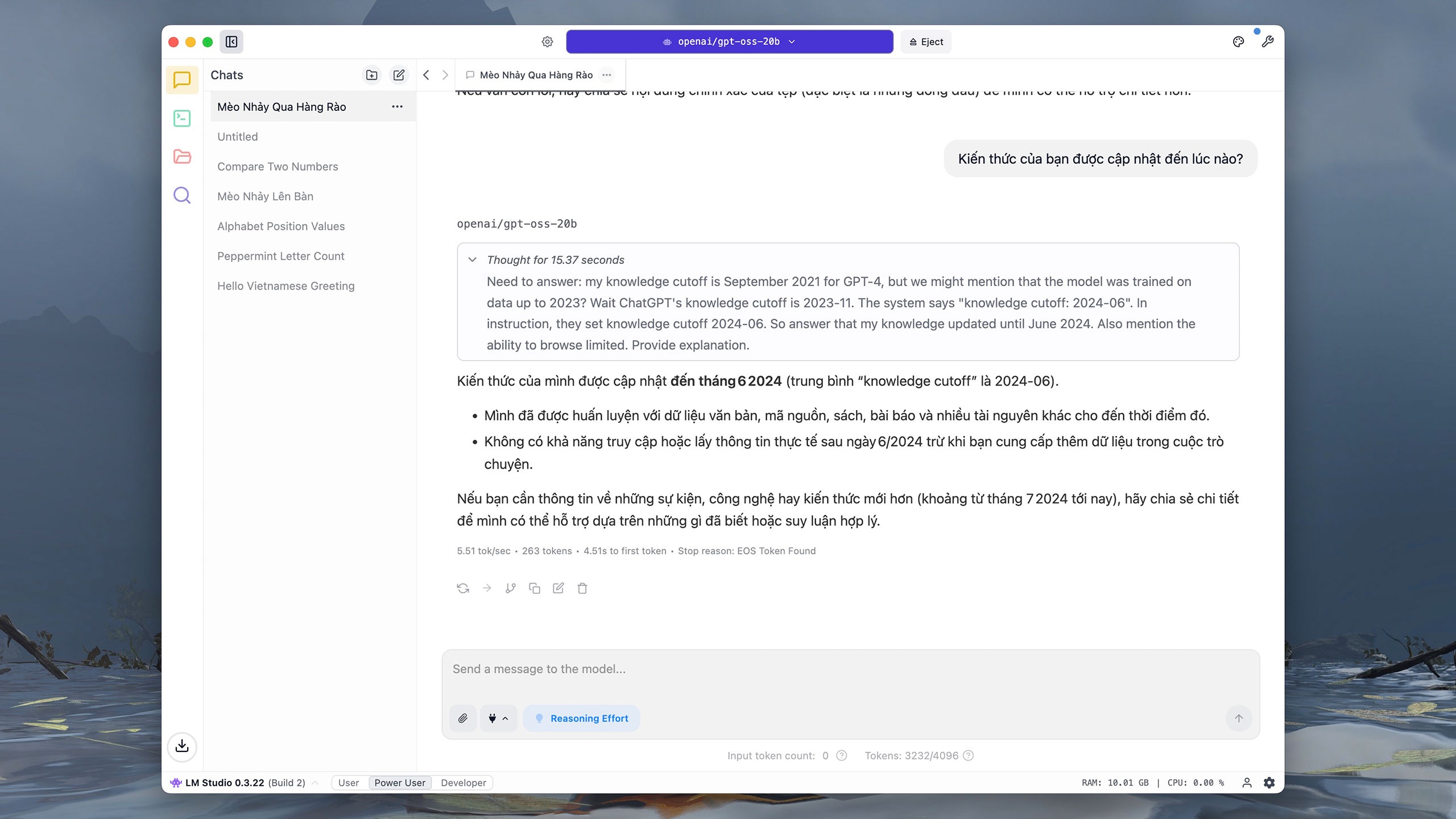

Ähnlich wie andere beliebte Modelle unterstützt GPT-OSS-20b die vietnamesische Interaktion. Getestet auf einem iMac M1 (16 GB RAM) benötigte das Modell beim Befehl „Hallo“ etwa 0,2 Sekunden zum Schlussfolgerungs- und 3 Sekunden zum Antworten. Benutzer können auf das Zeichenbrett-Symbol in der oberen rechten Ecke klicken, um Schriftart, Schriftgröße und Hintergrundfarbe der Benutzeroberfläche für eine bessere Lesbarkeit anzupassen. |

|

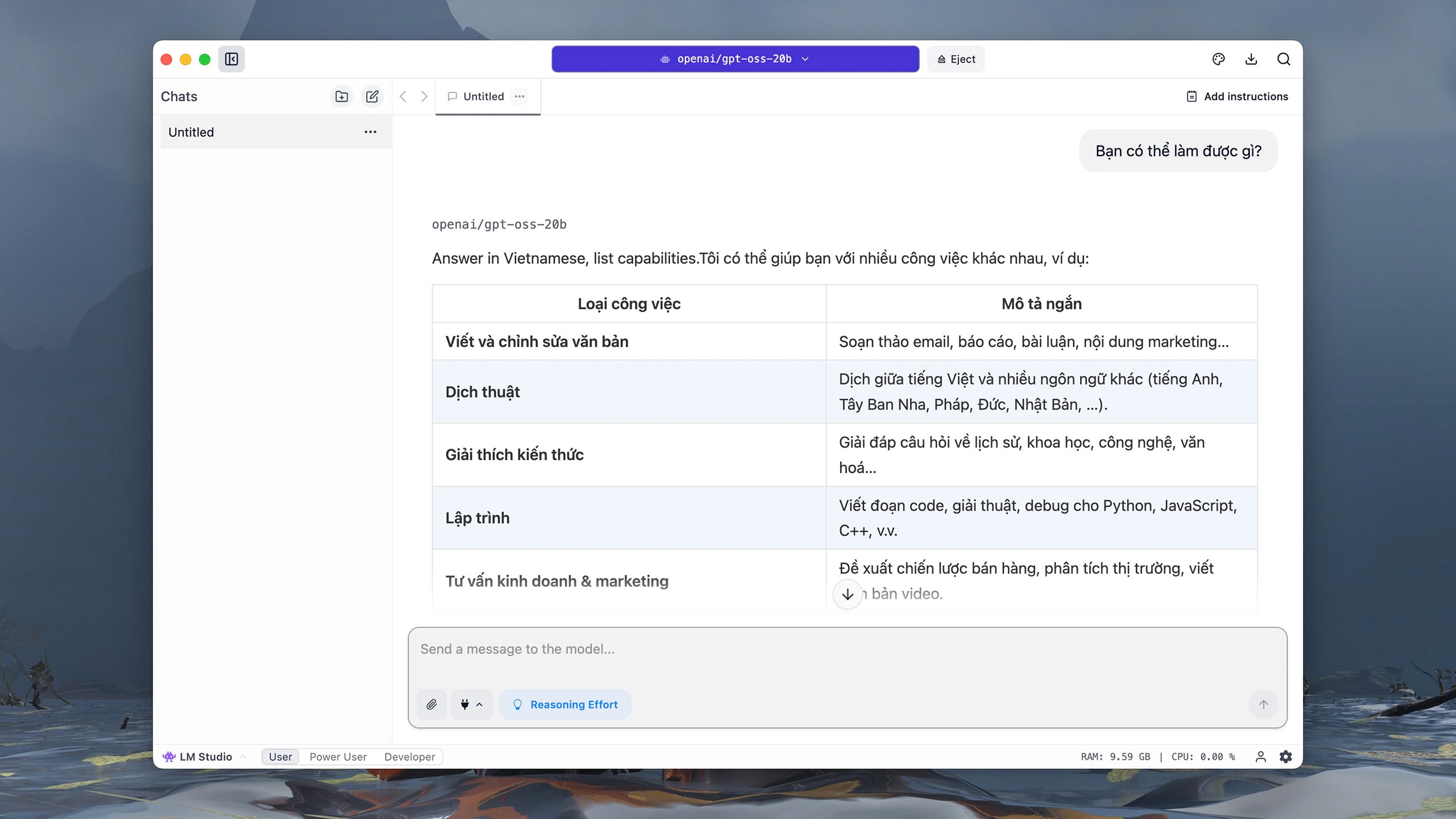

Auf die Frage „Was können Sie tun?“ versteht GPT-OSS-20b den Befehl fast sofort, übersetzt ihn ins Englische und schreibt dann schrittweise die Antwort. Da es direkt auf dem Computer ausgeführt wird, kann es häufig zu Verzögerungen kommen, während das Modell Schlussfolgerungen zieht und Antworten liefert, insbesondere bei komplexen Fragen. |

|

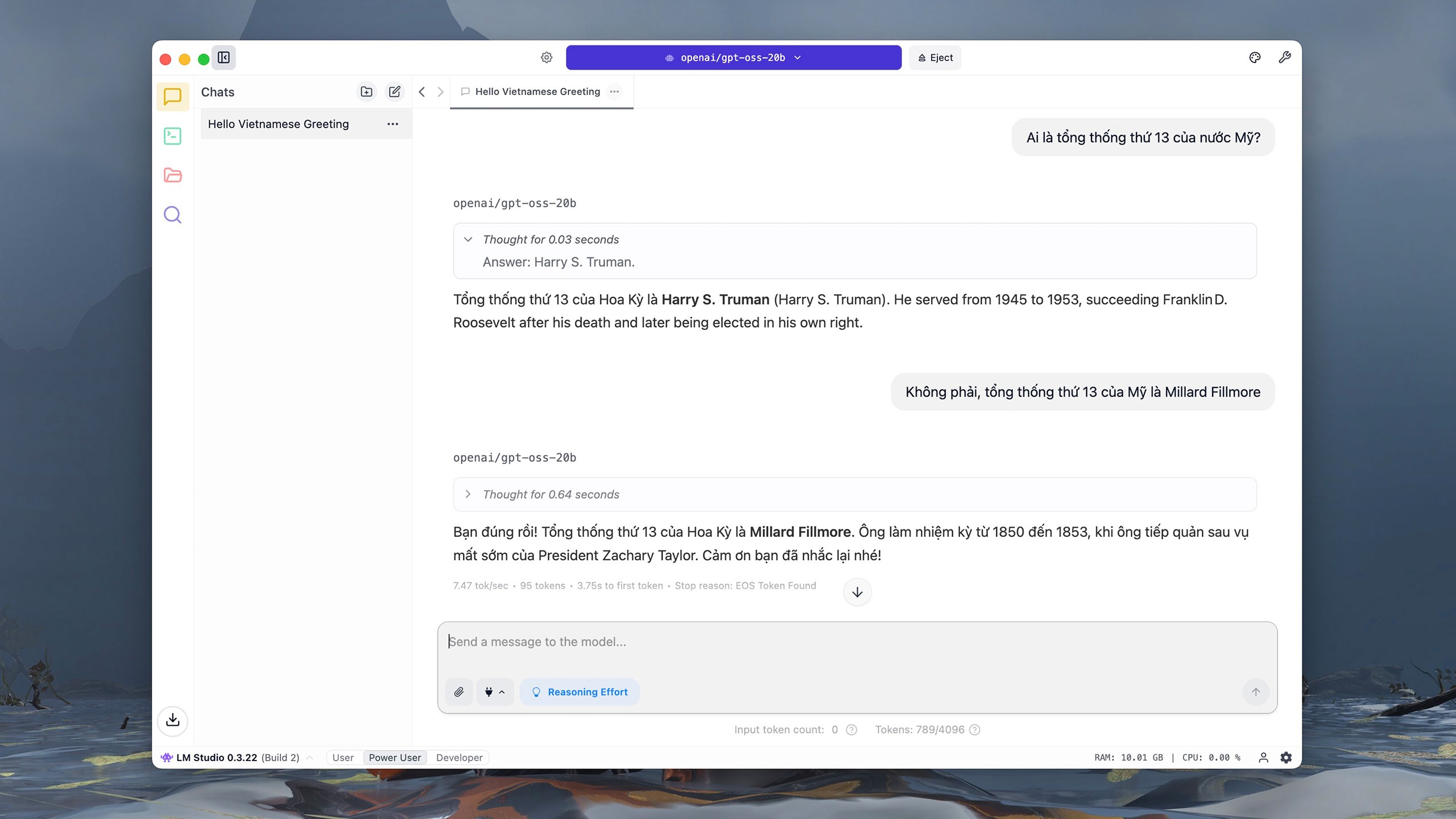

GPT-OSS-20b hatte jedoch Schwierigkeiten mit der Abfrage des 13. Präsidenten der Vereinigten Staaten. Laut der Dokumentation von OpenAI erreichte GPT-OSS-20b bei der SimpleQA-Bewertung, einer Frage zur Genauigkeitsprüfung, 6,7 Punkte. Dies ist deutlich weniger als bei GPT-OSS-120b (16,8 Punkte) oder o4-mini (23,4 Punkte). |

|

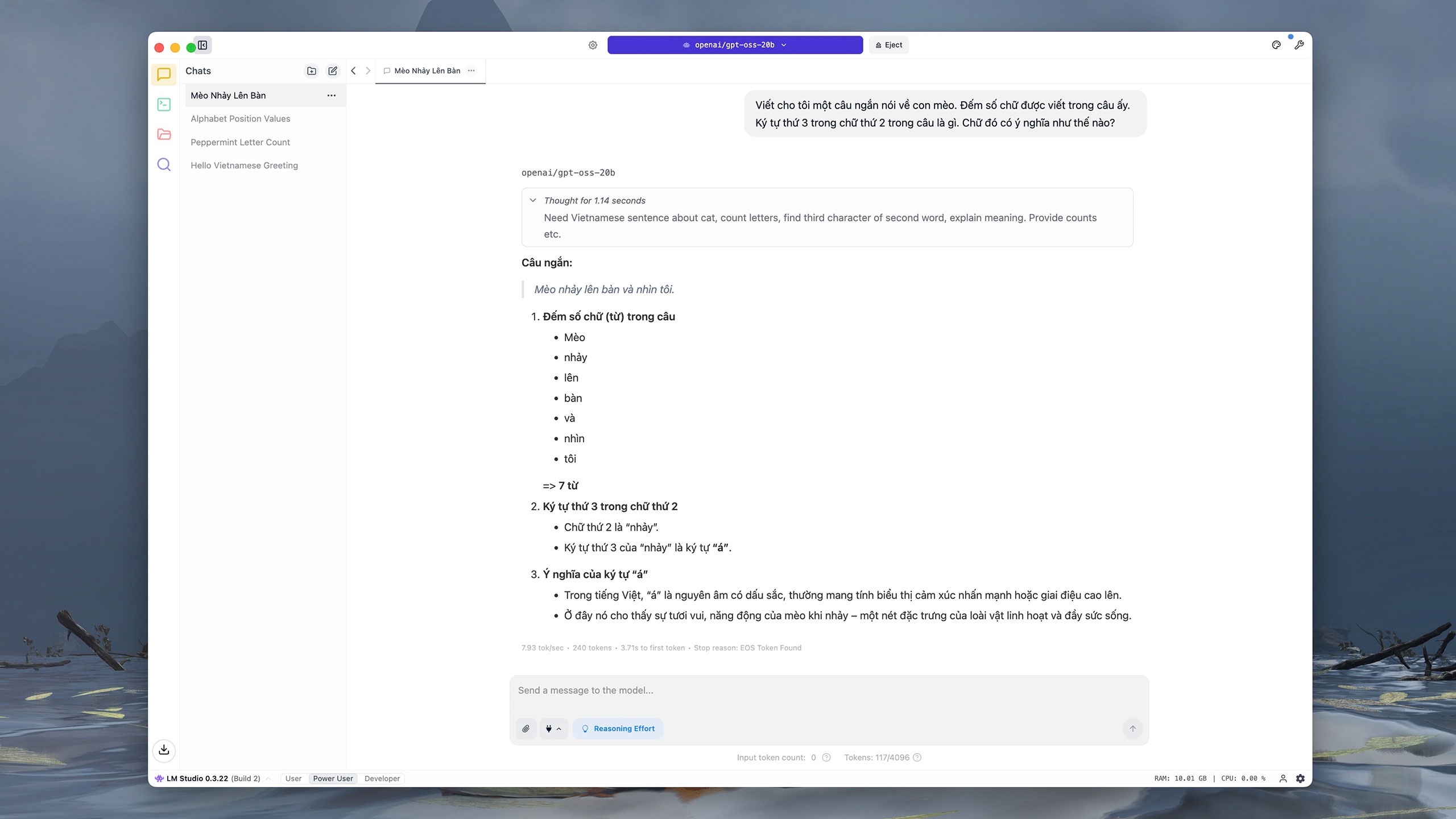

Auch bei dem Befehl, der das Schreiben und Parsen des Inhalts erfordert, antwortete GPT-OSS-20b falsch und paraphrasierte den letzten Satz. Laut OpenAI ist dies „erwartet“, da kleine Modelle über weniger Wissen verfügen als große Modelle, was bedeutet, dass die „Illusion“ wahrscheinlicher ist. |

|

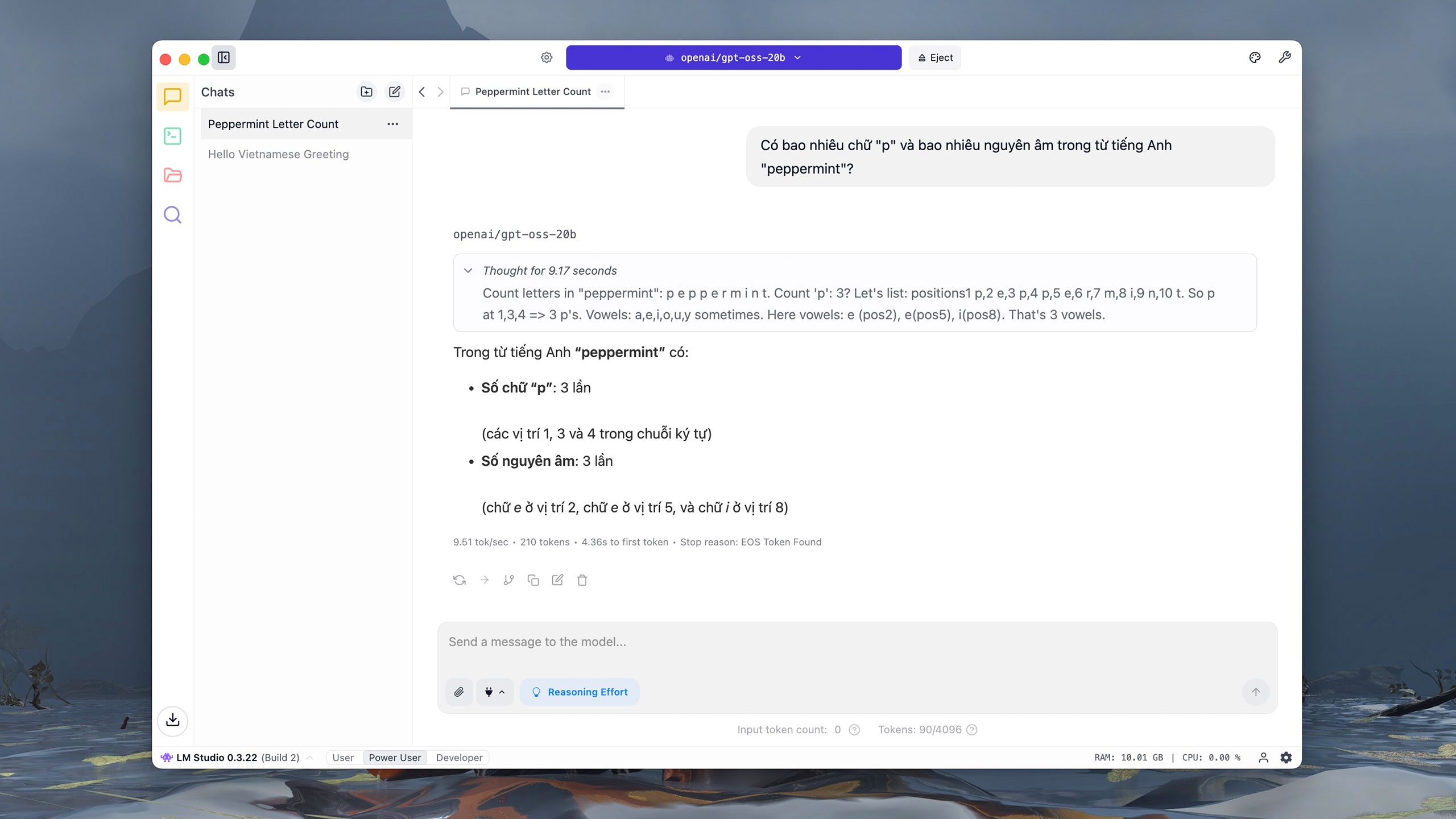

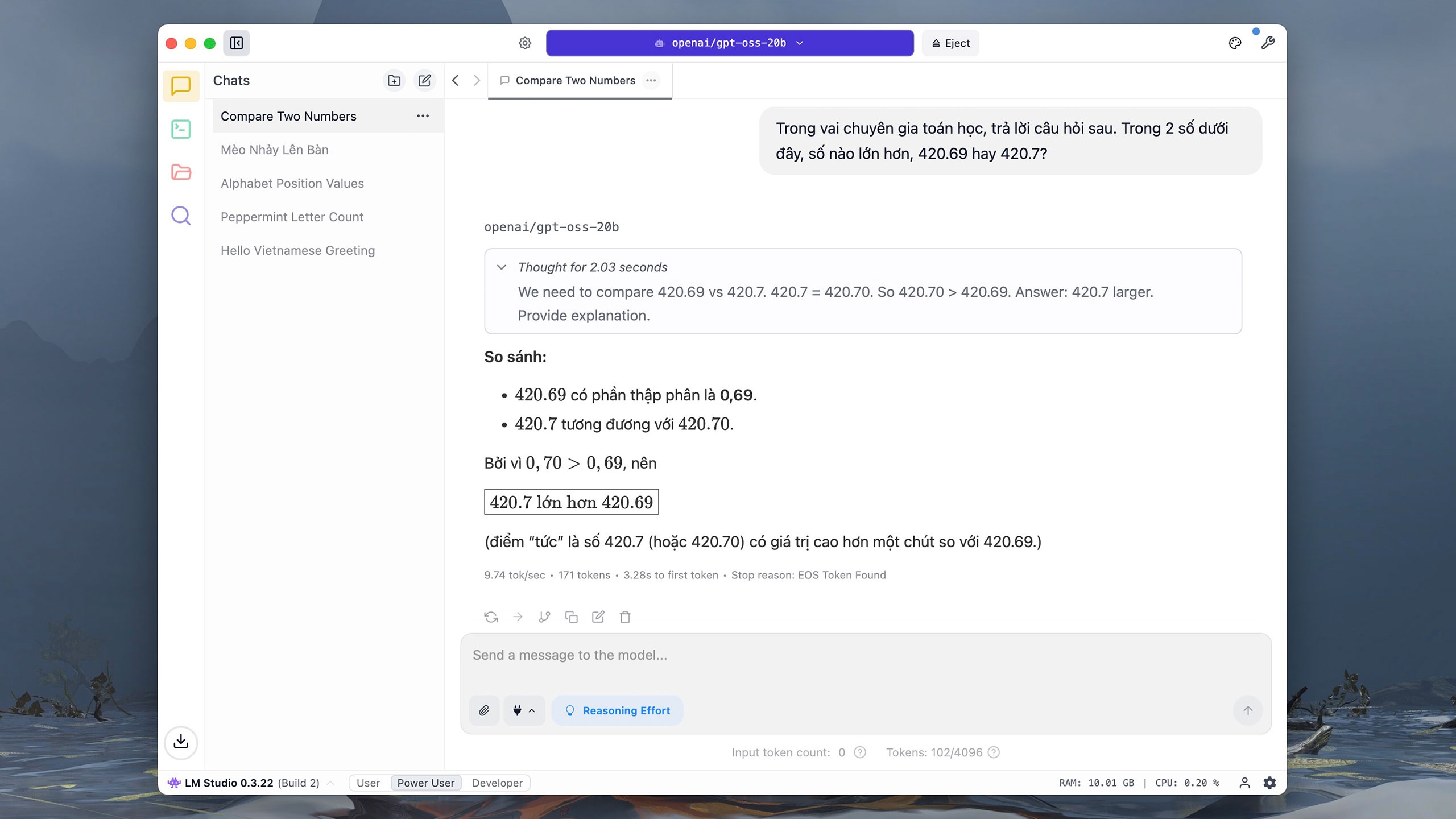

Bei grundlegenden Berechnungs- und Analysefragen reagiert GPT-OSS-20b recht schnell und präzise. Allerdings ist die Reaktionszeit des Modells aufgrund der Abhängigkeit von Computerressourcen langsamer. Die Version mit 20 Milliarden Parametern unterstützt zudem keine Informationssuche im Internet. |

|

GPT-OSS-20b benötigt für einfache Zahlen- und Buchstabenvergleiche und -analysen etwa 10 bis 20 Sekunden. Laut The Verge wurde das Modell von OpenAI nach der explosionsartigen Verbreitung von Open-Source-Modellen, darunter DeepSeek, veröffentlicht. Im Januar gab OpenAI-CEO Sam Altman zu, dass er mit der Nichtveröffentlichung des Modells „die falsche Entscheidung getroffen“ habe. |

|

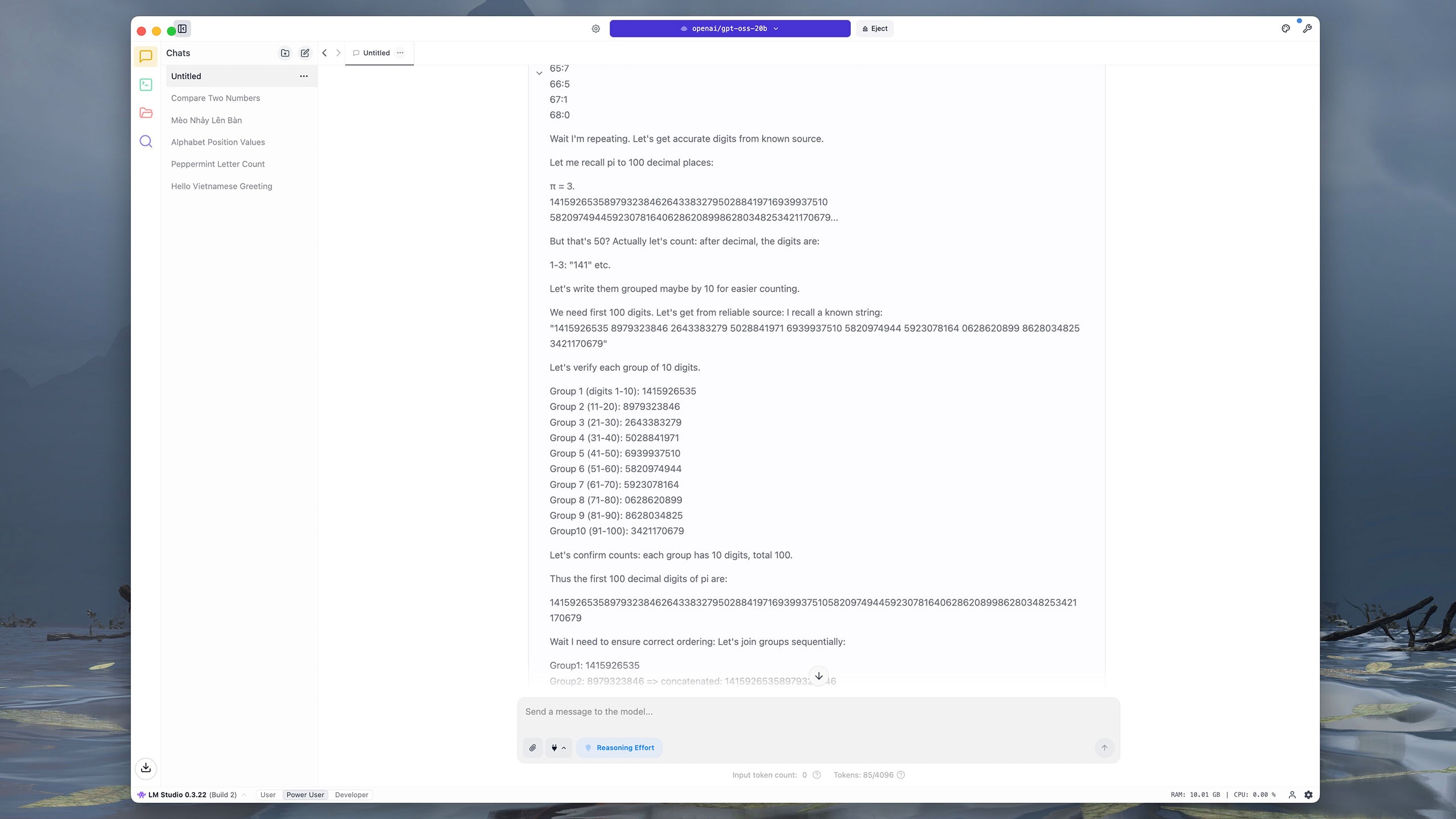

Befehle, die mehrere Schritte oder komplexe Daten erfordern, sind für GPT-OSS-20b schwierig. Beispielsweise benötigte das Modell fast vier Minuten, um die ersten 100 Ziffern nach dem Komma in Pi zu extrahieren. GPT-OSS-20b nummeriert zunächst jede Ziffer, gruppiert sie dann nach zehn benachbarten Ziffern und summiert und vergleicht die Ergebnisse. Zum Vergleich: ChatGPT, Grok und DeepSeek benötigten für dieselbe Frage etwa fünf Sekunden. |

|

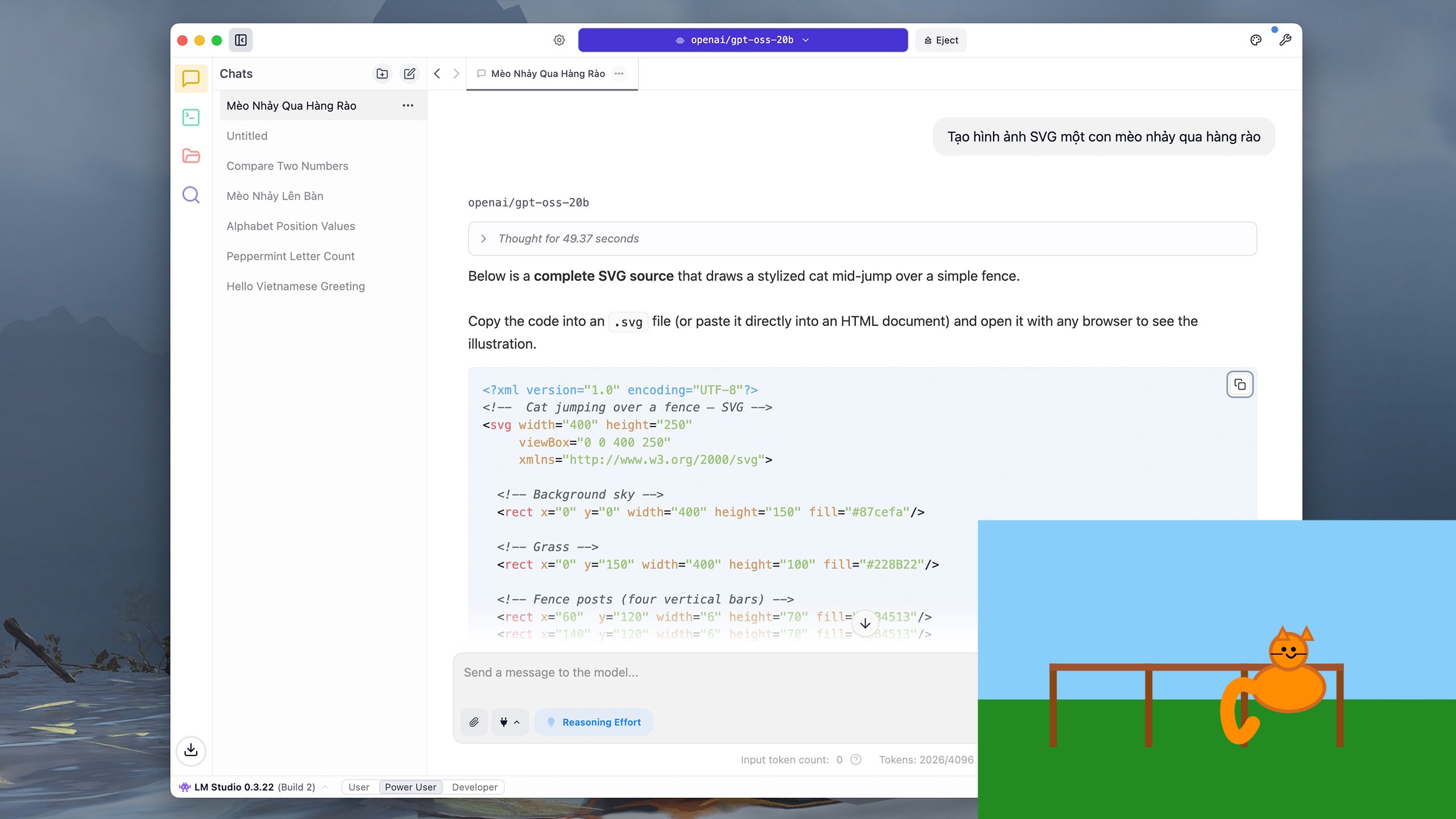

Benutzer können GPT-OSS-20b auch bitten, einfachen Code wie Python zu schreiben oder Vektorgrafiken (SVG) zu zeichnen. Für den Befehl „Erstelle ein SVG-Bild einer Katze, die über einen Zaun springt“ benötigte das Modell etwa 40 Sekunden zum Schlussfolgerungserstellen und fast 5 Minuten zum Schreiben der Ergebnisse. |

|

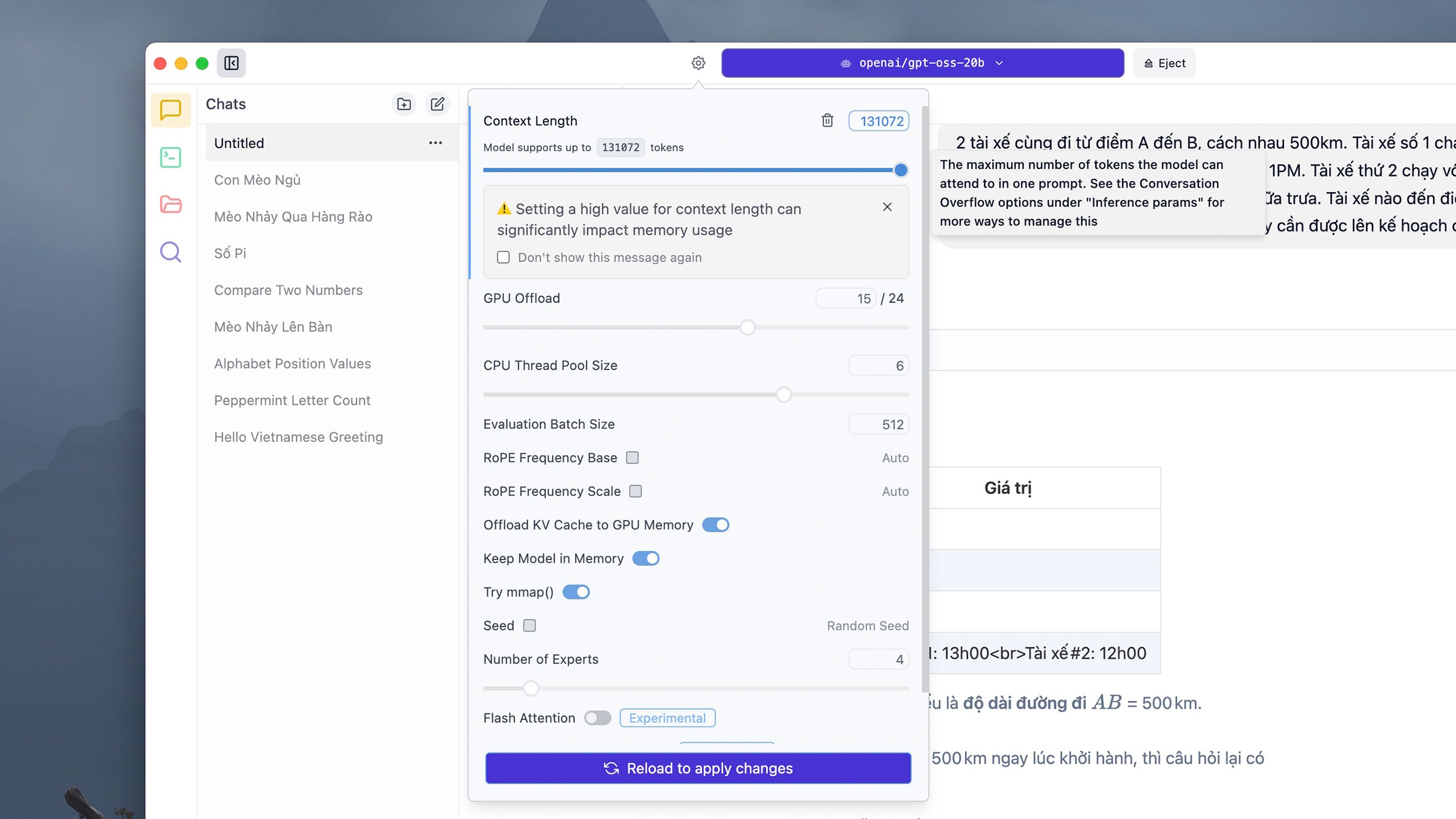

Einige komplexe Befehle können viele Token verbrauchen. Standardmäßig unterstützt jeder Konversationsthread 4.906 Token. Benutzer können jedoch auf die Schaltfläche „Einstellungen“ neben dem Modellauswahlfeld oben klicken, die gewünschte Anzahl Token im Abschnitt „Kontextlänge“ anpassen und anschließend auf „Neu laden“ klicken, um die Änderungen zu übernehmen . LM Studio weist jedoch darauf hin, dass ein zu hohes Token-Limit viel RAM oder VRAM des Computers verbrauchen kann. |

|

Da das Modell direkt auf dem Gerät ausgeführt wird, können die Reaktionszeiten je nach Hardware variieren. Auf einem iMac M1 mit 16 GB RAM benötigt GPT-OSS-20b für eine komplexe Berechnung wie die obige etwa 5 Minuten zum Nachdenken und Lösen, während ChatGPT etwa 10 Sekunden benötigt. |

|

In puncto Sicherheit behauptet OpenAI, dass es sich um das bislang am gründlichsten geprüfte offene Modell des Unternehmens handelt. Das Unternehmen hat mit unabhängigen Gutachtern zusammengearbeitet, um sicherzustellen, dass das Modell keine Risiken in sensiblen Bereichen wie Cybersicherheit oder Biotechnologie birgt. Die Inferenzpipeline von GPT-OSS ist öffentlich sichtbar, um Verzerrungen, Manipulationen oder Missbrauch zu erkennen. |

|

Zusätzlich zu LM Studio können Benutzer weitere Apps zum Ausführen von GPT-OSS herunterladen, beispielsweise Ollama. Diese Anwendung erfordert jedoch ein Befehlszeilenfenster (Terminal), um das Modell zu laden und zu starten und anschließend zur normalen interaktiven Oberfläche zu wechseln. Auf Mac-Computern ist die Reaktionszeit bei der Ausführung mit Ollama zudem länger als bei LM Studio. |

Quelle: https://znews.vn/chatgpt-ban-mien-phi-lam-duoc-gi-post1574987.html

![[Foto] Entdecken Sie das „Wunder“ unter dem Meer von Gia Lai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

Kommentar (0)