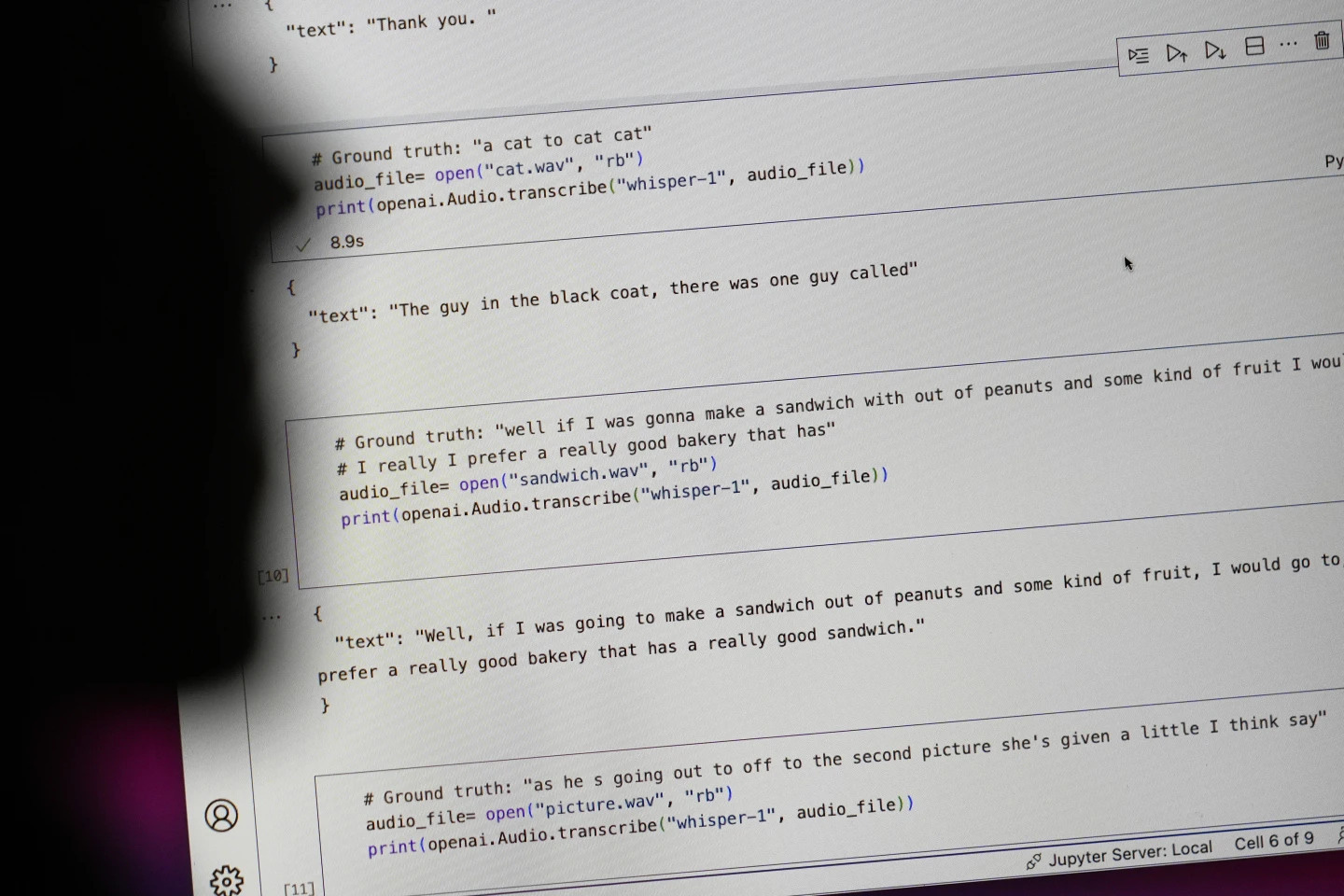

Der Technologieriese OpenAI pries sein Spracherkennungstool Whisper als KI mit „menschlicher Genauigkeit und Robustheit“ an. Doch Whisper hatte einen großen Fehler: Es generierte Texte und Sätze, die völlig falsch waren.

Einige der von der KI generierten Texte – sogenannte „Halluzinationen“ – können rassistische Kommentare, gewalttätige Sprache und sogar imaginäre medizinische Behandlungen enthalten – Foto: AP

Einige der von der KI generierten Texte seien sogenannte „halluzinatorische“ Inhalte, sagen Experten laut AP. Dazu gehörten rassistische Kommentare, gewalttätige Sprache und sogar imaginäre medizinische Behandlungen.

Hohe „Illusionsrate“ in KI-generierten Texten

Experten sind besonders besorgt, weil Whisper in vielen Branchen weltweit weit verbreitet ist, um Interviews zu übersetzen und zu transkribieren, Text in gängigen Verbrauchertechnologien zu generieren und Untertitel für Videos zu erstellen.

Noch beunruhigender ist, dass viele medizinische Zentren Whisper verwenden, um Konsultationen zwischen Ärzten und Patienten zu übertragen, obwohl OpenAI davor gewarnt hat, das Tool in „Hochrisikogebieten“ einzusetzen.

Das volle Ausmaß des Problems lässt sich nur schwer bestimmen, doch Forscher und Ingenieure geben an, dass sie bei ihrer Arbeit regelmäßig auf Whisper-„Halluzinationen“ stoßen.

Ein Forscher der University of Michigan gab an, in acht von zehn untersuchten Audiotranskriptionen „Halluzinationen“ gefunden zu haben. Ein Computeringenieur fand in etwa der Hälfte der von ihm analysierten Transkriptionen von über 100 Stunden Audio „Halluzinationen“. Ein anderer Entwickler sagte, er habe in fast allen der 26.000 Aufnahmen, die er mit Whisper erstellt hatte, „Halluzinationen“ gefunden.

Das Problem besteht selbst bei kurzen, klar aufgezeichneten Audioproben. Eine aktuelle Studie von Informatikern fand 187 „Illusionen“ in mehr als 13.000 untersuchten klaren Audioclips. Diese Tendenz führe zu Zehntausenden falscher Transkriptionen in Millionen von Aufnahmen, so die Forscher.

Solche Fehler können „sehr ernste Folgen“ haben, insbesondere im Krankenhausbereich, so Alondra Nelson, die bis letztes Jahr in der Biden-Regierung das Büro für Wissenschaft und Technologie des Weißen Hauses leitete.

„Niemand möchte eine Fehldiagnose“, sagte Nelson, heute Professor am Institute for Advanced Study in Princeton, New Jersey. „Es braucht einen höheren Standard.“

Whisper wird auch verwendet, um Untertitel für Gehörlose und Schwerhörige zu erstellen – eine Bevölkerungsgruppe, die besonders anfällig für Fehlübersetzungen ist. Denn gehörlose und schwerhörige Menschen haben keine Möglichkeit, erfundene Passagen zu identifizieren, die „im restlichen Text versteckt sind“, sagt Christian Vogler, gehörlos und Leiter des Technology Accessibility Program an der Gallaudet University.

OpenAI soll das Problem lösen

Die Häufigkeit solcher „Halluzinationen“ hat Experten, Befürworter und ehemalige OpenAI-Mitarbeiter dazu veranlasst, die Bundesregierung aufzufordern, KI-Regulierungen in Betracht zu ziehen. OpenAI muss zumindest diesen Mangel beheben.

„Dieses Problem ist lösbar, wenn das Unternehmen bereit ist, ihm Priorität einzuräumen“, sagte William Saunders, ein Forschungsingenieur in San Francisco, der OpenAI im Februar aufgrund von Bedenken hinsichtlich der Ausrichtung des Unternehmens verließ.

„Es wäre ein Problem, wenn man es auf den Markt bringt und die Leute so überzeugt von seinen Fähigkeiten werden, dass sie es in all diese anderen Systeme integrieren.“ Ein Sprecher von OpenAI sagte, das Unternehmen arbeite ständig daran, diese „Illusionen“ zu zerstreuen und schätze die Erkenntnisse der Forscher. Er fügte hinzu, dass OpenAI Feedback in die Modellaktualisierungen einbeziehe.

Während die meisten Entwickler davon ausgehen, dass Text-to-Speech-Tools Tippfehler oder andere Fehler machen können, sagen Ingenieure und Forscher, dass sie noch nie ein KI-gestütztes Text-to-Speech-Tool gesehen haben, das so viel „halluziniert“ wie Whisper.

Nobelpreis für Physik 2024: Die Menschen, die den Grundstein für KI legten

Nobelpreis für Physik 2024: Die Menschen, die den Grundstein für KI legten[Anzeige_2]

Quelle: https://tuoitre.vn/cong-cu-ai-chuyen-loi-noi-thanh-van-ban-cua-openai-bi-phat-hien-bia-chuyen-20241031144507089.htm

![[Foto] Vorsitzender des ungarischen Parlaments besucht das Mausoleum von Präsident Ho Chi Minh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760941009023_ndo_br_hungary-jpg.webp)

![[Foto] Der Vorsitzende der Nationalversammlung, Tran Thanh Man, führt Gespräche mit dem Vorsitzenden der ungarischen Nationalversammlung, Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760952711347_ndo_br_bnd-1603-jpg.webp)

![[Foto] Feierliche Eröffnung der 10. Sitzung der 15. Nationalversammlung](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760937111622_ndo_br_1-202-jpg.webp)

![[Foto] Premierminister Pham Minh Chinh trifft sich mit dem Präsidenten der ungarischen Nationalversammlung, Kover Laszlo](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/20/1760970413415_dsc-8111-jpg.webp)

Kommentar (0)