Am 12. März stellte Google Gemma 3 vor, ein Open-Source-KI-Modell der dritten Generation, das sowohl auf Smartphones als auch auf Hochleistungs-Workstations ausgeführt werden kann.

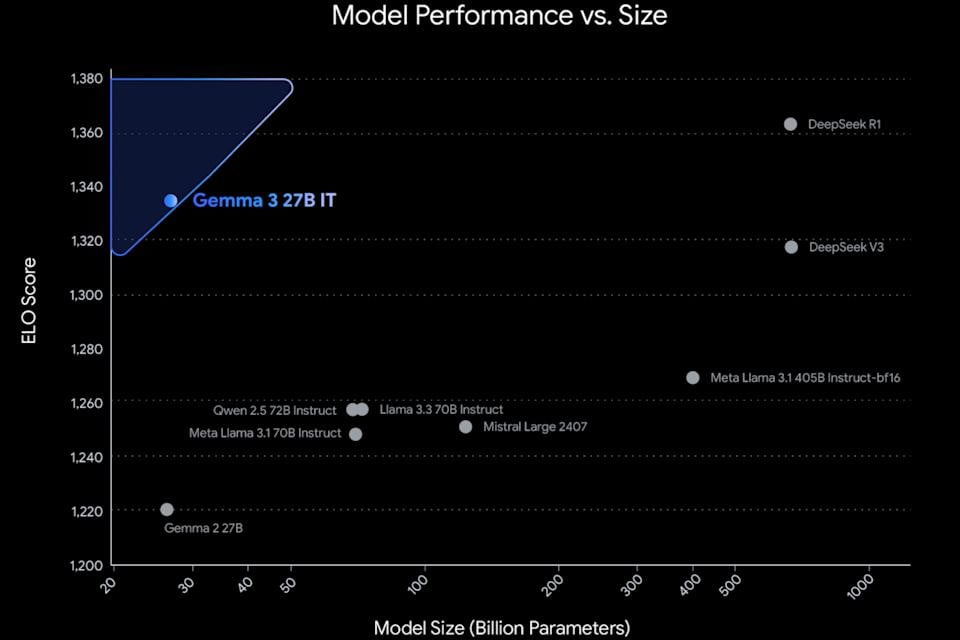

Gemma 3 ist in vier Varianten mit 1 Milliarde, 4 Milliarden, 12 Milliarden und 27 Milliarden Parametern erhältlich. Laut Google handelt es sich um das weltweit beste Single-Speed-Modell, das auf einer einzigen GPU oder TPU läuft, anstatt einen großen Computercluster zu benötigen.

Theoretisch kann Gemma 3 dadurch direkt auf der Tensor Processing Unit (TPU) des Pixel-Telefons ausgeführt werden, ähnlich wie das Gemini Nano-Modell lokal auf einem Mobilgerät ausgeführt wird.

Im Vergleich zur Gemini-KI-Modellfamilie liegt der größte Vorteil von Gemma 3 in seiner Open-Source-Natur. Dadurch können Entwickler die Software einfach anpassen, verpacken und bei Bedarf in mobilen Apps und Desktop-Software einsetzen. Darüber hinaus unterstützt Gemma mehr als 140 Sprachen, von denen 35 bereits als Trainingspakete verfügbar sind.

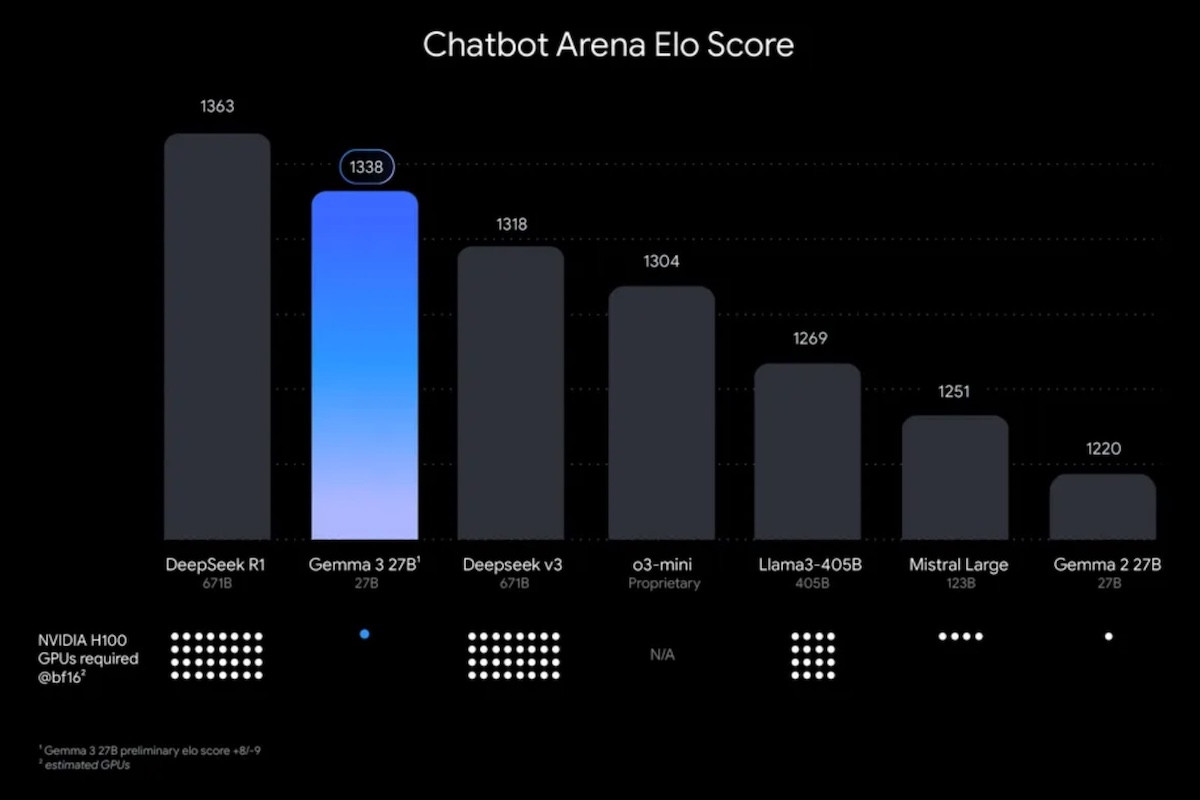

Ähnlich wie die neuesten Gemini 2.0-Modelle kann Gemma 3 Text, Bilder und Videos verarbeiten. In Bezug auf die Leistung schneidet Gemma 3 besser ab als viele andere beliebte Open-Source-KI-Modelle, darunter DeepSeek V3, OpenAI o3-mini und Metas Llama-405B-Variante.

Kontext entspricht 200 Buchseiten

Gemma 3 unterstützt ein Kontextfenster mit bis zu 128.000 Token, was der Datenmenge eines 200-seitigen Buches entspricht. Im Vergleich dazu verfügt das Gemini 2.0 Flash Lite-Modell über ein Kontextfenster mit bis zu 1 Million Token.

Gemma 3 kann mit externen Datensätzen interagieren und als automatisierter Agent fungieren, ähnlich wie Gemini nahtlos die Arbeit über Plattformen wie Gmail oder Docs hinweg unterstützt.

Googles neueste Open-Source-KI-Modelle können lokal oder über die Cloud-Dienste des Unternehmens, wie beispielsweise Vertex AI, bereitgestellt werden. Gemma 3 ist jetzt im Google AI Studio sowie auf Drittanbieterplattformen wie Hugging Face, Ollama und Kaggle verfügbar.

Googles Open-Source-Modell der dritten Generation ist Teil eines Branchentrends, bei dem Unternehmen parallel sowohl große Sprachmodelle (LLMs) als auch kleine Sprachmodelle (SLMs) entwickeln. Auch Googles Konkurrent Microsoft verfolgt mit seiner Phi-Reihe von Open-Source-Small-Language-Modellen eine ähnliche Strategie.

Kleine Sprachmodelle wie Gemma und Phi werden für ihre Ressourceneffizienz geschätzt und eignen sich daher ideal für die Ausführung auf Geräten wie Smartphones. Darüber hinaus eignen sie sich aufgrund ihrer geringeren Latenz besonders für mobile Anwendungen.

[Anzeige_2]

Quelle: https://vietnamnet.vn/google-ra-mat-gemma-3-mo-hinh-ai-ma-nguon-mo-voi-hieu-suat-vuot-troi-2380097.html

![[Maritime News] Mehr als 80 % der weltweiten Containerschifffahrtskapazität liegen in den Händen von MSC und großen Schifffahrtsallianzen](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/16/6b4d586c984b4cbf8c5680352b9eaeb0)

Kommentar (0)