Σύμφωνα με το BGR , το 2024 θα είναι μια καθοριστική χρονιά για τον κόσμο , ώστε να συνειδητοποιήσει εάν η τεχνητή νοημοσύνη είναι πραγματικά το μέλλον της πληροφορικής ή απλώς μια περαστική μόδα. Ενώ οι γνήσιες εφαρμογές της τεχνητής νοημοσύνης γίνονται ολοένα και πιο ποικίλες, η σκοτεινή πλευρά αυτής της τεχνολογίας θα αποκαλυφθεί επίσης μέσα από αμέτρητες απάτες τους επόμενους μήνες.

Οι ειδικοί κατά της απάτης του Scams.info μόλις δημοσίευσαν μια λίστα με 3 απάτες που υποστηρίζονται από τεχνητή νοημοσύνη και για τις οποίες οι άνθρωποι πρέπει να είναι προσεκτικοί το 2024. Ο γενικός κανόνας είναι να είστε προσεκτικοί με οτιδήποτε φαίνεται πολύ λαμπερό, αλλά τα παρακάτω σχέδια απαιτούν ιδιαίτερα αυξημένη επαγρύπνηση.

Απάτες επενδύσεων που βασίζονται στην τεχνητή νοημοσύνη

Σημαντικοί παίκτες όπως η Google, η Microsoft και η OpenAI έχουν επενδύσει εκατομμύρια δολάρια στην Τεχνητή Νοημοσύνη και θα συνεχίσουν να επενδύουν σε μεγάλο βαθμό φέτος. Οι απατεώνες θα εκμεταλλευτούν αυτό το γεγονός για να σας δελεάσουν να επενδύσετε σε αμφίβολες ευκαιρίες. Εάν κάποιος στα μέσα κοινωνικής δικτύωσης προσπαθήσει να σας πείσει ότι η Τεχνητή Νοημοσύνη θα πολλαπλασιάσει τις αποδόσεις των επενδύσεών σας, σκεφτείτε το δύο φορές πριν ανοίξετε το πορτοφόλι σας.

Οι «εξαιρετικές προσφορές» και οι επενδύσεις χαμηλού κινδύνου δεν υπάρχουν ποτέ στην πραγματικότητα.

«Να είστε επιφυλακτικοί με επενδύσεις που υπόσχονται υψηλές αποδόσεις με χαμηλό κίνδυνο και φροντίστε να κάνετε διεξοδική έρευνα πριν επενδύσετε τα χρήματά σας σε αυτές», προειδοποιεί ο ειδικός Nicholas Crouch από το Scams.info. Οι νέοι επενδυτές θα πρέπει επίσης να είναι προσεκτικοί με προσφορές που απαιτούν από αυτούς να παραπέμψουν νέα μέλη. Αυτές συχνά λειτουργούν με βάση ένα μοντέλο πολυεπίπεδου μάρκετινγκ (MLM), ωφελώντας μόνο όσους βρίσκονται στην κορυφή, ενώ οι άλλοι συμμετέχοντες σπάνια ωφελούνται.

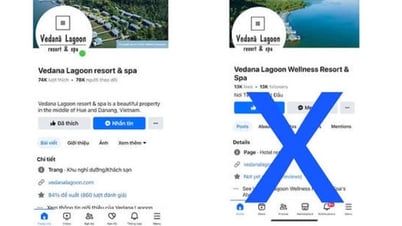

Μίμηση συγγενή

Η απάτη της πλαστοπροσωπίας φίλων ή συγγενών για δανεισμό χρημάτων δεν είναι κάτι καινούργιο, καθώς η μίμηση φωνής δεν είναι πολύ αποτελεσματική. Ωστόσο, με την Τεχνητή Νοημοσύνη, αυτό το είδος απάτης γίνεται πολύ πιο ύπουλο. Αρκεί ένα βίντεο στο YouTube ή μια ανάρτηση στο Facebook που περιέχει τη φωνή ενός συγγενή και ο απατεώνας μπορεί να χρησιμοποιήσει την Τεχνητή Νοημοσύνη για να την αναπαράγει τέλεια. Μπορείτε να καταλάβετε τη διαφορά κατά τη διάρκεια μιας τηλεφωνικής κλήσης;

Η τεχνητή νοημοσύνη μπορεί εύκολα να μιμηθεί τις φωνές των αγαπημένων σας προσώπων.

Στιγμιότυπο οθόνης από την Washington Post

«Είναι ζωτικής σημασίας οι άνθρωποι να προστατεύουν τους λογαριασμούς τους στα μέσα κοινωνικής δικτύωσης για να αποτρέψουν τους απατεώνες από τη συλλογή φωνητικών ηχογραφήσεων και οικογενειακών πληροφοριών», τόνισε ο Κράουτς.

Χρήση φωνητικών εντολών για παράκαμψη συστημάτων ασφαλείας.

Ορισμένες τράπεζες χρησιμοποιούν φωνητική αναγνώριση για την επαλήθευση χρηστών κατά τη διεξαγωγή συναλλαγών μέσω τηλεφώνου. Για τους λόγους που αναφέρθηκαν παραπάνω, αυτή η μέθοδος έχει ξαφνικά γίνει λιγότερο ασφαλής από πριν. Εάν δημοσιεύσετε βίντεο ή κλιπ που περιέχουν τη φωνή σας οπουδήποτε στο διαδίκτυο, κακόβουλοι παράγοντες μπορούν να χρησιμοποιήσουν αυτό το περιεχόμενο για να αντιγράψουν τη φωνή σας. Όπως σημειώνει ο Crouch, οι τράπεζες εξακολουθούν να έχουν άλλα δεδομένα για την επαλήθευση της ταυτότητας των πελατών, αλλά αυτή η τακτική φέρνει τους εγκληματίες πιο κοντά στην κλοπή του τραπεζικού σας λογαριασμού.

Τα συστήματα ασφαλείας που βασίζονται σε φωνή δεν είναι πλέον ασφαλή από τη δύναμη της Τεχνητής Νοημοσύνης.

Η Τεχνητή Νοημοσύνη έχει τη δυνατότητα να αλλάξει ριζικά τη ζωή μας και τον τρόπο που αλληλεπιδρούμε με τις συσκευές. Είναι επίσης το πιο πρόσφατο εργαλείο που θα χρησιμοποιήσουν οι χάκερ και οι απατεώνες για να επιτεθούν στους χρήστες. Επομένως, είναι σημαντικό να παραμένετε σε εγρήγορση και να διεξάγετε διεξοδική έρευνα πριν εμπλακείτε σε οποιαδήποτε δραστηριότητα που περιλαμβάνει Τεχνητή Νοημοσύνη.

[διαφήμιση_2]

Σύνδεσμος πηγής

![[Ζωντανά] Γκαλά Βραβείων Κοινοτικής Δράσης 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Εικόνα] Διαρροή εικόνων ενόψει της γκαλά απονομής των Βραβείων Δράσης Κοινότητας 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Φωτογραφία] Ο Πρωθυπουργός Φαμ Μινχ Τσινχ δέχεται τον Υπουργό Παιδείας και Αθλητισμού του Λάος, Θονγκσαλίθ Μανγκνόρμεκ](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Φωτογραφία] Ο Πρωθυπουργός Φαμ Μινχ Τσινχ δέχεται τον Κυβερνήτη της Επαρχίας Τοτσίγκι (Ιαπωνία)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Φωτογραφία] Ο πρωθυπουργός Pham Minh Chinh παρευρίσκεται στο Οικονομικό Φόρουμ του Βιετνάμ 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/16/1765893035503_ndo_br_dsc-8043-jpg.webp)

Σχόλιο (0)